LLaMA-Adapter V2 Parameter-Efficient Visual Instruction Model

LLaMA-Adapter V2: Parameter-Efficient Visual Instruction Model

Authors: Peng Gao, Jiaming Han, Renrui Zhang, Ziyi Lin, Shijie Geng, Aojun Zhou, Wei Zhang, Pan Lu, Conghui He, Xiangyu Yue, Hongsheng Li, Yu Qiao

Deep-Dive Summary:

LLaMA-Adapter V2: 参数高效的视觉指令模型

摘要

如何高效地将大型语言模型(LLMs)转化为指令跟随者是近期一个热门的研究方向,而针对多模态推理的LLM训练仍未被充分探索。尽管最近的LLaMA-Adapter展示了处理视觉输入与LLM结合的潜力,但它仍然无法很好地泛化到开放式视觉指令,并且在性能上落后于GPT-4。在本文中,我们提出了LLaMA-Adapter V2,一种参数高效的视觉指令模型。具体来说,我们首先通过解锁更多的可学习参数(例如,归一化、偏置和尺度)来增强LLaMA-Adapter,将指令跟随能力分布到整个LLaMA模型而不仅是适配器部分。其次,我们提出了一种早期融合策略,仅将视觉令牌输入到早期的LLM层中,有助于更好地整合视觉知识。第三,我们引入了一种图像-文本对和指令跟随数据的联合训练范式,通过优化不相交的可学习参数组来有效缓解图像-文本对齐和指令跟随这两个任务之间的干扰,并在仅使用小规模图像-文本和指令数据集的情况下实现了强大的多模态推理能力。在推理过程中,我们还将额外的专家模型(例如,图像描述/OCR系统)集成到LLaMA-Adapter中,进一步增强其图像理解能力,而无需增加训练成本。与原始的LLaMA-Adapter相比,我们的LLaMA-Adapter V2仅通过引入1400万参数即可执行开放式的多模态指令。新设计的框架还展现出更强的纯语言指令跟随能力,甚至在聊天互动中表现出色。我们的代码和模型可在https://github.com/ZrrSkywalker/LLaMA-Adapter获取。

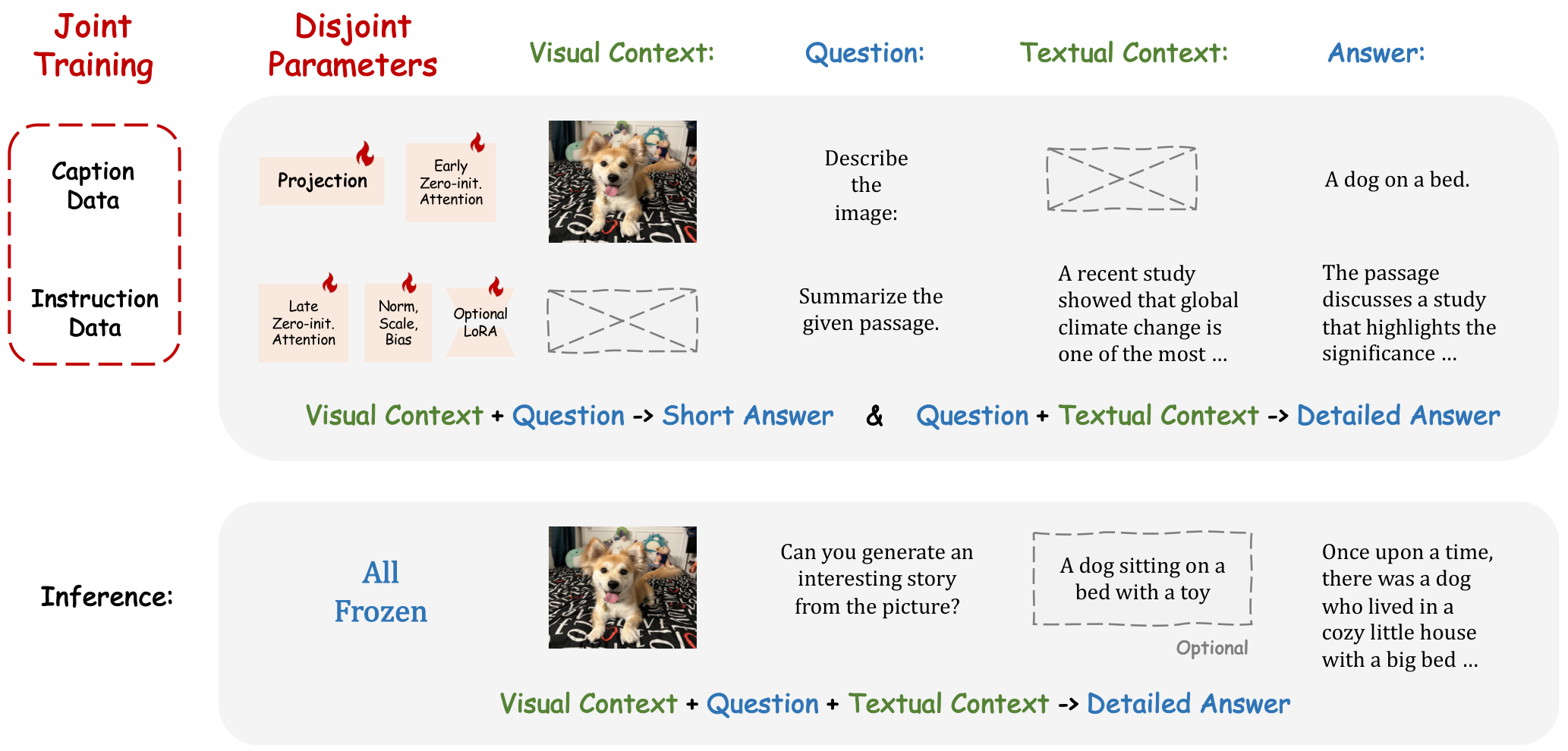

![Figure 1. Training Pipeline of LLaMA-Adapter V2. We introduce several strategies to enhance the capability of LLaMA-Adapter [72], which enable a parameter-efficient visual instruction model with superior multi-modal reasoning.](https://i-blog.csdnimg.cn/img_convert/23db841a95c23647dc237d920c86f14e.png)

1. 引言

大型语言模型(LLMs)[75] 因其在理解、推理和生成人类语言方面的卓越能力,在人工智能社区中引起了广泛关注。为了使 LLM 的回应更加生动和有说服力,近期的一些研究 [7, 19, 50, 62, 68] 探索了将 LLMs 转变为指令跟随模型的方法。例如,斯坦福的 Alpaca [62] 使用 OpenAI 的 InstructGPT 模型 [48] 生成的指令示例对 LLaMA [63] 进行微调,使其成为一个指令跟随模型。Alpaca 的后续工作通过使用更高质量的指令数据(如 ShareGPT [1] 和 GPT-4 [50] 生成的数据)进一步扩展了 LLaMA。与 Alpaca 和 Vicuna [7] 采用的完全微调范式相比,LLaMA-Adapter [72] 通过在冻结的 LLaMA 中引入轻量级适配器和零初始化的注意力机制,实现了参数高效的微调,并注入了多模态知识。尽管取得了显著进展,上述方法仍无法处理更高级的多模态指令,例如类似 GPT-4 [47] 的视觉理解任务。

最近,MiniGPT-4 [78] 和 LLaVA [38] 等研究掀起了将纯语言指令模型扩展为多模态模型的研究浪潮,以增强 LLMs 的视觉推理能力,类似于 LLaMA-Adapter 的方式。MiniGPT-4 通过在 1.34 亿个图像-文本对上预训练,将冻结的视觉编码器与 LLM 连接,并通过高质量的图像-文本数据集进一步改进模型。LLaVA 同样利用图像-文本对来对齐视觉模型和 LLM,与 MiniGPT-4 不同的是,LLaVA 在由 GPT-4 生成的 15 万条高质量多模态指令数据上对整个 LLM 进行微调。虽然这些方法展示了令人印象深刻的多模态理解能力,但它们需要更新数十亿个模型参数,并精心收集大量多模态训练数据,这些数据要么由人工标注,要么从 OpenAI API 的响应中提炼。

本文旨在设计一个参数高效的视觉指令模型。我们基于流行的参数高效方法 LLaMA-Adapter,开发了我们的新方法,称为 LLaMA-Adapter V2。LLaMA-Adapter 最初是作为一个指令跟随模型开发的,可以轻松转变为视觉指令模型。然而,由于缺乏多模态指令调优数据,LLaMA-Adapter 的多模态版本被限制为传统的视觉-语言模型。例如,在 COCO Captions 上训练的 LLaMA-Adapter 只能处理特定的提示,如“为这张图像生成标题”,而无法适应开放式的多模态指令,如复杂的视觉推理和视觉问答任务。

尽管我们目前未使用多模态指令数据,但仍有可能对 LLaMA-Adapter 进行多模态指令调优。我们以冻结的指令跟随 LLaMA-Adapter 模型为起点,通过在图像-文本对上优化视觉投影层,确保视觉-语言对齐。然而,我们观察到视觉特征往往会主导适应性提示,导致指令跟随能力迅速下降。

为了解决这一挑战,我们提出了一种简单的早期融合视觉知识策略,解决了图像-文本对齐和语言指令调优两个任务之间的干扰问题。在 LLaMA-Adapter 中,动态视觉提示被整合到最后 LLL 层的静态适应提示中。然而,在 LLaMA-Adapter V2 中,我们将动态视觉提示分布到前 KKK 层,其中 K<N−LK < N - LK<N−L,NNN 表示 Transformer 层的总数。因此,图像-文本对齐不再干扰模型的指令跟随能力。通过这一策略,我们可以在没有高质量多模态指令数据的情况下,通过图像标题数据和指令跟随数据的联合训练,实现卓越的视觉指令学习。此外,我们通过解锁更多可学习参数(如归一化、层偏差和尺度)增强了 LLaMA-Adapter 的能力,我们称之为线性层的偏差调优。通过增加模型的可调容量,我们可以将指令跟随知识扩散到整个 LLM 中。值得注意的是,可调参数仅占整个模型的 0.04%,确保 LLaMA-Adapter V2 仍然是一种参数高效的方法。

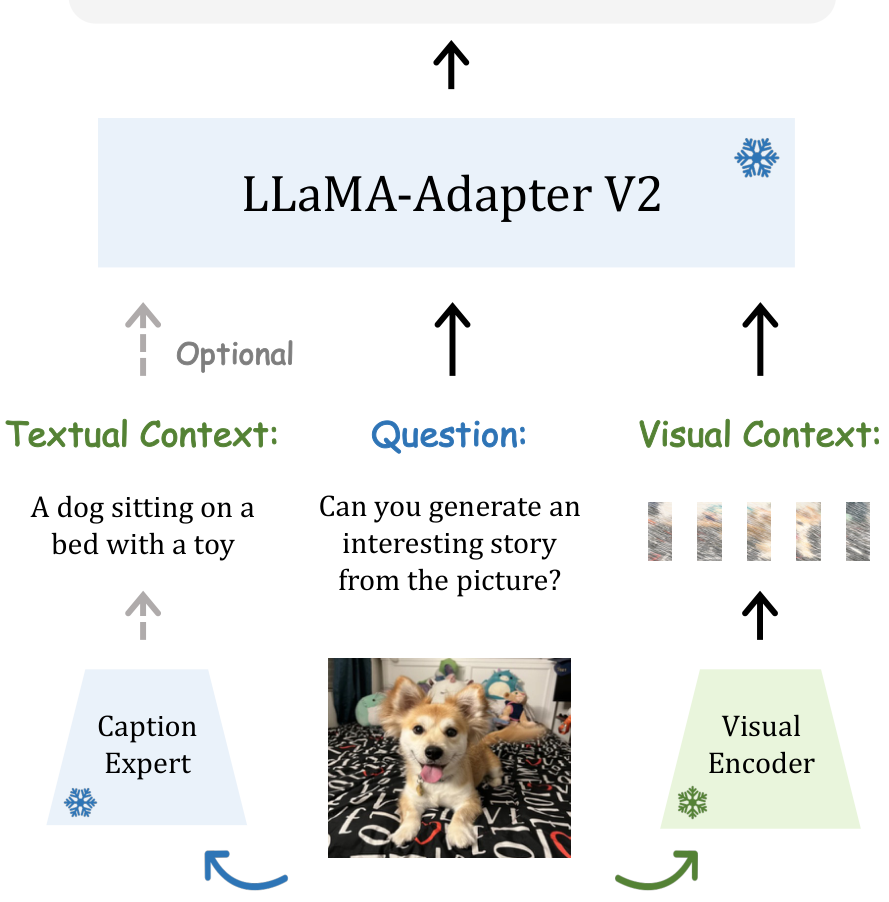

最后,我们引入了额外的专家模型(如标题生成、检测和 OCR 系统)来增强 LLaMA-Adapter V2 的图像理解能力,使我们的方法区别于 MiniGPT-4 和 LLaVA 等依赖大量图像-文本对训练数据的方法。通过与这些专业专家模型的协作,我们的框架获得了更大的灵活性,允许插入各种专家模型以适应多种任务,而无需在广泛的视觉-语言数据上进行预训练。

![Table 1. Training Comparison of Different Methods. CC, VG and L400 represent Conceptual Caption [5,57], Visual Genome [30] and LAION 400M [56], respectively. Note that we count all the data and tuning parameters needed to convert the pretrained vision model and LLM into a visual instruction model. * denotes the filtered dataset.](https://i-blog.csdnimg.cn/img_convert/229f3c66528aef1459f21582ab3e768c.png)

2. 相关工作

指令跟随语言模型

大型语言模型(LLMs)通过在广泛的文本语料库上进行预训练,采用自回归Transformer模型来预测后续token,展现了作为自监督学习[53]、多任务学习[54]以及少样本学习[4]的强大能力。近期,InstructGPT [48] 和 FLAN [8, 66] 表明,通过在指令数据集上进行微调,LLMs 可以转变为指令跟随模型。为了便于生成指令跟随示例,Self-Instruct [65] 采用半自动迭代自举算法,扩展了少量手动编写的指令种子集,并利用现成的大型语言模型逐步扩展任务集合。Alpaca [62] 应用 Self-Instruct 策略生成了52K高质量的指令跟随演示数据,并基于开源的 LLaMA [63] 模型进行微调,最终得到一个展现出与 OpenAI 的 text-davinci-003 类似行为的指令跟随语言模型。受到 Alpaca 成功的启发,Vicuna [7] 和 GPT-4-LLM [50] 进一步揭示,通过在用户共享的 ChatGPT 对话或由 GPT-4 API 生成的指令跟随数据上进行微调,可以激发对话和增强的指令跟随能力。然而,Alpaca、Vicuna 和 GPT-4-LLM 均对 LLMs 的全部参数进行微调,导致 GPU 内存使用和训练成本高昂。相比之下,LoRA [26] 和 LLaMA-Adapter [72] 验证了参数高效微调方法在监督微调 LLMs 时有可能替代全参数更新。在本文中,LLaMA-Adapter V2 更进一步,构建了一个参数高效的零样本视觉指令模型,复用了 LLaMA-Adapter 的指令跟随能力。

视觉指令模型

传统的图像描述[3, 9, 23, 32, 40, 64]和视觉问答(VQA)[2, 16, 20, 29, 34, 39, 41, 45, 77]方法可以视为视觉指令模型的简化版本。然而,与 GPT-4 相比,它们的图像理解能力不足。具体来说,图像描述模型只能用简短的句子描述图像,而 VQA 系统虽然能够回答各种与视觉相关的问题,但无法提供明确的解释。因此,这些系统尚未达到满足现实应用需求的能力水平。近期,GPT-4 展示了卓越的视觉指令跟随能力,能够处理图像和文本的混合输入,完成从表情包解释、文档级推理到考试问题解决等多样化任务。为了开发类似 GPT-4 的视觉指令跟随能力,LLaVA [38] 和 MiniGPT-4 [78] 使用 ChatGPT 或 GPT-4 构建高质量的多模态指令跟随数据,随后通过投影层整合视觉编码器和 LLMs,并在整理好的数据上微调模型。与这些方法不同,LLaMA-Adapter V2 致力于构建一个参数高效的视觉指令模型,而无需依赖多模态指令数据。相反,LLaMA-Adapter V2 仅使用语言指令数据和图像-文本对即可有效运作。

参数高效微调

预训练-微调范式在视觉识别、语言理解、文本生成和文本描述图像合成等任务中已被证明非常有效。然而,随着模型规模呈指数增长,对巨型模型的每个参数进行微调变得越来越不切实际。相比之下,参数高效微调(PEFT)方法[12, 49]冻结基础模型的大部分参数,仅优化其中一小部分。许多成功的 PEFT 方法[10, 17, 22, 28, 31, 59, 60, 71, 73]已被提出,用于将流行的预训练模型(如 BERT [11]、GPT [4, 53, 54]、ViT [13]、CLIP [52] 和 Stable Diffusion [55])适配到各种下游任务中。一般来说,这些 PEFT 方法可分为三类:前缀调优(如[35, 76])、重新参数化(如[10, 26, 43])和适配器(如[15, 24, 74])。在本文中,我们提出了 LLaMA-Adapter V2,它优雅而高效地结合了前缀调优和适配器技术。通过采用早期融合策略和偏置调优,LLaMA-Adapter V2 将视觉特征注入大型语言模型,仅使用整个 LLaMA 0.04%的参数即可实现令人印象深刻的多模态指令跟随性能。

专家系统整合

多个专家模型之间的协作在人工智能领域已被证明是一种成功的实践,因为它通常能带来性能和鲁棒性的提升。这在计算机视觉任务领域尤为明显,多个模型的集成常常在挑战排行榜上名列前茅。近年来,随着 LLMs 能力的持续扩展,越来越多地尝试[14, 18, 21, 27, 37, 42, 51, 58, 61, 67, 69, 79]将它们与视觉基础模型结合,发挥它们的综合优势以应对更复杂的视觉-语言任务。通过将 LLMs 作为外部视觉模型的核心控制器,这些专家反过来支持 LLMs 执行需要更深入视觉理解的更广泛任务。例如,HuggingGPT [58]、Visual ChatGPT [67]、Chameleon [42]、MMReACT [69] 和 ViperGPT [61] 等近期研究利用 LLMs 作为中央管理者进行组合任务规划,并调用现成的专家模型/工具来协助完成各种复杂多模态任务,包括理解、生成、搜索、推理和编程等。此外,PaLM-E [14]、Inner Monologue [27] 和 Text2Motion [37] 进一步将 LLMs 的能力扩展到机器人领域,融入了现实世界的传感器模式。这些具身化的 LLMs 具备理解自然语言指令并在现实世界中执行顺序操作规划的能力。因此,上述方法促进了不同专家系统的无缝整合,提升了 LLMs 的整体性能和能力。LLaMA-Adapter V2 通过在推理时整合由 LLaMA-Adapter 生成的简短而精确的描述,以高效的零样本和无训练方式实现视觉指令理解,区别于其他需要在训练期间使用大量多模态数据的方法。未来,将有更多的专家视觉系统被整合到 LLaMA-Adapter V2 中,以构建更强大的视觉指令模型。

3. LLaMA-Adapter 的回顾

零初始化注意力机制

LLaMA-Adapter [72] 是一种参数高效的微调解决方案,用于适配 LLaMA 模型 [63] 以获得指令跟随能力。它冻结了整个 LLaMA 模型,仅引入了一个包含 120 万参数的超轻量适配器模块。LLaMA-Adapter 在 LLaMA 的各层中将一组可学习的软提示(soft prompts)作为前缀与词语标记(word tokens)拼接。为了将新适配的知识注入到冻结的 LLaMA 中,LLaMA-Adapter 提出了一种零初始化注意力机制,通过学习一个初始值为零的门控因子,自适应地控制适配提示对词语标记的贡献。随着训练的进行,门控因子的大小逐渐增加,从而逐步将指令跟随能力注入到冻结的 LLaMA 中。这一策略不仅在早期训练阶段保留了 LLaMA 的语言生成能力,还持续引入新知识,使其成为强大的指令跟随者。

简单的多模态变体

除了使用纯语言指令进行微调外,LLaMA-Adapter 还可以整合图像和视频输入以实现多模态推理。例如,在处理图像时,LLaMA-Adapter 使用预训练的视觉编码器(如 CLIP [52])提取多尺度视觉特征。这些特征被聚合成一个全局特征,并通过一个可学习的投影层,将视觉语义与语言嵌入空间对齐。随后,全局视觉特征被逐元素地添加到 Transformer 高层的每个适配提示中。这使得 LLaMA-Adapter 能够基于文本和视觉输入生成响应,在 ScienceQA 基准测试 [41] 上取得了有竞争力的表现。

开放式多模态推理

虽然 LLaMA-Adapter 能够处理相对简单的任务(如 ScienceQA),但其是否能够生成开放式响应(例如通用视觉问答所需的响应)仍不明确。为了探究这一点,我们首先基于语言指令数据预训练 LLaMA-Adapter,以利用其现有的指令跟随能力。随后,我们通过在 COCO Caption [6] 数据集上微调其适配器模块和视觉投影层进行实验。然而,我们发现新学习的视觉线索往往会主导适配提示,覆盖原有的指令跟随特性。因此,我们提出了 LLaMA-Adapter V2,一种参数高效的视觉指令模型,以充分释放 LLaMA 的多模态潜力。

4. LLaMA-Adapter V2

在本节中,我们将介绍 LLaMA-Adapter V2 的技术细节,包括线性层的偏置调整(第 4.1 节)以增强其语言指令跟随能力、采用分离参数的联合训练(第 4.2 节)以实现平衡的视觉指令微调、早期融合视觉知识(第 4.3 节)以平衡文本和视觉理解,以及与专家模型的集成(第 4.4 节)以提升零样本多模态推理能力。

4.1. 线性层的偏置调整

LLaMA-Adapter 在冻结的 LLaMA 模型上采用了可学习的适应提示(参见第 3 节)以及零初始化的注意力机制,这使得新知识的高效整合成为可能。然而,参数更新仅限于适应提示和门控因子,而不修改大型语言模型(LLMs)的内部参数,这限制了其进行深度微调的能力。有鉴于此,我们提出了一种偏置调整策略,以在适应提示和门控因子之外,进一步将指令线索融合到 LLaMA 中。具体来说,为了自适应地处理指令跟随数据的任务,我们首先解冻 LLaMA 中的所有归一化层。对于 Transformer 中的每个线性层,我们添加了一个偏置和一个缩放因子作为两个可学习参数。我们将某个线性层的输入和预训练权重分别表示为 xxx 和 WWW。在 LLaMA-Adapter V2 中,我们使用偏置 bbb 和缩放因子 sss 修改线性层,如下所示:

wlnereb≡Init(0),s⟶Init(1).\mathrm{wlnere}\;\;\;b\equiv\;\mathrm{Init}(0),\;\;\;s\stackrel{}{\longrightarrow}\;\mathrm{Init}(1). wlnereb≡Init(0),s⟶Init(1).

与零初始化注意力机制类似,我们分别将偏置和缩放因子初始化为零和一,以在早期训练阶段稳定训练过程。通过结合偏置调整策略和高质量的指令数据 [50],LLaMA-Adapter V2 获得了卓越的指令跟随能力。值得注意的是,新添加的参数数量仅占整个 LLaMA 的 0.04%(约 500 万),显示出 LLaMA-Adapter V2 仍然是一种高度参数高效的方法。

讨论:我们的偏置调整策略与之前的参数高效方法(如用于 BERT 微调的 BitFit [70] 和用于视觉提示调整的 SSF [36] [28])有相似之处。然而,BitFit 和 SSF 都是为参数规模约为 8000 万的理解任务设计的,而我们的偏置调整策略在大规模语言模型(如 LLaMA 和 GPT-3)上展示了其高效性,参数规模从 70 亿到 650 亿不等。此外,我们的偏置调整策略与输入无关,不像低秩适应(LoRA)那样通过低秩变换添加与输入相关的偏置,从而进一步降低了微调成本。

4.2. 联合训练与分离参数

我们的目标是同时赋予 LLaMA-Adapter V2 生成长语言响应和多模态理解的能力。如图 2 所示,我们提出了一个联合训练范式,使 LLaMA-Adapter V2 能够利用图像-文本描述数据和纯语言指令示例进行训练。由于 50 万图像-文本对和 5 万指令数据在数据量上的差异,直接将它们组合进行优化会严重损害 LLaMA-Adapter 的指令遵循能力,正如第 3 节所讨论的。因此,我们的联合训练策略针对图像-文本对齐和指令遵循分别优化 LLaMA-Adapter V2 中分离的参数组。具体来说,仅对图像-文本描述数据训练视觉投影层和早期的零初始化注意力机制(带有门控),而对指令遵循数据则使用后期的适应提示与零门控、未冻结的归一化层、新增的偏置和缩放因子(或可选的低秩适应 [25])进行学习。

这种分离参数优化策略自然地解决了图像-文本理解和指令遵循之间的干扰问题,从而促成了 LLaMA-Adapter V2 突出的视觉指令遵循能力。

讨论:借助我们的联合训练策略,LLaMA-Adapter V2 不需要像 MiniGPT-4 [78] 和 LLaVA [38] 那样的高质量多模态指令数据,而仅需图像-文本对和指令遵循数据,如表 1 所示。描述数据通过短回答扩展了大型语言模型(LLM)的图像理解能力,如图 2 所示,而纯语言指令数据则用于保留 LLaMA 生成长而详细句子的能力。通过这种互补性,LLaMA-Adapter V2 能够在大规模图像-文本和指令遵循数据上进行训练,而无需高质量的多模态指令数据。

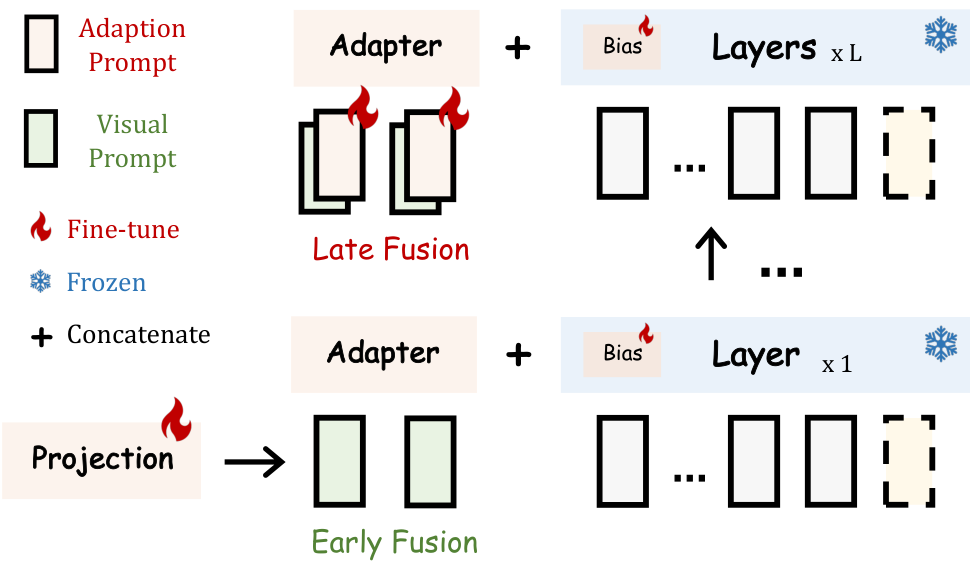

4.3. 视觉知识的早期融合

为了避免视觉和语言微调之间的干扰,我们提出了一种简单的早期融合策略,以防止输入的视觉提示和适应提示之间的直接交互。在 LLaMA-Adapter 中,输入的视觉提示由一个冻结的视觉编码器按顺序编码,并通过一个可学习的视觉投影层,然后在每个插入层与适应提示相加。而在 LLaMA-Adapter V2 中,我们将编码后的视觉标记和适应提示注入到不同的 Transformer 层中,而不将它们融合在一起,如图 3 所示。对于数据集共享的适应提示,我们遵循 LLaMA-Adapter 的做法,将其插入到最后 L 层(例如,L=30)。对于输入的视觉提示,我们直接在第一层 Transformer 层中与词标记拼接,并使用零初始化注意力机制,而非将其添加到适应提示中。结合所提出的联合训练策略,这种视觉标记的简单早期融合策略能够有效解决两种微调目标之间的冲突。这有助于构建一个参数高效的 LLaMA-Adapter V2,具备卓越的多模态推理能力。

5. 实验

5.1. 实验设置

训练数据:如表1所示,我们使用来自GPT-4-LLM [50] 的52K单轮指令数据和来自COCO Caption [6] 的567K图像描述数据对LLaMA-Adapter V2进行训练。我们没有使用类似MiniGPT-4 [78] 和LLaVA [38] 的视觉指令数据。此外,我们还使用ShareGPT [1] 收集的80K对话数据训练了一个聊天机器人系统。

![Figure 5. Response Quality Comparisons assessed by GPT4. The comparison baseline is ChatGPT. We use GPT4 to assess the response quality of different methods on 80 questions [7]. Note that our model is based on LLaMA-65B, while Vicuna is built on LLaMA-13B. But we only fine-tune 14M parameters, while Vicuna requires fine-tuning the whole 13B parameters.](https://i-blog.csdnimg.cn/img_convert/e498e77c18fd6cd5e9a262569ff59bbf.png)

实现细节:对于具有32个Transformer层的LLaMA-7B模型,我们在最后31层中插入静态适应提示。此外,我们在第一层附加动态视觉提示,提示长度设置为20。训练期间,归一化层、线性层偏置和缩放的所有参数都被设置为可更新,而LLaMA中的其余参数保持冻结。

5.2. 更强的语言指令模型

通过提出的偏置调整策略和高质量指令数据 [50],LLaMA-Adapter V2 进一步增强了LLaMA的指令跟随能力。如表2所示,LLaMA-Adapter V2 能够对人类指令提供全面的回答以及详细的解释,而LLaMA-Adapter 仅提供相对较短的回答。

考虑到偏置调整涉及到更多的可学习参数用于知识更新,因此可以构建一个需要更深入理解语言上下文的聊天机器人系统。通过在80K对话数据 [1] 上训练LLaMA-Adapter V2,我们开发了一个更强的聊天机器人模型。

![Table 3. Comparisons on COCO Caption. BLIP and BLIP2 require pretraining (PT) on COCO Caption [6], Visual Genome [30], Conceptual Captions [5, 57] and LAION [56], while ClipCap and our approach only fine-tune (FT) the model on COCO Caption.](https://i-blog.csdnimg.cn/img_convert/61e95c6a7cd78110635b790c396688c5.png)

图11展示了一个使用70亿参数模型的聊天机器人示例,该系统能够回答我们的问题,但对上下文的理解不够准确。通过将模型扩展到650亿参数(图10),聊天机器人变得更强。在图5中,我们还使用GPT4评估响应质量,其中LLaMA-Adapter V2 在总分和80个问题中的50个问题上甚至超过了ChatGPT。

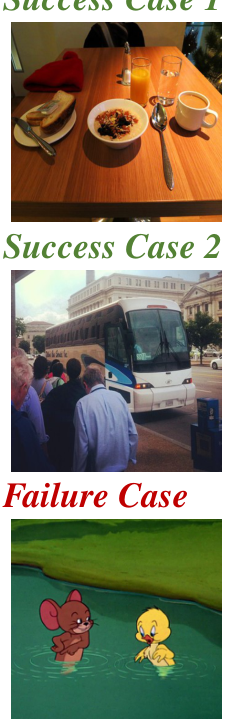

5.3. 可视化指令模型

LLaMA-Adapter 主要是一个语言指令模型或闭集视觉-语言模型,而 LLaMA-Adapter V2 则是一个强大的可视化指令模型,通过在标题数据和纯语言指令数据上的联合训练得以实现。在本节中,我们研究了 LLaMA-Adapter V2 的图像标题生成能力,并展示了如何将其扩展为像 GPT-4 这样的通用多模态理解系统。此外,我们还引入了专家系统以进一步提升 LLaMA-Adapter V2 的视觉指令跟随能力。

图像标题生成。正如第 3 节所述,LLaMA-Adapter 通过简单地将视觉特征添加到适应性提示中来支持多模态输入。在 COCO Caption 数据集上进行微调后,我们将 LLaMA-Adapter 转变为一个强大的图像标题生成器。在表 3 中可以观察到,LLaMA-Adapter 取得了与 BLIP [32,33] 相当的结果,即使没有在大规模图像-文本数据上进行预训练。然而,由于 LLaMA-Adapter 对特定提示(如“为此图像生成标题”)较为敏感,它无法重用大型语言模型(LLM)的语言建模能力。

通过采用早期融合和联合训练,LLaMA-Adapter V2 成为一个强大的可视化指令模型,可以同时执行语言指令跟随和图像标题生成。我们在图 6 中提供了一些示例,比较了 LLaMA-Adapter 和 LLaMA-Adapter V2 在图像标题生成上的结果。对于给定的图像,LLaMA-Adapter 只能生成简短的封闭式图像描述,而 LLaMA-Adapter V2 能够生成自然且详细的图像描述。

成功案例 1

V1:一碗麦片、一杯咖啡和一个三明治在桌子上。

V2:图像展示了一张布置好的餐桌,上面摆放了各种食物,包括一碗水果、一杯咖啡和一盘糕点。桌上还摆放了刀、叉和勺子,表明食物已经准备好可以食用。餐桌位于厨房内,旁边放着一把椅子。椅子靠近一个小桌子,可能用于放置额外的食物或饮料。房间光线充足,一盏灯照亮了整个区域。

V2:图像中,一辆大型公交车停在路边,附近站着几个人。至少有三个人站在公交车旁,其中一个人拿着背包,另一个人拿着袋子。背景中还有几个人正走向公交车。公交车漆成白色,前端可见,前面站着几个人。背景中还可见几辆汽车,增添了街头的繁忙景象。

V1:一只老鼠和一只鸭子在水体中。

V2:图像中,两名男子站在湖边或河边的码头上。一名男子穿着蓝色衬衫,另一名穿着白色衬衫。两人都低头看着下方,似乎在钓鱼。他们站在一个小石块区域附近,水没到膝盖。图像中还有一只狗,一只黄色的拉布拉多寻回犬,正在水中游泳,靠近两人。狗似乎被渔夫的存在吸引,游向他们。狗戴着红色项圈,似乎很享受与两名男子在水中的时光。

论文摘要(中文)

以下是对论文中指定部分的中文总结,同时保留了原文中的图像部分及其格式和位置。

论文摘要(中文)

以下是对所提供论文片段的中文总结,保留了原文中的图片和格式:

6. 结论

在这项工作中,我们提出了 LLaMA-Adapter V2,一个参数高效的视觉指令调优系统。通过对图像-文本对和指令跟随数据的联合训练,我们观察到 LLaMA-Adapter V2 能够将预训练的大型语言模型(LLM)转化为零样本视觉指令模型。在简单的偏置调优策略和视觉特征早期融合的帮助下,LLaMA-Adapter V2 的零样本视觉指令跟随能力得到了进一步提升,减轻了图像-文本对与指令跟随数据之间的干扰。同时,LLaMA-Adapter V2 展现出更强的语言指令跟随性能,甚至具备类似聊天机器人的多轮对话能力。为了解决 LLaMA-Adapter V2 在图像描述不准确的问题,我们集成了专家视觉系统,例如 OCR 和图像描述器,以提供更准确的图像相关信息。尽管 LLaMA-Adapter V2 能够整合专家视觉系统并以零样本方式执行视觉指令跟随,但其视觉理解能力仍落后于 LLaVA,并且容易受到专家系统提供的不准确信息的影响。未来,我们计划探索更多专家系统的集成,并使用多模态指令数据集或其他参数高效微调方法(例如 LoRA)对 LLaMA-Adapter V2 进行微调,以进一步增强其视觉指令跟随能力。

论文摘要(中文)与原文Markdown图像部分

以下是对论文中指定部分的中文摘要,同时保留了原文中Markdown格式的图像部分在适当位置。

中文摘要

这段论文内容引用了多项与视觉语言模型、预训练语言模型以及学术研究对话模型相关的研究成果。其中包括对视觉问答(Visual Question Answering, VQA)、参数高效迁移学习以及领域专家与大型语言模型(LLM)结合的研究。此外,还提及了关于视觉编程和少样本学习(few-shot learning)的重要工作。

在对话示例中,使用了65B LLaMA-Adapter V2模型进行聊天展示。用户表达了希望与多位历史名人会面的愿望,包括阿尔伯特·爱因斯坦(Albert Einstein)、史蒂夫·乔布斯(Steve Jobs)、莱昂纳多·达·芬奇(Leonardo da Vinci)、珍·古道尔(Jane Goodall)和纳尔逊·曼德拉(Nelson Mandela)。针对用户对爱因斯坦的进一步提问,Assistant-7B详细解释了爱因斯坦的主要贡献,即他提出的广义相对论(General Theory of Relativity),这是现代物理学的两大支柱之一(另一支柱为量子力学)。广义相对论奠定了现代宇宙学的基础,深刻影响了我们对宇宙的理解,并推动了原子弹和激光等技术的发展。

此外,Assistant-7B还回答了关于爱因斯坦最著名方程的问题,即能量-质量方程 E=mc2E = mc^2E=mc2。此方程是核物理的基础,对核武器的开发具有重要意义,同时也对黑洞研究和引力本质的理解产生了深远影响。该方程作为相对论的直接推论,已被高精度实验验证。

原文Markdown图像部分

以下为原文中关于聊天示例的部分,保持其原始格式:

Figure 10. A Chatting Example using 65B LLaMA-Adapter V2.

Assistant-7B:

● Albert Einstein: I would love to meet the genius physicist who revolutionized our understanding of the universe.

● Steve Jobs: I would like to meet the visionary who changed the way we communicate and interact with technology.

● Leonardo da Vinci: I would like to meet the artist, inventor, and scientist who was a true Renaissance man.

● Jane Goodall: I would like to meet the primatologist who has dedicated her life to studying and protecting chimpanzees.

● Nelson Mandela: I would like to meet the anti-apartheid activist and former South African president who fought for equality and freedom.

Human: Could you explain me the main contribution of the first person you mentioned?

Assistant-7B: Albert Einstein was a German-born theoretical physicist who developed the general theory of relativity, one of the two pillars of modern physics (alongside quantum mechanics). His theory of relativity is the foundation of modern cosmology and has had a profound impact on our understanding of the universe.

Einstein’s theory of relativity revolutionized our understanding of space and time, and it has been experimentally verified to a high degree of accuracy. It has also led to the development of the atomic bomb and the laser, among other technological advancements.

Einstein’s contributions to physics are immense, and his work has had a lasting impact on the field. He is widely considered one of the most influential scientists of all time.

Human: What is the most famous equation from this theory?

Assistant-7B: The most famous equation from the theory of relativity is the famous E=mc2E = mc^2E=mc2 equation, which states that energy (EEE) is equal to mass. This equation is the foundation of nuclear physics and is the basis for the development of nuclear weapons. It also has important implications for the study of black holes and the nature of gravity.

The equation is a direct consequence of the theory of relativity, and it has been experimentally verified to a high degree of accuracy. It has had a profound impact on our understanding of the universe and has led to many technological advancements.

论文部分总结(中文)

以下是对论文中特定部分的中文总结,保留了原文中的 Markdown 格式图片标题及其位置。

图表示例

在论文中,作者展示了一个使用 7B LLaMA-Adapter V2 的聊天示例,以说明模型在实际对话场景中的应用效果。

Figure 11. A Chatting Example using 7B LLaMA-Adapter V2.

总结

本部分主要引用了大量与视觉语言模型、参数高效微调方法以及大型语言模型相关的文献。这些文献涵盖了从图像描述、视觉问答到多模态推理等多个领域的研究成果。作者引用了如 LoRA(低秩适应)、Visual Instruction Tuning 等关键技术,旨在说明如何通过高效的微调方法提升模型在视觉与语言任务上的表现。此外,文中还提及了多个数据集(如 Visual Genome、LAION-400M)和模型(如 BLIP、GPT-4),为研究提供了数据和方法支持。这些引用为论文提出的 LLaMA-Adapter V2 模型提供了理论和实践基础,特别是在视觉语言理解与生成任务中的应用。

Original Abstract: How to efficiently transform large language models (LLMs) into instruction

followers is recently a popular research direction, while training LLM for

multi-modal reasoning remains less explored. Although the recent LLaMA-Adapter

demonstrates the potential to handle visual inputs with LLMs, it still cannot

generalize well to open-ended visual instructions and lags behind GPT-4. In

this paper, we present LLaMA-Adapter V2, a parameter-efficient visual

instruction model. Specifically, we first augment LLaMA-Adapter by unlocking

more learnable parameters (e.g., norm, bias and scale), which distribute the

instruction-following ability across the entire LLaMA model besides adapters.

Secondly, we propose an early fusion strategy to feed visual tokens only into

the early LLM layers, contributing to better visual knowledge incorporation.

Thirdly, a joint training paradigm of image-text pairs and

instruction-following data is introduced by optimizing disjoint groups of

learnable parameters. This strategy effectively alleviates the interference

between the two tasks of image-text alignment and instruction following and

achieves strong multi-modal reasoning with only a small-scale image-text and

instruction dataset. During inference, we incorporate additional expert models

(e.g. captioning/OCR systems) into LLaMA-Adapter to further enhance its image

understanding capability without incurring training costs. Compared to the

original LLaMA-Adapter, our LLaMA-Adapter V2 can perform open-ended multi-modal

instructions by merely introducing 14M parameters over LLaMA. The newly

designed framework also exhibits stronger language-only instruction-following

capabilities and even excels in chat interactions. Our code and models are

available at https://github.com/ZrrSkywalker/LLaMA-Adapter.

PDF Link: 2304.15010v1

部分平台可能图片显示异常,请以我的博客内容为准