【AI论文】LongVie:多模态引导的可控超长视频生成

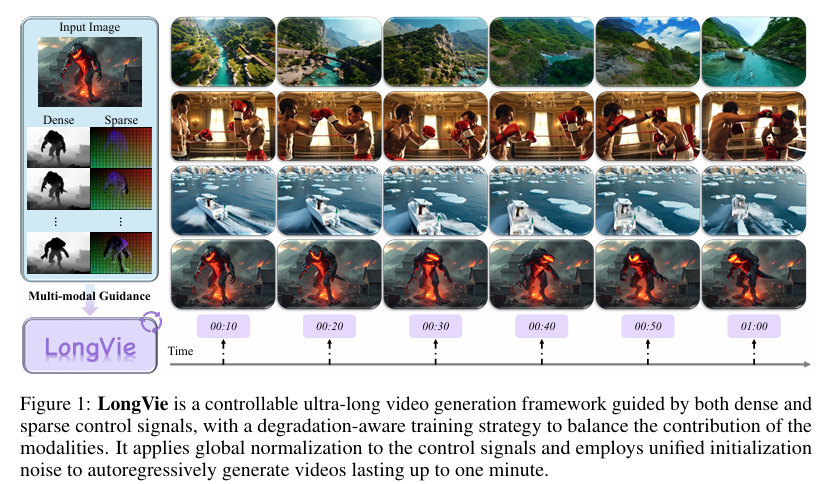

摘要:可控超长视频生成是一项基础且颇具挑战性的任务。尽管现有方法在处理短视频片段时效果显著,但由于存在时间不一致性和视觉质量退化等问题,这些方法难以扩展应用到更长的视频生成。本文首先研究并确定了三个关键因素:独立的噪声初始化、独立控制信号归一化,以及单模态引导的局限性。为解决这些问题,我们提出了LongVie——一个用于可控长视频生成的端到端自回归框架。LongVie引入了两项核心设计以确保时间一致性:1)采用统一的噪声初始化策略,保证不同片段生成的一致性;2)采用全局控制信号归一化方法,确保整个视频控制空间内的一致性。为缓解视觉质量退化问题,LongVie采用了3)一个多模态控制框架,该框架整合了密集型(如深度图)和稀疏型(如关键点)控制信号,并辅以4)一种退化感知训练策略,该策略能随时间自适应地平衡不同模态的贡献,从而保持视觉质量。此外,我们还推出了LongVGenBench——一个综合性基准测试集,其中包含100个高分辨率视频,涵盖多样化的真实世界和合成环境,每个视频时长均超过一分钟。大量实验表明,LongVie在长距离可控性、一致性和质量方面均达到了最先进的性能水平。Huggingface链接:Paper page,论文链接:2508.03694

研究背景和目的、研究方法、研究结果、研究局限及未来研究方向总结

1. 研究背景和目的

研究背景

随着深度学习技术的快速发展,视频生成领域取得了显著进展,尤其是在短片段视频生成方面,现有方法已经能够生成高质量、与文本提示高度一致的视频内容。然而,当涉及到生成超长(如持续一分钟以上)、可控且时间上一致的视频时,现有方法面临诸多挑战。这些问题主要包括时间不一致性(temporal inconsistency)和视觉质量退化(visual degradation)。

- 时间不一致性:在生成长视频时,由于每个视频片段独立生成,片段间的过渡往往不够平滑,导致场景转换不自然或闪烁。这种不一致性在视频长度增加时尤为明显,严重影响了观看体验。

- 视觉质量退化:长时间生成过程中,由于累积误差和单模态控制的局限性,视频的视觉质量会逐渐下降。例如,仅依赖深度图等密集信号可能导致生成内容缺乏高级语义信息,而仅依赖关键点等稀疏信号则可能缺乏足够的空间细节。

研究目的

本研究旨在解决可控超长视频生成中的时间不一致性和视觉质量退化问题,提出一种新的框架——LongVie,以实现高质量、可控且时间上一致的超长视频生成。具体目标包括:

- 分析现有方法的局限性:深入探讨导致时间不一致性和视觉质量退化的根本原因。

- 提出解决方案:设计一个多模态引导的可控超长视频生成框架,通过统一的噪声初始化和全局控制信号归一化来增强时间一致性,同时采用多模态控制和退化感知训练策略来保持视觉质量。

- 构建评估基准:创建一个包含100个高分辨率、多样化场景的视频基准测试集LongVGenBench,用于评估超长视频生成的性能。

- 验证框架有效性:通过大量实验验证LongVie在长距离可控性、一致性和质量方面的优越性。

2. 研究方法

框架设计

LongVie框架基于自回归生成模型,通过多模态控制信号引导视频生成过程。框架的核心组件包括:

- 多模态控制注入:采用深度图(密集信号)和关键点(稀疏信号)作为控制信号,通过ControlNet风格的架构将控制信号注入到基础视频生成模型中。

- 统一的噪声初始化:所有视频片段使用相同的初始噪声实例,确保生成过程的一致性。

- 全局控制信号归一化:对深度图进行全局归一化处理,确保整个视频中控制信号的一致性。

- 退化感知训练策略:通过特征级和数据级退化策略,动态平衡密集和稀疏控制信号的贡献,防止视觉质量退化。

实现细节

- 基础模型:以CogVideoX为基础模型,扩展ControlNet风格的架构以支持多模态控制信号。

- 控制信号提取:使用Video Depth Anything提取深度图,使用SpatialTracker提取关键点轨迹。

- 训练数据:收集了包括ACID、VchitectT2V-DataVerse和MovieNet在内的多个数据集,共计130,000个视频用于训练。

- 评估指标:采用背景一致性、主体一致性、整体一致性、时间风格、动态程度、时间闪烁和成像质量等七个指标进行评估。

3. 研究结果

定量结果

- LongVGenBench基准测试:在包含100个高分辨率视频的基准测试集上,LongVie在所有评估指标上均达到了最优性能,显著超越了其他基线方法。具体指标包括背景一致性(Background Consistency)、主体一致性(Subject Consistency)、整体一致性(Overall Consistency)、时间风格(Temporal Style)、动态程度(Dynamic Degree)、时间闪烁(Temporal Flickering)和成像质量(Imaging Quality)。

- 用户研究:通过用户研究验证了LongVie在视觉质量、提示-视频一致性、条件一致性、颜色一致性和时间一致性方面的优越性。参与用户普遍认为LongVie生成的视频在各个方面均优于其他基线方法。

定性结果

- 视频编辑:LongVie能够实现对长视频中目标人物或物体的精确替换,保持编辑后视频的时间一致性。

- 运动和场景转移:LongVie支持复杂运动和场景的长视频转移,生成的视频能够保持转移后的运动和场景特征,同时确保时间一致性。

- 可控网格到视频生成:LongVie能够从无纹理的动画3D网格生成逼真的长视频,实现动画3D资产与真实感域的无缝集成。

4. 研究局限

尽管LongVie在可控超长视频生成方面取得了显著进展,但仍存在一些局限性:

- 推理时间:生成一分钟可控视频大约需要45分钟,推理过程相对耗时。未来需要进一步优化以提高生成效率。

- 输出分辨率:当前输出分辨率虽能满足基准测试需求,但仍未达到电影级标准。未来工作将探索更高分辨率的生成框架。

- 初始帧敏感性:LongVie对初始帧的质量和内容较为敏感,初始帧的不一致可能导致生成视频质量下降。未来需要改进对初始帧的鲁棒性。

5. 未来研究方向

针对LongVie的局限性和当前研究的不足,未来研究将聚焦于以下几个方面:

- 提高生成效率:通过优化模型结构和算法,减少生成一分钟可控视频所需的时间,提高推理效率。

- 提升输出分辨率:探索更高分辨率的视频生成框架,生成视觉上更丰富、更逼真的长视频。

- 增强初始帧鲁棒性:改进模型对初始帧的鲁棒性,减少初始帧不一致对生成视频质量的影响。

- 多语言支持:扩展模型的语言支持能力,使其能够处理多种语言的指令和生成任务,提升模型的通用性和实用性。

- 持续优化与部署:进一步优化模型结构和训练方法,降低部署成本,推动多模态AI技术在更多实际场景中的应用。例如,在短内容创作、电影制作等领域,LongVie有望显著简化视频制作流程,拓展创意可能性。

- 开放模型与数据集:开放模型权重、训练代码和数据集,促进参数高效统一多模态架构的进一步研究,加速多模态AI技术的发展和应用。

总之,本研究提出的LongVie框架在可控超长视频生成方面取得了显著进展,为未来的研究提供了宝贵的经验和方向。通过持续优化和创新,我们有望看到更多高质量、可控且时间上一致的长视频生成应用。