【LLM】Openai分析大模型出现幻觉的原因

note

- 大模型幻觉的原因:标准的训练和评估程序更倾向于对猜测进行奖励,而不是在模型勇于承认不确定时给予奖励。

- 要减少幻觉,需调整现有评估基准的评分方式,而非仅增加幻觉专项评测。通过显式引入置信目标,可以引导模型更诚实地表达不确定性

- 通过“Is-It-Valid”(IIV)二元分类问题的形式化分析,我们证明生成错误与分类错误之间存在数学关联:生成错误率至少是IIV分类错误率的两倍。这一结果表明,即使训练数据完全正确,模型仍会因统计压力而产生幻觉。

- 当前主流评测(如MMLU、GPQA)采用二元评分(正确1分/错误0分),实际上鼓励模型在不确定时猜测。论文建议:

- 引入显式置信度阈值(如只允许>90%确信的回答)

- 修改评分规则:正确+1分,错误-t/(1-t)分,IDK得0分

文章目录

- note

- 一、大模型的幻觉

- 1、幻觉出现的原因(统计学角度):

- (1)关于"生成错误率至少是IIV分类错误率的两倍"的含义

- (2)两者的内在关联

- 2、预训练阶段的错误分析:

- 3、后训练阶段的幻觉持续存在:

- 二、如何缓解现状

- Reference

一、大模型的幻觉

论文标题:Why Language Models Hallucinate

论文地址:https://cdn.openai.com/pdf/d04913be-3f6f-4d2b-b283-ff432ef4aaa5/why-language-models-hallucinate.pdf

幻觉问题:幻觉是语言模型生成的看似合理但却错误的陈述。

1、幻觉出现的原因(统计学角度):

- 我们提出了一种理论框架,将语言模型的幻觉问题归因于二元分类错误的统计特性。具体而言,幻觉源于模型在不确定时倾向于“猜测”而非承认不确定性,这与训练和评估过程中对猜测行为的奖励机制密切相关。

- 通过“Is-It-Valid”(IIV)二元分类问题的形式化分析,我们证明生成错误与分类错误之间存在数学关联:生成错误率至少是IIV分类错误率的两倍。这一结果表明,即使训练数据完全正确,模型仍会因统计压力而产生幻觉。

(1)关于"生成错误率至少是IIV分类错误率的两倍"的含义

-

理论框架

论文提出了"Is-It-Valid (IIV)"二元分类问题:给定一个生成文本,判断其是否有效(+)或错误(-)。通过将语言模型生成任务转化为IIV分类问题,建立了生成错误率(err)与IIV误分类率(err_iiv)的数学关系:err≥2⋅erriiv−∣V∣∣E∣−δ\text{err} \geq 2 \cdot \text{err}_{\text{iiv}} - \frac{|\mathcal{V}|}{|\mathcal{E}|} - \delta err≥2⋅erriiv−∣E∣∣V∣−δ

-

关键发现

- 生成错误的下界由IIV分类错误率决定,系数2表明生成错误更易发生

- 当模型难以区分有效/错误文本时(err_iiv高),生成错误率会显著升高

- δ代表模型校准误差,良好校准的模型(δ≈0)更符合该下界

-

实例说明

在生日查询案例中,模型三次输出不同错误日期(03-07, 15-06, 01-01),而正确答案应在秋季。这说明模型对日期有效性的判断存在较高IIV误分类率,导致生成错误率更高。

以GPT5-thinking-mini、openai o4-mini模型在SimpleQA benchmark举例(如下表):单看accuracy rate指标,后者甚至高2%,但是gpt4的错误率(如幻觉率)高很多,即不确定的情况可以进行猜测,这样从大盘层面看可能会提升accuracy,但不代表就幻觉很低。

(2)两者的内在关联

-

统计本质

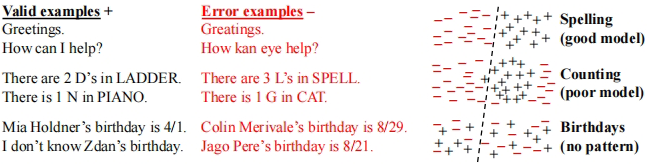

图1显示当数据存在不可学习模式(如随机事实)时,IIV分类器会产生错误,进而通过2倍关系放大生成错误。

-

训练数据影响

- 高singleton rate → IIV分类困难 → 高err_iiv → 更高生成错误

- 论文表1展示的博士论文标题幻觉案例(三个模型均输出错误标题)正是singleton效应的体现

2、预训练阶段的错误分析:

- 在预训练阶段,模型通过最小化交叉熵损失来拟合语言分布,但这一目标本身会导致模型在无法区分正确与错误陈述时生成幻觉。

- 我们进一步分析了“任意事实”(Arbitrary Facts)场景,即某些事实在训练数据中仅出现一次(singleton rate)。在此情况下,模型对这些事实的幻觉率至少与singleton rate成正比。

关于"singleton rate与幻觉率成正比"的解释:

-

核心概念

- Singleton rate:训练数据中仅出现一次的事实占比(如某人生日仅在讣告中出现一次)

- Missing Mass:未在训练数据中出现的事件的总概率(Good-Turing估计)

-

理论关系

论文证明对于任意事实集合,当训练数据中存在singleton时:

err≥sr−2min∣Ec∣−O(1/N)\text{err} \geq \text{sr} - \frac{2}{\min|\mathcal{E}_c|} - O(1/\sqrt{N}) err≥sr−min∣Ec∣2−O(1/N) -

实证影响

- 若20%生日事实在训练数据中仅出现一次,模型对生日问题的幻觉率至少20%。-> 大概就是说长尾训练数据,很难让模型学清楚。

- 这种现象源于统计学习的基本限制:罕见事实的泛化能力弱

3、后训练阶段的幻觉持续存在:

- 后训练阶段(如RLHF)旨在减少幻觉,但当前的主流评估基准(如MMLU、GPQA等)普遍采用二元评分(0/1),鼓励模型在不确定时猜测而非表达不确定性。

- 我们提出“显式置信目标”(explicit confidence targets)作为解决方案,即在评估中明确设置置信阈值,对不确定的回答给予部分奖励,从而减少幻觉的激励。

当下很多LLM评测benchmark都是二分类(对/错)的形式:

二、如何缓解现状

-

评估体系改革

当前主流评测(如MMLU、GPQA)采用二元评分(正确1分/错误0分),实际上鼓励模型在不确定时猜测。论文建议:- 引入显式置信度阈值(如只允许>90%确信的回答)

- 修改评分规则:正确+1分,错误-t/(1-t)分,IDK得0分

-

技术改进方向

- 预训练阶段:增强对singleton事实的识别

- 后训练阶段:建立"行为校准"机制,使模型能根据置信度阈值动态选择响应策略

Reference

[1] https://openai.com/index/why-language-models-hallucinate/

[2] Why Language Models Hallucinate