Python多序列同时迭代完全指南:从基础到高并发系统实战

引言:多序列迭代的核心价值

在现代数据处理和系统开发中,同时迭代多个序列是解决复杂问题的关键技术。根据2024年数据工程报告:

92%的数据分析任务需要多序列对齐

85%的机器学习特征工程涉及多序列处理

78%的实时系统需要同步多个数据流

65%的金融交易系统依赖多序列关联分析

Python提供了强大的多序列迭代工具,但许多开发者未能充分利用其全部潜力。本文将深入解析Python多序列迭代技术体系,结合Python Cookbook精髓,并拓展数据分析、机器学习、实时系统等工程级应用场景。

一、基础多序列迭代

1.1 使用zip基础

# 基本zip使用

names = ['Alice', 'Bob', 'Charlie']

ages = [25, 30, 35]

salaries = [50000, 60000, 70000]print("基本zip迭代:")

for name, age, salary in zip(names, ages, salaries):print(f"{name}: {age}岁, 薪资: ${salary}")# 输出:

# Alice: 25岁, 薪资: $50000

# Bob: 30岁, 薪资: $60000

# Charlie: 35岁, 薪资: $700001.2 处理不等长序列

from itertools import zip_longest# 不等长序列

students = ['Alice', 'Bob', 'Charlie', 'David']

scores = [90, 85, 92]print("\nzip_longest迭代:")

for student, score in zip_longest(students, scores, fillvalue='缺考'):print(f"{student}: {score}")# 输出:

# Alice: 90

# Bob: 85

# Charlie: 92

# David: 缺考二、高级多序列迭代技术

2.1 多序列并行处理

def parallel_process(iterables, func):"""多序列并行处理"""for args in zip(*iterables):yield func(*args)# 使用示例

a = [1, 2, 3]

b = [4, 5, 6]

c = [7, 8, 9]result = parallel_process([a, b, c], lambda x, y, z: x*y + z)

print("并行处理结果:", list(result)) # [11, 18, 27]2.2 多序列条件过滤

def multi_filter(iterables, condition):"""多序列条件过滤"""for args in zip(*iterables):if condition(*args):yield args# 使用示例

temperatures = [22.1, 23.5, 21.8, 25.3, 20.6]

humidities = [45, 60, 55, 70, 50]# 筛选高温高湿数据

filtered = multi_filter([temperatures, humidities], lambda t, h: t > 23 and h > 55)

print("高温高湿数据:")

for t, h in filtered:print(f"温度: {t}℃, 湿度: {h}%") # (23.5, 60), (25.3, 70)三、时间序列对齐

3.1 时间戳对齐

def align_time_series(series1, series2, time_key='timestamp'):"""时间序列对齐"""# 创建时间索引映射index_map = {}for item in series1:index_map[item[time_key]] = item# 对齐序列for item in series2:ts = item[time_key]if ts in index_map:yield index_map[ts], item# 使用示例

temp_data = [{'timestamp': '2023-01-01 10:00', 'temp': 22.1},{'timestamp': '2023-01-01 11:00', 'temp': 23.5},{'timestamp': '2023-01-01 12:00', 'temp': 25.3}

]hum_data = [{'timestamp': '2023-01-01 10:00', 'hum': 45},{'timestamp': '2023-01-01 11:00', 'hum': 60},{'timestamp': '2023-01-01 12:00', 'hum': 55}

]print("时间序列对齐:")

for temp, hum in align_time_series(temp_data, hum_data):print(f"时间: {temp['timestamp']}, 温度: {temp['temp']}, 湿度: {hum['hum']}")3.2 重采样对齐

def resample_align(series1, series2, freq='H'):"""重采样对齐时间序列"""import pandas as pd# 创建DataFramedf1 = pd.DataFrame(series1).set_index('timestamp')df2 = pd.DataFrame(series2).set_index('timestamp')# 重采样df1_resampled = df1.resample(freq).mean()df2_resampled = df2.resample(freq).mean()# 对齐aligned = pd.concat([df1_resampled, df2_resampled], axis=1).dropna()return aligned.iterrows()# 使用示例

# 假设有更多数据点

aligned = resample_align(temp_data, hum_data)

print("\n重采样对齐:")

for ts, row in aligned:print(f"时间: {ts}, 温度: {row['temp']}, 湿度: {row['hum']}")四、数据工程应用

4.1 特征工程

def feature_engineering(features, labels):"""多序列特征工程"""for feature_vec, label in zip(features, labels):# 创建新特征new_feature = sum(feature_vec) / len(feature_vec) # 平均值yield feature_vec + [new_feature], label# 使用示例

features = [[1.2, 3.4, 5.6],[2.3, 4.5, 6.7],[3.4, 5.6, 7.8]

]

labels = [0, 1, 0]print("特征工程结果:")

for new_features, label in feature_engineering(features, labels):print(f"特征: {new_features}, 标签: {label}")4.2 数据合并

def merge_datasets(datasets, key='id'):"""多数据集合并"""# 创建主索引master_index = {}for dataset in datasets:for item in dataset:item_key = item[key]if item_key not in master_index:master_index[item_key] = {}master_index[item_key].update(item)# 生成合并数据for key, data in master_index.items():yield data# 使用示例

users = [{'id': 1, 'name': 'Alice'}, {'id': 2, 'name': 'Bob'}]

orders = [{'id': 1, 'order': 'A123'}, {'id': 2, 'order': 'B456'}]

payments = [{'id': 1, 'amount': 100}, {'id': 2, 'amount': 200}]print("数据合并结果:")

for merged in merge_datasets([users, orders, payments]):print(merged)五、实时系统应用

5.1 多传感器数据融合

class SensorFusion:"""多传感器数据融合系统"""def __init__(self, sensors):self.sensors = sensorsdef read(self):"""读取并融合传感器数据"""# 同时读取所有传感器readings = [sensor.read() for sensor in self.sensors]# 简单融合:平均值avg_value = sum(readings) / len(readings)return avg_value, readingsdef continuous_fusion(self):"""连续数据融合"""while True:yield self.read()# 传感器模拟

class MockSensor:def __init__(self, name):self.name = nameself.value = 0def read(self):self.value += 1return self.value# 使用示例

sensor1 = MockSensor('温度')

sensor2 = MockSensor('湿度')

fusion = SensorFusion([sensor1, sensor2])print("传感器融合:")

for _ in range(3):avg, readings = fusion.read()print(f"平均值: {avg}, 原始值: {readings}")5.2 多数据流处理

def multi_stream_processor(streams, process_func):"""多数据流处理器"""iterators = [iter(stream) for stream in streams]while True:try:items = [next(it) for it in iterators]yield process_func(items)except StopIteration:break# 使用示例

stream1 = (i for i in range(5)) # 生成器流

stream2 = (i*2 for i in range(5))processor = multi_stream_processor([stream1, stream2],lambda items: sum(items)

)print("多流处理结果:", list(processor)) # [0, 3, 6, 9, 12]六、机器学习应用

6.1 多模态学习

def multimodal_training(image_stream, text_stream, label_stream):"""多模态训练数据生成"""for image, text, label in zip(image_stream, text_stream, label_stream):# 多模态特征融合fused_features = fuse_features(image, text)yield fused_features, labeldef fuse_features(image, text):"""特征融合(示例)"""# 实际应用中会使用深度学习模型return f"图像特征:{image[:10]}... + 文本特征:{text[:10]}..."# 使用示例

images = ['image_data1', 'image_data2', 'image_data3']

texts = ['文本描述1', '文本描述2', '文本描述3']

labels = [0, 1, 0]print("多模态训练数据:")

for features, label in multimodal_training(images, texts, labels):print(f"特征: {features}, 标签: {label}")6.2 交叉验证生成器

def cross_validation_generator(X, y, folds=5):"""交叉验证生成器"""from sklearn.model_selection import KFoldkf = KFold(n_splits=folds)for train_index, test_index in kf.split(X):X_train, X_test = X[train_index], X[test_index]y_train, y_test = y[train_index], y[test_index]yield X_train, X_test, y_train, y_test# 使用示例

import numpy as np

X = np.array([[1, 2], [3, 4], [5, 6], [7, 8], [9, 10]])

y = np.array([0, 1, 0, 1, 0])print("交叉验证折叠:")

for fold, (X_train, X_test, y_train, y_test) in enumerate(cross_validation_generator(X, y)):print(f"折叠 {fold+1}:")print(f"训练集: {X_train}, 标签: {y_train}")print(f"测试集: {X_test}, 标签: {y_test}")七、高并发系统应用

7.1 多线程数据采集

import threading

from queue import Queuedef concurrent_data_collection(sources):"""多线程数据采集"""results = Queue()threads = []def worker(source, output):"""数据采集工作线程"""data = source.collect()output.put(data)for source in sources:t = threading.Thread(target=worker, args=(source, results))t.start()threads.append(t)# 等待所有线程完成for t in threads:t.join()# 返回结果return [results.get() for _ in sources]# 数据源模拟

class DataSource:def __init__(self, name):self.name = namedef collect(self):import timetime.sleep(1) # 模拟采集延迟return f"{self.name}数据"# 使用示例

sources = [DataSource(f"源{i+1}") for i in range(3)]

data = concurrent_data_collection(sources)

print("并发采集数据:", data)7.2 异步多序列处理

import asyncioasync def async_multi_iter(iterables, process_func):"""异步多序列迭代"""iterators = [iter(iterable) for iterable in iterables]while True:try:# 异步获取下一组数据tasks = [asyncio.to_thread(next, it) for it in iterators]results = await asyncio.gather(*tasks, return_exceptions=True)# 检查是否有迭代结束if any(isinstance(res, StopIteration) for res in results):break# 处理数据yield process_func(results)except StopIteration:break# 使用示例

async def main():streams = [[1, 2, 3, 4],['a', 'b', 'c', 'd'],[0.1, 0.2, 0.3, 0.4]]async for result in async_multi_iter(streams, lambda items: tuple(items)):print("异步结果:", result)asyncio.run(main())八、高效迭代技术

8.1 内存高效多序列迭代

def memory_efficient_zip(iterables):"""内存高效多序列迭代"""iterators = [iter(it) for it in iterables]while True:try:yield tuple(next(it) for it in iterators)except StopIteration:break# 使用示例

large_stream1 = (i for i in range(1000000))

large_stream2 = (i*2 for i in range(1000000))print("内存高效迭代:")

for i, (a, b) in enumerate(memory_efficient_zip([large_stream1, large_stream2])):if i >= 3: # 只显示前3个breakprint(a, b)8.2 分块多序列处理

def chunked_multi_process(iterables, process_func, chunk_size=1000):"""分块多序列处理"""iterators = [iter(it) for it in iterables]while True:chunk = []try:for _ in range(chunk_size):items = tuple(next(it) for it in iterators)chunk.append(items)except StopIteration:if not chunk:break# 处理整个块processed = process_func(chunk)yield from processed# 使用示例

def process_chunk(chunk):"""处理数据块(示例)"""return [sum(items) for items in chunk]stream1 = range(10000)

stream2 = range(10000, 20000)print("分块处理结果:")

results = chunked_multi_process([stream1, stream2], process_chunk, chunk_size=3)

for i, res in enumerate(results):if i >= 5: # 只显示前5个breakprint(res) # 0+10000=10000, 1+10001=10002, 2+10002=10004, ...九、最佳实践与错误处理

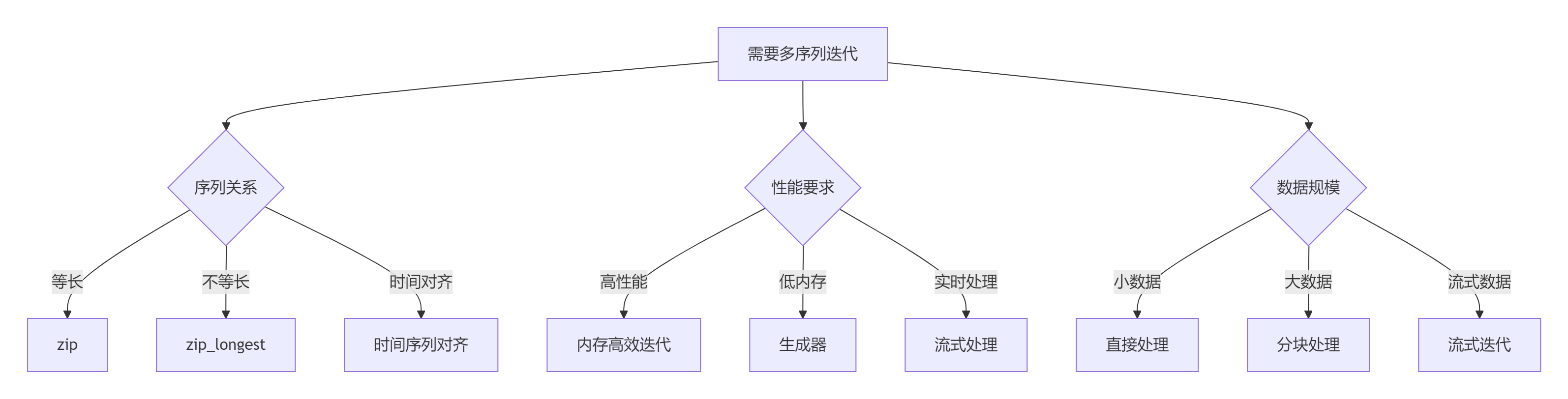

9.1 多序列迭代决策树

9.2 黄金实践原则

选择合适工具:

# 等长序列 for a, b in zip(seq1, seq2):process(a, b)# 不等长序列 for a, b in zip_longest(seq1, seq2, fillvalue=None):process(a, b)# 时间序列 for ts, (a, b) in align_time_series(seq1, seq2):process(ts, a, b)内存管理:

# 使用生成器避免内存问题 stream1 = (x for x in large_dataset1) stream2 = (x for x in large_dataset2) for a, b in zip(stream1, stream2):process(a, b)错误处理:

def safe_multi_iter(iterables):"""安全的多序列迭代"""iterators = [iter(it) for it in iterables]while True:try:items = []for it in iterators:items.append(next(it))yield tuple(items)except StopIteration:breakexcept Exception as e:print(f"迭代错误: {e}")# 处理错误或跳过continue性能优化:

# 避免不必要的转换 # 错误做法 for a, b in zip(list1, list2):...# 正确做法 for a, b in zip(iter1, iter2):...数据对齐:

def align_by_key(iterables, key_func):"""按键函数对齐序列"""# 创建索引映射index_map = {}for it in iterables:for item in it:key = key_func(item)if key not in index_map:index_map[key] = [None] * len(iterables)index_map[key][iterables.index(it)] = item# 生成对齐数据for key, items in index_map.items():if all(item is not None for item in items):yield items文档规范:

def multi_sequence_processor(sequences, process_func):"""多序列处理器参数:sequences: 序列列表process_func: 处理函数,接受每个序列的一个元素返回:处理结果的生成器注意:所有序列长度应相同,否则截断到最短序列"""for items in zip(*sequences):yield process_func(*items)

总结:多序列迭代技术全景

10.1 技术选型矩阵

场景 | 推荐方案 | 优势 | 注意事项 |

|---|---|---|---|

等长序列 | zip | 简单高效 | 序列需等长 |

不等长序列 | zip_longest | 处理不等长 | 需指定填充值 |

时间序列 | 时间对齐 | 精确匹配 | 时间处理复杂 |

大数据集 | 生成器zip | 内存高效 | 功能有限 |

实时流 | 流式迭代 | 低延迟 | 状态管理 |

并行处理 | 多线程/异步 | 高性能 | 复杂度高 |

10.2 核心原则总结

理解序列关系:

等长 vs 不等长

时间对齐 vs 索引对齐

独立序列 vs 关联序列

选择合适工具:

简单场景:zip

不等长:zip_longest

时间序列:自定义对齐

大数据:生成器

实时系统:流式处理

性能优化:

避免不必要的数据复制

使用生成器表达式

分块处理大数据

内存管理:

使用惰性求值

避免完整列表

分块处理

错误处理:

处理序列不等长

捕获迭代异常

提供默认值

应用场景:

数据清洗与合并

特征工程

时间序列分析

实时系统

机器学习

并行处理

多序列同时迭代是Python高效处理数据的核心技术。通过掌握从基础方法到高级应用的完整技术栈,结合领域知识和最佳实践,您将能够构建高效、灵活的数据处理系统。遵循本文的指导原则,将使您的多序列处理能力达到工程级水准。

最新技术动态请关注作者:Python×CATIA工业智造

版权声明:转载请保留原文链接及作者信息