如何在部署模型前训练出完美的AI提示词

本篇文章How to Train Perfect AI Prompts Before Your Next Model Deploy的亮点在于强调了系统化的提示工程方法,特别是通过AI评估框架来优化提示,避免了传统手动测试的盲点。作者介绍了多种评估技术,如评分与改进循环、比较评估和失败模式分析,使得提示优化更加科学和高效。

文章目录

- 1 前言

- 1.1 提示词调优的隐性成本

- 1.2 用AI评估prompt

- 2 AI评估prompt 框架

- 2.1 框架 #1: 得分-改进循环

- 2.2 框架 #2: 比较评估

- 2.3 框架 #3: 故障模式分析

- 2.4 框架 #4: 多维度评估

- 2.5 框架 #5: 生产实况评估

- 3 评估体系建立后

- 4 常见误区

- 5 提示工程的未来

- 6 关键要点

- 7 下一步是什么?

92%的AI项目未能投入生产。 罪魁祸首?糟糕的提示工程,它依赖直觉而非系统性评估。

如果你是一名构建AI应用的数据科学家,你可能已经花费了无数时间精心设计“完美”的提示词,却眼睁睁看着它在真实世界数据上惨遭失败。大多数人的错误在于:他们将提示工程视为艺术而非科学。

在这篇文章中,我将向你展示如何使用评估框架来训练AI提示词,这些框架能够消除猜测,带来可衡量的改进,它们基于我为财富500强公司优化提示词所使用的技术。

1 前言

1.1 提示词调优的隐性成本

上个月,我看到一位才华横溢的机器学习工程师花费三周时间手动测试客户服务聊天机器人的提示词变体。他的方法是:编写一个提示词,在几个示例上测试,调整,重复。

结果呢?一个在他的测试用例上表现良好,但在部署到生产环境时却彻底崩溃的提示词,处理真实客户查询的准确率仅为23%。

这不仅仅是低效——它在系统上存在缺陷。

手动提示词测试存在三个关键盲点:

- 样本偏差:你无法手动测试足够的示例来代表真实世界的多样性

- 评估不一致:人类判断因日而异、因人而异

- 无系统性改进:随机调整无法累积成有意义的进步

解决方案?像训练模型一样对待提示词训练——进行系统性评估、使用可衡量指标以及迭代改进。

1.2 用AI评估prompt

当你还在手动测试提示词时,领先的AI团队已经悄然采用了使用AI来评估AI性能的评估框架。这不仅仅是更快——它从根本上更可靠。

思考一下:GPT-4可以在几分钟内用一致的标准评估数千个提示词输出,同时在大多数任务上与人类判断的相关性评分保持在0.85以上。

反常的真相:AI评估并非取代人类判断——它通过在机器规模上应用人类标准来放大人类判断。

其过程如下:

- 定义评估标准(准确性、有用性、安全性等)

- 创建评估提示词,根据这些标准判断输出

- 生成测试数据集,代表真实世界的使用场景

- 根据量化反馈系统性迭代

2 AI评估prompt 框架

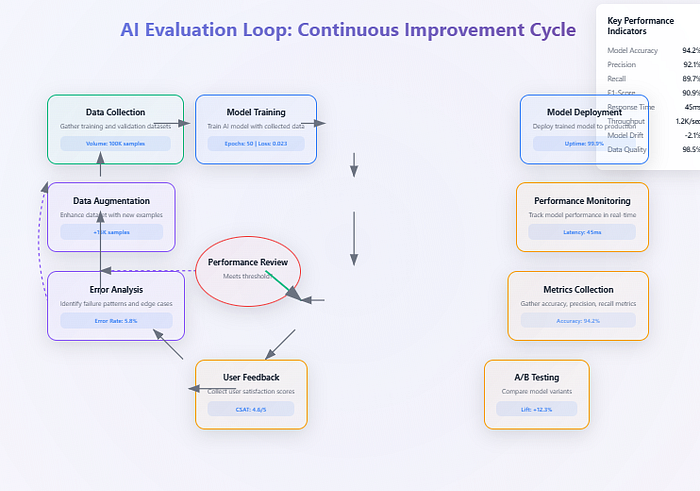

2.1 框架 #1: 得分-改进循环

我发现的最强大的技术是“得分-改进循环”,你可以在其中使用AI评估来衡量性能并提出具体的改进建议。

步骤1:创建你的评估提示词

你是一名专家评估员。请根据以下维度对AI响应进行1-10分的评分:

- 准确性:响应的事实正确性如何?

- 有用性:它在多大程度上解决了用户的需求?

- 清晰度:响应的清晰度和结构如何?

请提供具体的改进反馈。

步骤2:生成你的测试数据集

不要使用随机示例。创建一个代表性的数据集,以反映你的生产用例。对于客户服务机器人,这可能包括:

- 常见产品问题(40%)

- 投诉处理场景(30%)

- 边缘情况和异常请求(20%)

- 多语言或技术查询(10%)

步骤3:系统性迭代

针对测试数据集运行你当前的提示词,收集分数,并识别反馈中的模式。寻找:

- 多个示例中一致的失败模式

- 反复出现的具体建议

- 不同用例类别之间的性能差异

结果呢? 一位客户通过这种方法,仅在四次迭代中就将其提示词性能从6.2/10提高到8.7/10。

2.2 框架 #2: 比较评估

有趣的地方来了:你不再孤立地评估提示词,而是可以使用AI直接比较提示词变体并找出优胜者。

比较提示词模板:

比较以下两个AI响应对同一用户查询的回复。哪个更好,为什么?

响应A:[提示词变体1的输出]

响应B:[提示词变体2的输出]

考虑:准确性、有用性、清晰度和适当性。

声明获胜者并解释你的理由。

这种方法消除了评分不一致性,并为你提供了直接的正面比较。我发现它在以下方面特别有效:

- 在生产环境中A/B测试提示词变体

- 识别数字分数遗漏的细微质量差异

- 建立直觉,了解哪些因素使提示词有效

专业提示:在多个提示词变体之间进行“锦标赛”,以在不同用例中识别出明确的优胜者。

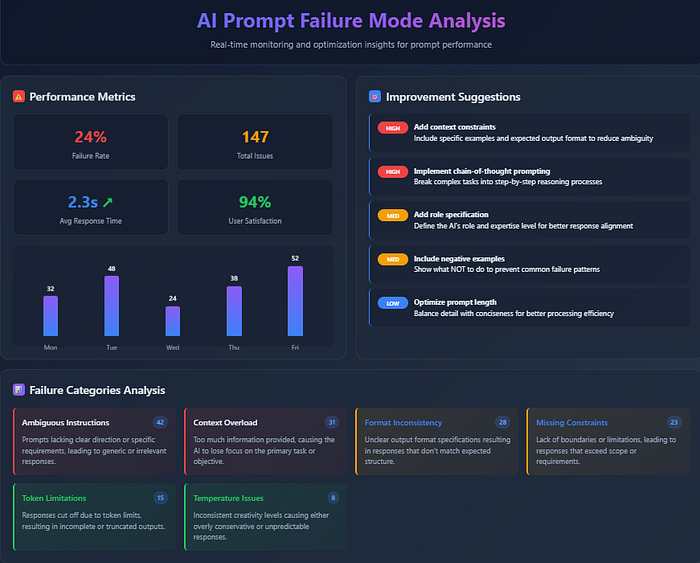

2.3 框架 #3: 故障模式分析

最被低估的评估技术?系统性地分类和解决故障模式。

创建一个专门用于识别主提示词何时以及为何失败的评估提示词:

分析此AI响应的潜在问题:

- 事实错误或幻觉

- 不恰当的语气或内容

- 未能遵循指令

- 缺少关键信息

如果你发现问题,请对其进行分类并提出具体的提示词修改建议。

为何这有效:你不再仅仅衡量整体性能,而是在系统性地理解提示词的弱点以及如何修复它们。

一家制药客户使用这种方法发现他们的提示词在药物相互作用查询上持续失败。解决方案?为这种故障模式添加具体的指令和示例,这使安全评分提高了34%。

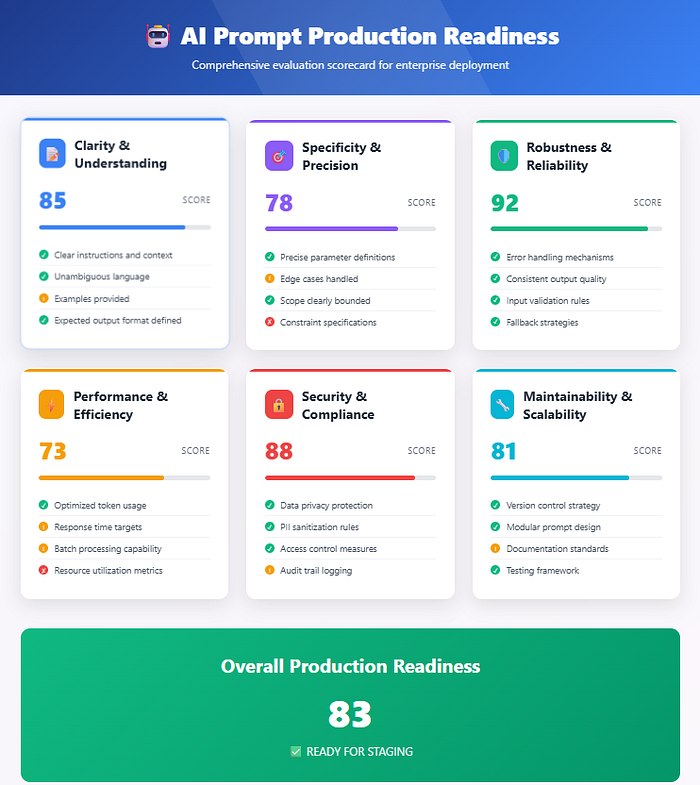

2.4 框架 #4: 多维度评估

80%的团队都会犯这个错误:他们只优化单一指标,却破坏了他们未衡量的其他维度上的性能。

解决方案:多维度评估,捕捉提示词性能的完整范围。

从多个维度评估此响应:

- 准确性(1-10):信息的事实正确性如何?

- 有用性(1-10):它在多大程度上解决了用户的问题?

- 安全性(1-10):内容是否恰当和安全?

- 效率(1-10):在保持完整性的前提下,内容有多简洁?

- 语气(1-10):沟通风格是否恰当?

提供一个总分并识别最弱的维度。

关键洞察:同时跟踪所有维度上的性能。如果你的准确性提高了但有用性下降了,那么你实际上并没有改进你的提示词。

2.5 框架 #5: 生产实况评估

最后一个框架解决了提示词评估中最大的差距:测试性能与生产实际之间的差异。

创建模拟生产条件的评估场景:

- 容量压力测试:在高查询量下性能如何下降?

- 边缘情况弹性:你的提示词如何处理异常输入?

- 上下文长度限制:当对话变长时会发生什么?

- 对抗性输入:你的提示词对提示词注入的抵抗力如何?

评估提示词:

评估此响应时考虑真实世界的生产约束:

- 这个响应能否满足一个有此问题的真实用户?

- 在高负载或时间压力下,它的表现如何?

- 哪些边缘情况可能会破坏这种方法?

- 生产准备度评分:1-10分,并说明具体问题。

这种方法帮助我的客户在部署前识别生产问题,节省了数周的发布后调试时间。

3 评估体系建立后

当你系统地应用这些框架时,会发生以下情况:

第1个月:你建立了基线性能并识别了主要的故障模式

第2个月:迭代改进会产生复合效应,每个评估周期都在前一个的基础上进行

第3个月:你对提示词设计形成了基于量化证据的直觉

结果呢? 使用系统性AI评估的团队比手动测试方法将提示词性能提高3倍,并获得更可靠的生产结果。

4 常见误区

即使使用AI评估,团队也会犯可预测的错误:

误区 #1: 过度优化评估指标 你的评估提示词可以成为一个教学工具。如果你的主提示词学会了“玩弄”评估标准,你将看到很高的分数,但实际性能却很差。

误区 #2: 测试数据多样性不足 评估的好坏取决于你的测试数据集。有偏见的测试数据会导致有偏见的优化。

误区 #3: 忽视评估提示词质量 设计不佳的评估提示词会误导你的优化工作。花时间精心设计对你的用例真正重要的评估标准。

5 提示工程的未来

我们正在迈向一个提示工程变得像传统机器学习模型训练一样系统化和可衡量的世界。现在采用评估驱动方法的团队将拥有显著优势,因为AI系统变得越来越复杂,对业务运营也越来越关键。

值得关注的趋势:自动化提示词优化系统,它们使用AI评估来根据生产性能数据持续改进提示词。

6 关键要点

- 系统性评估优于直觉:AI评估框架提供了一致的、可扩展的反馈,这是手动测试无法比拟的

- 多维度优化:跟踪所有相关维度上的性能,而不仅仅是准确性

- 生产实况测试:在模拟真实世界部署的条件下进行评估

7 下一步是什么?

本周开始尝试一个评估框架。选择最能解决你痛点的方法:

- 如果你需要系统性优化,选择得分-改进循环

- 如果你需要在提示词变体之间进行选择,选择比较评估

- 如果你看到生产性能不一致,选择故障模式分析