【AI论文】单一领域能否助力其他领域?一项基于数据的、通过强化学习实现多领域推理的研究

摘要:具备可验证奖励的强化学习(RLVR,Reinforcement Learning with Verifiable Rewards)已成为增强大语言模型(LLMs)推理能力的强大范式。现有研究主要聚焦于数学解题、代码编写或逻辑推理等单一推理领域。然而,现实世界的推理场景本质上需要综合运用多种认知技能。尽管如此,强化学习框架下这些推理技能之间的相互作用机制仍鲜有深入探讨。为填补这一空白,本研究在RLVR框架内对多领域推理展开系统性探索,重点聚焦数学推理、代码生成和逻辑谜题求解三大核心领域。研究通过四大关键模块展开全面分析:(1)基于GRPO算法与Qwen-2.5-7B模型族,系统评估模型在单一领域数据集训练下的领域内性能提升及跨领域泛化能力;(2)深入剖析跨领域联合训练中出现的技能协同增强与冲突等复杂交互现象;(3)为探究监督微调(SFT)对强化学习的影响,在相同RL配置下对比基础模型与指令微调模型的性能差异;(4)深入探究强化学习训练的关键细节,系统分析课程学习策略、奖励设计差异及语言特性等要素的影响机制。通过大规模实验,研究揭示了领域间动态交互的核心规律,阐明了影响专业推理性能与泛化推理能力的关键因素。这些发现为优化强化学习方法提供了重要指导,有助于在大语言模型中培育全面、跨领域的综合推理能力。Huggingface链接:Paper page,论文链接:2507.17512

研究背景和目的

研究背景:

随着大型语言模型(LLMs)在自然语言处理领域的广泛应用,如何提升其推理能力成为关键问题。传统的监督微调(SFT)方法虽然有效,但依赖于大量标注数据,且在面对复杂推理任务时仍显不足。近年来,具备可验证奖励的强化学习(RLVR,Reinforcement Learning with Verifiable Rewards)作为一种新兴范式,展示了通过非监督方式显著提升LLMs推理能力的潜力。RLVR通过设计奖励机制,使模型在自我探索中优化推理策略,从而摆脱对大规模标注数据的依赖。

然而,现有RLVR研究主要集中于单一推理领域,如数学解题、代码生成或逻辑推理,忽略了现实世界推理任务往往需要综合运用多种认知技能的特性。这种孤立的训练方式限制了模型在处理跨领域复杂任务时的表现。因此,理解不同推理技能在强化学习框架下的相互作用机制,探索多领域推理的协同优化策略,成为提升LLMs综合推理能力的关键。

研究目的:

本研究旨在填补这一研究空白,通过系统性探索多领域推理在RLVR框架下的表现,揭示不同推理技能之间的相互作用机制,为优化强化学习方法、提升LLMs的综合推理能力提供理论指导和实践参考。具体目标包括:

- 评估单一领域数据集训练对模型在领域内及跨领域任务上的性能影响。

- 揭示跨领域联合训练中不同推理技能之间的协同增强与冲突现象。

- 分析监督微调(SFT)对强化学习效果的影响,对比基础模型与指令微调模型在相同RL配置下的性能差异。

- 探究课程学习策略、奖励设计差异及语言特性等关键因素对强化学习训练的影响。

研究方法

1. 数据集构建:

本研究选取了数学推理、代码生成和逻辑谜题求解三大核心领域,分别构建了领域特定的数据集:

- 数学推理:使用DeepScaleR(DSR)和CountDown(CD)数据集,涵盖代数、几何、数论等多种数学问题。

- 代码生成:采用CodeR1-12k数据集,包含LeetCode可靠数据和TACO验证数据,覆盖算法实现、数据结构操作等编程任务。

- 逻辑谜题求解:聚焦Knights-and-Knaves(KK)和Logic Puzzle Baron(LPB)两类谜题,考察模型的逻辑推理和模式识别能力。

2. 模型选择与训练:

- 模型架构:选用Qwen2.5-7B-Base和Qwen2.5-7B-Instruct作为基础模型,分别代表基础版本和经过指令微调的版本。

- 强化学习算法:采用Group Relative Policy Optimization(GRPO)算法,通过评估不同响应之间的质量差异来优化策略,避免了对价值模型的依赖。

- 训练配置:在8×A100 GPU集群上进行训练,使用veRL框架实现强化学习流程。训练过程中,通过调整最大令牌数、批次大小、学习率等超参数,优化模型性能。

3. 评估方法:

- 领域内评估:使用MATH500、AIME24、CountDown等数学基准测试,HumanEval和MBPP等代码生成基准测试,以及KK和ZebraLogicBench等逻辑谜题基准测试,评估模型在各自领域内的性能。

- 跨领域评估:通过组合不同领域的数据集进行联合训练,评估模型在跨领域任务上的泛化能力。

- 模板一致性评估:考察训练模板与测试模板的一致性对模型性能的影响,确保评估结果的可靠性。

研究结果

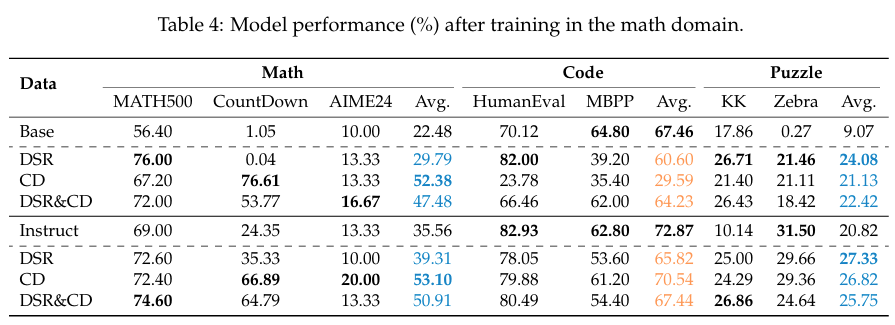

1. 单一领域训练效果:

- 数学推理:RLVR显著提升了模型在数学任务上的表现,如Base-DSR模型在MATH500上的准确率提升了19.60%。然而,数学训练对代码生成任务产生负面影响,表明不同推理技能之间存在竞争关系。

- 代码生成:代码数据训练有效提升了模型在代码生成任务上的性能,如Base-CodeR1模型在HumanEval上的准确率提升了10.37%。同时,指令微调模型在跨领域任务上表现出更强的泛化能力。

- 逻辑谜题求解:逻辑谜题训练显著提升了模型在逻辑推理任务上的表现,如Base-KK模型在KK测试集上的准确率达到94.29%。此外,逻辑谜题训练还促进了模型在数学任务上的表现,表明逻辑推理与数学能力之间存在协同增强效应。

2. 跨领域联合训练效果:

- 双领域组合:数学与逻辑谜题联合训练显著提升了模型在数学和逻辑推理任务上的表现,如Math+Puzzle组合在数学任务上的准确率达到49.72%。然而,代码与逻辑谜题联合训练对代码生成任务产生负面影响,表明不同领域之间的交互作用复杂多样。

- 三领域组合:数学、代码和逻辑谜题三领域联合训练进一步提升了模型的整体性能,平均准确率达到56.57%。尽管逻辑谜题任务上的表现有所下降,但模型在数学和代码生成任务上保持了稳定表现,表明三领域联合训练有助于提升模型的跨领域泛化能力。

3. 关键因素分析:

- 监督微调(SFT)的影响:SFT显著提升了强化学习效果,指令微调模型在跨领域任务上表现出更强的泛化能力。这表明SFT有助于模型更好地理解任务指令,从而在强化学习过程中优化推理策略。

- 奖励设计:奖励设计需根据任务复杂度进行调整。简单任务适合二元奖励,复杂任务适合比例奖励。实验表明,针对逻辑谜题任务设计比例奖励和格式奖励,可显著提升模型性能。

- 语言特性:中文训练数据下的模型性能显著低于英文模型,表明RLVR框架在处理跨语言推理任务时存在局限性,需进一步优化跨语言泛化能力。

研究局限

- 数据多样性有限:尽管本研究选取了数学、代码和逻辑谜题三大领域的数据集,但仍可能无法全面覆盖所有可能的推理场景,未来研究需进一步扩展数据集多样性。

- 语言限制:当前研究主要关注中英文数据集,未来需探索更多语言的数据集对模型性能的影响。

- 硬件限制:受限于硬件资源,本研究主要基于Qwen2.5-7B模型进行,未来研究可探索更大规模的模型和更复杂的数据集。

未来研究方向

1. 扩展数据集多样性:

- 增加数据集多样性:未来研究应扩展数据集多样性,纳入科学推理、常识推理等更多领域的数据集,以更全面评估模型在各种推理任务上的表现。

- 跨领域数据融合:探索如何将不同领域的数据集进行更有效的融合,以提升模型在处理跨领域任务时的表现。

2. 跨语言推理能力:

- 多语言训练:研究模型在不同语言数据上的表现,为跨语言推理任务提供理论支持。

3. 增强跨语言推理:通过多语言数据集训练,提升模型处理不同语言推理任务的能力,满足全球化应用需求。

3. 提升低资源语言处理:针对低资源语言训练,研究如何利用无监督预训练或迁移学习等方法,降低对标注数据的依赖,提升模型在低资源场景下的推理效率和准确性。

4. 优化奖励设计:

- 精细化奖励设计:根据不同任务特性设计更精细的奖励机制,如考虑任务难度、用户偏好或领域特性,优化奖励信号以更准确反映任务完成质量。

5. 探索新型强化学习方法:

- 结合领域知识特性:利用领域知识(如数学公式、代码结构)设计更符合领域特性的强化学习算法,提升跨领域推理效率。

- 强化模型在多语言环境下的适应性和稳定性**:通过设计领域特定的优化策略,使模型更好地适应不同语言的推理任务,如考虑语言模型、语法结构对奖励信号的影响,提升跨语言推理的准确性和稳定性。

7. 利用领域知识增强推理:结合数学、代码和逻辑谜题等领域的专业知识,设计更精确的奖励机制,使奖励信号与领域知识紧密结合,提升模型在处理跨领域任务时的专业性和泛化能力。

8. 可解释性:针对不同领域设计差异,制定差异化的奖励机制,如根据任务复杂度调整奖励权重,确保奖励信号与任务完成质量正相关,如对数学任务设计基于问题正确率的比例奖励,对代码任务采用准确率作为奖励信号。

9. 引入反馈机制:对模型在处理跨领域任务时的反馈信号进行实时调整,如根据模型在处理逻辑谜题时的实时反馈调整奖励信号,确保奖励与任务完成质量正相关。

10. 提升泛化能力:通过设计更精细化的奖励机制,提升模型在处理未见过的任务时的泛化能力和适应能力,

实践意义与价值

1. 提升跨领域协同:通过多领域数据集训练,促进不同领域模型间的知识表示和技能协同提升,如数学推理与代码生成任务可共享领域知识,提升整体推理效率。

2. 推动模型优化:结合领域知识设计、迁移学习策略、奖励机制调整等方法,持续优化模型在处理不同领域任务时的表现,确保模型在多领域应用中的稳定性和高效性。

总结与展望:

本研究通过系统性探索多领域推理在RLVR框架下的表现,揭示了领域间协同增强与冲突现象,指出奖励设计需匹配任务复杂度,同时强调了SFT对RL效果的提升,以及未来研究可进一步探索更多领域的协同推理策略、知识融合机制,以及更精细化的奖励设计。