【机器学习深度学习】微调量化与模型导出量化:区分与应用

目录

前言

一、微调量化:训练中的精雕细琢

1.1 核心原理

QLoRA未优化推理计算

1.2 核心优势

1.3 适用场景

二、导出量化:部署前的轻装上阵

2.1 核心原理

2.2 核心目标与权衡

2.3 适用场景

三、核心差异对比表

四、如何选择:最佳实践建议

五、微调量化与量化导出的比较

结语

前言

在大型语言模型(LLM)应用落地的征途上,“量化”技术扮演着至关重要的角色。它如同一位技艺高超的裁缝,为臃肿的模型“量体裁衣”,使其能在资源受限的环境中高效运行。但在不同阶段进行的量化——微调量化与导出量化——其目标、原理和效果却大相径庭。理解它们的差异,是优化模型性能的关键。

一、微调量化:训练中的精雕细琢

1.1 核心原理

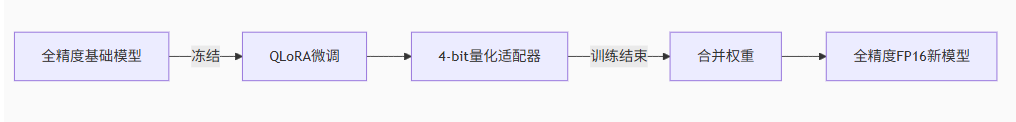

微调量化(如QLoRA技术)发生在模型仍在训练或微调过程中。它将模型权重(通常是部分,如LoRA适配器)转换为低精度格式(如4-bit)。关键在于:这些量化后的参数并未“冻结”,而是继续参与梯度计算和优化更新。

-

QLoRA仅在训练阶段将基础模型权重转化为4-bit(可逆操作),但:

-

最终产出物是FP16模型:微调完成后,需将LoRA适配器权重解量化并合并回基础模型,生成完整的FP16微调模型。

-

此时模型体积/计算需求与原始基础模型相同——部署成本未降低。

【说明】

QLoRA未优化推理计算

QLoRA的4-bit量化仅用于降低训练显存,推理时仍需加载合并后的FP16大模型。

未激活硬件加速:GPU/NPU对INT8/FP16有专用指令集(如Tensor Core),4-bit需要特殊运行时支持。

✅ 结论:QLoRA解决了训练成本问题,但未解决部署成本问题。

1.2 核心优势

-

精度损失最小化:量化本身会引入误差(信息损失),但由于参数在训练中动态调整,模型能够“学习”去补偿这些量化带来的精度损失。

-

资源效率高:在训练/微调阶段使用量化(尤其是4-bit),能显著降低GPU显存消耗,使得在消费级显卡上微调大模型成为可能。

-

保持模型潜力:模型保留了适应和学习能力,最终的精度潜力接近全精度微调。

1.3 适用场景

需要高精度的应用:对于对精度要求较高的应用,微调量化是一个理想的选择。它能够在降低计算需求的同时,最大程度地保留模型性能。

动态场景:当模型需要在训练过程中动态调整和适应量化时,微调量化尤为有效。

当你需要在有限的计算资源(如单张24GB显存的消费级显卡)上对大型基础模型(如LLaMA 3, Mistral)进行特定任务(如客服问答、代码生成)的微调时,QLoRA等微调量化技术是首选方案。

1.4 形象比喻

想象一位运动员在减肥塑身的过程中(训练),穿着较轻便的装备(量化)进行训练。装备虽轻,但运动员能根据其特性调整动作和发力(动态学习补偿),最终体能和技巧(模型精度)几乎不受影响,甚至更适应轻装比赛。

二、导出量化:部署前的轻装上阵

2.1 核心原理

导出量化发生在模型训练/微调彻底完成、评估验证通过之后,是为了模型部署上线而进行的步骤。它将模型的权重(和有时激活值)永久性地转换为低精度格式(如INT8, FP16, 4-bit, GGUF等)。

2.2 核心目标与权衡

-

极致压缩:大幅减小模型文件体积(从数十GB压缩到几个GB甚至更小)。

-

加速推理:低精度运算(如INT8)通常能被硬件(CPU/GPU/NPU)更快地执行,显著提升推理速度。

-

降低资源需求:压缩后的模型能在内存更小、算力更弱的边缘设备(如手机、嵌入式设备)或更便宜的云实例上运行。

-

精度损失是必然代价:这种量化是静态的、不可逆的。模型参数被“冻结”在低精度状态,无法再通过训练学习来补偿量化误差,必然带来一定的精度下降。

2.3 适用场景

推理加速:当目标是尽可能提高推理速度并减少存储空间时,导出量化是一种理想选择,尤其适用于推理任务而非训练任务。

已经完成训练的模型:对于已经训练完成且精度足够的模型,导出量化能够有效减少推理时的计算负担。

当你的模型已经完成训练和测试,需要发布、部署到生产环境、集成到应用程序或在资源受限的设备上运行时,导出量化是必要的步骤。选择何种精度(INT8, FP16, 4-bit等)需要在速度、体积和精度之间做具体权衡。

2.4 形象比喻

运动员在登上正式赛场前(部署),为了跑得更快、负担更轻,脱掉所有不必要的负重,换上最轻便的比赛服(导出量化)。这身衣服是固定的,无法再调整(参数冻结)。虽然轻便利于发挥速度(推理性能),但可能不如训练服舒适(精度下降),且无法在比赛中更换(无法学习补偿)。

三、核心差异对比表

| 特性 | 微调量化 (如QLoRA) | 导出量化 |

|---|---|---|

| 发生时机 | 训练/微调过程中 | 训练完成、部署之前 |

| 参数状态 | 动态变化(参与训练更新) | 静态冻结(不再更新) |

| 主要目的 | 降低训练资源消耗 | 优化部署性能/体积/成本 |

| 精度影响 | 极小(模型可学习补偿) | 必然损失(需权衡取舍) |

| 核心价值 | 让大模型微调平民化 | 让大模型部署实用化 |

| 典型技术 | QLoRA (4-bit), ... | GGUF, AWQ, GPTQ, Torch FP16/INT8... |

四、如何选择:最佳实践建议

-

训练/微调阶段:

-

资源紧张? 毫不犹豫地选择 QLoRA (4-bit) 等微调量化技术。它是在有限资源下撬动大模型潜力的利器,精度损失可控。

-

资源充足?全精度微调仍是基准。

-

-

部署阶段:

-

必须进行导出量化! 原始的大模型文件(如FP16/FP32)通常体积巨大、推理慢、成本高,不适合生产。

-

精度优先? 考虑FP16或较高质量的INT8/AWQ/GPTQ量化。

-

速度/体积/边缘部署优先? 4-bit量化(如GGML/GGUF格式)是强大选择。务必在测试集上验证量化后的精度是否满足要求!

-

【为什么说导出量化通常是必要的?】

资源限制是现实: 绝大多数实际部署环境(手机、网页端、嵌入式设备、成本敏感的云服务)根本无法承载原始FP16/FP32大模型的体积(数十GB)和计算需求(高显存、高算力)。不进行任何量化,模型根本无法部署或成本极高。

性能需求是刚需: 用户无法忍受缓慢的响应速度。导出量化(即使是INT8)通常能带来显著的推理加速。

因此,在追求模型落地应用(而非纯研究)时,某种程度的导出量化几乎是不可避免的。

【什么情况下不推荐使用导出量化?】

针对激进量化(尤其是4-bit及以下): 这类量化会引入较大的信息损失,对模型能力(特别是复杂推理、知识召回、长上下文理解、低资源语言处理等)的破坏风险显著增高。在精度要求极高的场景下,直接对全精度模型进行激进的4-bit导出量化确实“一般不推荐”。

缺乏量化感知训练/校准: 如果模型在训练/微调阶段完全没有考虑过量化(即没有使用量化感知训练QAT或进行充分的校准),直接进行后训练量化(PTQ),精度损失可能难以预测和控制。

任务敏感度高: 某些任务(如需要高数值精度的科学计算、细微语义差别的判断、安全关键决策)对量化误差容忍度极低。

在这些情况下,“不推荐”的是不经充分评估和选择的、尤其是激进的导出量化方案。

五、微调量化与量化导出的比较

| 特性 | 微调量化(QAT) | 量化导出(PTQ) |

|---|---|---|

| 操作时机 | 在训练过程中进行,量化操作动态参与训练 | 在训练完成后,对已训练模型进行量化 |

| 精度影响 | 精度损失较小,因为量化过程中模型会通过训练弥补损失 | 精度可能会下降,因为量化后不会通过训练进行补偿 |

| 推理性能 | 推理性能提升有限,更多关注模型精度 | 推理性能显著提升,尤其是计算量和存储需求减少 |

| 适用场景 | 精度要求较高的应用,训练中需要动态适应量化 | 推理加速,特别是需要快速部署和减少内存占用的场景 |

| 内存和计算优化 | 通过量化后的精度和计算需求进行动态调整 | 通过量化压缩模型体积,优化内存使用和计算效率 |

| 硬件支持 | 适用于支持动态量化计算的硬件(如某些GPU、TPU等) | 适用于支持低精度推理(如8位整数计算)的硬件 |

| 精度与推理速度的平衡 | 保证精度的同时,优化推理速度,适合精度优先的场景 | 在可接受的精度损失范围内,优化推理速度和体积,适合速度优先的场景 |

| 适用设备 | 高性能计算环境,精度要求较高的应用 | 边缘设备、嵌入式设备、推理加速需求较高的场景 |

| 部署复杂度 | 需要重新训练和调整,部署较为复杂 | 一旦训练完成,量化导出更适合快速部署和使用 |

| 不可逆性 | 训练中的量化可以进行灵活调整 | 导出量化是不可逆的,一旦量化可能无法恢复精度 |

-

微调量化(QAT):适合精度要求较高、需要动态适应量化的场景,能在训练过程中通过学习来减少量化带来的精度损失。如果推理速度和计算需求已经满足,可以不做导出量化。

-

量化导出(PTQ):适合对推理速度和模型体积要求较高的应用,尤其是对于边缘设备和内存有限的环境。导出量化能够显著提高推理速度和减少内存占用,但可能牺牲一定的精度。

结语

微调量化与导出量化,是LLM生命周期中不同阶段的“瘦身术”。前者是训练时的智慧妥协,让大模型在有限资源下也能“学有所成”;后者是部署前的必要精简,让模型能以高效、经济的姿态服务用户。理解两者本质区别——参数是否动态学习——是驾驭量化技术、最大化模型价值的关键。在资源受限的世界里,善用量化,方能释放大模型的真正潜力。