【AGI使用教程】GPT-OSS 本地部署(2)

欢迎关注【AGI使用教程】 专栏

【AGI使用教程】GPT-OSS 本地部署(1)

【AGI使用教程】GPT-OSS 本地部署(2)

【AGI使用教程】GPT-OSS 本地部署(2)基于 WebUI 使用 GPT-OSS

- 1. 安装Docker

- 2. 安装WebUI

- 3. 使用GPT-OSS模型

- 4. 模型管理与联网搜索

- 4.1 模型管理

- 4.2 联网搜索

2025年8月5日,OpenAI 正式发布了 开源 GPT 服务框架:GPT-OSS-120B 和 GPT-OSS-20B。

GPT-OSS 支持主流开源大模型(如 Llama、Qwen、Mistral、Gemma 等),兼容 OpenAI API 标准,具备高性能推理、插件扩展、模型管理、权限控制等能力,适用于智能问答、内容生成、RAG、Agent、企业知识库等多种场景。

本节继续介绍:基于 WebUI 使用 GPT-OSS

Open WebUI 是一款可扩展、功能丰富、用户友好的大语言模型(LLM)交互界面,支持本地部署与离线运行。它支持各种LLM运行程序,包括 Ollama 和 OpenAI 兼容的 API,提供了 web 的方式来访问 Ollama API。

本教程将指导您使用 Docker 安装Open WebUI,并将其与Ollama的GPT-OSS模型集成。这种方法可以简化部署过程,并确保环境的一致性。

1. 安装Docker

Docker是一种虚拟化容器技术。Docker基于镜像,可以秒级启动各种容器。每一种容器都是一个完整的运行环境,容器之间互相隔离。注意Docker Desktop要求Windows 10 Pro或企业版,并且需要启用Hyper-V。

- 检查安装环境。检查Windows系统是否开启虚拟化。

(1)打开任务管理器(Ctrl+Alt+Del),选择:“性能-CPU-虚拟化”,确认 “虚拟化” 已启用。

(2)如果未开启虚拟化,则要开机重启并进入BIOS 设置:选择Advanced(高级)-CPU Configuration-Secure Virtual Machine,设置为:Enabled(启用)。

(3)在 “控制面板” 打开 “程序”,然后点击 “启用或关闭Windows功能”,勾选 “Hyper-V 管理工具” 和 “Hyper-V 平台”。

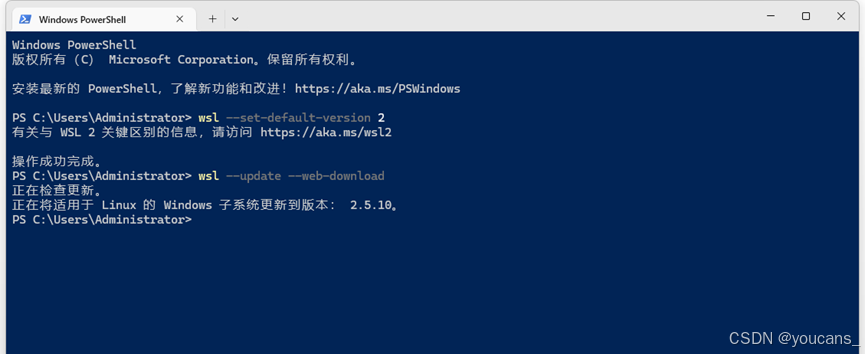

(4)以管理员身份打开命令行窗口,输入 “wsl --set-default-version 2”,将默认设置为 WSL 2。

(5)在命令行窗口输入"wsl --update --web-download",更新安装 wsl。

通过适用于Linux的Windows子系统 (WSL),开发人员可以安装Linux发行版,并直接在Windows上使用Linux应用程序、实用程序和 Bash 命令行工具。

- 安装 Docker for Desktop。

Docker Desktop 是 Docker 官方提供的桌面应用程序。

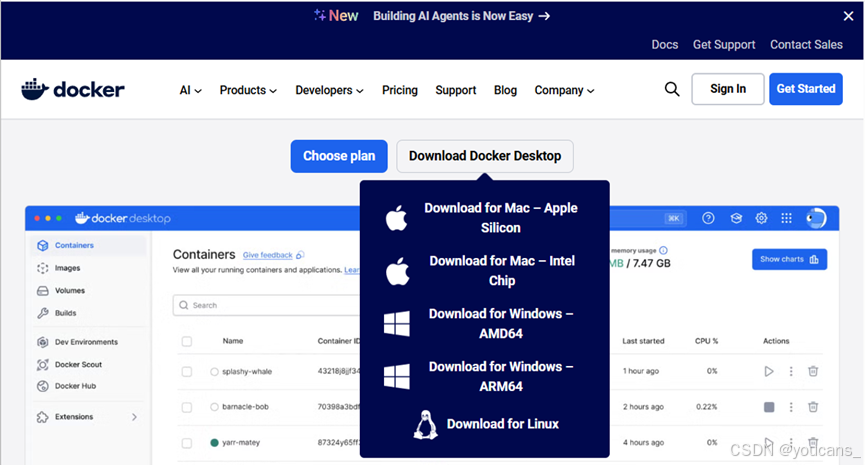

(1)下载Docker Desktop。访问Docker官网(https://www.docker.com/),下载 Docker Desktop for Windows安装程序。

(2)安装Docker Desktop。以管理员身份运行下载的Docker Desktop安装包,安装程序会引导用户完成安装过程。

(3)创建Docker Hub账号。访问Docker官网,点击右上角的"Sign Up"按钮,进入注册页面注册Docker Hub账号。

(4)登录Docker Hub账号。访问Docker官网并登录。

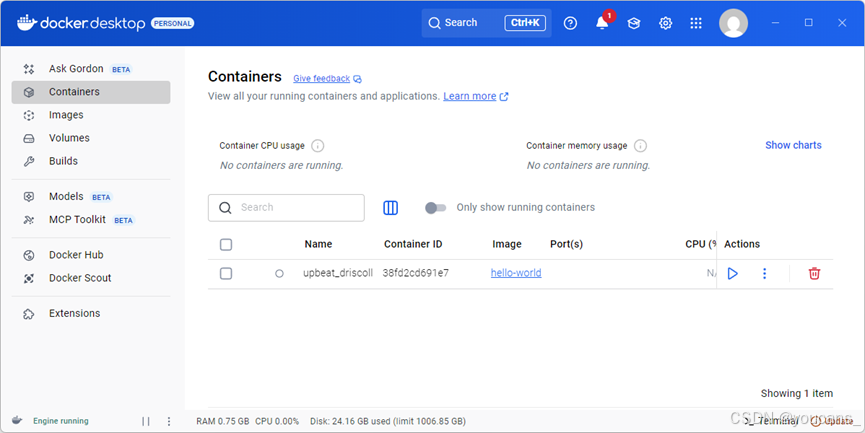

(5)安装完成后,启动Docker Desktop,检查右下角托盘图标状态为"Docker Desktop running",表明安装成功。

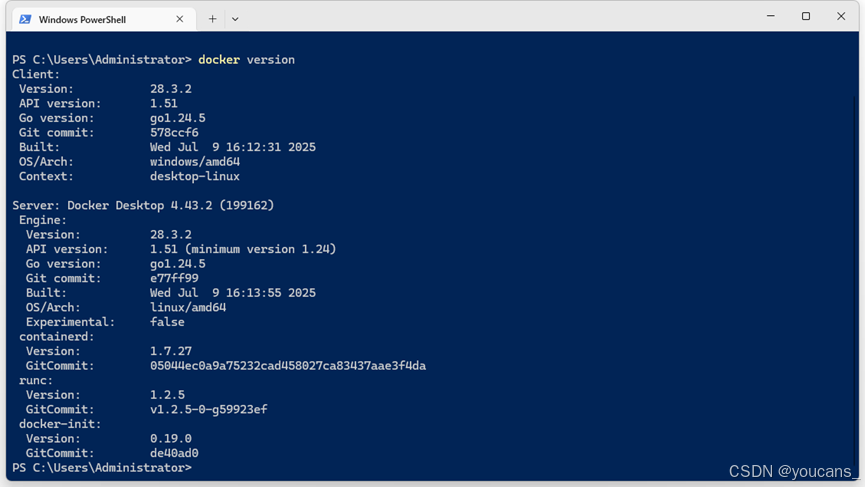

(6)打开命令行窗口,输入" docker version "检查,显示docker的版本号,

- 配置国内镜像源。

在命令行运行 “docker run hello-world”,可能出现报错:" docker: Error response from daemon. (Client. Timeout exceeded while awaiting headers). "。这是Docker守护进程在尝试连接到 Docker Hub(registry-1.docker.io)时,发生连接超时,即访问镜像源失败。配置国内的镜像源或者相关加速可以解决这个问题。

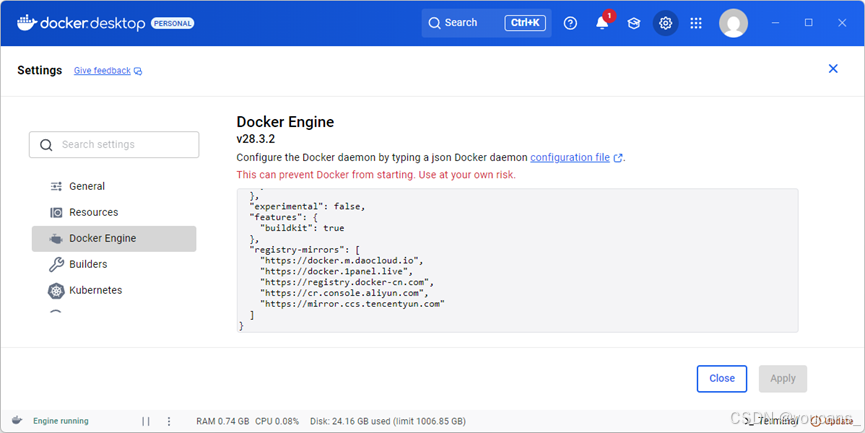

(1)进入Docker Desktop,选择 “Settings-Docker Engine”,将镜像源替换如下。

{"builder": {"gc": {"defaultKeepStorage": "20GB","enabled": true}},"experimental": false,"features": {"buildkit": true},"registry-mirrors": ["https://docker.m.daocloud.io","https://docker.1panel.live","https://registry.docker-cn.com","https://cr.console.aliyun.com","https://mirror.ccs.tencentyun.com"]

}

(2)点击 “Apply” 按钮,然后重启Docker Desktop,等待Engine Starting后就完成镜像源替换。

(3)再次运行 “docker run hello-world”,就可以成功拉取hello-world镜像。

2. 安装WebUI

Open WebUI 支持本地部署与离线运行大语言模型,提供了web方式来访问 Ollama API。

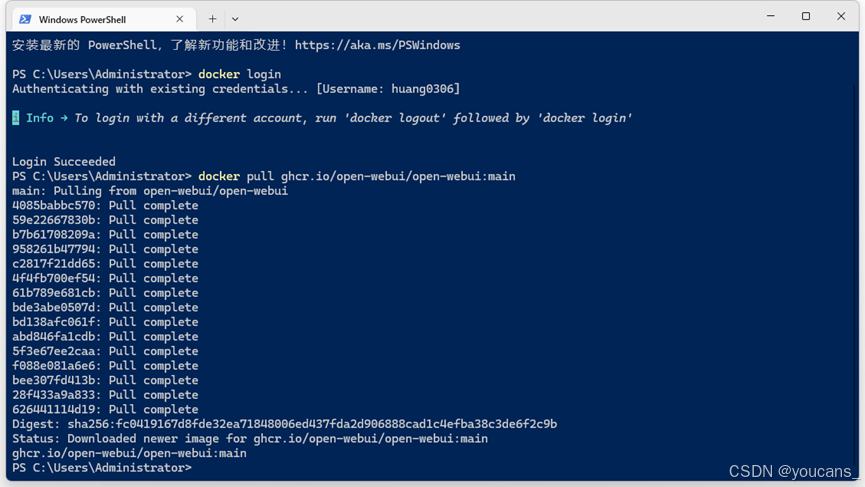

- 从GitHub仓库拉取Open WebUI Docker镜像。

docker pull ghcr.io/open-webui/open-webui:main

- 使用默认设置运行容器 docker。

(1)使用CPU(不支持GPU)。

docker run -d -p 3000:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

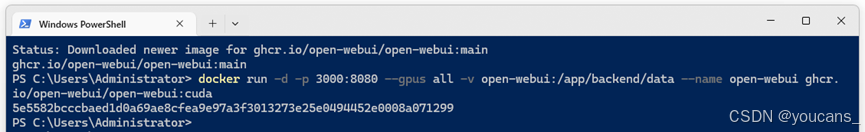

(2)若要支持 Nvidia GPU,请在 “docker run” 命令中添加 “–gpus all”。

docker run -d -p 3000:8080 --gpus all -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:cuda

(3)若要跳过登录页面,使用单用户设置,请将 WEBUI_AUTH 环境变量设置为 False。注意:修改后将无法在单用户模式和多帐户模式之间切换。

docker run -d -p 3000:8080 -e WEBUI_AUTH=False -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

其中:卷映射 -v open-webui:/app/backend/data 可以防止容器重启时数据丢失;端口映射 -p 3000:8080 表示访问主机的 3000端口时,请求会被转发到容器的 8080 端口。

- 访问 WebUI。

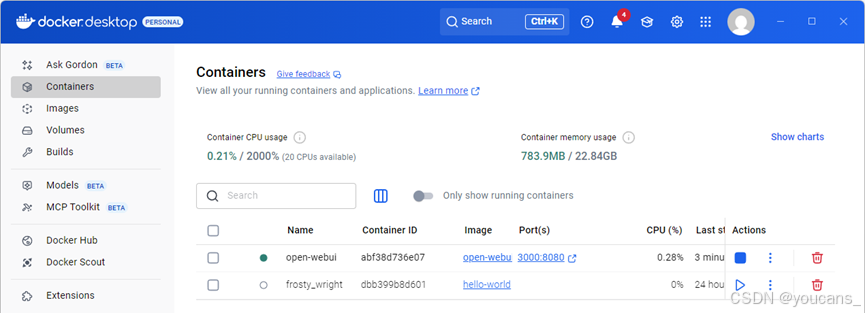

(1)在容器docker中运行open-webui,如下图所示。

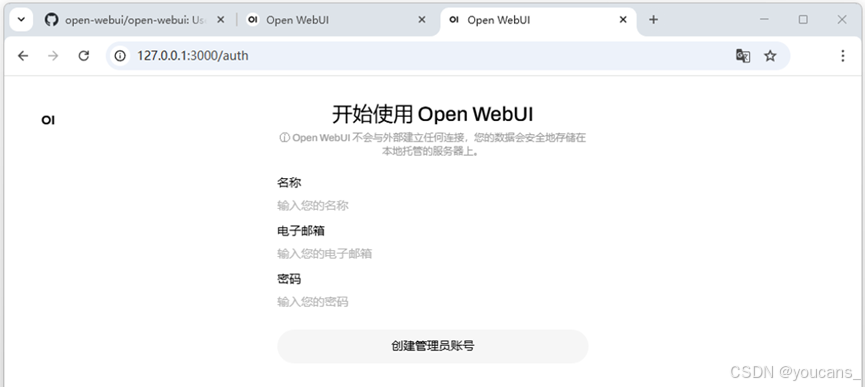

(2)从浏览器访问3000端口:“http://127.0.0.1:3000” 或 “http://localhost:3000”,进入 WebUI。首次访问时,需要创建一个管理员账户。

(3)再次访问 WebUI 时,则显示如下的登录界面。输入用户名(电子邮箱)和密码,登录WebUI 。

3. 使用GPT-OSS模型

- 访问 WebUI(“http://localhost:3000”),登录用户账号。

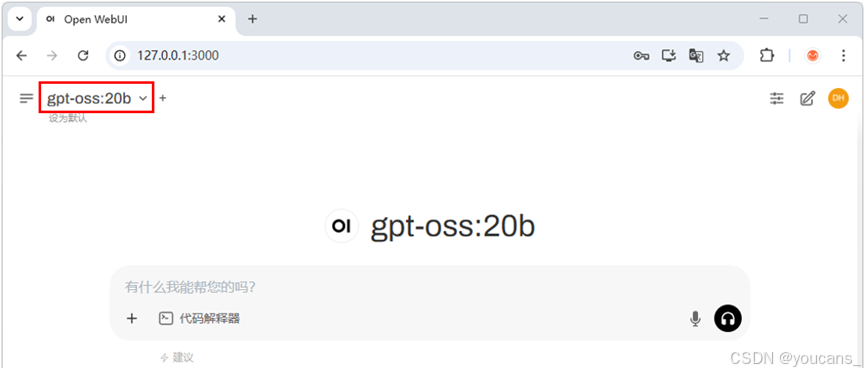

- 模型配置。点击左上角模型选择按钮,选中 “gpt-oss:20b” 模型,就可以使用本地部署的GPT-OSS模型进行对话了。

- 向GPT-OSS模型提问:【请比较RCNN,Fast RCNN 与 Faster RCNN。】。

模型的输出如下图所示。

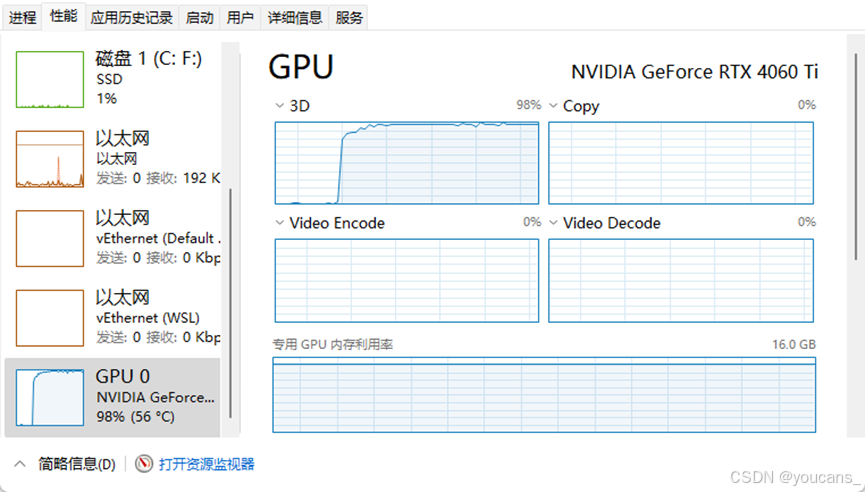

本地计算机配置NVIDIA RTX 4060Ti(16 GB)单卡GPU,对话时的GPU性能如下图所示,GPU利用率高达98%,表示算力已经满载。

4. 模型管理与联网搜索

4.1 模型管理

(1)在 Open WebUI 中,选择 “管理员面板-设置-外部连接”,可以下载模型、配置设置和管理连接。

(2)点击 “管理OpenAI API连接”,在弹出的 “添加连接” 窗口中填写API请求地址和API密钥,可以将您的服务器连接到 Open WebUI。

4.2 联网搜索

本节内容需要模型支持,GPT-OSS 目前不能支持。

为了充分释放本地模型的潜力,启用网络搜索将允许从网络中获取实时数据,从而通过最新信息增强他们的响应。

- 启用网络搜索。

(1)导航到管理面板:打开WebUI,选择 “管理员面板-设置-联网搜索”。

(2)启用网络搜索:点击"通用-联网搜索"后的切换按钮,启用联网搜索功能。

(3)选择搜索提供商:点击"网络搜索引擎"选择搜索根据,如"tavily"。注意有的模型需要API密钥。

- 使用网络搜索:

启用Web搜索后,模型就可以使用实时搜索功能。当你提出需要当前信息的查询时,该模型将自动从网络中搜索相关数据。

(1)打开Web搜索:在WebUI聊天界面中,点击输入框下方"联网搜索"图标,该图标转为蓝色背景表明打开Web搜索。

(2)与模型对话:像往常一样输入提问。如果输入的问题需要联网信息,模型将使用启用的搜索引擎为您提供更准确和最新的响应。

【本节完】

下节 继续介绍:使用API接口调用GPT-OSS

版权声明:

youcans@qq.com 原创作品,转载必须标注原文链接:

【AGI使用教程】GPT-OSS 本地部署(1)

【AGI使用教程】GPT-OSS 本地部署(2)

Copyright@youcans 2025

Crated:2025-08