【数据采集+人形机器人】使用 Apple Vision Pro 对宇树(Unitree)G1 和 H1 人形机器人进行全身的遥操作控制

OpenWBT:https://github.com/GalaxyGeneralRobotics/OpenWBT/blob/main/README_zh.md

采集后的算法:https://zzk273.github.io/R2S2/

该项目的技术实现主要由R2S2支持。该仓库实现了使用 Apple Vision Pro 对宇树(Unitree)G1 和 H1 人形机器人进行全身的遥操作控制,该系统不仅支持实机也能使用户在仿真中遥操,基于该系统只需要一个遥操员就可以控制机器人像人一样运动、蹲、弯、抓,搬等,大幅度扩展了机器人作业空间以实现更多任务。

在这个项目中,遥操作可分为下半身控制与上半身控制两部分。针对下半身控制,我们的方法允许使用者通过一对摇杆控制器来操控人形机器人行走或改变身体姿态。而上半身控制方面,机器人手部动作是通过逆向运动学算法,从VR设备捕捉到的人手位姿数据计算得出的。

数据采集后使用RSS2算法进行训练

2505_R2S2:Unleashing Humanoid Reaching Potential via Real-world-Ready Skill Space 通过现实可用的技能空间释放类人机器人到达能力潜力

-

Unleashing:释放、激发

-

Humanoid Reaching Potential:类人机器人在 reaching(到达目标)的潜力

-

via:通过

-

Real-world-Ready Skill Space:

-

Skill Space:技能空间(可以是一个表示“不同技能组合”的控制空间)

-

Real-world-Ready:可直接部署到真实世界的、具备现实可行性的

-

效果

遥控

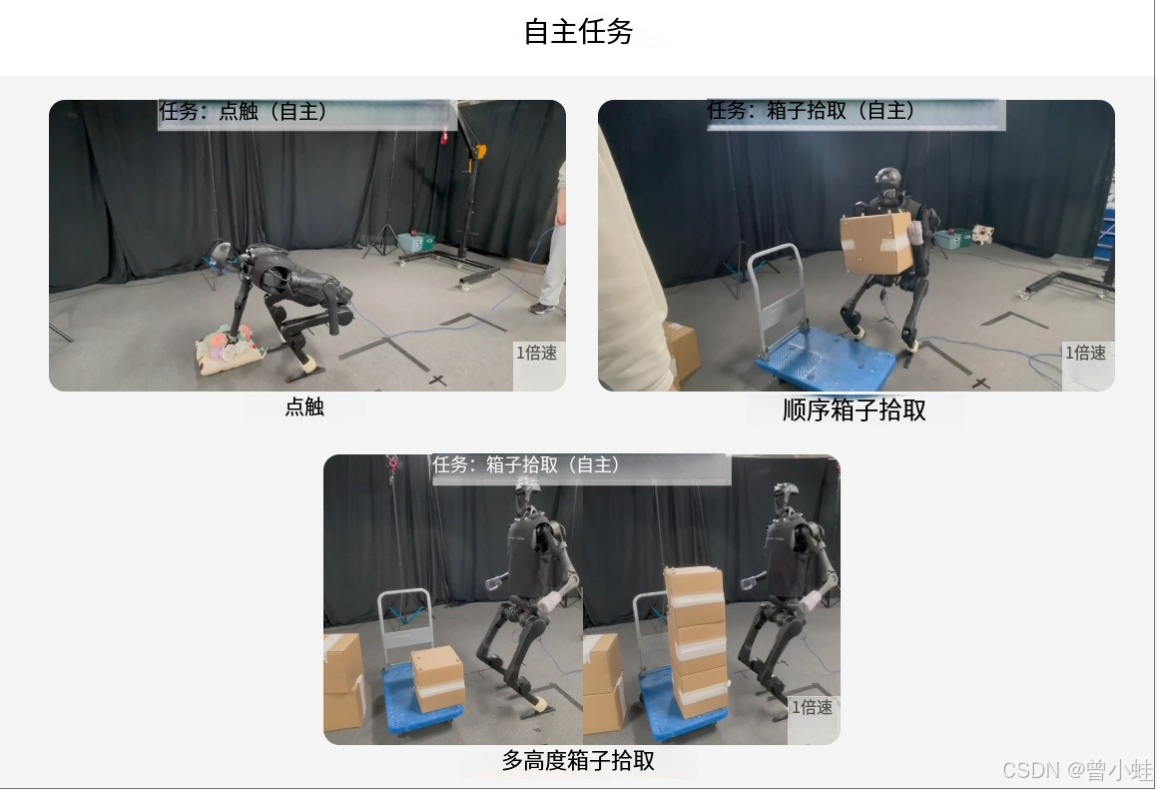

训练后自主运动

算法结构

1)我们将复杂的WBC运动技能分解为原始技能的库,每个技能分别进行了调整和SIM2REAL。 2)我们将多种原始技能整合到具有各种信息瓶颈的学生政策中。 3)我们培训高级规划政策,以从R2S2进行采样,从而有效,稳定地完成现实的目标任务。