技术速递|使用 AI Toolkit 构建基于 gpt-oss-20b 的应用程序

作者:卢建晖 - 微软高级云技术布道师

翻译/排版:Alan Wang

OpenAI 已发布开源模型 gpt-oss-20b 和 gpt-oss-120B。企业和开发者现在可以在边缘设备上部署这些模型,无需依赖云端 API,从而实现本地部署。

VS Code 的 AI Toolkit 扩展为开发者提供了完整的开发工作流——从模型测试、本地部署到构建智能 Agent 应用——打造了一个端到端的 AI 应用开发流程。本篇文章,我们将结合 gpt-oss-20b,使用 AI Toolkit 来构建本地 AI 应用。

理解 gpt-oss

OpenAI 已发布 gpt-oss-120b 和 gpt-oss-20b,这是自 GPT-2 以来首次推出的开放权重语言模型。两款模型均采用混合专家(Mixture-of-Experts,MoE)架构,并结合 MXFP4 量化技术,具备卓越的推理能力和工具使用功能。

-

gpt-oss-120b 拥有 1,170 亿参数,每个 token 激活 51 亿参数,可在单张 H100 GPU(80GB 显存)上运行,性能可媲美 OpenAI 的 o4-mini。

-

gpt-oss-20b 拥有 210 亿参数,每个 token 激活 36 亿参数,仅需约 16GB 内存,非常适合消费级硬件和边缘设备。

两款模型均支持 128k 上下文长度、完整的推理链(Chain-of-Thought)、结构化输出以及 Agent 工作流。它们采用 Apache 2.0 许可证发布,允许免费商用、修改和再分发。模型兼容多种推理框架,包括 vLLM、Ollama 和 Transformers,也可运行在 Azure AI Foundry、Hugging Face 等云平台上。

在生物安全、化学安全和网络安全等领域,这些模型均经过严格的安全测试,可为开发者和企业提供灵活、可控的 AI 解决方案,支持本地部署、云托管或边缘计算应用。详情可阅读:https://openai.com/index/introducing-gpt-oss/

开发者可以在本地环境基于 gpt-oss-20b 构建应用,所使用的工具是 Visual Studio Code 的 AI Toolkit 扩展。你可以部署、测试模型,创建 Agent 等。接下来我们来看看这些场景。

部署

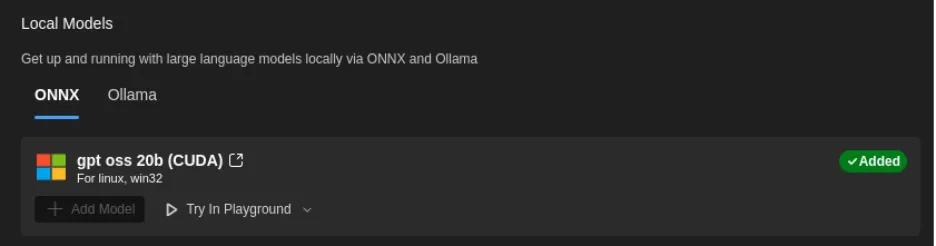

从 AI Toolkit 模型目录将 gpt-oss-20b 部署到本地环境

系统要求

在开始部署之前,请确保你的开发环境满足以下要求:

- 硬件:显存 16GB 及以上的 GPU

- 软件:Visual Studio Code 的 AI Toolkit 扩展

部署步骤

-

访问 AITK 模型目录 安装 VS Code 的 AI Toolkit 扩展后,通过命令面板(Ctrl+Shift+P)打开模型目录。在目录中找到 gpt-oss-20b,并点击 “Add Model” 按钮。

-

初始化部署 AI Toolkit 会自动下载模型文件并执行本地部署。整个过程通常需要 15–30 分钟。

3. 验证部署 部署完成后,你可以在 AI Toolkit 的模型管理界面查看 gpt-oss-20b 的运行状态。

注意:未来版本将支持仅使用 CPU 的部署。目前仅支持 GPU 加速部署。

使用 Ollama 与 AI Toolkit 进行本地部署

除了在 AI Toolkit 的模型目录中直接以 onnx 格式部署 gpt-oss-20b 外,你还可以使用 Ollama 以 gguf 格式部署 gpt-oss-20b。

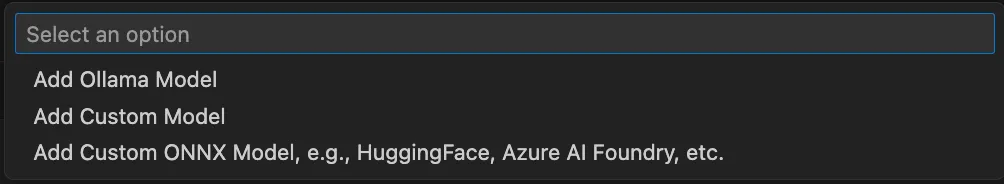

Ollama 提供了灵活的 API,并可与多种开发框架集成。开发者能够在 AI Toolkit 中更快速地测试和调用 Ollama 模型。以下是将 Ollama 集成到 AI Toolkit 的步骤:

-

安装 Ollama 按照你的操作系统的标准 Ollama 安装流程进行安装。

-

运行 gpt-oss-20b 模型

ollama run gpt-oss

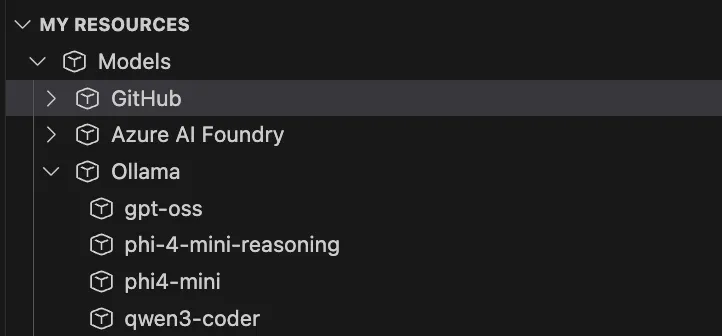

- 在 AI Toolkit 中添加 Ollama gpt-oss-20b 到 My Resources

添加成功,AI Toolkit 资源中已包含通过 Ollama 部署的 gpt-oss-20b

AI Toolkit 集成测试 gpt-oss-20b

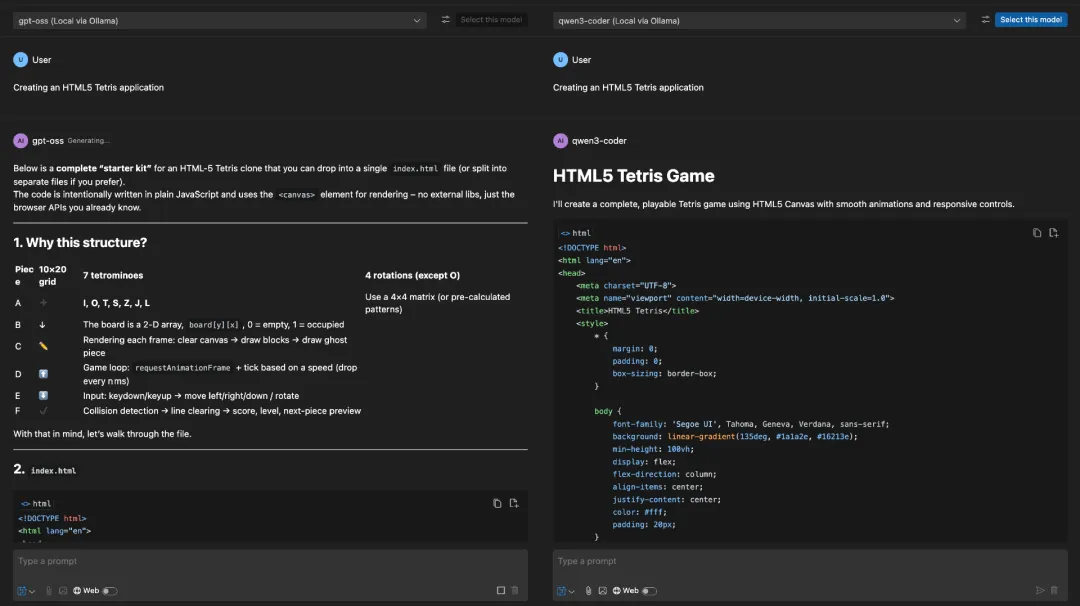

如上所述,在 AI Toolkit 中,我们的关注点不仅是本地模型部署。接下来,我们可以对模型进行测试。毕竟,在业务场景中,模型生成的内容至关重要。通过 AI Toolkit 的 Playground,我们可以对比不同模型的输出结果。

例如,在编程场景中,我们可以尝试对比 gpt-oss-20b 与 qwen3-coder。

- 配置对比实验

-

gpt-oss-20b(本地部署)

-

Qwen3-Coder(本地部署)

-

在 Playground 中启用 “Model Comparison” 模式并选择

-

代码生成测试用例

测试提示词:“Creating an HTML5 Tetris application”

使用 gpt-oss-20b 创建 Agent

AI Agent 是当前热门的技术之一。除了使用基于云端的大语言模型创建应用外,我们还可以在本地创建 Agent。尤其在开发场景中,本地模型的组合能更方便地用于构建 AI Agent 原型和应用。

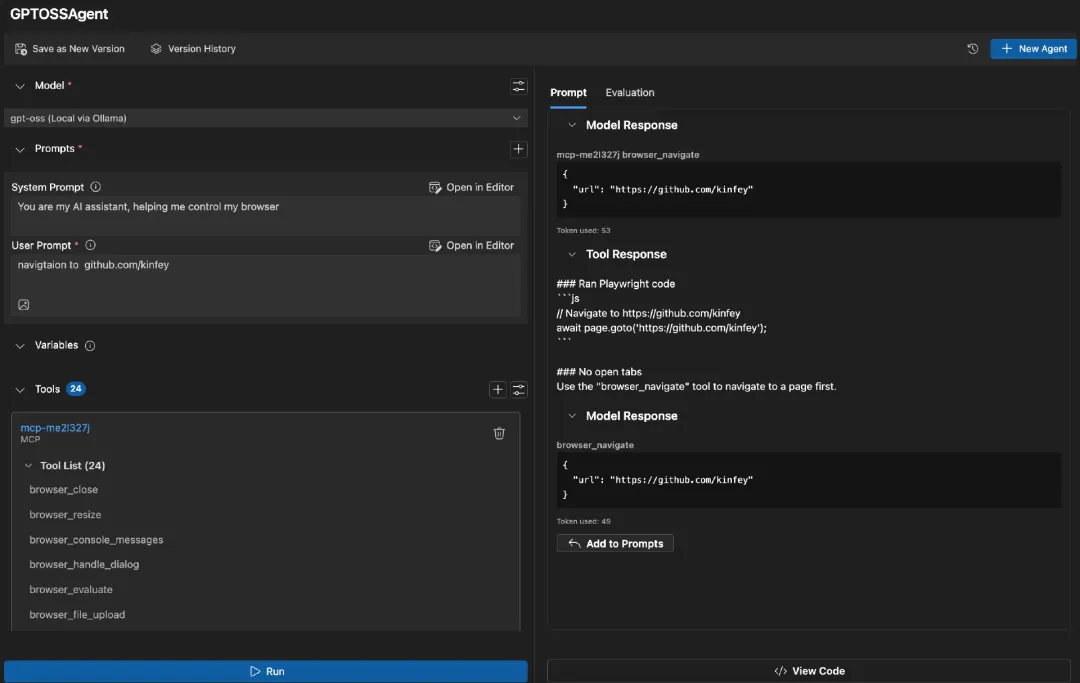

AITK 的 Agent Builder 是一个可视化智能 Agent 构建工具,能够让开发者快速创建由 gpt-oss-20b 驱动的 Agent 应用。你可以结合 MCP 服务,基于 gpt-oss-20b 构建功能更强大的 Agent。

结论

AI Toolkit 支持对新发布的模型(如 gpt-oss-20b)进行本地部署、测试和应用评估。这加速了模型与应用场景的集成,使最新的智能应用能够满足多样化的企业需求。

资源

-

了解更多 AITK 信息

-

了解更多 gpt-oss 信息

-

OpenAI 开源模型:gpt-oss 在 Azure AI Foundry 与 Windows AI Foundry 上的应用