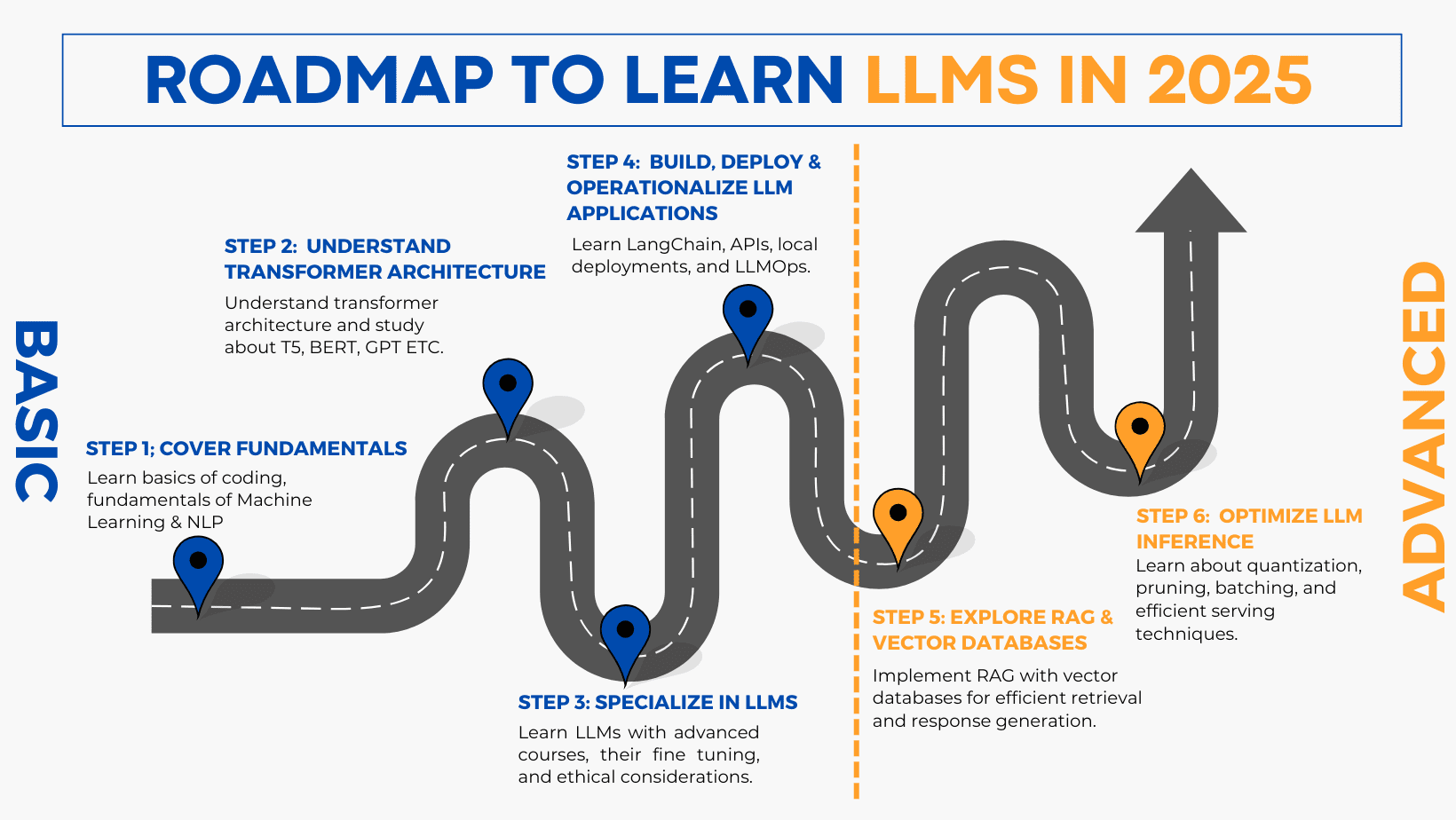

2025 大语言模型系统学习路线:从基础到部署与优化的全方位指南(含权威资源与项目实战)

大语言模型(LLM)是人工智能的一大进步。它们能够预测并生成“仿人类”的文本。LLM 学习语言规则(如语法与语义),因此能执行多种任务:回答问题、总结长文本、甚至创作故事。

对自动生成与组织内容的需求在快速增长,推动了大语言模型市场的扩张。根据一份报告《Large Language Model (LLM) Market Size & Forecast》: “The global LLM Market is currently witnessing robust growth, with estimates indicating a substantial increase in market size. Projections suggest a notable expansion in market value, from USD 6.4 billion in 2024 to USD 36.1 billion by 2030, reflecting a substantial CAGR of 33.2% over the forecast period”

这意味着:2025 年可能是学习 LLM 的最佳时机。学习 LLM 的高级概念需要结构化、循序渐进的方法,涵盖概念、模型、训练、优化、部署与高级检索方法。本路线图提供获得 LLM 专业能力的逐步路径。让我们开始吧。

步骤 1:夯实基础

你已掌握编程、机器学习和自然语言处理基础的话,可跳过此步;若你是新手,建议参考以下资源。

- 编程(Python)

- 目标:掌握 Python 基础(机器学习最常用语言)

- 资源:

- Learn Python - Full Course for Beginners [Tutorial] - YouTube(推荐)

- Python Crash Course For Beginners - YouTube

- TEXTBOOK: Learn Python The Hard Way

- 机器学习(ML)

- 目标:在进入 LLM 之前掌握核心概念:监督/无监督学习、回归、分类、聚类、模型评估

- 资源:

- Machine Learning Specialization by Andrew Ng | Coursera(付费,可认证) -(免费替代)Machine Learning by Professor Andrew Ng(YouTube)

- 自然语言处理(NLP)

- 目标:打牢 NLP 基础:分词、词向量、注意力机制等

- 资源:

- Coursera: DeepLearning.AI Natural Language Processing Specialization(推荐)

- Stanford CS224n (YouTube): Natural Language Processing with Deep Learning

步骤 2:掌握 LLM 的核心架构

大语言模型以不同架构为基础,其中以 Transformer 最为关键。理解这些架构是高效使用现代 LLM 的前提。

- 学习 Transformer 架构,重点理解:自注意力(self-attention)、多头注意力(multi-head attention)、位置编码(positional encoding)

- 从 Attention Is All You Need 入门,随后了解不同变体:

- 仅解码器(decoder-only):GPT 系列

- 仅编码器(encoder-only):BERT

- 编码器-解码器(encoder-decoder):T5、BART

- 使用 Hugging Face Transformers 等库获取与实现多种模型架构

- 练习对不同架构进行微调(分类、生成、摘要等任务)

推荐资源

- The Illustrated Transformer(图文讲解)

- Transformers Explained – Yannic Kilcher:深入解读 Attention Is All You Need(推荐)

- Language Models are Few-Shot Learners(GPT 系列:解码器架构)

- BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

- Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer(T5)

- Hugging Face Tutorial (2024):覆盖多种 NLP 任务(推荐)

- Fine-Tuning BERT for Text Classification:BERT 文本分类实战(推荐)

- Fine tuning gpt2 | Transformers huggingface | conversational chatbot | GPT2LMHeadModel:GPT-2 微调聊天机器人

步骤 3:专精大语言模型 在打好基础后,聚焦 LLM 本身:其架构、伦理影响与实际应用。

- LLM University – Cohere(推荐)

- 为新手提供线性学习路径,为进阶者提供应用驱动路径;系统覆盖理论与实践

- Stanford CS324: Large Language Models(推荐)

- 全面课程,涵盖理论、伦理与实操;教你构建与评估 LLM

- Maxime Labonne Guide(推荐)

- 提供两条职业路径:LLM Scientist(模型研发)与 LLM Engineer(应用落地)

- 包含 The LLM Engineer’s Handbook:从设计到发布 LLM 应用的全流程

- Princeton COS597G: Understanding Large Language Models

- 研究生级课程,覆盖 BERT、GPT、T5 等;适合深度技术研究

- Fine Tuning LLM Models – Generative AI Course

- 学习高效微调(LoRA、QLoRA)与量化技术;基于 Llama2、Gradient、Google Gemma 的实操

- Finetune LLMs to teach them ANYTHING with Huggingface and Pytorch | Step-by-step tutorial

- 从数据准备到训练评估的完整微调流程

步骤 4:构建、部署与运营化 LLM 应用 理论与实践相辅相成。

本部分聚焦用主流框架与 API 将 LLM 集成到项目中,并介绍生产与本地环境的部署和运营最佳实践,包括监控、优化与维护(LLMOps)。

核心方向

- 应用开发:将 LLM 集成到面向用户的应用或服务

- LangChain:高效 LLM 应用框架,学习用它快速搭建项目

- API 集成:对接各类 API(如 OpenAI)以增强功能

- 本地部署:在本机运行 LLM

- LLMOps 实践:生产环境中的部署、监控与维护方法论

推荐项目与资源

-

构建 LLM 应用:

- LangChain Crash Course For Beginners | LangChain Tutorial

- LangChain Master Class 2024:20+ 真实用例(推荐)

- OpenAI Api Crash Course For Beginners | Financial Data Extraction Tool Using OpenAI API(项目式教学,推荐)

- Build your own LLM chatbot from scratch | End to End Gen AI | End to End LLM | Mistrak 7B LLM(从零构建聊天机器人)

- LLM Course – Build a Semantic Book Recommender(Python、OpenAI、LangChain、Gradio)

- Youtube Free Playlist Consisting of LLM End to End Projects:20+ 端到端项目(推荐)

-

本地 LLM 部署:

- How to Deploy an LLM on Your Own Machine

- How to Run Any Open-Source Large Language Model Locally

- Foundations of Local Large Language Models(Duke University,推荐)

- Beginning Llamafile for LLMs:用 llama.cpp 将 LLM 提供为生产级 Web API

- Containerizing LLM-Powered Apps: Chatbot Deployment:用 Docker 部署本地 LLM

-

生产环境部署与管理:

- How to deploy LLMs as APIs using Hugging Face + AWS

- LLMOps Instructional Video Series:Azure AI Studio 实操的 5 部系列

- Large Language Model Operations (LLMOps) Specialization(Duke University,推荐)

- Simplify LLMOps & Build LLM Pipeline in Minutes:用 Vext 简化 LLMOps

-

GitHub 资源库:

- Awesome-LLM:LLM 论文、框架、工具、课程与教程合集,重视 ChatGPT 相关

- Awesome-langchain:跟踪 LangChain 生态的项目与资源

步骤 5:RAG 与向量数据库 RAG(检索增强生成)

将信息检索与文本生成结合:在生成前检索外部相关文档,以提升准确性、减少幻觉,适合知识密集型任务。

- 理解 RAG 及其架构:标准 RAG、层级 RAG、混合 RAG 等

- 向量数据库:在 RAG 中用于语义检索(而非关键词匹配),实现高效相关文档召回

- 检索策略:实现稠密检索、稀疏检索与混合检索

- LlamaIndex 与 LangChain:掌握其在 RAG 中的用法

- 企业级 RAG 扩展:分布式检索、缓存与时延优化

推荐资源与项目

- 基础课程:

- Vector Database: Faiss - Introduction to Similarity Search:FAISS 相似度搜索基础

- Chroma - Vector Database for LLM Applications | OpenAI integration:管理向量数据的实践

- Learn RAG From Scratch – Python AI Tutorial from a LangChain Engineer(推荐)

- Introduction to LlamaIndex with Python (2024)

- Introduction to Retrieval Augmented Generation (RAG) | Coursera(推荐)

- 高级架构与实现:

- Retrieval-Augmented Generation (RAG) Patterns and Best Practices(架构与最佳实践,推荐)

- Fundamentals of AI Agents Using RAG and LangChain:高级 RAG、提示工程、AI Agent 构建

- HybridRAG: Ultimate RAG Engine – Knowledge Graphs + Vector Retrieval – YouTube(知识图谱 + 向量检索,推荐)

- Retrieval Augmented Generation LlamaIndex & LangChain Course:系统构建高效 RAG

- 企业级与可扩展性:

- RAG: Building enterprise ready retrieval-augmented generation applications - YouTube(系统化课程)

- Multimodal RAG using the Vertex AI Gemini API – Coursera(企业级多模态 RAG,推荐)

- Learn Advanced RAG Tricks with Zain – YouTube(企业级 RAG 进阶技巧)

步骤 6:优化 LLM 推理

推理优化对效率、成本与可扩展性至关重要:减少时延、提升响应速度、降低计算开销。

关键主题

- 模型量化:8-bit、4-bit(如 GPTQ、AWQ)以减小模型、提升速度

- 高效服务:vLLM、TGI(Text Generation Inference)、DeepSpeed 等推理框架

- 参数高效微调:LoRA、QLoRA 在低资源下提升性能

- 批处理与缓存:通过批量与缓存优化 API 调用与内存使用

- 端侧推理:GGUF(适配 llama.cpp)、ONNX、TensorRT 等

推荐学习资源

- Efficiently Serving LLMs – Coursera

- Mastering LLM Inference Optimization: From Theory to Cost-Effective Deployment – YouTube(推荐)

- MIT 6.5940 Fall 2024 TinyML and Efficient Deep Learning Computing(模型压缩与优化,推荐)

- Inference Optimization Tutorial (KDD) – Making Models Run Faster – YouTube(AWS 团队教程)

- Large Language Model inference with ONNX Runtime (Kunal Vaishnavi)

- Run Llama 2 Locally On CPU without GPU GGUF Quantized Models Colab Notebook Demo(CPU 本地运行 LLaMA 2)

- Tutorial on LLM Quantization w/ QLoRA, GPTQ and Llamacpp, LLama 2(多种量化技术)

- Inference, Serving, PagedAtttention and vLLM(PagedAttention 与 vLLM 加速原理)

结语

本指南为 2025 年系统学习与掌握 LLM 提供了完整路线图。内容看似繁多,但请相信:只要按部就班,你将很快构建起全面而扎实的能力。若你有任何问题或需要进一步帮助,欢迎继续提问。