【机器学习深度学习】NLP评价指标 BLEU 和 ROUGE

目录

前言

一、为什么需要BLEU和ROUGE?

二、BLEU(精确度):检查翻译有多“准”

2.1 BLEU是什么?

2.2 BLEU怎么打分?

2.3 BLEU的优点

2.4 BLEU的缺点

2.5 类比理解

2.6 小结

三、 ROUGE(召回率):检查摘要抓了多少“重点”

3.1 ROUGE是什么?

3.2 ROUGE有哪些类型?

3.3 ROUGE怎么打分?

3.4 ROUGE的优点

3.5 ROUGE的缺点

3.6 类别理解

四、BLEU和ROUGE比一比

啥时候用哪个?

五、LLaMAFactory评估指标

六、实际用的时候咋办?

6.1 怎么实现?

6.2 遇到的问题

6.3 还有啥新玩法?

六、总结:选对指标很重要

前言

在自然语言处理(NLP)中,机器生成的文本(比如翻译或摘要)需要评估好坏。人工检查太慢又主观,所以我们用BLEU和ROUGE这样的自动化指标来打分。这篇文章将用直观易懂的方式,带你搞清楚这俩指标是啥、怎么用、优缺点在哪,适合初学者和想快速了解NLP评价的人。

一、为什么需要BLEU和ROUGE?

想象你让机器翻译一句中文:“我爱吃苹果。”机器输出:“I love eating apples.”这看起来挺好,但怎么量化“好”呢?人工评价太费劲,BLEU和ROUGE就像“评分机器”,通过对比机器输出和标准答案(参考文本)来打分。它们帮我们快速判断机器翻译、摘要或对话生成的质量,省时省力还能保持客观。

二、BLEU(精确度):检查翻译有多“准”

2.1 BLEU是什么?

BLEU(双语评价替补)诞生于2002年,主要用来评价机器翻本译。它关注机器输出的文跟参考文本有多像,重点是精确度——机器说的词,有多少是参考文本里有的?

2.2 BLEU怎么打分?

BLEU的核心是看n-gram(连续的n个词)的匹配情况。比如一元(单个词)、二元(两个词的组合)等。以下是它的计算步骤,简单来说:

-

数匹配的词:把机器输出(候选文本)和参考文本拆成词或短语,比较有多少相同的。比如:

-

参考:“我爱吃苹果。”(I love eating apples.)

-

机器输出:“I love apples.”

-

一元匹配:I、love、apples都对,3/3,精确度100%。

-

-

防止作弊:如果机器重复用某个词(比如输出十个“I”),BLEU会限制匹配次数,参考文本里“I”只出现一次,多的不算。

-

惩罚太短:如果机器输出很短(比如只说“apples”),可能精确度很高,但漏了很多信息。BLEU会给短文本打折扣,叫简短惩罚。

-

综合打分:把不同n-gram(一元、二元等)的精确度加权平均,再乘上简短惩罚,得到最终BLEU分数(0到1,1是完美匹配)。

2.3 BLEU的优点

-

简单好用:计算快,适合快速比较多个翻译模型。

-

翻译专用:特别擅长检查翻译是否用了正确的词。

-

标准统一:NLP领域都用它,方便比较。

2.4 BLEU的缺点

-

只看精确度:只管机器说了啥对的,没说对的(漏掉的内容)不算问题。

-

死板:要求词完全一样,比如“big”和“large”算不同,语义相似不管用。

-

爱短文:太短的输出可能得分高,但其实漏了很多信息。

-

需要多参考:只有一个参考文本时,BLEU可能不公平。

2.5 类比理解

想象你参加了一场拼字比赛(类似于拼写考试)。比赛的规则是:你需要写下尽可能多的单词,这些单词和参考答案中的单词应该尽量匹配。你的得分就取决于你写下的单词与参考答案中相同的单词数。

类比解释:

你写的单词:相当于机器生成的翻译。

参考答案中的单词:相当于正确的翻译或参考文本中的单词。

得分:就是 BLEU 得分,表示你写下的单词与参考答案中的匹配程度。

举个例子:

参考答案是: "The cat is on the mat."

你写的是: "The cat sits on the mat."

在这种情况下,你匹配了 "The", "cat", "on", "the", 和 "mat" 这些单词。也就是说,你写的单词与参考答案中相同的单词占了一定的比例,BLEU 得分就根据这种比例来评估。

2.6 小结

| 方面 | 内容 |

|---|---|

| 优点 | 1. 简单快速,易实现 |

| 缺点 | 1. 只看精确度,漏掉内容不扣分 |

三、 ROUGE(召回率):检查摘要抓了多少“重点”

3.1 ROUGE是什么?

ROUGE(面向召回的摘要评价替补)2004年问世,主要用来评价文本摘要,也能用在翻译。它关注召回率——机器输出抓住了参考文本多少内容?简单说,就是看机器有没有把重要的东西说出来。

3.2 ROUGE有哪些类型?

ROUGE有几种玩法,每种看问题的角度不同:

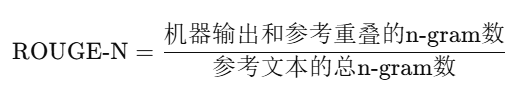

1.ROUGE-N:和BLEU类似,数n-gram的匹配,但重点是参考文本里有多少词被机器输出覆盖了。

示例:参考:“猫坐在垫子上。”机器输出:“猫在垫子上。”ROUGE-1看参考的词(猫、坐、在、垫子、上)有多少在输出里。

2.ROUGE-L:看最长公共子序列(LCS),不要求词连着出现,适合句式变了但意思差不多的场景。

3.ROUGE-S:看跳跃二元,允许词之间有间隔,适应词序更灵活的情况。

3.3 ROUGE怎么打分?

ROUGE主要算三种分数:

-

召回率:参考文本的词,有多少出现在机器输出里?

-

精确度:机器输出的词,有多少是参考文本里的?

-

F1分数:综合召回率和精确度,平衡两者的表现。

比如ROUGE-N的召回率:

3.4 ROUGE的优点

-

抓重点:特别适合摘要任务,确保机器没漏掉关键信息。

-

灵活:ROUGE-L能处理句式变化,比如“猫在垫子上”和“垫子上有只猫”。

-

全面:提供召回率、精确度和F1分数,多角度看质量。

3.5 ROUGE的缺点

-

还是有点死板:ROUGE-N要求词完全一样,语义相近不算。

-

计算复杂:ROUGE-L和ROUGE-S比BLEU费力。

-

偏摘要:对话生成等任务用ROUGE可能不太合适。

3.6 类别理解

想象你是一个老师,你给学生一个练习题,要求他们根据给定的提示写一个摘要。你将学生的答案与参考答案对比,看看学生是否写出了一些重要的信息(n-gram)。在这种情况下,你更关心的是学生写出的答案中,有多少内容是从参考答案中获取的。

类比解释:

-

学生的摘要:相当于机器生成的摘要。

-

参考答案的内容:相当于人工给出的参考摘要。

-

得分:就是 ROUGE 得分,表示学生写出的答案与参考答案中匹配的部分有多少。

举个例子:

-

参考答案是:“The cat sat on the mat and played with a ball.”

-

学生的摘要是:“The cat sat on the mat.”

在这种情况下,学生的摘要包含了参考答案中的主要信息:“cat” 和 “mat”。ROUGE 计算的就是学生摘要与参考摘要之间的重叠部分,它关注学生是否尽可能召回了参考摘要中的重要内容。

四、BLEU和ROUGE比一比

| 特点 | BLEU | ROUGE |

|---|---|---|

| 关注点 | 精确度:机器说的对不对 | 召回率:机器抓了多少重点内容 |

| 主要用在 | 机器翻译 | 文本摘要 |

| 方法 | n-gram匹配+简短惩罚 | n-gram、LCS或跳跃二元匹配 |

| 优点 | 简单、快速、翻译专用 | 灵活、抓重点、适合摘要 |

| 缺点 | 忽略漏掉内容、死板 | 有点复杂、ROUGE-N死板 |

啥时候用哪个?

-

BLEU:机器翻译,关心词对不对,尤其是多参考文本时。

-

ROUGE:文本摘要,关心有没有抓住关键内容,或句式变化大的场景。

BLEU 更像是在拼字比赛中,评估你写的单词和参考答案中的单词的 精确匹配。

ROUGE 更像是在摘要生成比赛中,评估你生成的摘要有多少信息来自参考答案,强调 召回率。

更简单的类比:

BLEU:如果你和别人玩“找出相同的单词”游戏,你找到的相同单词越多,得分越高。

ROUGE:如果你和别人玩“找出包含相似意思的单词”游戏,你找到的相似意思单词越多,得分越高。

五、LLaMAFactory评估指标

常见的评估指标主要用于衡量模型在不同任务中的表现。以下是常用评估指标的表格总结:

| 评估指标 | 描述 | 适用场景 |

|---|---|---|

| BLEU | 计算生成文本与参考文本之间的 n-gram 匹配精度。 | 机器翻译、对话生成 |

| ROUGE | 衡量生成文本与参考文本之间的 n-gram 重叠程度,侧重召回率。 | 文本摘要、自动摘要生成 |

| Perplexity | 衡量语言模型预测下一个词的困惑程度,值越低表示模型越自信。 | 语言建模、文本生成 |

| Accuracy | 衡量分类任务中,正确预测的样本占所有样本的比例。 | 文本分类、序列标注 |

| F1-score | 综合精确度和召回率的指标,适用于不均衡数据的分类任务。 | 分类任务(特别是有偏类数据) |

| ROUGE-L | 通过最长公共子序列(LCS)衡量文本之间的相似度,适用于摘要任务。 | 文本摘要、自动摘要生成 |

| BLEU-N | 对不同长度的 n-gram(如 1-gram, 2-gram 等)进行评估,扩展了 BLEU。 | 机器翻译、对话生成 |

| Meteor | 一种比 BLEU 更复杂的评估方法,考虑了同义词匹配、词形变化等因素。 | 机器翻译、文本生成 |

| Exact Match | 衡量模型输出与目标文本完全一致的比例。 | 文本生成任务(如问答) |

| ROUGE-S | 基于句子对的评估,计算生成文本和参考文本之间的 n-gram 匹配。 | 摘要生成、生成式任务 |

说明:

-

BLEU 和 ROUGE 是最常见的生成任务评估指标,分别适用于翻译任务和摘要任务。

-

Perplexity 主要用于语言建模,帮助衡量模型生成的文本的自然度。

-

Accuracy 和 F1-score 通常用于分类任务。

-

Meteor 是 BLEU 的增强版本,考虑了更多的语言变异,因此在处理语言生成任务时有时会提供更好的评估。

-

Exact Match 用于评估生成文本与目标文本的完全一致性,通常用于问答类任务。

六、实际用的时候咋办?

6.1 怎么实现?

用Python就能轻松搞定:

-

BLEU:用nltk库的nltk.translate.bleu_score。

-

ROUGE:用rouge-score库,或者Hugging Face的datasets包。

6.2 遇到的问题

-

参考文本少:没好的参考文本,两个指标都不准。

-

语义问题:它们只看词面,不懂“苹果”和“apple”是同一个意思。

-

任务不同:得根据任务选指标,比如翻译用BLEU,摘要用ROUGE。

6.3 还有啥新玩法?

BLEU和ROUGE有点老派,新的指标更聪明:

-

BERTScore:用BERT模型看语义相似性,懂“big”和“large”是一个意思。

-

METEOR:考虑同义词和词形变化,匹配更灵活。

-

BLEURT:模仿人类打分,综合性更强。

六、总结:选对指标很重要

BLEU和ROUGE是NLP评价的“老大哥”,帮我们快速检查机器翻译和摘要的质量。BLEU像个严格的语文老师,盯着翻译的每个词对不对;ROUGE像个总结高手,确保摘要没漏重点。但它们都不完美,词面匹配的局限让它们抓不住语义。实际用时,可以结合BERTScore等新指标,或者请人帮忙看看。选对指标,能让你的NLP模型更上一层楼!