大语言模型幻觉检测:语义熵揭秘

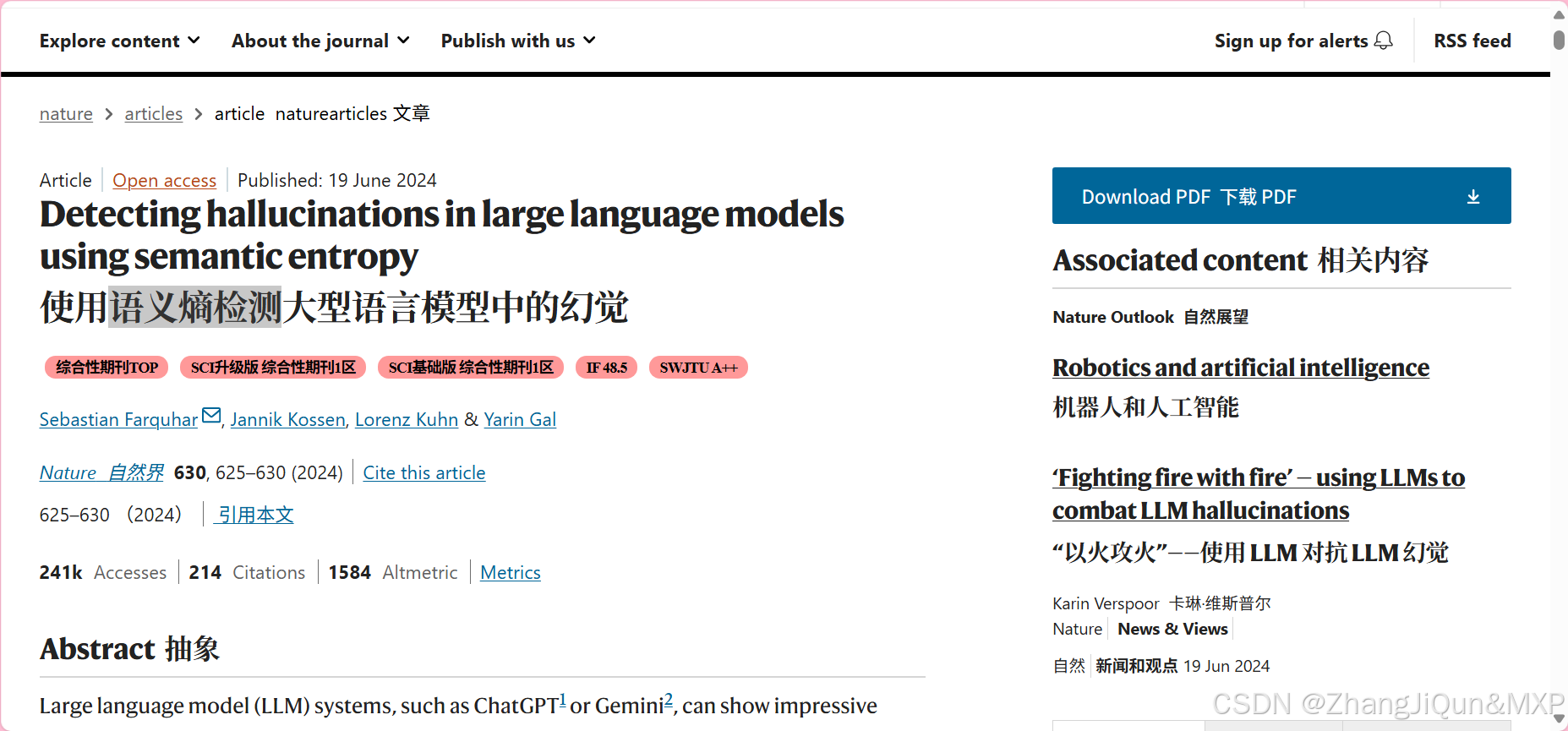

论文核心解析:《Detecting hallucinations in large language models using semantic entropy》

一、研究背景与核心问题

大语言模型(LLMs,如ChatGPT、Gemini)虽在问答、创作等领域表现强大,但“幻觉”(生成错误或无依据内容)严重限制其可靠性——例如医疗领域可能生成错误用药建议,法律领域虚构判例。

论文聚焦一种特定幻觉:“虚构内容(confabulations)”——即模型生成的错误答案具有“随意性”(受随机种子等无关因素影响,多次生成结果矛盾)。例如问“Sotorasib的作用靶点是什么”,模型可能有时答“KRASG12C(正确)”,有时答“KRASG12D(错误)”,这种随机错误就是虚构内容。

传统检测方法的局限:

- 基于