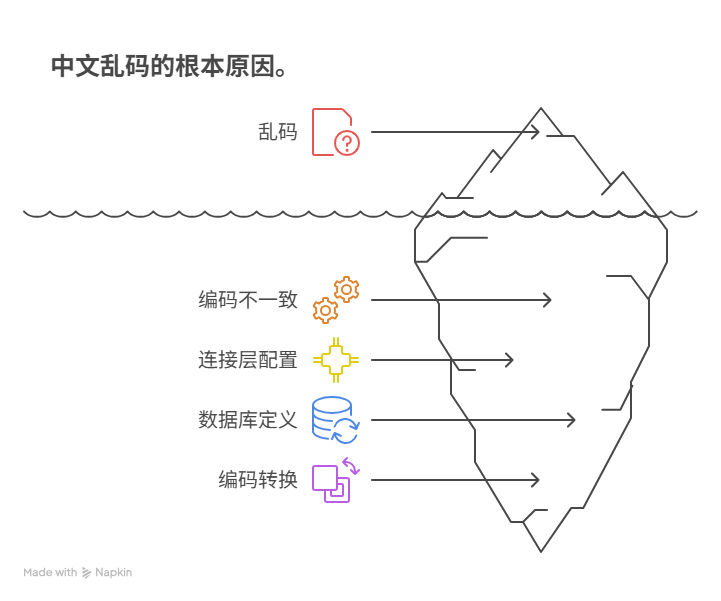

为什么存入数据库的中文会变成乱码

从产生、传输、处理到最终存储的整个生命周期中采用统一且正确的字符集编码。具体原因纷繁复杂,主要归结为:客户端操作系统或应用与数据库服务端字符集编码不一致、Web应用服务器到数据库驱动的连接层编码配置缺失或错误、数据库本身及其表、字段各层级的字符集定义不统一、以及在数据传输过程中发生了不恰当的隐式或显式编码转换。

这一系列环节中任何一环出现编码“断裂”,都会导致中文字符的二进制字节序列被错误解析,最终在数据库中呈现为毫无意义的问号、方块或其他无法辨识的符号,形成所谓的“乱码”。

一、探本溯源:字符集与编码的奥秘

要彻底理解乱码问题的根源,必须首先深入到计算机科学最基础的层面,厘清字符集与字符编码这两个既紧密联系又有所区别的概念。字符集(Character Set)是一个抽象的符号集合,它定义了哪些字符可以被计算机识别,例如,一个包含了所有汉字、英文字母、数字和标点符号的集合就是一个字符集。而字符编码(Character Encoding)则是将这个抽象集合中的每一个字符,映射为计算机能够存储和传输的二进制字节序列的具体规则。可以说,字符集是“字库”,而编码是“字典”,它告诉计算机如何用0和1来表示每一个“字”。

在中文信息处理的历史长河中,诞生了多种对汉字进行编码的方案。早期广泛使用的是国家标准GB2312,它收录了6763个汉字,基本满足了日常使用,但对于一些罕见字或繁体字则无能为力。为了扩展其表示范围,后续又推出了GBK编码,它向下完全兼容GB2312,同时增加了更多的汉字和符号,成为Windows操作系统中文版的默认编码。再后来,更为全面的GB18030标准被制定,其字符容量更为庞大。然而,这些编码方案都属于地区性标准,在全球化的互联网时代,跨语言的信息交换成为了常态,这就催生了统一的编码标准——Unicode。Unicode的目标是为世界上每一种语言的每一个字符都设定一个唯一的数字编号,即码点(Code Point)。但Unicode本身只是一个字符集,它还需要具体的编码实现方式,其中最著名、应用最广泛的就是UTF-8。UTF-8是一种变长编码方案,它使用1到4个字节来表示一个字符,对于ASCII字符,它只用1个字节表示,完全兼容ASCII,这使得它在互联网工程中具备了极高的通用性和效率,正如软件工程师Joel Spolsky在其经典文章《The Absolute Minimum Every Software Developer Absolutely, Positively Must Know About Unicode and Character Sets (No Excuses!)》中所强调的,忽略Unicode和字符编码的知识,是现代软件开发者不可原谅的疏忽。 UTF-8的普及极大地解决了全球范围内的乱码问题,但前提是整个数据处理链路都必须明确并遵守这一约定。

二、数据的“漂流”:从客户端到数据库的全链路追踪

一个中文字符从用户的浏览器输入框,到最终被持久化到数据库的表中,其间经历了一段漫长而复杂的“漂流”。这段旅程跨越了多个技术层面和软硬件环境,每一站都像一个编码的“海关”,如果“通关文牒”(即编码声明)不正确,数据就会被“误解”甚至“损毁”。我们可以将这条链路大致分解为几个关键节点,任何一个节点的编码配置失误,都是乱码问题的潜在引爆点。

首先是数据的源头——客户端。这通常是用户的浏览器或者一个桌面应用程序。浏览器通过HTML页面的<meta charset="UTF-8">标签来获知当前页面的编码方式,当用户提交表单时,浏览器会按照这个编码方式将数据发送给服务器。如果页面没有正确声明编码,浏览器可能会根据默认设置进行猜测,这就埋下了不确定性的种子。其次是Web服务器(如Tomcat, Nginx),它在接收到HTTP请求后,需要正确解析请求体中的数据。服务器的配置需要指定默认的URL和请求体编码,例如在Tomcat的server.xml中配置URIEncoding="UTF-8",就是为了确保HTTP GET请求中的中文字符能被正确解码。接着,数据进入了应用服务器内部的业务逻辑代码,例如Java或Python程序。编程语言本身对字符串的处理方式也至关重要。Java内部使用UTF-16来表示所有字符串,但在与其他系统进行I/O操作时,必须明确指定编码,否则会使用平台的默认编码,这在跨平台部署时是一个巨大的隐患。其中最关键也最容易被忽视的一环,是应用程序通过数据库驱动(如JDBC)连接数据库的时刻。 数据库连接字符串中必须显式地指定通信编码,例如在MySQL的JDBC URL中追加?characterEncoding=UTF-8,这个参数的作用是告知MySQL驱动,应用程序发送的数据是采用UTF-8编码的,请驱动在与数据库服务器通信时也使用此编码。如果缺失这一环,驱动可能会使用一个意想不到的默认编码,导致在通信层面就已经产生了乱码。

三、病灶诊断:剖析乱码产生的典型场景与根源

乱码的最终表现形态并非千篇一律,不同的表现往往暗示着不同的病因。最常见的乱码形态有两种:一种是整齐划一的“问号(?)”,另一种则是看似毫无规律的“火星文”。这两种形态背后,是两种性质完全不同的编码错误。

“问号”乱码通常是一种信息永久丢失的标志。它产生的原因是,当一个字符在从源编码向目标编码转换时,在目标字符集中找不到对应的字符。例如,当用户输入了一个Emoji表情(它在Unicode中有对应的码点,通常需要4个字节的UTF-8编码),而数据库的字段被定义为了GBK编码。GBK字符集中根本不存在Emoji表情的定义,因此在转换过程中,这个无法识别的字符就会被数据库系统用一个默认的替代符号来表示,这个符号通常就是问号“?”。一旦数据以问号的形式存入数据库,其原始的二进制信息就已经彻底丢失,后续无论如何进行编码转换,都无法再恢复出原始的Emoji表情。 这是一种不可逆的破坏,因此在数据库设计阶段,选择一个能够容纳所有可能输入字符的超集编码(如utf8mb4)就显得尤为重要。

而“火星文”式的乱码,则通常是由于编码链条中发生了错误的“解读”和“再编码”导致的,这种情况下的信息通常并未丢失,只是被“扭曲”了,理论上存在恢复的可能性。一个经典的场景是:客户端使用UTF-8编码提交了汉字“中”,其二进制字节是E4 B8 AD。然而,数据库连接层或者服务器层错误地认为这是一段Latin1(ISO-8859-1)编码的数据。由于Latin1是单字节编码,它会将这三个字节E4、B8、AD分别当作三个独立的字符进行存储。当再次从数据库读取并试图以UTF-8格式展示时,系统会尝试将这三个已经被错误存储的字符的二进制码再当作UTF-8来解析,最终呈现出来的就是一堆无法辨认的符号。在MySQL中,这个过程与几个关键的系统变量密切相关:character_set_client(客户端发送数据的编码)、character_set_connection(连接层编码)、character_set_results(返回给客户端的数据编码)。当执行SET NAMES utf8;命令时,实际上是同时设置了这三个变量,它是在明确地告诉MySQL服务器:“我接下来发送的SQL和数据都是UTF-8编码的,请你按照UTF-8来理解;同时,也请你将返回的结果用UTF-8编码”。对这几个变量的深刻理解,是诊断和解决MySQL中文乱码问题的关键所在。

四、防患未然:构建无乱码数据库系统的最佳实践

面对错综复杂的编码问题,与其在事后费尽心力地进行数据修复,不如在系统设计之初就采取一套严格的、统一的编码规范,从根本上杜绝乱码的发生。业界的最佳实践可以总结为一个核心原则:“UTF-8 Everywhere”,即在数据流转的每一个环节,都坚定不移地使用UTF-8编码。

这个原则需要从系统的最外层贯彻到最核心。首先,所有前端的HTML、CSS、JavaScript文件本身都应保存为UTF-8格式,并在HTML中明确声明<meta charset="UTF-8">。其次,Web服务器(如Nginx)应配置为默认使用UTF-8处理请求和响应。应用服务器(如Tomcat)的配置也需跟上,确保对URL和请求体都以UTF-8进行解码。在应用程序代码层面,任何涉及文件读写、网络通信等I/O操作的地方,都应显式指定UTF-8编码,避免依赖于可能变化的平台默认编码。在连接数据库时,必须在连接字符串中明确指定编码,例如jdbc:mysql://localhost:3306/mydb?characterEncoding=utf8mb4。最后,也是最重要的一步,数据库本身需要进行彻底的UTF-8化配置。对于MySQL而言,强烈推荐使用utf8mb4而非utf8。 utf8在MySQL的实现中是一个“阉割版”的UTF-8,它最多只使用3个字节来表示一个字符,无法存储像Emoji表情这样需要4个字节的Unicode字符。而utf8mb4才是完整实现了UTF-8的标准,能够处理所有Unicode字符。在MySQL的配置文件my.cnf或my.ini中,需要在[client]、[mysql]和[mysqld]等多个节下都配置default-character-set=utf8mb4,确保服务器、客户端以及所有新建的数据库和表都默认使用utf8mb4编码。只有当这条从前端到后端的编码链路被彻底打通,形成一个封闭的、统一的UTF-8环境,乱码问题才能被根治。

五、亡羊补牢:已存乱码数据的修复策略与技巧

尽管我们强调预防为主,但在现实世界的遗留系统或紧急故障处理中,我们仍然不可避免地要面对已经存入数据库的乱码数据。修复这些数据是一项精细且高风险的工作,操作前务必对目标数据进行完整备份。修复的核心思路是进行一次“逆向工程”,即分析乱码是如何产生的,然后执行其逆向的编码转换操作。

假设一个常见的错误场景:UTF-8编码的中文数据被错误地以Latin1的编码方式存入了数据库。此时,数据库中存储的是中文字符UTF-8编码后的原始字节序列。我们的修复目标就是让数据库“重新认识”这些字节。在MySQL中,可以利用CONVERT和CAST函数组合来完成这个精巧的操作。具体步骤是,先将该字段的类型从字符类型(如VARCHAR)临时转换为二进制类型(BINARY或BLOB),这一步是为了让MySQL“忘记”其当前的错误编码,而只关注其底层的原始字节。然后再将这个二进制序列按照正确的原始编码(这里是UTF-8)进行转换。一个典型的修复SQL语句如下:UPDATE my_table SET my_column = CONVERT(CAST(my_column AS BINARY) USING utf8mb4);。这条语句的逻辑是:将my_column字段的内容先视为一个纯粹的二进制串(CAST(my_column AS BINARY)),然后告诉MySQL,这个二进制串实际上是一个utf8mb4编码的字符串,请将其转换回来(CONVERT(... USING utf8mb4))。这个过程巧妙地绕过了错误的编码解读,直接对底层字节进行了重新解释,从而恢复出正确的中文字符。需要强调的是,这种修复方法并非万能,它只适用于原始字节信息没有丢失(即非“问号”乱码)的情况,并且需要准确判断出当初是哪两种编码之间发生了错误的转换。 在进行大规模数据修复前,务必先在少量样本数据上进行测试,验证修复逻辑的正确性。

六、总结与展望

中文乱码问题,看似是一个小小的技术瑕疵,实则是软件工程中全局意识和规范化流程的试金石。它横跨了从用户界面到数据存储的几乎所有技术栈,考验着开发者对底层数据流和字符编码原理的理解深度。从根本上说,解决乱码问题的银弹就是“一致性”——确保数据在整个生命周期中所经历的每一个环节,都对其字符编码有着统一、明确的约定和配置。以utf8mb4作为全链路的统一标准,是当前构建健壮、无乱码系统的最有效策略。

随着技术的发展,现代的开发框架、云数据库服务和容器化技术在很大程度上简化了编码配置的复杂性,许多默认配置已经朝着“UTF-8 Everywhere”的最佳实践靠拢。然而,技术可以降低犯错的门槛,却不能替代开发者对基础原理的理解。只有深刻洞悉字符从抽象符号到二进制字节的转换奥秘,以及数据在复杂系统中流转的完整路径,我们才能在面对层出不穷的新技术和新场景时,依然能够从容不迫地构建出真正稳定、可靠的全球化软件系统。

常见问答(FAQ)

Q1:为什么我的程序在本地Windows电脑上运行正常,部署到Linux服务器上就出现中文乱码了?

A1:这是非常典型的环境不一致问题。根本原因在于Windows中文版的默认编码通常是GBK,而大多数Linux发行版的默认编码是UTF-8。如果您的代码中存在依赖平台默认编码的地方(例如,文件读写、网络通信时未指定编码),那么在从Windows迁移到Linux时,这些操作的默认行为就会从GBK变为UTF-8,从而导致编码不匹配和乱码。解决方案是在代码所有I/O操作中显式指定统一的编码,如UTF-8,从而消除对环境的依赖。

Q2:MySQL中的utf8和utf8mb4到底有什么区别,为什么现在都推荐utf8mb4?

A2:在MySQL中,utf8是一个历史遗留的别名,它实现的并非完整的UTF-8标准,每个字符最多只使用3个字节存储。这使得它无法存储Unicode中需要4个字节编码的字符,最典型的例子就是各类Emoji表情符号和一些生僻汉字。而utf8mb4(mb4意为most bytes 4)才是MySQL中对UTF-8标准的完整实现,每个字符最多可使用4个字节存储,能够覆盖整个Unicode字符集。因此,为了保证未来的兼容性和避免数据丢失,所有新的应用都应该毫无疑问地选择utf8mb4作为数据库编码。

Q3:我已经将数据库、表和字段都设置为了utf8mb4,为什么保存Emoji表情时还是变成了问号?

A3:如果您确认数据库层面(表、字段)的字符集已经是utf8mb4,那么问题很可能出在数据进入数据库之前的环节。请检查您的数据库连接字符串,确保其中也指定了characterEncoding=utf8mb4。如果连接层没有正确声明编码,即使后端存储支持,数据在传输过程中也可能已经被错误地转换,导致信息丢失,最终存入的还是代表无法识别字符的问号。需要从客户端到数据库的全链路进行排查。

Q4:如何快速检查我的MySQL数据库当前的字符集相关配置?

A4:您可以通过执行SQL命令来查看MySQL的字符集设置。登录到MySQL客户端后,执行SHOW VARIABLES LIKE 'character%';和SHOW VARIABLES LIKE 'collation%';。这两个命令会列出所有与字符集和校对规则相关的服务器变量,如character_set_server、character_set_database等,通过它们可以全面了解服务器的默认配置。要查看当前连接的编码设置,可以执行SHOW SESSION VARIABLES LIKE 'character%';。要查看特定表的编码,可以执行SHOW CREATE TABLE your_table_name;,在返回的建表语句中会明确指出表的默认字符集。