如何通过ETLCloud做数据监听

许多企业为数据库日志解析而头痛,时常因为技术瓶颈,无法保证数据的实时性和一致性。

今天我们为您推荐一款新一代数据集成平台——ETLCloud。这款平台通过可视化的CDC配置能力和开箱即用的链接器,可帮助企业快速完成数据库日志解析,构建高可靠的数据实时管道。

本文将为您深入解析,如何通过ETLCloud快速落地CDC方案,释放实时数据的战略价值。

一、准备工作

1.本地部署ETLCLoud。

2.源库和目标端数据库。

3.源端数据库开启CDC功能,具体开启方法可以参考etlcloud官网帮助文档。

二、配置数据源

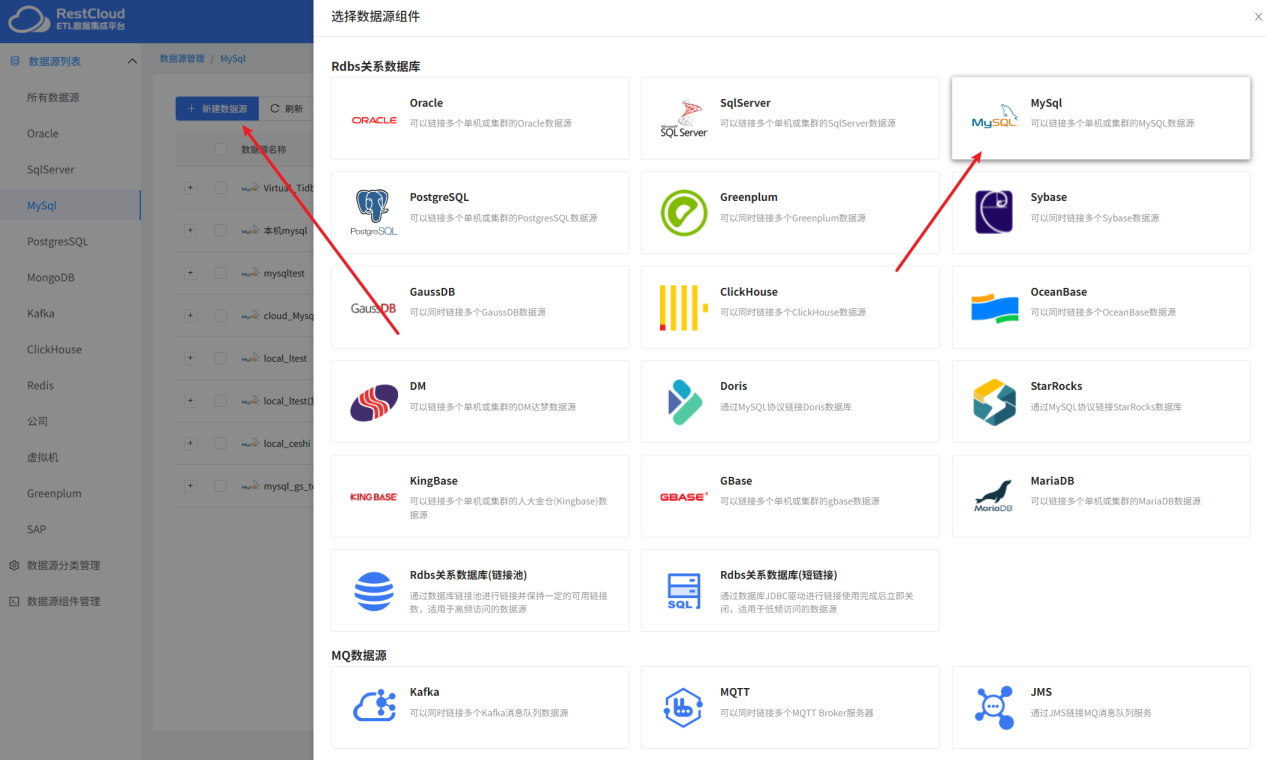

首先要配置好数据源,来到平台首页,进入数据源管理模块。

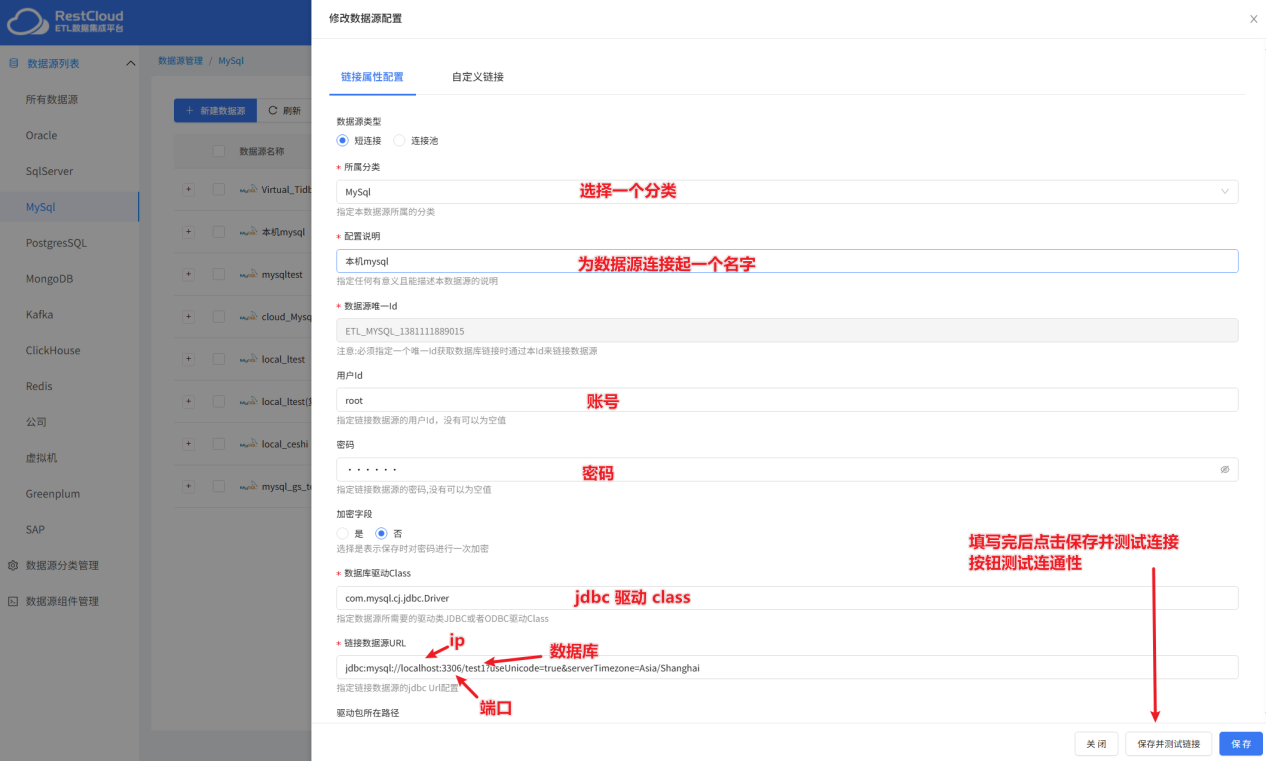

首先创建源端数据库的数据源,这里要监听mysql数据库,所以创建mysql的数据源。

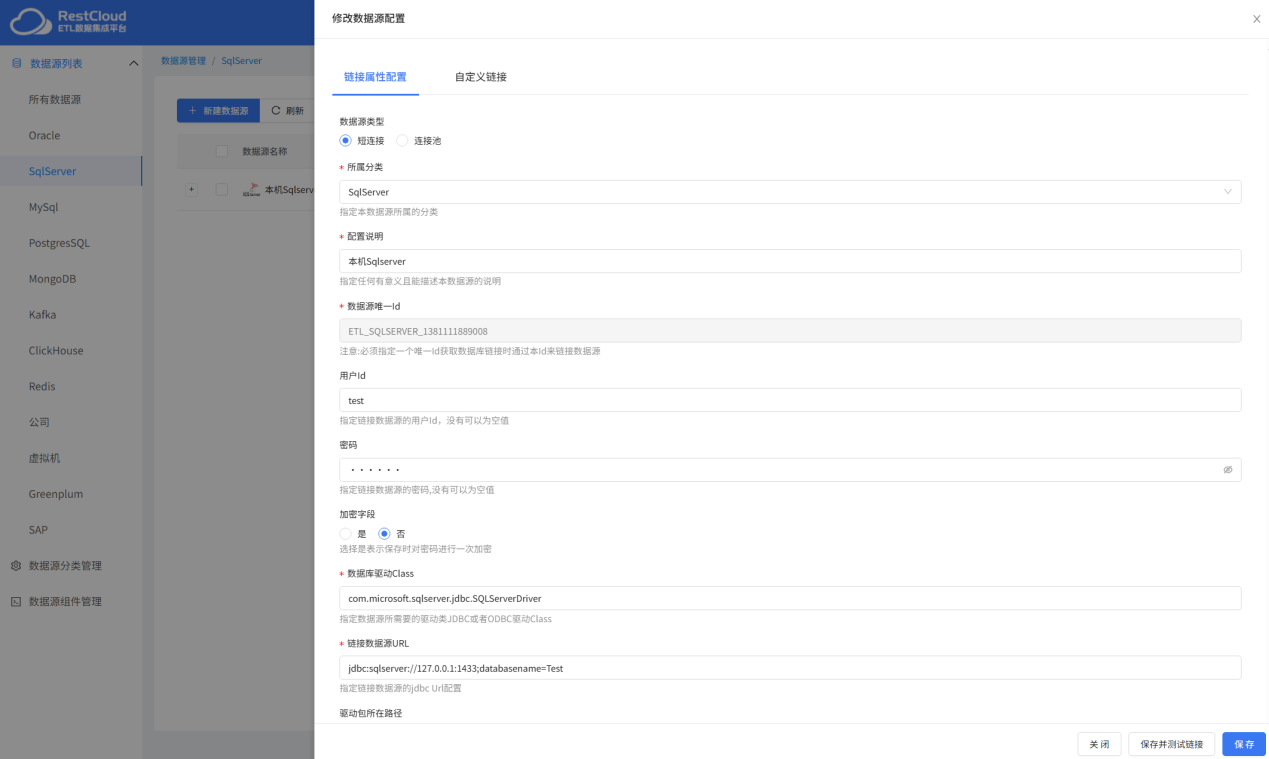

同理创建目标表的数据源链接,这里是sqlserver的数据源。

**二、**创建监听器

创建好数据源后,来到平台首页,进入实时数据集成模块,准备创建数据库监听器。

新建监听器,配置监听器。

启动配置好的监听器。

上面这种情况是做单纯的增量同步,但如果需要对数据进行处理的话,直接传输的模式就不适用了,需要使用传输到etl功能,比如需要监听源表变更的同时打宽源表的数据。

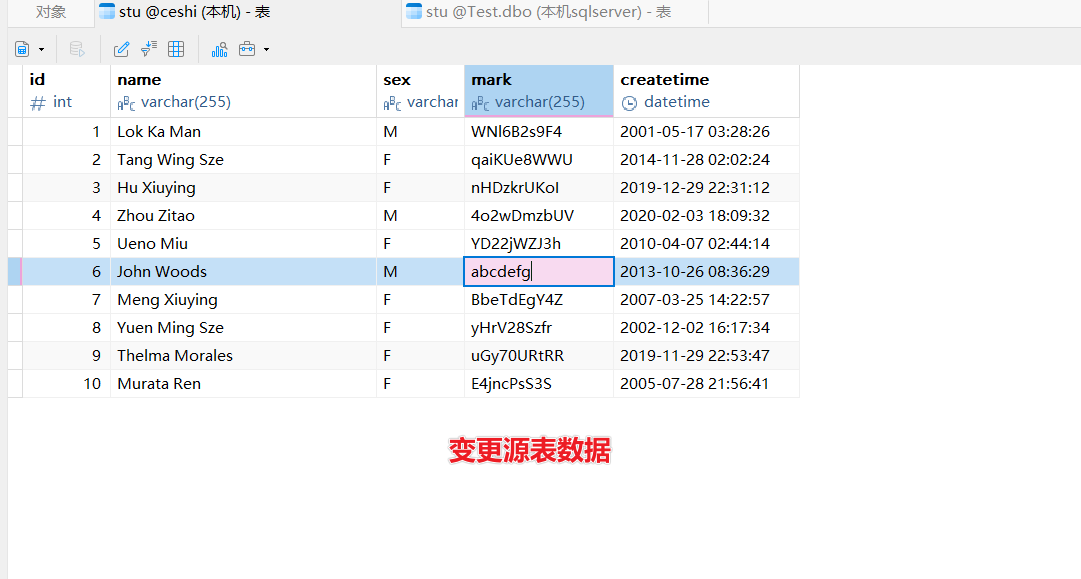

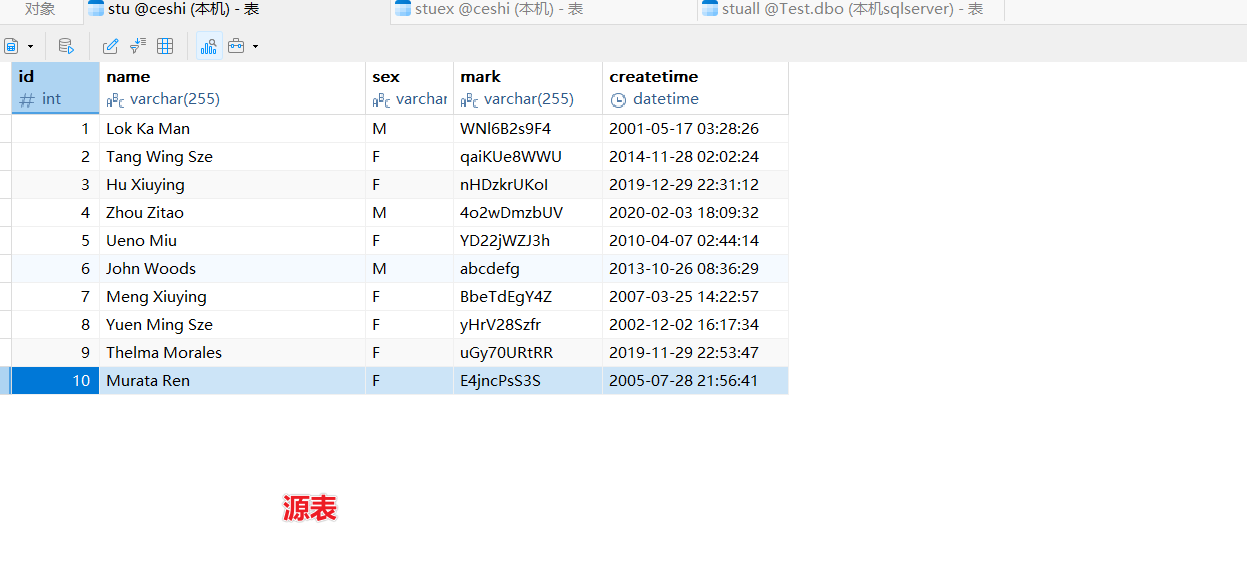

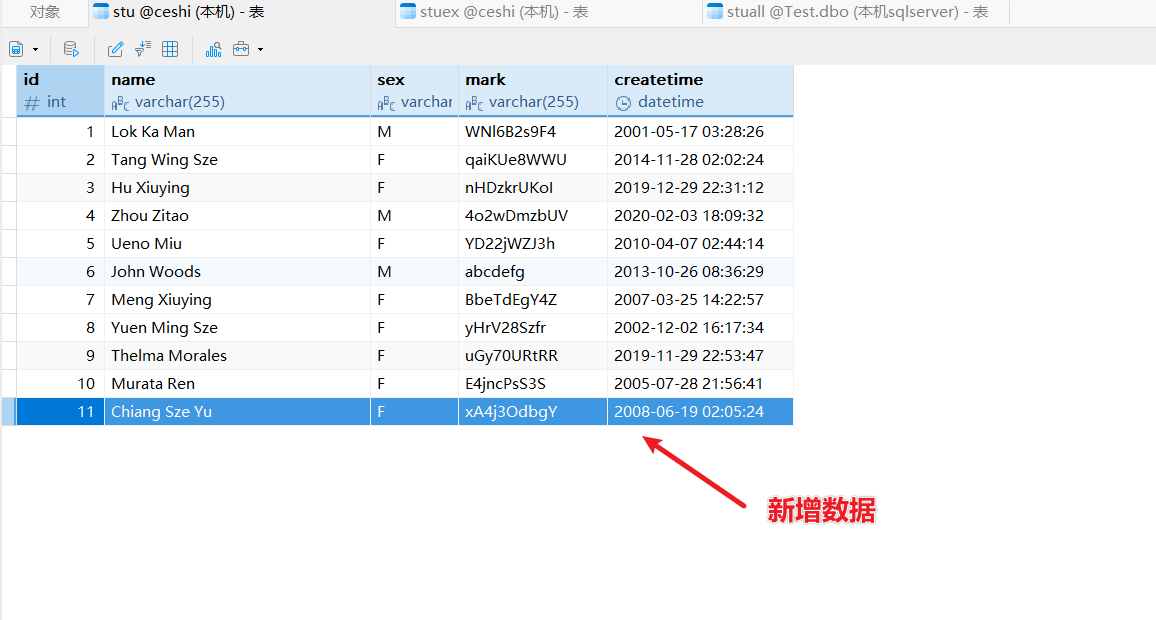

比如这是源表

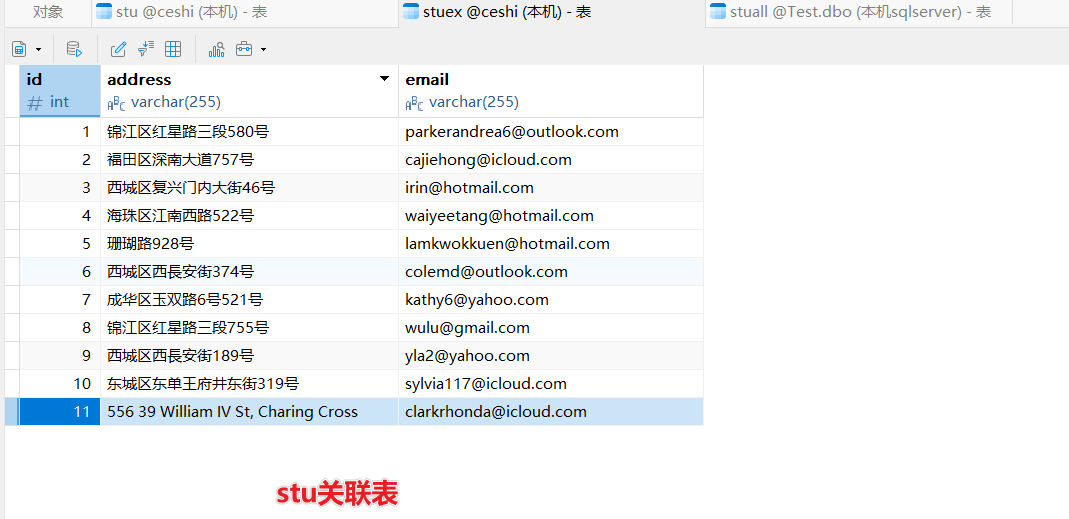

这是关联表

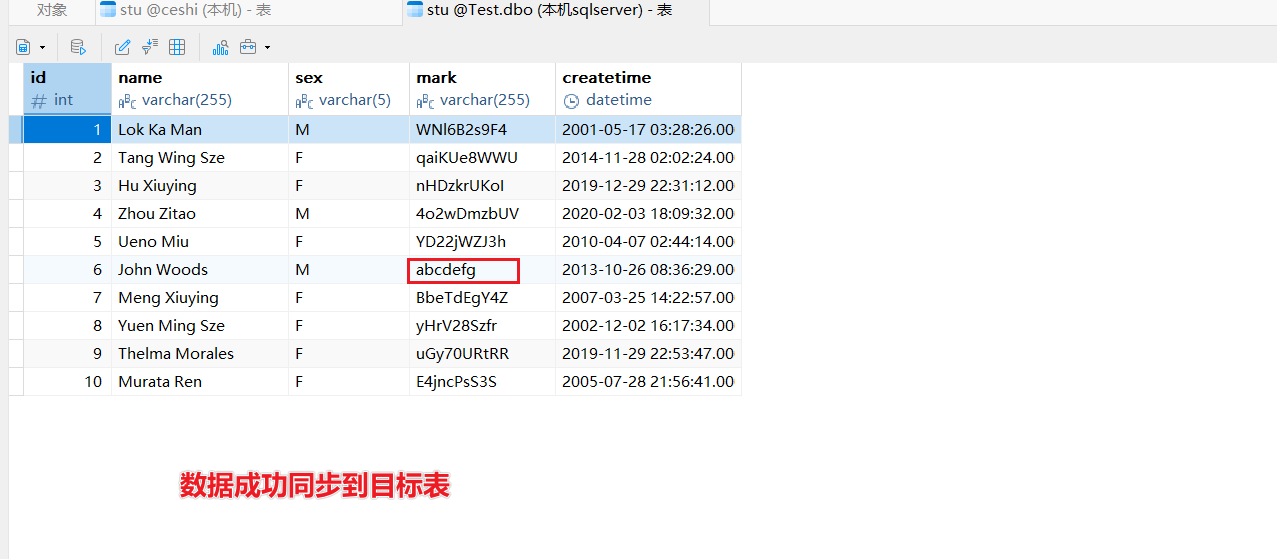

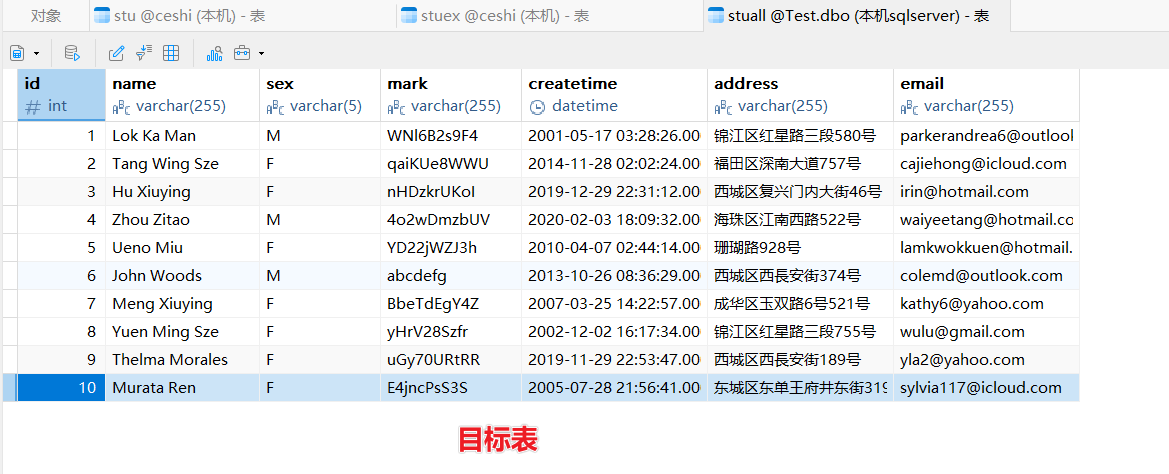

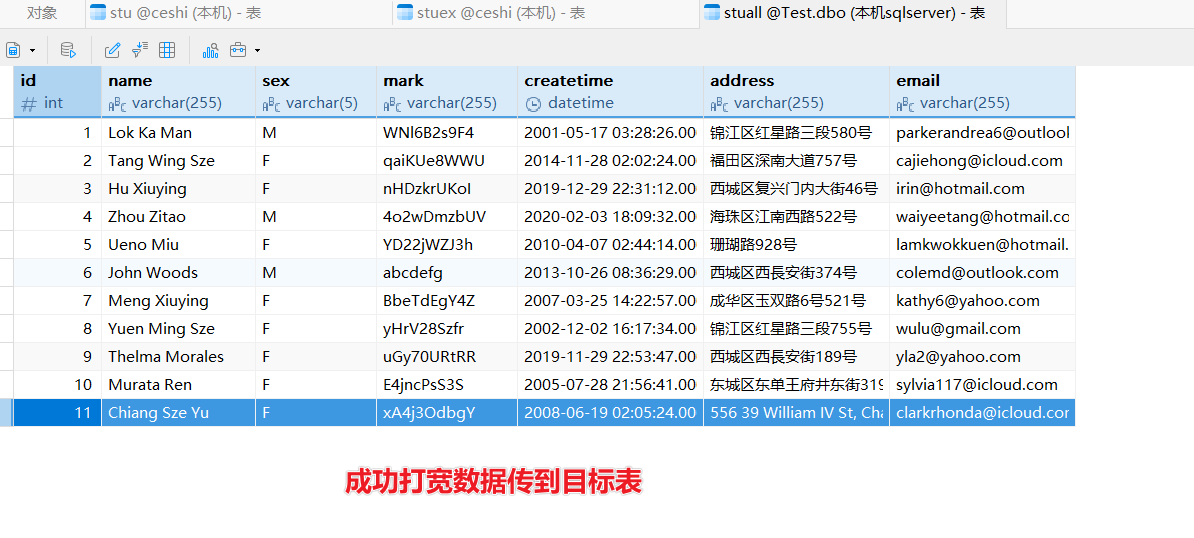

目标表数据:

目标表数据:

这里的需求是,源表监听到数据,要根据id字段值从关联表查出数据并进行leftjoin,最后把合并的数据输出到目标表。

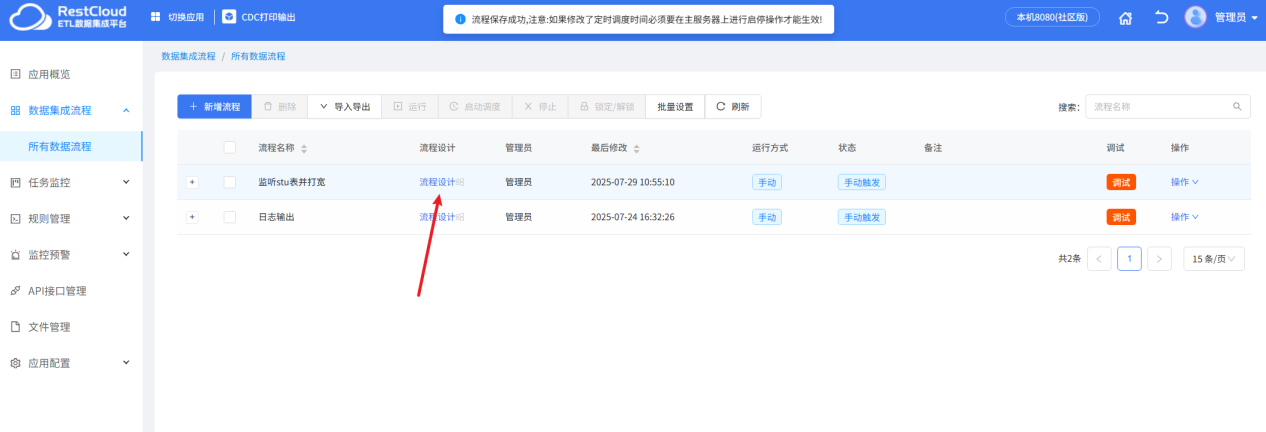

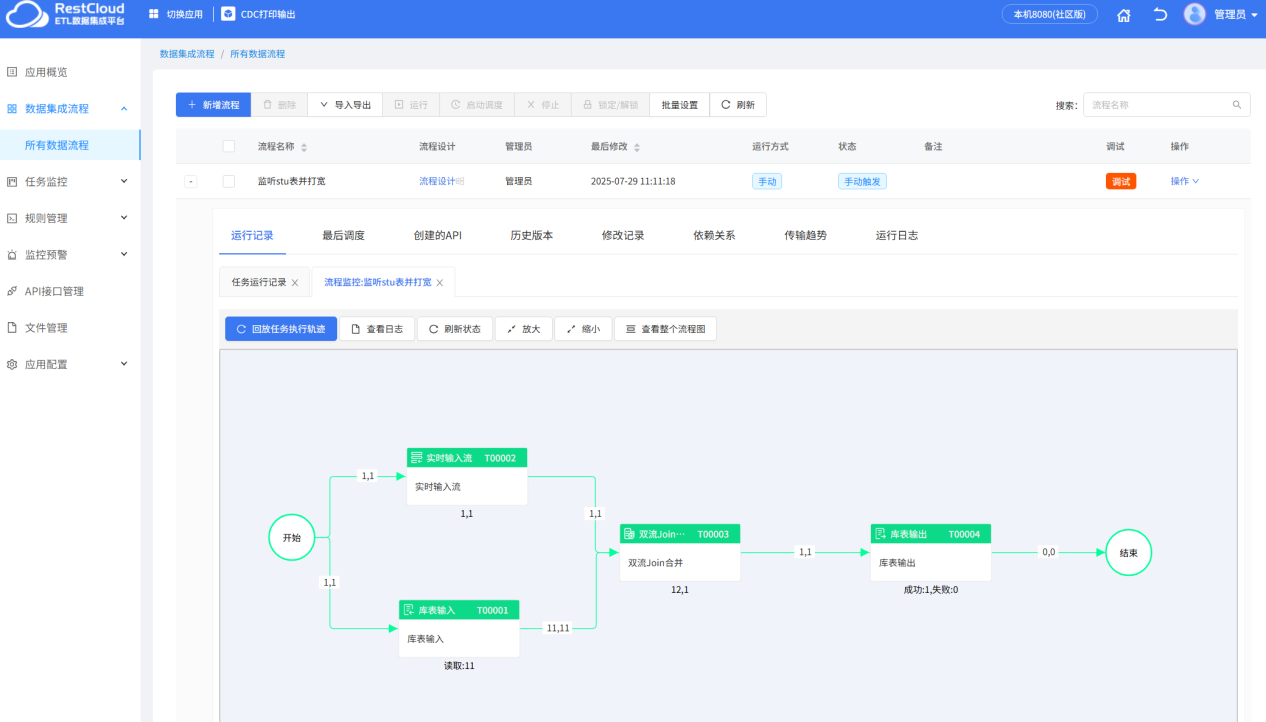

首先先在离线数据集成新建一个etl流程:

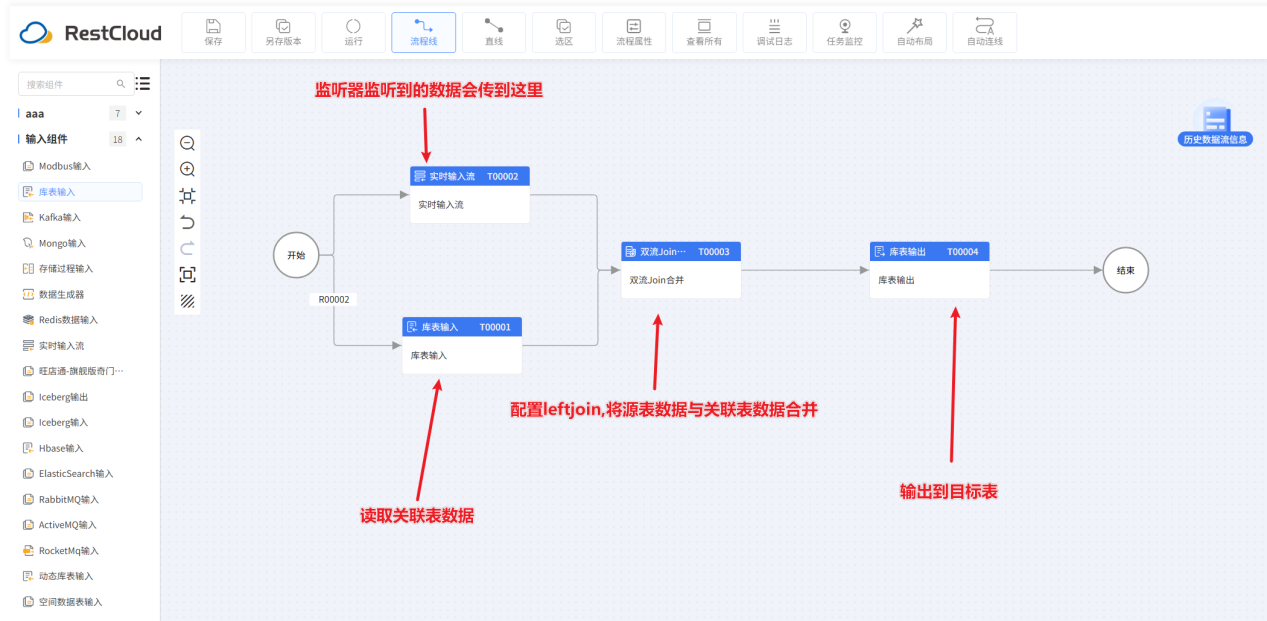

配置一个如图的流程:

双流join合并组件配置:

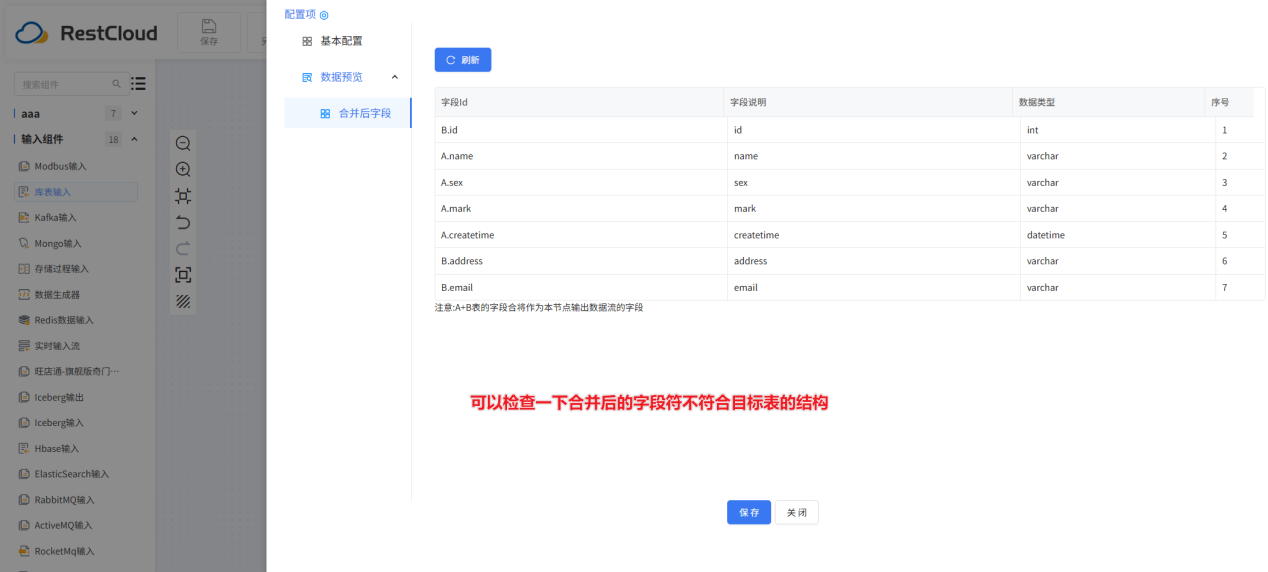

可以预览一下合并后的字段:

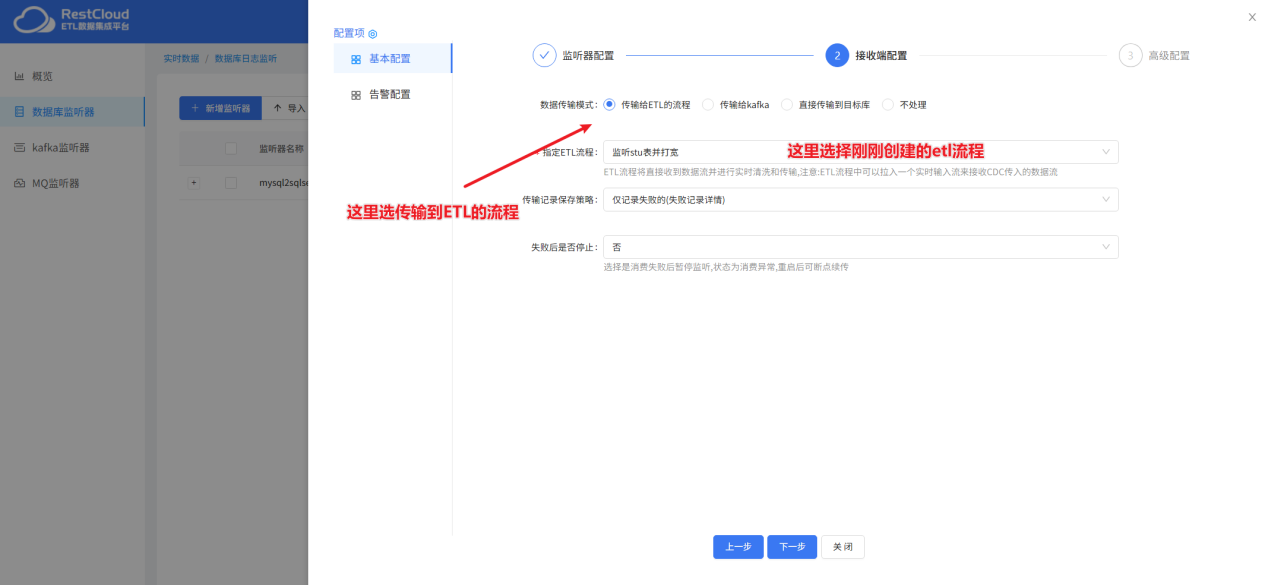

创建监听器:

配置完成后启动监听器:

源表新增一条数据:

来到etl流程页面

流程成功运行:

以上便是通过ETLCloud做数据监听的示例,如果源表和目标表的结构一致,我们可以选择监听器的直接传输方式,但当源表与目标表的结构不一致的情况下,可以使用传输到etl流程的方式,并在etl流程配置数据处理的流程。如果源表变更的数据量太大,平台处理速率跟不上的情况还可以选传输到kafka的方式,将变更的数据传到kafka里面再进行消费。