[Chat-LangChain] 前端用户界面 | 核心交互组件 | 会话流管理

链接:https://python.langchain.com/docs/tutorials/qa_chat_history/

Chat-LangChain技术栈 :

- LangChain

- LangGraph

- Next.js

- Weaviate (向量存储)

- OpenAI (嵌入模型)

docs:chat-langchain

Chat LangChain 是一个智能聊天机器人,专为解答LangChain技术文档相关问题设计。

它如同智能研究助手,首先将海量信息整合为可搜索知识库,随后通过AI核心处理模块(LangGraph)理解用户问题、检索相关细节并生成清晰专业的解答*。

该系统还集成可观测性工具实现持续优化。

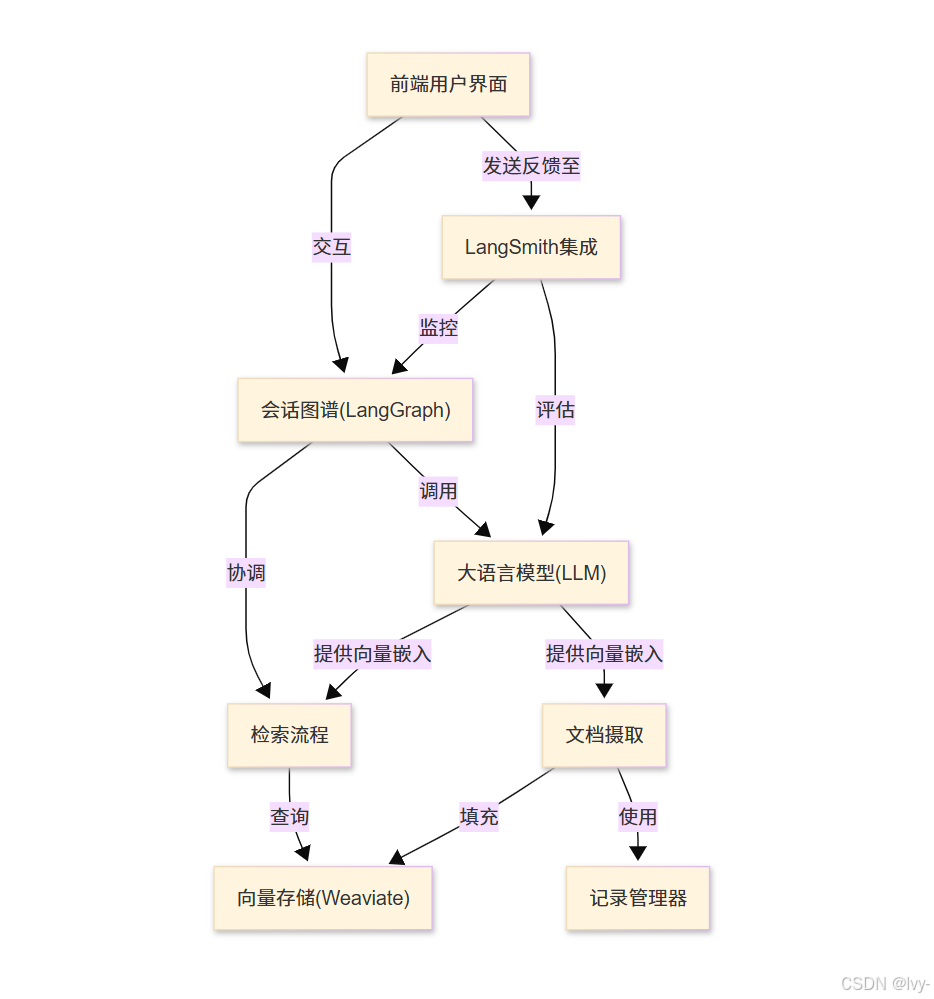

架构

章节导航

- 前端用户界面

- 会话图谱(LangGraph)

- 大语言模型(LLM)

- 检索流程

- 向量存储(Weaviate)

- 文档摄取

- 记录管理器

- LangSmith集成

第一章:前端用户界面

想象我们正在与一台超级智能机器人对话!

正如我们看到机器人的"面部"并听到其语音,聊天机器人也需要一个交互界面。这个"面部"或交互屏幕就是我们所说的前端用户界面。

chat-langchain项目这部分解决的问题很简单:如何让人轻松与聊天机器人交流并理解其行为逻辑?

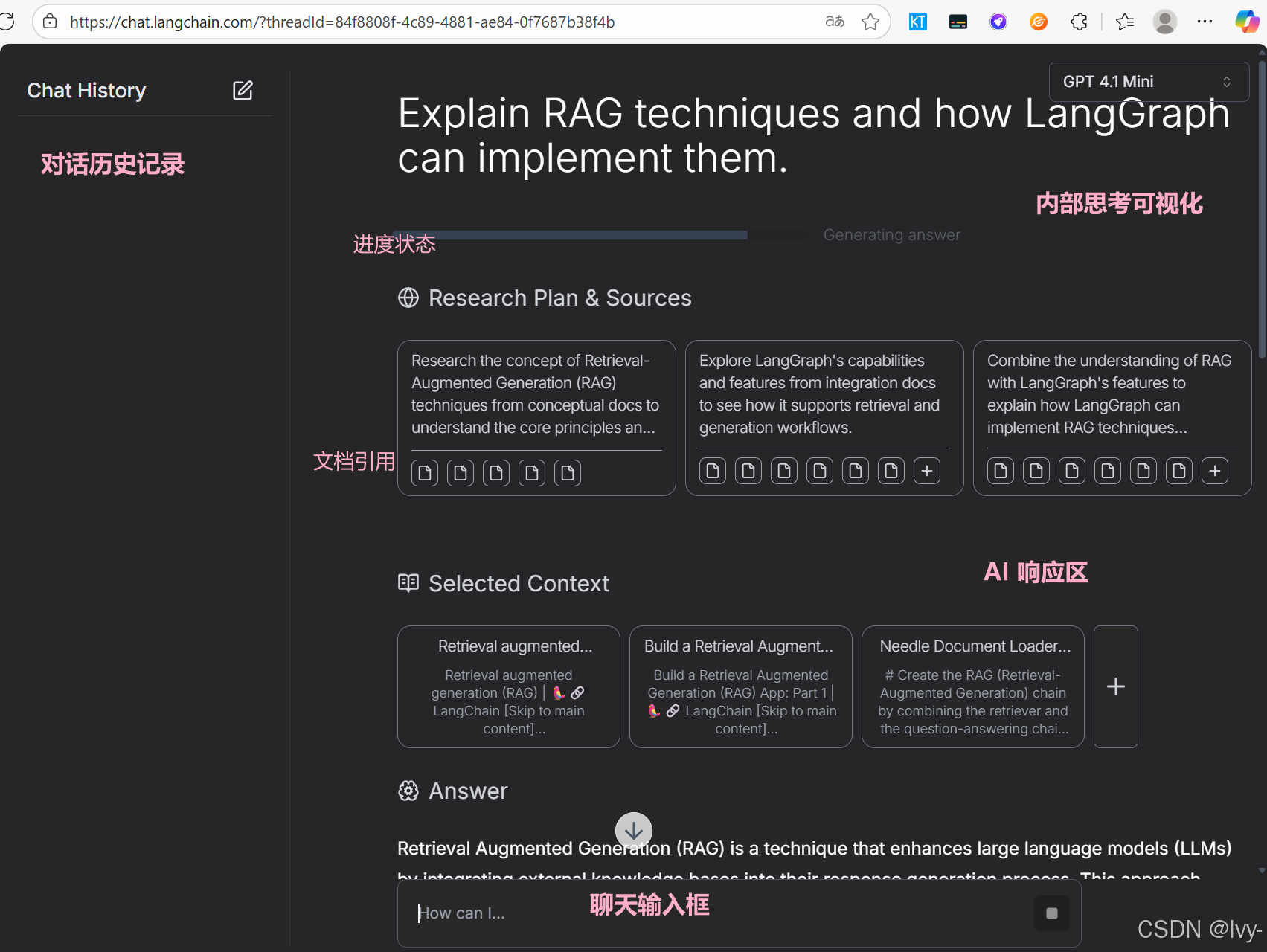

本章的目标是理解用户如何通过可视化界面与聊天机器人互动——从输入问题到获取答案,甚至观察机器人的"思考过程"。

何为前端用户界面?

前端用户界面(常简称为"前端"或"UI")可视为屏幕上的控制面板或聊天窗口,是用户直接交互的可视化部分。其核心功能包括:

- 聊天输入框:用户在此输入问题或消息,如同与机器人对话的"嘴巴"

- 对话历史记录:展示完整的聊天记录,形成对话"文字实录"

- AI响应区:显示机器人的回答内容

- 内部思考可视化:有时会展示后台处理过程,例如:

- 进度状态:显示"思考中"、“检索中”、"响应中"等状态提示

- 文档引用:当使用外部信息时显示参考文档来源

让我们通过chat-langchain的交互流程来具体理解。

首次交互指南

使用chat-langchain应用的典型流程:

- 启动应用:访问网站或打开应用程序

- 输入问题:在底部输入框键入内容,例如:“什么是LangChain?”

- 发送消息:点击回车键或发送按钮

- 获取响应:界面显示处理进度,最终呈现机器人的完整回答

这种流畅的交互体验完全依赖于前端用户界面的有效运作!

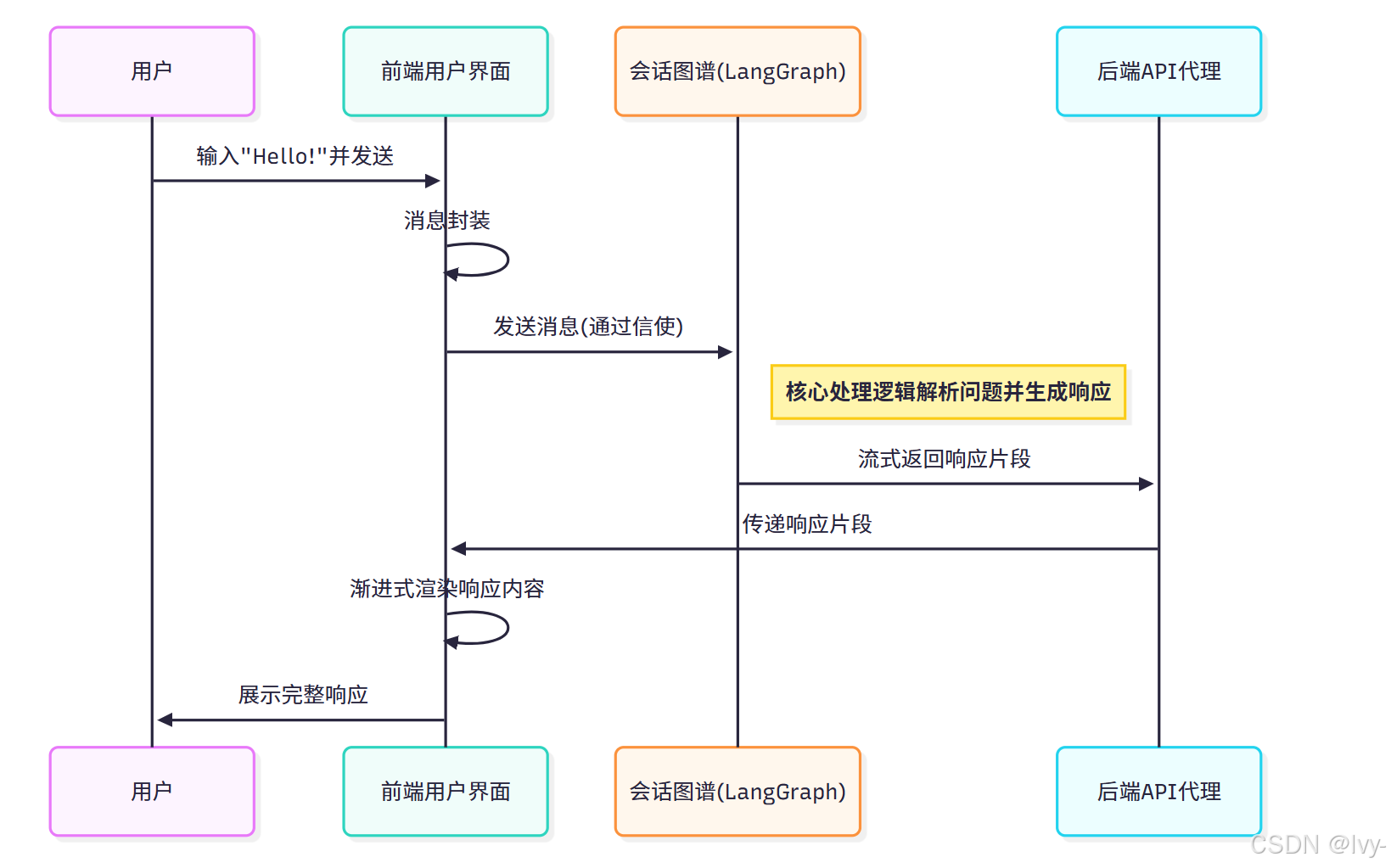

幕后流程:消息传递机制

当我们输入"Hello!"并发送时,后台将触发以下处理流程:

- 用户触发:在输入框完成内容输入

- 前端封装:界面代码识别操作并进行消息封装

- 核心处理:通过会话图谱(LangGraph)进行智能解析(下一章详述)

- 流式响应:后端通过API代理返回处理结果片段

- 实时渲染:前端逐步更新界面显示内容

现在让我们解析支撑这些功能的代码结构。

应用入口文件(frontend/app/page.tsx)

该文件作为应用的主入口,负责初始化聊天环境:

// frontend/app/page.tsx

"use client";import React from "react";

import { GraphProvider } from "./contexts/GraphContext";

import { ChatLangChain } from "./components/ChatLangChain";export default function Page(): React.ReactElement {return (<main className="w-full h-full"><React.Suspense fallback={null}>{/* GraphProvider注入核心数据处理逻辑 */}<GraphProvider>{/* ChatLangChain承载可视化聊天界面 */}<ChatLangChain /></GraphProvider></React.Suspense></main>);

}

其中GraphProvider作为数据引擎管理聊天逻辑,ChatLangChain作为可视化组件呈现交互界面,二者协同工作。

核心交互组件(frontend/app/components/ChatLangChain.tsx)

该组件实现消息收发与呈现的核心逻辑:

// frontend/app/components/ChatLangChain.tsx

"use client";import React, { useState } from "react";

import { AppendMessage, AssistantRuntimeProvider } from "@assistant-ui/react";

import { HumanMessage } from "@langchain/core/messages";

import { useGraphContext } from "../contexts/GraphContext";

import { ThreadChat } from "./chat-interface";function ChatLangChainComponent(): React.ReactElement {const { graphData } = useGraphContext(); // 获取数据上下文const { messages, setMessages, streamMessage } = graphData;const [threadId, setThreadId] = useState<string | null>(null); // 会话线程管理async function onNew(message: AppendMessage): Promise<void> {// 用户消息处理const humanMessage = new HumanMessage({ content: message.content[0].text });setMessages((prevMessages) => [...prevMessages, humanMessage]); // 更新消息列表await streamMessage(threadId!, { messages: [humanMessage] }); // 触发消息处理流}const runtime = { messages, onNew, isRunning: false }; // 运行时配置return (<div><AssistantRuntimeProvider runtime={runtime}>{/* 渲染聊天窗口组件 */}<ThreadChat submitDisabled={false} messages={messages} /></AssistantRuntimeProvider></div>);

}export const ChatLangChain = React.memo(ChatLangChainComponent);

onNew函数作为消息处理中枢:

- 将用户输入转换为标准消息格式

- 实时更新界面消息列表

- 调用流式消息处理接口

会话流管理(frontend/app/contexts/GraphContext.tsx)

该上下文管理完整的会话生命周期:

// frontend/app/contexts/GraphContext.tsx

import { createContext, useContext, useState } from "react";

import { AIMessage, BaseMessage, HumanMessage } from "@langchain/core/messages";

import { createClient } from "./utils"; // 服务端连接工具// ... 接口定义及其他依赖 ...export function GraphProvider({ children }: { children: React.ReactNode }) {const [messages, setMessages] = useState<BaseMessage[]>([]);const [isStreaming, setIsStreaming] = useState(false); // 流式状态标识const streamMessage = async (currentThreadId: string,params: { messages?: Record<string, any>[] },): Promise<void> => {const client = createClient(); // 建立服务连接// 初始化流式会话const stream = client.runs.stream(currentThreadId, "chat", {input: params, // 输入参数streamMode: "events", // 事件流模式});setIsStreaming(true); // 激活处理状态try {for await (const chunk of stream) {// 处理响应数据块if (chunk.data.event === "on_chat_model_stream") {const message = chunk.data.data.chunk;setMessages((prevMessages) => {// 动态更新消息内容const existingIndex = prevMessages.findIndex(msg => msg.id === message.id);if (existingIndex !== -1) {// 增量更新现有消息return [...prevMessages.slice(0, existingIndex),new AIMessage({ ...prevMessages[existingIndex], content: prevMessages[existingIndex].content + message.content }),...prevMessages.slice(existingIndex + 1)];} else {// 新增AI消息return [...prevMessages, new AIMessage({ ...message })];}});}// ... 其他事件处理 ...}} finally {setIsStreaming(false); // 终止处理状态}};// ... 上下文值传递 ...

}

streamMessage函数通过事件流机制实现:

- 建立与LangGraph服务的持久化连接

- 动态处理响应数据块

- 实时更新界面渲染状态

界面渲染引擎(frontend/app/components/chat-interface/index.tsx)

该组件实现可视化布局:

// frontend/app/components/chat-interface/index.tsx

"use client";import { ThreadPrimitive } from "@assistant-ui/react";

import { type FC } from "react";

import { AssistantMessage, UserMessage } from "./messages"; // 消息组件

import { ChatComposer } from "./chat-composer"; // 输入组件export interface ThreadChatProps extends ChatComposerProps {}export const ThreadChat: FC<ThreadChatProps> = (props: ThreadChatProps) => {const isEmpty = props.messages.length === 0;// 可视化增强钩子// useProgressToolUI(); // 进度指示// useSelectedDocumentsUI(); // 文档引用展示// useRouterLogicUI(); // 路由逻辑return (<ThreadPrimitive.Root className="flex flex-col h-screen overflow-hidden w-full">{!isEmpty ? (<ThreadPrimitive.Viewport className="flex-1 overflow-y-auto w-full">{/* 消息列表容器 */}<ThreadPrimitive.Messagescomponents={{UserMessage: UserMessage, // 用户消息样式AssistantMessage: AssistantMessage, // AI消息样式}}/></ThreadPrimitive.Viewport>) : null}{/* 输入框组件 */}<ChatComposer submitDisabled={props.submitDisabled} messages={props.messages} /></ThreadPrimitive.Root>);

};

组件架构包含:

- 响应式滚动容器

- 动态消息列表渲染

- 可扩展的可视化增强模块

消息呈现组件(frontend/app/components/chat-interface/messages.tsx)

定义具体消息样式:

// frontend/app/components/chat-interface/messages.tsx

"use client";import { MessagePrimitive, useMessage } from "@assistant-ui/react";

import { type FC } from "react";

import { MarkdownText } from "../ui/assistant-ui/markdown-text"; // Markdown渲染export const UserMessage: FC = () => {// 用户消息模板return (<MessagePrimitive.Root className="your-message-styling"><div className="bg-inherit text-white break-words"><MessagePrimitive.Content /></div></MessagePrimitive.Root>);

};export const AssistantMessage: FC = () => {// AI消息模板const isLast = useMessage((m) => m.isLast); // 末条消息标识return (<MessagePrimitive.Root className="ai-message-styling"><div className="bg-inherit text-white max-w-full break-words"><MessagePrimitive.Content components={{ Text: MarkdownText }} />{isLast && (// <FeedbackButtons /> // 反馈功能组件null)}</div></MessagePrimitive.Root>);

};

功能特性:

- 支持

Markdown语法渲染 - 消息内容自适应布局

- 扩展反馈功能接口

API代理服务(frontend/app/api/[..._path]/route.ts)

实现安全通信中转:

// frontend/app/api/[..._path]/route.ts

import { NextRequest, NextResponse } from "next/server";export const runtime = "edge"; // 边缘计算优化async function handleRequest(req: NextRequest, method: string) {try {const path = req.nextUrl.pathname.replace(/^\/?api\//, ""); // 路径解析const url = new URL(req.url);const options: RequestInit = {method,headers: {"x-api-key": process.env.LANGCHAIN_API_KEY || "", // 认证密钥},};if (["POST", "PUT", "PATCH"].includes(method)) {options.body = await req.text(); // 请求体处理}// 请求转发至核心服务const res = await fetch(`${process.env.API_BASE_URL}/${path}`, options);// 响应回传return new NextResponse(res.body, { status: res.status, headers: res.headers });} catch (e: any) {return NextResponse.json({ error: e.message }, { status: e.status ?? 500 });}

}// HTTP方法代理

export const GET = (req: NextRequest) => handleRequest(req, "GET");

export const POST = (req: NextRequest) => handleRequest(req, "POST");

// ... 其他方法代理 ...

代理层功能:

- 请求路径重定向

- 安全认证处理

- 异常状态拦截

- 协议方法适配

总结

-

Chat-LangChain是一个基于LangChain技术栈的智能聊天机器人,专为解答LangChain文档问题设计。

-

它采用

Next.js构建前端交互界面,通过Weaviate向量存储和OpenAI嵌入模型实现高效检索,并利用LangGraph进行核心对话处理。 -

系统架构包含用户界面、对话图谱、大语言模型、检索流程等模块,支持流式响应和思考过程可视化。

-

前端代码通过React组件管理消息传递和会话状态,后端则负责语义理解和知识检索,形成完整的问答系统。项目还集成了

LangSmith等工具进行性能监控和优化。

本章深入解析了chat-langchain的前端用户界面,揭示其如何通过可视化组件实现人机交互。

我们追踪了从用户输入到响应呈现的完整流程,剖析了核心代码模块的协作关系。尽管前端承担着界面呈现的重要角色,真正的智能处理依赖于会话图谱(LangGraph)这一"大脑",这将是下一章的重点解析对象。