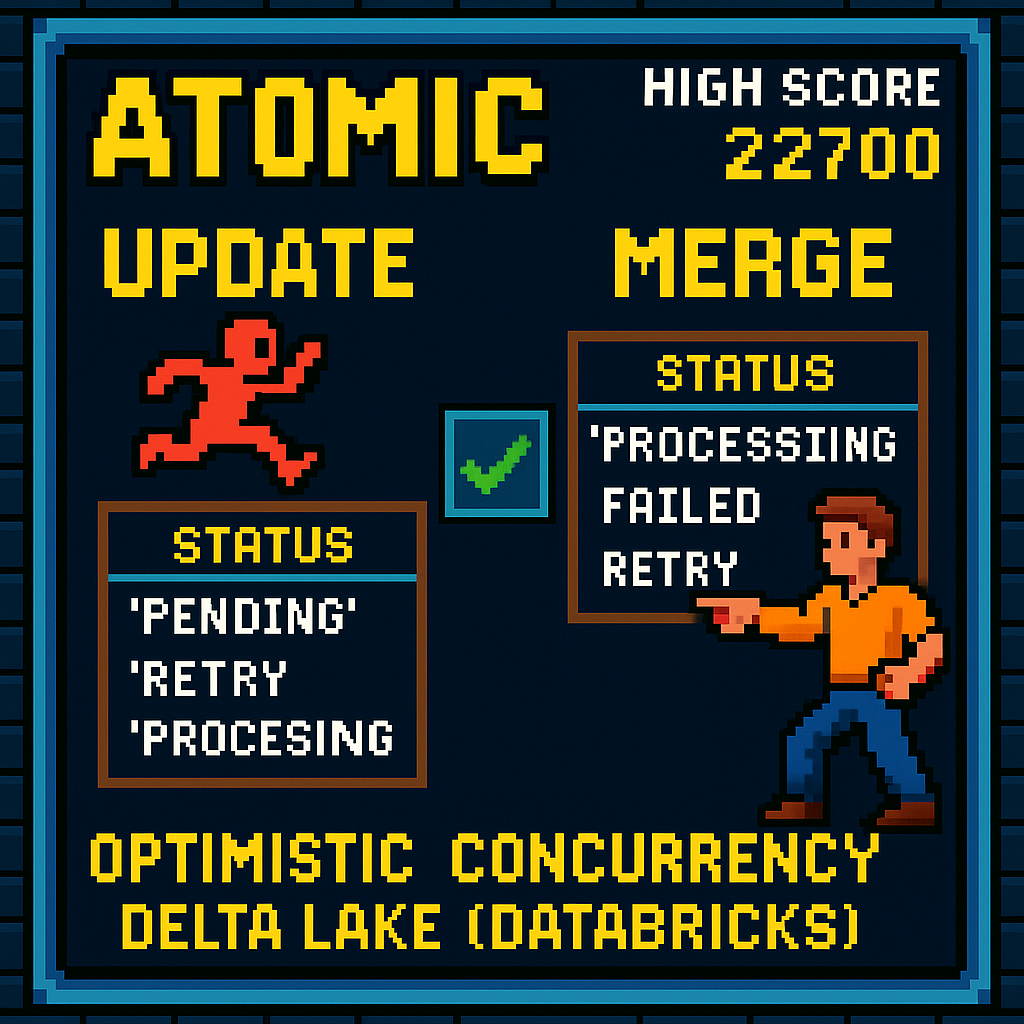

MERGE 语句在 Delta Lake 中的原子更新原理

MERGE 语句在 Delta Lake(Databricks 的 Delta 表格式)中用于实现原子(Atomic)更新,其核心原理基于 乐观并发控制(Optimistic Concurrency Control, OCC) 和 条件匹配机制,这使得它能够安全地处理并发冲突(race conditions),而不会像简单的 UPDATE 那样容易失败或导致数据不一致。下面我一步步解释其原理,以及为什么它比 UPDATE 更适合处理并发场景。

1. 数据库事务的基本概念:原子性与并发控制

- 原子性(Atomicity):这是 ACID(Atomicity, Consistency, Isolation, Durability)事务属性之一,意思是一个操作要么全部成功,要么全部失败,不存在中间状态。在 Delta Lake 中,所有写操作(如 UPDATE、MERGE)都是事务性的,确保数据一致性。

- 并发冲突(Race Conditions):在分布式系统如 Databricks 中,多个任务或作业可能同时访问同一张表。如果一个操作读取数据、计算更新,然后写入,但期间另一个操作修改了数据,就会导致冲突。例如,你的 UPDATE 试图将状态从 'PENDING' 或 'RETRY' 改为 'PROCESSING',但如果另一个作业(如超时重置任务)同时修改了同一行,就会触发 ConcurrentAppendException。

- Delta Lake 使用 乐观并发控制:它假设冲突很少发生,先执行操作,然后在提交时检查是否有冲突。如果有冲突,再重试或失败。这比悲观锁(Pessimistic Locking,如行级锁)更高效,因为它不阻塞其他操作。

2. UPDATE 语句的局限性及其易受赛条件影响的原因

- UPDATE 是简单的批量更新:它先扫描表,找到匹配谓词(predicate)的行,然后更新它们。

- 为什么易受赛条件影响:

- UPDATE 的执行过程分为读取(read)和写入(write)阶段。如果在读取后、写入前,另一个事务修改了同一分区的数据(例如,添加文件或更新行),Delta Lake 会检测到版本不匹配,导致 ConcurrentAppendException。

- 没有内置的条件检查机制来验证行在更新时是否仍处于预期状态(e.g., 'PENDING')。如果并发操作先修改了行,你的 UPDATE 可能覆盖它,导致数据丢失或不一致。

- 在你的代码中,UPDATE 是基于 iron_id 列表直接更新的,但如果并发操作(如重置超时记录)同时运行,它会干扰分区(如 updated_hour),造成追加冲突。

3. MERGE 语句的核心原理:原子条件更新

- MERGE 是 Delta Lake 的高级操作,类似于 SQL 的 UPSERT(Update + Insert),但在这里用于纯更新。它将 读取、条件检查和写入 合并成一个原子事务,确保操作的隔离性和一致性。

- 关键机制:

- 匹配条件(ON clause):指定如何匹配源表(source)和目标表(target)的行。在你的代码中,使用 ON target.iron_id = source.src_iron_id 来精确匹配记录。

- 条件动作(WHEN MATCHED AND <condition> THEN UPDATE)</condition>:这是 MERGE 的强大之处。它允许在匹配后添加额外条件检查(e.g., AND target.status IN ('PENDING', 'RETRY'))。只有当行当前状态仍符合预期时,才执行更新。如果并发操作已将状态改为其他值(e.g., 'FAILED'),MERGE 会自动跳过该行,而不会失败或覆盖。

- 原子执行:整个 MERGE 在 Delta Lake 的事务日志(Transaction Log)中作为一个单一版本提交。Delta Lake 使用 MVCC(Multi-Version Concurrency Control)来管理版本:

- 先读取表的当前版本(snapshot)。

- 计算更新(基于条件)。

- 在提交时,检查是否仍有冲突(e.g., 表版本是否改变)。如果无冲突,原子写入新版本;如果有冲突,Delta Lake 会自动重试(在某些配置下)或抛出异常,但由于条件检查,实际冲突率降低。

- 跳过机制的安全性:如果并发更新先发生,MERGE 看到的是更新后的行状态。如果不符合 AND 条件,它会安全跳过,不会修改行。这避免了数据覆盖,确保一致性(e.g., 不会将已重置的行强制改为 'PROCESSING')。

4. 为什么 MERGE 能减少冲突机会

- 降低冲突窗口:UPDATE 的谓词是静态的(e.g., based on iron_id and status),但如果并发修改了 status,UPDATE 可能仍尝试写入,导致异常。MERGE 的条件是动态检查的,在事务提交前验证状态,缩小了 "读取-写入" 间隙。

- 容错性:MERGE 内置处理部分失败(跳过不匹配行),而 UPDATE 是全或无(all-or-nothing),容易因单个分区冲突而整体失败。

- 性能与扩展:在大型表(如你的 40,000 条记录)中,MERGE 利用 Delta 的文件 compaction 和 Z-Ordering(如按 iron_id 排序)来高效扫描,只影响匹配分区。

- 与乐观控制的结合:如果仍发生版本冲突,Databricks 可以配置自动重试(e.g., spark.databricks.delta.retryOnConflict.enabled = true)。但 MERGE 的条件使大多数逻辑冲突被内部解决。

5. 潜在局限与最佳实践

- 局限:如果冲突非常频繁(e.g., 多个作业每秒更新同一分区),MERGE 仍可能抛出异常。这时,需要结合重试循环(如你之前的建议)。

- 最佳实践:

- 启用 Delta 配置:集群级别设置 spark.databricks.delta.merge.repartitionBeforeWrite.enabled = true 以优化大批量 MERGE。

- 监控历史:用 DESCRIBE HISTORY {iron_queue_table} 查看事务日志,分析冲突模式。

- 测试:用小批量测试 MERGE,确保在并发模拟下跳过正确。

- 如果表分区过多,考虑 OPTIMIZE 命令压缩文件,减少 IO 冲突。

总之,MERGE 的原理是通过原子事务 + 条件匹配来实现 "检查并更新"(Check-and-Set),这在并发环境中比 UPDATE 更鲁棒。它源于数据库的 CAS(Compare-And-Swap)模式,确保只有预期状态的行被修改,从而安全地处理赛条件。