第13章 AB实验平台的建设

AB实验平台的核心收益在于:

- 提升实验效率

- 通过自动化工具(如流量寻优、历史AA回溯)降低实验成本

- 支持分钟级监控与快速决策

- 保障结果可信度

- 内置SRM检查、显著性检验(P值/置信区间)

- 多层正交流量分配避免交叉污染

一、AB实验平台架构

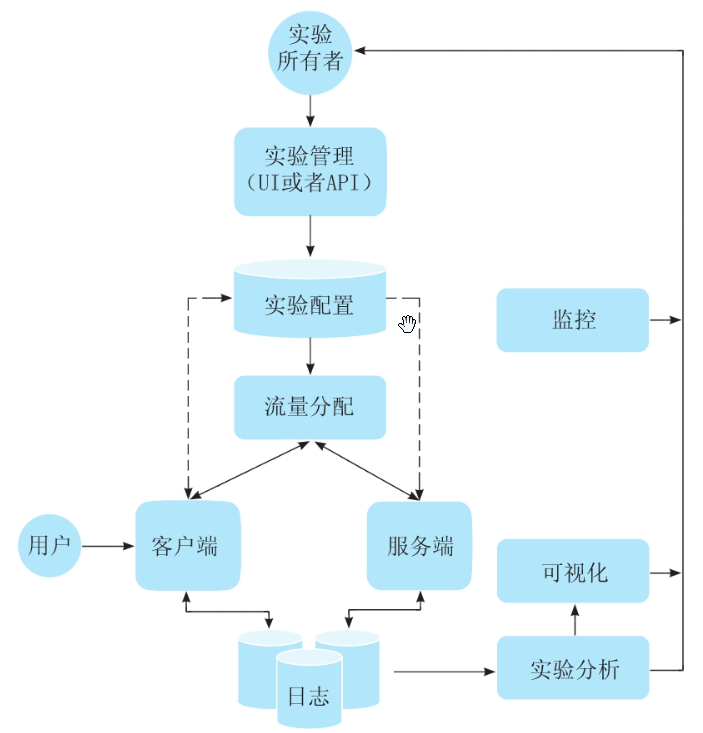

AB实验平台的交互过程:

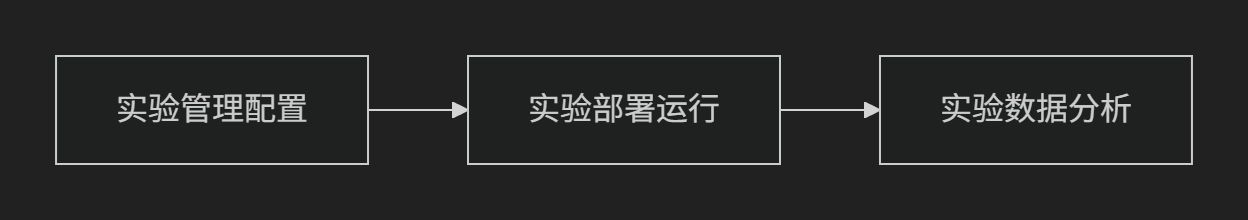

实验平台三阶段闭环:

核心功能集:

| 模块 | 关键能力 |

|---|---|

| 实验管理配置 | 实验元数据定义、流量预评估、策略参数化模板 |

| 实验部署运行 | 分层流量分配、客户端/服务端部署同步、跨平台ID一致性处理 |

| 实验数据分析 | 近实时监控、指标分层计算(DAU/留存等核心指标优先)、多维下钻分析 |

平台性能评估标准:

●稳:架构稳定、服务稳定、实验质量稳定。

案例:某电商大促期间,实验平台连续7天承载每秒10万级分流请求,零宕机,实验组/对照组流量偏差始终<0.5%。

●准:分流、指标、数据、分析准确。

案例:短视频APP通过哈希+正交分层算法,确保「青少年模式」实验组用户画像年龄100%符合18岁以下标准。

●易:便于进行各种实验管理、工具交互,实验容易创建、观测、评估和得出结论。

案例:新入职产品经理3分钟完成「搜索框颜色优化」实验创建,系统自动推荐点击率/停留时长核心指标模板。

●快:实验接入快,实验数据计算快,实验结果评估快。

案例:资讯类APP凌晨2点上线「推荐算法V2」实验,5分钟完成全量数据计算,显著效果当天决策全量上线。

●多:能快速支持多种场景、多种类型的多个实验。

案例:SaaS平台同时运行「定价策略」「UI改版」「API限流」等20+跨业务线实验,共享同一套分流底层。

附加要素:需支持实验沉淀(历史策略可回溯)、灰度放量(5%→100%渐进发布)、敏感数据脱敏(如GDPR合规审计)。

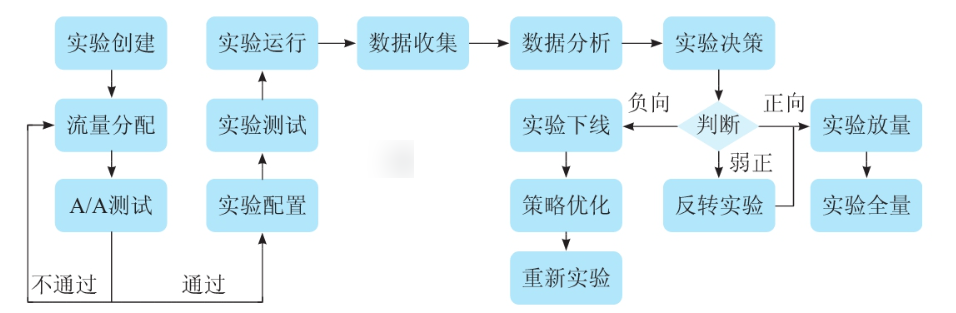

二、实验管理功能

AB实验流程:从实验创建开始,经过流量分配确保用户分组科学性,随后进行A/A测试验证系统稳定性;进入实验运行阶段后持续数据收集与分析,最终基于结果判断决策——若效果未达预期则进入实验下线或优化环节,若验证成功则推进至放量全量。各环节以箭头紧密衔接,形成从设计到验证的闭环流程体系,体现了实验驱动的科学决策路径。

1、 实验创建管理

实验创建管理是AB测试的核心环节,需要规范填写实验基础信息(名称、描述、类型等)和配置参数(层域、流量、目标人群、指标等)。实验名称应采用"场景_手段_目标"的统一格式,描述需包含假设和预期收益,类型通过多标签分类管理。

关键配置包括:基于业务需求选择实验层域并计算最小流量,提前圈选特定人群确保分流均匀,按指标重要性分级分组勾选(如核心指标默认计算)。

所有信息需支持可追溯的版本管理,以提升实验效率和分析可靠性。

(1)拆解实验创建管理

概念:实验创建是AB测试的"实验设计书",需用最简语言表达完整实验逻辑。

检验标准:能否让新人用1分钟看懂:

- 要解决什么问题(场景)

- 怎么解决(手段)

- 如何衡量效果(指标)

案例对比:

❌ 模糊描述:"测试新按钮颜色对用户的影响"

✅ 清洗表述:"购物车页-将结算按钮从浅灰(#CCCCCC)改为深红(#FF0000)-验证点击率提升5%"

(2)核心字段详解

| 字段 | 费曼式解释 | 电商案例(优惠券实验) | 工具类案例(通知推送实验) |

|---|---|---|---|

| 实验名称 | 场景+手段+目标 | 支付页_满100弹券_提升客单价 | 消息页_红包图标强提醒_提升打开率 |

| 实验描述 | 假设+预期+文档链接 | 假设:用户对显性优惠更敏感→预期客单价提升8%→[需求文档链接] | 假设:视觉强化能突破通知疲劳→预期打开率提升15%→[PRD链接] |

| 实验类型 | 用标签快速归类 (方便团队的实验管理、实验沉淀、实验检索) | 服务端实验+促销策略+转化漏斗 | 客户端实验+UI优化+留存 |

| 层域选择 | 流量隔离不打架 | 复用"支付流程层"剩余30%流量 | 独占"消息通知层"全量流量 |

| 指标配置 | 像点菜一样勾选指标组 | 核心:支付成功率;辅助:客单价、退款率 | 核心:通知打开率;辅助:次日留存 |

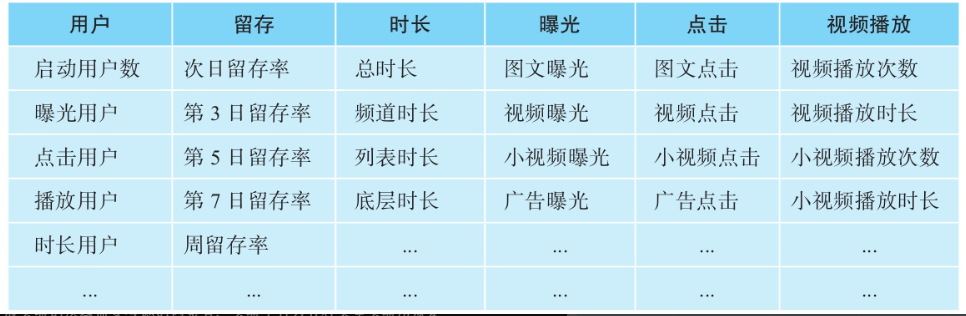

AB实验指标配置

1. 用户指标组 → 勾选"启动用户数"+"播放用户数"

2. 留存指标组 → 全选(次日/3日/7日留存率)

3. 视频指标组 → 仅勾选"视频播放次数"(节省计算资源) (3)避坑指南

-

流量分配陷阱

- 问题:同时运行"首页改版"和"搜索算法"实验,共用默认层导致交叉污染

- 解法:建立正交层域,或使用分层哈希技术

-

指标过载陷阱

- 反例:新手勾选图中全部50+指标 → 结果计算延迟24小时

- 黄金法则:核心指标 ≤3个(必须计算) ,辅助指标 ≤5个(按需勾选) ,探索性指标离线补算

-

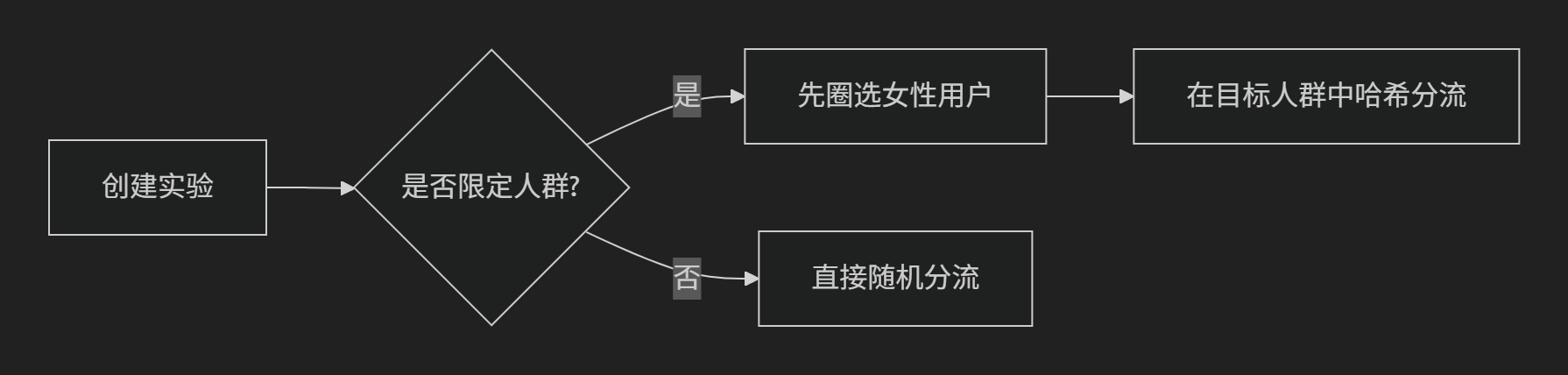

人群圈选陷阱

- 错误操作:先随机分流再筛选"女性用户" → 导致组间样本不均衡

- 正确流程:

(4)行业最佳实践

命名规范

互联网大厂通用模板:[模块]_[策略版本]_[目标指标]

示例:

信息流_多模态排序V2_人均时长

指标分级

图中表格的智能用法:

def select_metrics(experiment_type):if experiment_type == "UI优化":return ["点击率", "页面停留时长"] # 视觉类核心指标elif experiment_type == "算法迭代":return ["CTR", "转化率"] # 效果类核心指标文档沉淀

- 实验描述字段直接关联Confluence/飞书文档

- 自动生成实验ID:

EXP_20230725_001(日期+序号)

(5)检验理解

✍️ 练习题:假设你要优化一个在线教育的"课程购买页",请设计实验创建字段:

- 实验名称:

课程页_价格锚点设计_提升转化率 - 核心假设:价格对比设计能减少决策犹豫

- 必选指标:点击用户数+图文点击率

2、 实验配置管理

实验配置管理核心是确保流量分配均匀(通过AA测试验证)和策略配置准确。先进行3天以上的AA测试验证组间可比性,失败时需重新分配或使用流量寻优算法;通过后配置实验组策略(如A/B/B1),采用参数化模板降低错误率;最后通过日志检测和白名单测试双重验证配置正确性,所有修改记录需完整留存。

描述了互联网产品进行AB测试(也称为分组实验)时的实验配置管理流程,特别是流量分配和参数配置两个关键环节。

1. 流量分配与AA实验

- 目的:确保实验组和对照组的用户分布均匀,排除流量偏差对结果的干扰。

- 流程:

- 初始分配:根据实验请求信息随机分配流量(如50%用户进对照组A,50%进实验组B)。

- AA测试:所有组均使用基线策略(无差异),持续至少3天,检验用户行为数据(如点击率、停留时长)是否无显著差异。

- 问题处理:若AA不通过(如某组用户活跃度异常),需重新分配流量,直到通过。

- 优化措施:

- 历史数据回溯:快速验证流量分布,缩短AA周期。

- 流量寻优:调整随机算法(如分层抽样)提高均匀分配概率,减少重复分配次数。(流量寻优是AB测试中用于提高流量分配效率的技术手段,目的是通过算法调整,减少随机分配导致的流量分布不均问题,从而降低需要重复分配流量的概率(即减少AA实验失败的次数)。)

2. 实验配置阶段

- 核心操作:将AA测试的组别转为真实的AB测试策略:

- 保留对照组A(基线策略)。

- 实验组配置为B、B1、B2等(不同待测策略)。

- 关键参数:需配置算法策略(召回、排序)、用户画像、功能开关等。

- 防错设计:

- 模块化模板:参数化配置,避免重复劳动。

- 冲突检测:防止策略冲突(如同时修改同一参数)。

- 版本记录:保留参数修改日志,支持回溯。

3. 实验前检测

- 系统接口检测(服务端验证):验证服务日志是否正常(如请求是否成功下发)。(例如:电商平台修改了搜索排序策略,需检测搜索服务是否实际使用了新参数,而非仍沿用旧配置。)

- 白名单体验检测(用户端验证):通过指定设备模拟用户操作,检查前端逻辑(如按钮是否显示异常)。(例如:社交APP测试新评论功能,需通过白名单账号发布评论,验证能否正常显示、删除或回复。)

- 通过标准:两项检测均无问题后,实验正式上线。

为什么必须检测?

避免配置错误。参数可能因人工输入错误、系统同步延迟等原因未生效,直接上线会导致实验失效。案例:某次实验误将“折扣率10%”配成“100%”,因未检测直接上线,导致全场商品免费。

防止逻辑冲突。多个实验可能修改同一参数(如首页排序规则),需检测是否冲突。案例:A实验修改了搜索算法,B实验同时调整了搜索结果页UI,未检测导致页面崩溃。

保障用户体验。明显的交互问题(如按钮无法点击)会伤害用户,检测可提前拦截。

4. 工具支持

- 参数对比工具:便于多实验组间快速对比差异(如B组与B2组的排序权重)。

- 灵活调整:实验中途可修改参数,但需记录变更并评估影响。

5. 总结

这一流程通过严格的流量分配、参数化配置和双重检测机制,确保AB测试的科学性(数据可信)和高效性(减少人工错误)。例如,电商平台通过此流程可验证"新推荐算法是否提升转化率",同时避免因配置错误导致线上事故。

3、 实验操作管理

在AB测试的实验阶段,需要系统化地管理实验的运行、监控、分析和决策,确保实验结果的可靠性和可操作性。

1. 实验操作

(1) 异常处理与实验暂停

- 异常场景:

- 实验数据显著偏离预期(如转化率骤降50%)。

- 用户反馈集中投诉(如新功能导致页面卡顿)。

- 技术故障(如服务崩溃、数据上报丢失)。

- 操作流程:

- 立即暂停实验:停止流量分配,回滚至基线策略(对照组A)。

- 问题排查:分析日志、用户行为路径或技术指标(如接口耗时)。

- 修复后重新测试:通过白名单验证问题是否解决,重新启动小流量实验。

(2) 反转实验

- 目的:排除非策略因素(如人群偏差、季节性影响)对结果的干扰。

- 方法:将原实验组(B)和对照组(A)的策略对调(B→A,A→B),其他条件不变,对比两次实验的数据趋势是否一致。

- 示例:首次实验显示B组转化率比A组高10%,反转后若A组(原B策略)仍高10%,则证明策略有效;若差异消失,可能是人群偏差导致。

2. 实验流量管理

- 原则:实验期间避免调整流量分配比例(如从50%/50%改为70%/30%),否则会引入时间维度偏差。

- 正确做法:

- 若流量分配不符合预期(如某组用户量过少),应停止实验,重新设计分流规则后再启动。

- 特殊情况下需调整流量时,需记录变更时间点,并在分析阶段分段评估数据。

3. 实验监控与通知

(1) 监控指标

- 核心指标:转化率、留存率、GMV等业务指标。

- 辅助指标:

- 技术指标:接口成功率、延迟、错误率。

- 用户反馈:负面评论、客服工单量。

(2) 告警机制

- 自动告警:当指标超出阈值(如转化率下降超过5%)时,触发邮件/钉钉通知。

- 人工标记:实验人员可手动标记异常状态,并添加备注说明原因。

4. 实验选择与查找

- 功能需求:

- 筛选:按业务线、负责人、实验状态(运行中/已结束)过滤。

- 搜索:通过实验ID或关键词(如“推荐算法”)快速定位。

- 收藏夹:高频关注的实验可加入个人收藏,避免重复查找。

- 意义:提升团队协作效率,尤其适用于多实验并行的复杂场景。

5. 实验分析

(1) 统计方法选择

- 显著性检验:常用T检验(正态分布)或Mann-Whitney U检验(非正态)。

- 置信度:通常要求95%以上(p-value <0.05)。

- 功效(Power):确保样本量足够检测到最小显著差异(如80%功效)。

(2) 分析维度

- 全局效果:实验组 vs 对照组的整体差异。

- 分群分析:按用户画像(如新/老用户)拆解效果,避免“平均掩盖真相”。

6. 实验报告与决策

(1) 报告内容

- 核心结论:策略效果(如B组GMV提升+7.2%,p=0.01)。

- 支持数据:显著性检验结果、分群分析、反转实验验证。

- 风险提示:潜在负面影响(如B组用户投诉率增加)。

(2) 决策流程

- 小流量验证:通过5%流量实验确认效果。

- 逐步放量:按20%→50%→100%分阶段扩量,监控指标波动。

- 全量上线:实验效果达标后,全量推送新策略。

- 紧急回滚:若放量阶段出现异常,立即回退至旧版本。

7. 关键注意事项

- 逐步放量:避免直接全量,降低风险。

- 反转实验:重要实验必须通过反转验证,排除偶然性。

- 避免