【完整源码+数据集+部署教程】乡村道路植物与障碍物识别图像分割系统源码和数据集:改进yolo11-OREPA

背景意义

研究背景与意义

随着全球城市化进程的加快,乡村地区的生态环境和交通安全问题日益凸显。乡村道路作为连接城乡的重要通道,其安全性和通行能力直接影响到农村经济的发展和居民的生活质量。因此,开发高效的道路监测与管理系统显得尤为重要。近年来,计算机视觉技术的快速发展为乡村道路的植物与障碍物识别提供了新的解决方案。尤其是基于深度学习的图像分割技术,能够在复杂环境中实现高精度的目标检测与识别。

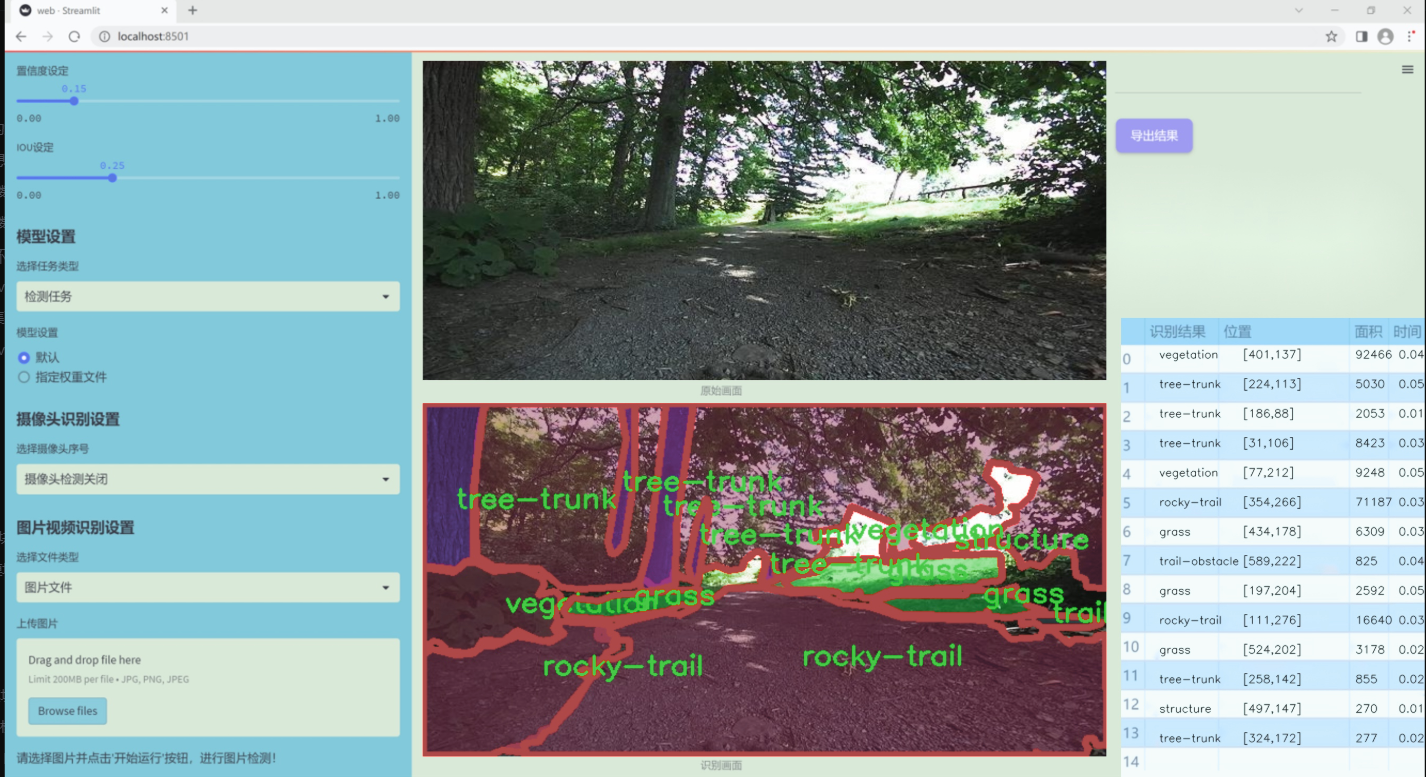

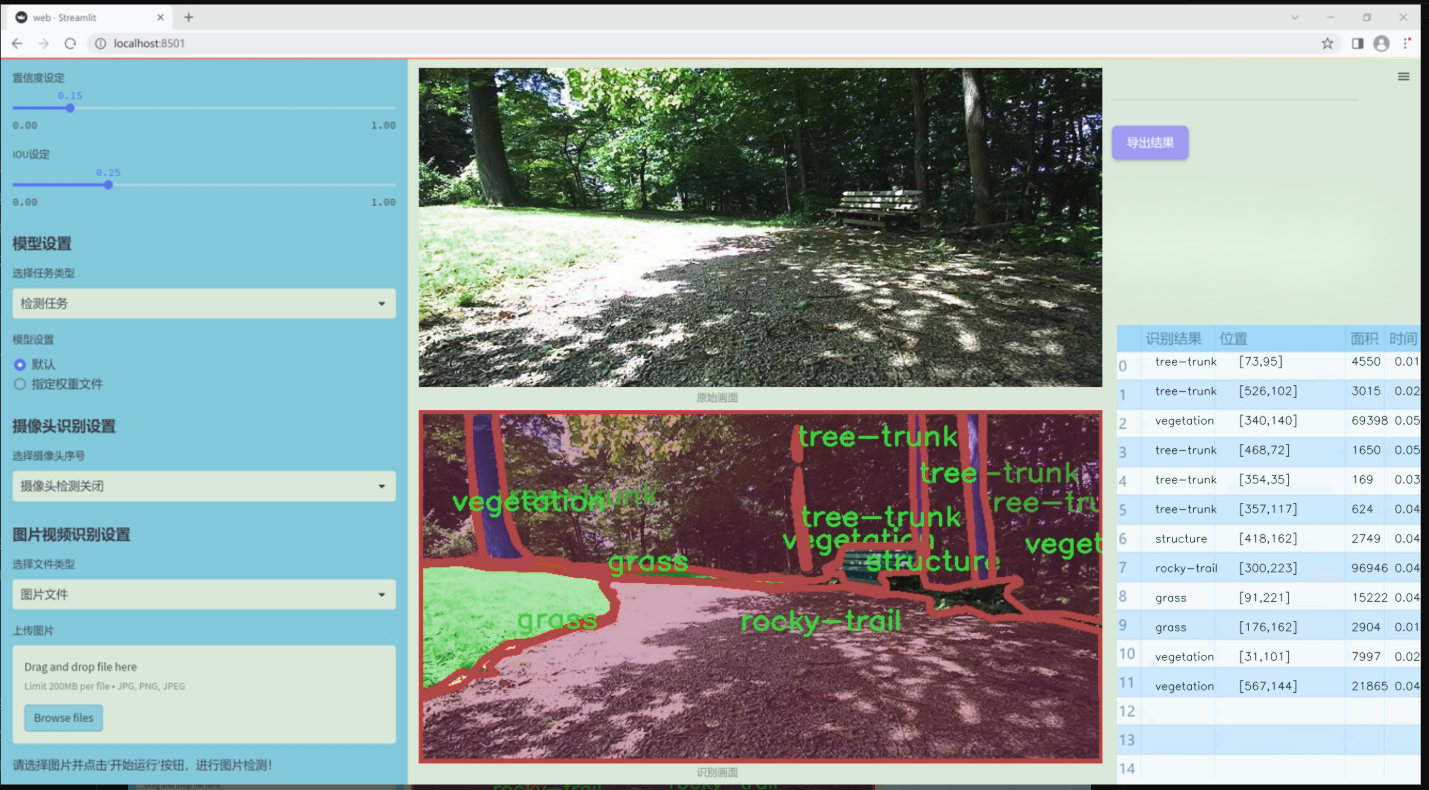

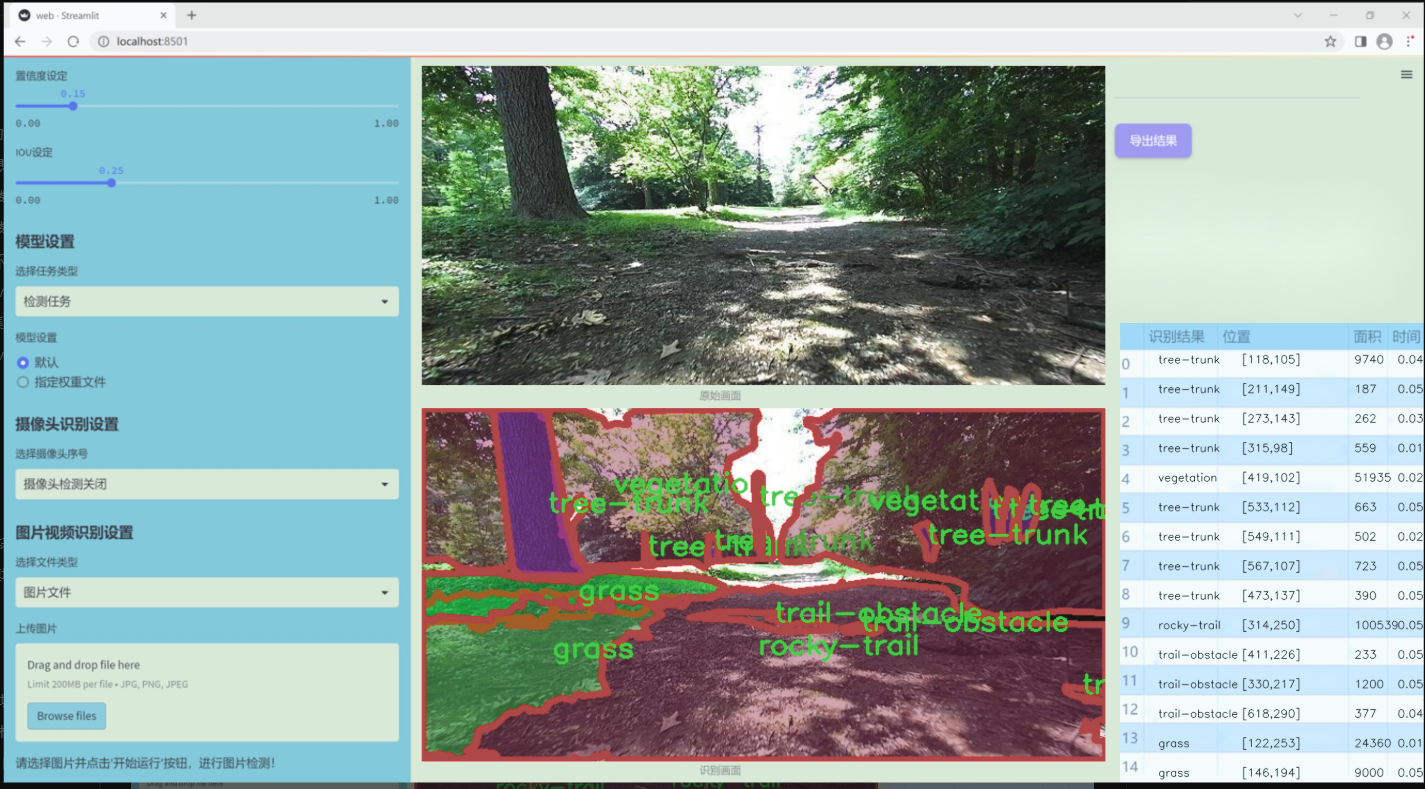

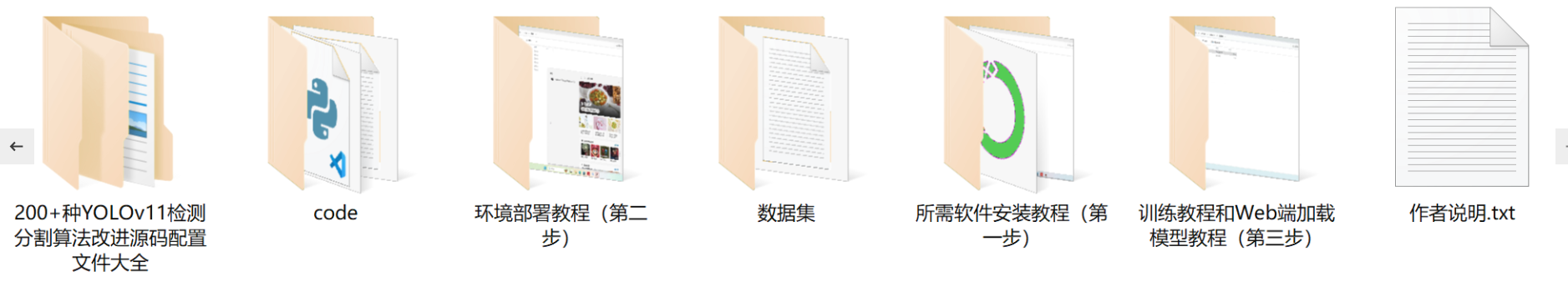

本研究旨在基于改进的YOLOv11模型,构建一个专门针对乡村道路植物与障碍物的识别图像分割系统。该系统将利用一个包含1300张图像的数据集,涵盖草地、岩石小径、粗糙小径、结构物、道路障碍物、树干和植被等七个类别。这些类别的选择不仅反映了乡村道路环境的多样性,也为系统的实际应用提供了丰富的场景支持。通过对这些图像的深度学习训练,系统将能够有效识别和分割出不同类型的植物与障碍物,从而为乡村道路的管理和维护提供科学依据。

此外,乡村道路的植物与障碍物识别系统的建立,能够为生态保护、交通安全、灾害预警等方面提供重要的数据支持。通过实时监测和分析道路环境,能够及时发现潜在的安全隐患,减少交通事故的发生。同时,该系统的应用还可以为乡村环境的可持续发展提供技术保障,促进人与自然的和谐共生。因此,本研究不仅具有重要的学术价值,也具有广泛的社会应用前景。

图片效果

数据集信息

本项目数据集信息介绍

本项目旨在改进YOLOv11模型,以实现对乡村道路植物与障碍物的高效识别与图像分割。为此,我们构建了一个专门的数据集,主题为“Arboretum Less classes”,该数据集包含七个类别,涵盖了乡村道路环境中常见的植物与障碍物。这七个类别分别为:草地(grass)、岩石小径(rocky-trail)、粗糙小径(rough-trail)、结构物(structure)、小径障碍物(trail-obstacle)、树干(tree-trunk)以及植被(vegetation)。这些类别的选择不仅考虑了乡村道路的自然环境特征,还兼顾了可能影响行车安全和行人通行的障碍物。

数据集的构建过程注重多样性与代表性,确保每个类别的样本数量均衡且具备一定的复杂性,以便于模型在训练过程中能够学习到丰富的特征。图像数据来源于多个乡村道路场景,涵盖不同的季节和天气条件,从而增强模型的泛化能力。每张图像都经过精确标注,确保每个类别的物体都被准确地框定与分割。这种细致的标注不仅提高了数据集的质量,也为后续的模型训练提供了坚实的基础。

在数据集的使用过程中,我们将重点关注模型在识别和分割不同类别物体时的表现,特别是在复杂背景和遮挡情况下的鲁棒性。通过对这些类别的深入分析与学习,我们期望能够提升YOLOv11在乡村道路场景中的应用效果,进而为智能交通系统的建设提供更为精准的技术支持。

核心代码

以下是代码中最核心的部分,并附上详细的中文注释:

import torch

from torch import nn

class EMA(nn.Module):

def init(self, channels, factor=8):

super(EMA, self).init()

self.groups = factor # 分组数

assert channels // self.groups > 0 # 确保每组的通道数大于0

self.softmax = nn.Softmax(-1) # 用于计算权重的softmax

self.agp = nn.AdaptiveAvgPool2d((1, 1)) # 自适应平均池化

self.pool_h = nn.AdaptiveAvgPool2d((None, 1)) # 自适应池化,输出高度不变,宽度为1

self.pool_w = nn.AdaptiveAvgPool2d((1, None)) # 自适应池化,输出宽度不变,高度为1

self.gn = nn.GroupNorm(channels // self.groups, channels // self.groups) # 分组归一化

self.conv1x1 = nn.Conv2d(channels // self.groups, channels // self.groups, kernel_size=1) # 1x1卷积

self.conv3x3 = nn.Conv2d(channels // self.groups, channels // self.groups, kernel_size=3, padding=1) # 3x3卷积

def forward(self, x):b, c, h, w = x.size() # 获取输入的batch size, 通道数, 高度, 宽度group_x = x.reshape(b * self.groups, -1, h, w) # 重新排列为 (b*g, c//g, h, w)x_h = self.pool_h(group_x) # 对每组进行高度自适应池化x_w = self.pool_w(group_x).permute(0, 1, 3, 2) # 对每组进行宽度自适应池化并转置hw = self.conv1x1(torch.cat([x_h, x_w], dim=2)) # 1x1卷积x_h, x_w = torch.split(hw, [h, w], dim=2) # 将结果分割为高度和宽度部分x1 = self.gn(group_x * x_h.sigmoid() * x_w.permute(0, 1, 3, 2).sigmoid()) # 通过sigmoid激活进行归一化x2 = self.conv3x3(group_x) # 3x3卷积x11 = self.softmax(self.agp(x1).reshape(b * self.groups, -1, 1).permute(0, 2, 1)) # 计算x1的权重x12 = x2.reshape(b * self.groups, c // self.groups, -1) # 重新排列x2x21 = self.softmax(self.agp(x2).reshape(b * self.groups, -1, 1).permute(0, 2, 1)) # 计算x2的权重x22 = x1.reshape(b * self.groups, c // self.groups, -1) # 重新排列x1weights = (torch.matmul(x11, x12) + torch.matmul(x21, x22)).reshape(b * self.groups, 1, h, w) # 计算最终权重return (group_x * weights.sigmoid()).reshape(b, c, h, w) # 返回加权后的结果

class SimAM(nn.Module):

def init(self, e_lambda=1e-4):

super(SimAM, self).init()

self.activaton = nn.Sigmoid() # Sigmoid激活函数

self.e_lambda = e_lambda # 控制平滑的超参数

def forward(self, x):b, c, h, w = x.size() # 获取输入的batch size, 通道数, 高度, 宽度n = w * h - 1 # 计算nx_minus_mu_square = (x - x.mean(dim=[2, 3], keepdim=True)).pow(2) # 计算方差y = x_minus_mu_square / (4 * (x_minus_mu_square.sum(dim=[2, 3], keepdim=True) / n + self.e_lambda)) + 0.5 # 计算yreturn x * self.activaton(y) # 返回加权后的结果

class SpatialGroupEnhance(nn.Module):

def init(self, groups=8):

super().init()

self.groups = groups # 分组数

self.avg_pool = nn.AdaptiveAvgPool2d(1) # 自适应平均池化

self.weight = nn.Parameter(torch.zeros(1, groups, 1, 1)) # 权重参数

self.bias = nn.Parameter(torch.zeros(1, groups, 1, 1)) # 偏置参数

self.sig = nn.Sigmoid() # Sigmoid激活函数

self.init_weights() # 初始化权重

def init_weights(self):for m in self.modules():if isinstance(m, nn.Conv2d):nn.init.kaiming_normal_(m.weight, mode='fan_out') # Kaiming初始化if m.bias is not None:nn.init.constant_(m.bias, 0) # 偏置初始化为0elif isinstance(m, nn.BatchNorm2d):nn.init.constant_(m.weight, 1) # BatchNorm权重初始化为1nn.init.constant_(m.bias, 0) # BatchNorm偏置初始化为0elif isinstance(m, nn.Linear):nn.init.normal_(m.weight, std=0.001) # 线性层权重初始化if m.bias is not None:nn.init.constant_(m.bias, 0) # 偏置初始化为0def forward(self, x):b, c, h, w = x.shape # 获取输入的batch size, 通道数, 高度, 宽度x = x.view(b * self.groups, -1, h, w) # 重新排列为 (bs*g, dim//g, h, w)xn = x * self.avg_pool(x) # 计算平均池化xn = xn.sum(dim=1, keepdim=True) # 按通道求和t = xn.view(b * self.groups, -1) # 重新排列t = t - t.mean(dim=1, keepdim=True) # 去均值std = t.std(dim=1, keepdim=True) + 1e-5 # 计算标准差t = t / std # 归一化t = t.view(b, self.groups, h, w) # 重新排列t = t * self.weight + self.bias # 加权和偏置t = t.view(b * self.groups, 1, h, w) # 重新排列x = x * self.sig(t) # 加权输入x = x.view(b, c, h, w) # 还原形状return x

代码核心部分说明:

EMA类:实现了一个有效的多通道特征增强模块,通过对输入特征进行分组、池化和卷积操作,计算出增强的特征图。

SimAM类:实现了一种自适应的激活模块,通过计算输入特征的方差,生成权重来增强特征。

SpatialGroupEnhance类:实现了空间分组增强,通过自适应平均池化和分组归一化来增强特征。

这些模块在深度学习模型中用于特征增强和注意力机制,提升模型的表现。

这个程序文件 attention.py 是一个实现多种注意力机制的 PyTorch 模块,主要用于计算机视觉任务中的特征增强和注意力机制。文件中定义了多个类,每个类实现了一种特定的注意力机制或相关的操作。以下是对文件内容的详细说明:

首先,文件导入了必要的库,包括 PyTorch 的核心模块和一些辅助模块,如 torchvision 和 efficientnet_pytorch。这些库提供了深度学习所需的基本功能和高效的模型结构。

接下来,文件定义了多个注意力机制的类,包括 EMA、SimAM、SpatialGroupEnhance、TopkRouting、KVGather、QKVLinear、BiLevelRoutingAttention 等。这些类实现了不同的注意力机制和操作。

EMA 类实现了一种基于通道的注意力机制,通过对输入特征图进行分组和池化,计算出每个组的加权特征,并通过 sigmoid 函数进行激活。SimAM 类实现了一种自适应的注意力机制,通过计算输入特征的均值和方差来生成注意力权重。SpatialGroupEnhance 类则通过空间分组增强特征图的表示能力。

TopkRouting 和 KVGather 类实现了基于 Top-k 路由的注意力机制,通过选择最重要的特征进行加权聚合。QKVLinear 类则用于将输入特征映射到查询、键和值的空间。

BiLevelRoutingAttention 类实现了一种双层路由注意力机制,结合了局部和全局的注意力计算,能够有效地捕捉不同尺度的特征信息。该类还支持多种下采样模式和参数设置。

此外,文件中还定义了一些其他的注意力机制,如 CoordAtt、TripletAttention、BAMBlock、EfficientAttention 等。这些类各自实现了不同的注意力计算方法,旨在提高模型的表达能力和性能。

最后,文件中还包含了一些辅助函数和类,如 img2windows 和 windows2img,用于处理图像的窗口化操作,以及 FocusedLinearAttention 和 MLCA 等实现特定注意力机制的类。

总的来说,这个文件实现了多种注意力机制,提供了灵活的接口和功能,适用于各种计算机视觉任务,特别是在特征提取和增强方面。通过组合不同的注意力机制,用户可以根据具体任务需求设计出更为复杂和高效的模型。

10.4 SMPConv.py

以下是代码中最核心的部分,并附上详细的中文注释:

import torch

import torch.nn as nn

import torch.nn.functional as F

定义一个函数用于生成相对位置坐标

def rel_pos(kernel_size):

# 生成一个从-1到1的线性空间,长度为kernel_size

tensors = [torch.linspace(-1, 1, steps=kernel_size) for _ in range(2)]

# 创建网格坐标

kernel_coord = torch.stack(torch.meshgrid(*tensors), dim=-0)

kernel_coord = kernel_coord.unsqueeze(0) # 增加一个维度

return kernel_coord

定义SMPConv类,继承自nn.Module

class SMPConv(nn.Module):

def init(self, planes, kernel_size, n_points, stride, padding, groups):

super().init()

self.planes = planes # 输出通道数self.kernel_size = kernel_size # 卷积核大小self.n_points = n_points # 采样点数self.init_radius = 2 * (2/kernel_size) # 初始化半径# 生成卷积核坐标kernel_coord = rel_pos(kernel_size)self.register_buffer('kernel_coord', kernel_coord) # 注册为缓冲区# 初始化权重坐标weight_coord = torch.empty(1, n_points, 2)nn.init.trunc_normal_(weight_coord, std=0.2, a=-1., b=1.) # 截断正态分布初始化self.weight_coord = nn.Parameter(weight_coord) # 权重坐标作为可学习参数# 初始化半径self.radius = nn.Parameter(torch.empty(1, n_points).unsqueeze(-1).unsqueeze(-1))self.radius.data.fill_(value=self.init_radius) # 填充初始半径# 初始化权重weights = torch.empty(1, planes, n_points)nn.init.trunc_normal_(weights, std=.02) # 权重初始化self.weights = nn.Parameter(weights) # 权重作为可学习参数def forward(self, x):# 生成卷积核并进行卷积操作kernels = self.make_kernels().unsqueeze(1) # 生成卷积核x = x.contiguous() # 确保输入张量是连续的kernels = kernels.contiguous() # 确保卷积核是连续的# 根据输入数据类型选择不同的卷积实现if x.dtype == torch.float32:x = _DepthWiseConv2dImplicitGEMMFP32.apply(x, kernels) # FP32卷积elif x.dtype == torch.float16:x = _DepthWiseConv2dImplicitGEMMFP16.apply(x, kernels) # FP16卷积else:raise TypeError("Only support fp32 and fp16, get {}".format(x.dtype)) # 类型错误return x def make_kernels(self):# 计算卷积核diff = self.weight_coord.unsqueeze(-2) - self.kernel_coord.reshape(1, 2, -1).transpose(1, 2) # 计算坐标差diff = diff.transpose(2, 3).reshape(1, self.n_points, 2, self.kernel_size, self.kernel_size) # 重塑形状diff = F.relu(1 - torch.sum(torch.abs(diff), dim=2) / self.radius) # 计算差值并应用ReLU# 计算最终的卷积核kernels = torch.matmul(self.weights, diff.reshape(1, self.n_points, -1)) # 计算加权卷积核kernels = kernels.reshape(1, self.planes, *self.kernel_coord.shape[2:]) # 重塑形状kernels = kernels.squeeze(0) # 去掉多余的维度kernels = torch.flip(kernels.permute(0, 2, 1), dims=(1,)) # 翻转卷积核return kernelsdef radius_clip(self, min_radius=1e-3, max_radius=1.):# 限制半径的范围r = self.radius.datar = r.clamp(min_radius, max_radius) # 限制在[min_radius, max_radius]之间self.radius.data = r # 更新半径

定义一个卷积层生成函数

def get_conv2d(in_channels, out_channels, kernel_size, stride, padding, dilation, groups, bias, n_points=None):

# 根据条件返回SMPConv或标准卷积层

if n_points is not None and in_channels == out_channels and out_channels == groups and stride == 1 and padding == kernel_size // 2 and dilation == 1:

return SMPConv(in_channels, kernel_size, n_points, stride, padding, groups) # 返回SMPConv

else:

return nn.Conv2d(in_channels=in_channels, out_channels=out_channels, kernel_size=kernel_size, stride=stride,

padding=padding, dilation=dilation, groups=groups, bias=bias) # 返回标准卷积层

定义SMPCNN类,继承自nn.Module

class SMPCNN(nn.Module):

def init(self, in_channels, out_channels, kernel_size, stride, groups, n_points=None, n_points_divide=4):

super().init()

self.kernel_size = kernel_size

if n_points is None:

n_points = int((kernel_size**2) // n_points_divide) # 计算采样点数

padding = kernel_size // 2 # 计算填充self.smp = conv_bn(in_channels=in_channels, out_channels=out_channels, kernel_size=kernel_size,stride=stride, padding=padding, dilation=1, groups=groups, n_points=n_points) # 使用SMP卷积self.small_kernel = 5 # 小卷积核大小self.small_conv = Conv(in_channels, out_channels, self.small_kernel, stride, self.small_kernel // 2, groups, act=False) # 小卷积层def forward(self, inputs):# 前向传播out = self.smp(inputs) # 通过SMP卷积out += self.small_conv(inputs) # 加上小卷积的输出return out

代码核心部分解释:

相对位置坐标生成:rel_pos函数用于生成卷积核的相对位置坐标,帮助卷积操作更好地捕捉空间信息。

SMPConv类:这是一个自定义的卷积层,支持根据输入数据类型选择不同的卷积实现,并通过可学习的权重和坐标生成卷积核。

卷积层生成函数:get_conv2d函数根据输入参数决定返回自定义的SMP卷积层还是标准的卷积层。

SMPCNN类:结合了SMP卷积和小卷积层的结构,用于实现更复杂的卷积操作。

以上是代码的核心部分和详细注释,旨在帮助理解代码的结构和功能。

这个程序文件 SMPConv.py 实现了一种自定义的卷积神经网络模块,主要包含了几个类和函数,用于构建和使用特定类型的卷积层。

首先,文件导入了必要的库,包括 PyTorch 的核心模块、深度学习相关的功能模块以及自定义的卷积模块。文件中还尝试导入了深度可分离卷积的实现,如果导入失败则捕获异常。

接下来,定义了一个函数 rel_pos,该函数生成一个相对位置的张量,用于卷积核的坐标计算。

SMPConv 类是该文件的核心部分,继承自 nn.Module。在初始化方法中,定义了多个参数,包括输出通道数、卷积核大小、点数、步幅、填充和分组卷积的参数。通过调用 rel_pos 函数,计算出卷积核的坐标,并将其注册为缓冲区。此外,还初始化了权重坐标和半径参数,并创建了权重张量。

在 forward 方法中,首先调用 make_kernels 方法生成卷积核,然后根据输入数据的类型选择相应的深度可分离卷积实现进行前向传播。

make_kernels 方法用于生成卷积核。它计算权重坐标与卷积核坐标之间的差异,并通过 ReLU 激活函数进行处理,最后将这些差异与权重结合,生成最终的卷积核。

radius_clip 方法用于限制半径的范围,确保其在指定的最小值和最大值之间。

接下来,定义了一些辅助函数,如 get_conv2d、get_bn 和 conv_bn,这些函数用于创建卷积层和批归一化层的组合。conv_bn_relu 函数则在此基础上添加了 ReLU 激活函数。

SMPCNN 类实现了一个包含自定义卷积层和小卷积层的网络结构。它在前向传播中将两个卷积层的输出相加。

SMPCNN_ConvFFN 类实现了一个前馈网络,包含两个逐点卷积层和一个非线性激活函数,最后将输入与输出相加,形成残差连接。

最后,SMPBlock 类定义了一个模块,其中包含两个逐点卷积层和一个自定义的卷积层,结合了残差连接和 DropPath 技术以实现更好的训练效果。

总体而言,这个文件实现了一种新的卷积结构,结合了深度可分离卷积和残差连接的思想,旨在提高模型的表达能力和训练效率。

源码文件

源码获取

欢迎大家点赞、收藏、关注、评论啦 、查看👇🏻获取联系方式👇🏻