【AI论文】UI-TARS-2技术报告:借助多轮强化学习推进图形用户界面(GUI)智能体发展

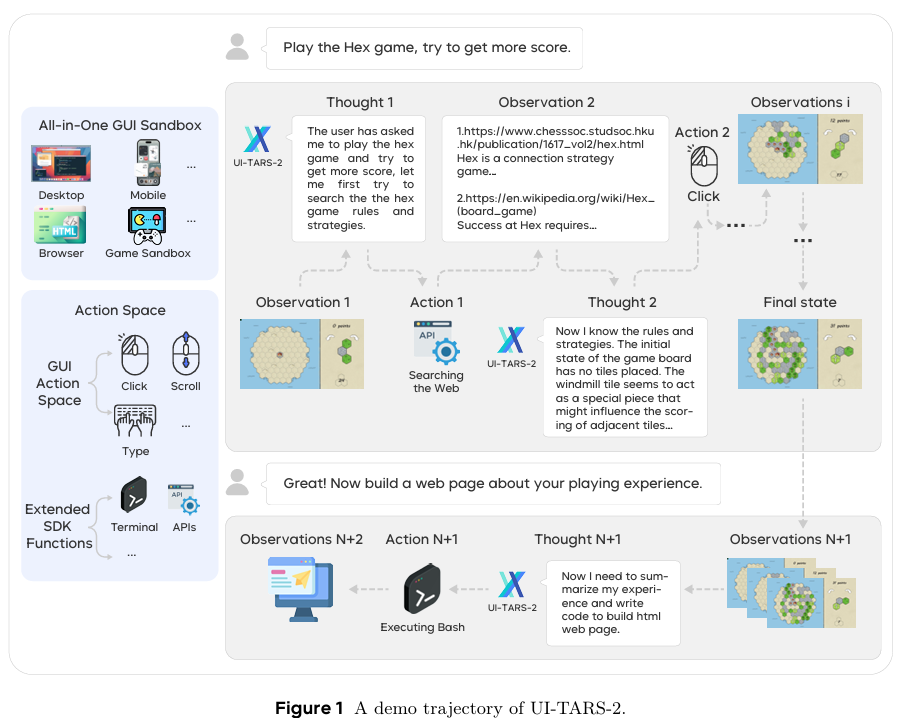

摘要:为图形用户界面(GUI)开发自主智能体是人工智能领域面临的重大挑战。尽管近期原生智能体模型通过端到端学习整合感知、推理、行动和记忆,展现出令人瞩目的潜力,但在数据可扩展性、多轮强化学习(RL)、仅依赖图形用户界面操作的局限性以及环境稳定性方面仍存在未解决的问题。本技术报告提出UI-TARS-2——一种以原生图形用户界面为核心的智能体模型,通过系统化训练方法应对上述挑战:利用数据飞轮实现可扩展的数据生成,构建稳定的多轮强化学习框架,打造集成文件系统和终端的混合图形用户界面环境,并搭建用于大规模部署的统一沙盒平台。实证评估表明,UI-TARS-2相较于前代模型UI-TARS-1.5取得了显著提升。在图形用户界面基准测试中,其在Online-Mind2Web上得分达88.2,在OSWorld上得分达47.5,在WindowsAgentArena上得分达50.6,在AndroidWorld上得分达73.3,表现优于Claude和OpenAI智能体等强劲基线模型。在游戏环境中,该模型在15款游戏测试套件中取得平均归一化分数59.8——约为人类水平的60%——且在LMGame-Bench上与前沿专有模型(如OpenAI o3)保持竞争力。此外,该模型还能泛化至长周期信息检索任务和软件工程基准测试,凸显其在多样智能体任务中的稳健性。对训练动态的详细分析进一步揭示了在大规模智能体强化学习中实现稳定性和效率的关键路径。这些成果凸显了UI-TARS-2推动图形用户界面智能体技术进步的潜力,并展现出其在真实交互场景中的强大泛化能力。Huggingface链接:Paper page,论文链接:2509.02544

研究背景和目的

研究背景:

随着大型语言模型(LLMs)的快速发展,自然语言处理(NLP)领域取得了显著进展。LLMs不仅能够生成流畅的文本,还能执行复杂的推理和决策任务,极大地拓宽了NLP的应用范围。然而,传统的LLMs主要依赖于静态的启发式模块,这些模块在特定任务上表现良好,但在动态、不确定的环境中往往缺乏自适应和鲁棒行为的能力。例如,在图形用户界面(GUI)导航、代码生成、游戏环境等复杂任务中,智能体需要具备与环境的动态交互能力,根据实时反馈调整策略,以实现最优决策。

为了应对这一挑战,强化学习(RL)作为一种关键机制被引入,旨在将LLMs的推理和决策能力转化为自适应、鲁棒的智能体行为。RL通过智能体与环境的交互学习最优策略,使智能体能够在动态环境中表现出色。近年来,基于LLMs的智能体强化学习(Agentic RL)逐渐成为研究热点,其核心在于利用LLMs的强大语言理解和生成能力,结合RL的决策优化能力,构建能够处理复杂、动态任务的智能体。

研究目的:

本研究旨在通过系统综述和实证分析,深入探讨强化学习如何赋能基于LLMs的智能体,使其能够在动态环境中展现出更强的自适应能力和鲁棒性。具体目标包括:

- 理论整合:从概念基础到实际实现,逐步构建对智能体强化学习(Agentic RL)的统一理解,明确其在NLP和AI领域的重要地位。

- 模块化能力分析:分类并详细分析智能体强化学习中的关键模块,如规划、推理、工具使用、记忆和自我改进等,理解各模块在智能体行为中的作用及其相互关系。

- 应用探索:探索智能体强化学习在不同领域的应用,包括搜索、GUI导航、代码生成、数学推理和多人系统等,评估其在实际场景中的表现和潜力。

- 挑战与未来方向:讨论智能体强化学习面临的挑战,如数据稀缺性、计算资源需求、泛化能力等,并提出未来的研究方向,以促进可扩展、自适应和可靠的智能体智能的发展。

研究方法

本研究采用了综合性的研究方法,包括文献综述、案例分析和实证研究,具体方法如下:

- 文献综述:

- 广泛搜集文献:通过学术数据库(如arXiv、Google Scholar等)搜索近五年内关于智能体强化学习、大型语言模型和强化学习结合的相关文献。

- 筛选与分类:根据研究主题和贡献,筛选出高质量的文献,并按照研究内容(如理论基础、模块化能力、应用领域等)进行分类。

- 深入分析:对分类后的文献进行深入分析,提取关键观点、方法、实验结果和结论,形成对智能体强化学习的全面理解。

- 案例分析:

- 选择典型案例:选取在智能体强化学习领域具有代表性的研究案例,如DeepSeek-R1、OpenAI o3、UI-TARS-2等模型在动态环境中的应用。

- 详细剖析:对每个案例进行详细剖析,包括模型架构、训练方法、实验结果和应用场景等,理解其成功经验和存在的问题。

- 对比分析:对比不同案例之间的异同点,总结智能体强化学习在不同任务和环境中的表现和适用性。

- 实证研究:

- 实验设计:设计一系列实验,评估智能体强化学习模型在GUI导航、代码生成、游戏环境等动态任务中的表现。

- 数据收集:收集实验过程中的交互数据、性能指标和用户反馈,为分析提供数据支持。

- 结果分析:对实验数据进行统计分析,评估模型的自适应能力、鲁棒性和效率,验证强化学习在赋能基于LLMs的智能体方面的有效性。

研究结果

通过文献综述、案例分析和实证研究,本研究取得了以下主要结果:

- 理论整合:

- 明确了智能体强化学习的概念基础,即利用LLMs的语言理解和生成能力,结合RL的决策优化能力,构建能够处理复杂、动态任务的智能体。

- 梳理了智能体强化学习的发展历程,从早期的模块化设计到近期的端到端学习,展示了其在NLP和AI领域的重要地位。

- 模块化能力分析:

- 分类并详细分析了智能体强化学习中的关键模块,包括规划、推理、工具使用、记忆和自我改进等。

- 发现各模块在智能体行为中发挥着重要作用,且相互之间存在紧密的依赖关系。例如,规划模块负责生成长期目标,推理模块负责分析当前状态,工具使用模块负责调用外部资源,记忆模块负责存储历史信息,自我改进模块负责根据反馈调整策略。

- 应用探索:

- 探索了智能体强化学习在不同领域的应用,包括搜索、GUI导航、代码生成、数学推理和多人系统等。

- 发现智能体强化学习在这些领域中表现出色,能够显著提高任务的完成效率和准确性。例如,在GUI导航任务中,强化学习使智能体能够通过试错学习最优操作序列,显著提高了导航效率;在代码生成任务中,强化学习通过执行反馈引导策略更新,提高了代码的正确性和可维护性。

- 实证研究结果:

- 通过实验评估了智能体强化学习模型在GUI导航、代码生成、游戏环境等动态任务中的表现。

- 实验结果表明,强化学习显著提高了智能体的自适应能力和鲁棒性。例如,在GUI导航任务中,经过强化学习训练的智能体能够更快速地找到目标元素;在代码生成任务中,强化学习使生成的代码更符合语法规范和逻辑要求。

研究局限

尽管本研究在智能体强化学习领域取得了显著进展,但仍存在以下局限:

- 数据稀缺性:在某些特定领域(如专业数学推理、复杂系统控制),高质量的训练数据稀缺,限制了强化学习算法的性能提升。这可能导致模型在训练过程中过拟合或欠拟合,影响其泛化能力。

- 计算资源需求:强化学习训练过程需要大量计算资源,尤其是在处理复杂任务和大规模模型时,计算成本高昂。这可能限制了研究