【本地AI大模型部署+可视化界面图文教程】Ollama+Qwen3

文章目录

- Ollama简介

- 安装Ollama

- Ollama相关操作

- 拉取大模型镜像

- 使用大模型

- 实现可视化界面

- 配置Chatbox

- 使用可视化大模型

Ollama简介

Ollama 是一款大模型容器管理框架,旨在帮助用户快速在本地部署和运行大模型。

它具备以下核心优势:

1.硬件自适应:无需手动配置,可自动检测电脑硬件,优先调用GPU(若支持)或使用CPU运行模型,降低操作门槛。

2.跨平台兼容:支持 Windows(仅 Win10 及以上系统)、macOS 和 Linux 系统。

特别注意,对于Windows 系统,仅支持Windows 10 或更高版本(需 64 位系统)。

安装Ollama

访问:

https://ollama.com/download/windows

点击下载:

安装完成后,电脑右下角任务栏会显示Ollama图标:

打开cmd命令窗口,输入以下命令查看安装版本:

Ollama -v

若输出如上图,则说明安装成功。

Ollama相关操作

如果不小心关闭了Ollama程序,输入以下命令即可重新启动Ollama服务:

ollama serve

也可以直接在应用程序中打开ollama应用程序。

Ollama serve默认端口为127.0.0.1:11434,这个端口会在后面用到。

如果不设置模型文件保存位置,模型文件会自动保存在C盘。时间久了,C盘很容易存满。

因此可打开系统环境变量配置,添加一个环境变量OLLAMA_MODELS=D:\Ollama(指定文件夹),然后点确定。

拉取大模型镜像

镜像中包含了运行大模型所需的所有文件(如模型参数、代码、依赖程序),就像快递里装着组装玩具的零件、说明书和工具,大幅降低使用门槛。

访问以下链接:

https://ollama.com/

点击左上角Models:

这里有非常多的大模型镜像供我们选择:

本文选择Qwen3

具体介绍:https://ollama.com/library/qwen3

选择Qwen3中的qwen3:1.7b,复制右上角的命令:

ollama run qwen3:1.7b

打开cmd窗口,输入刚刚复制的ollama run qwen3:1.7b

Ollama将拉取Qwen的镜像文件,然后运行Qwen模型:

成功后将显示success:

以下命令可以列出当前主机存在的大模型:

ollama list

使用大模型

实现可视化界面

命令行界面的操作不够直观、学习成本较高,如何通过图形化界面便捷地使用大模型?Chatbox可以使用户通过图形化界面访问本地大模型。

访问Chatbox官网:

https://chatboxai.app/zh

下载:

此时Chatbox已安装成功。

配置Chatbox

进入软件界面,选择“使用自己的API Key或本地模型”:

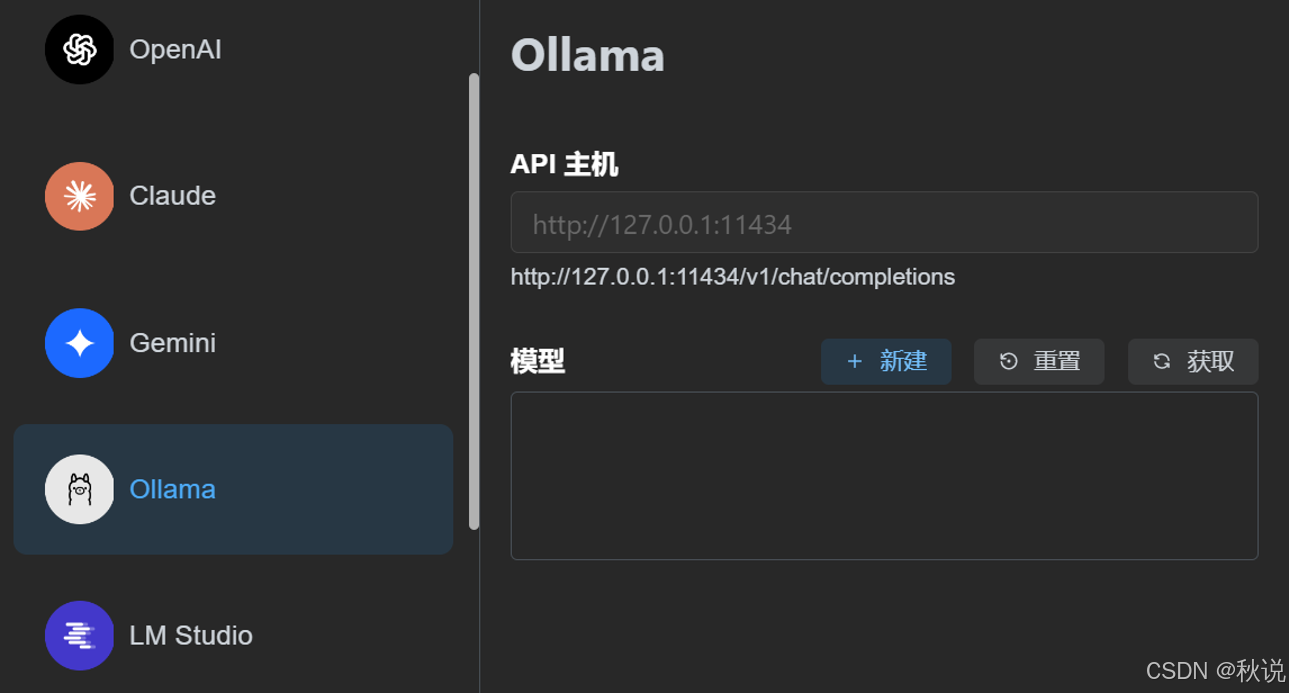

由于我们使用Ollama,因此选择Ollama API:

在以下界面输入:

http://127.0.0.1:11434

127.0.0.1:11434是什么意思?它与服务的联系是什么?

127.0.0.1 是本地回环地址,代表设备自身,用于本地网络通信测试;11434 是端口号,标识特定服务。

二者组合“127.0.0.1:11434”指向本地主机上占用该端口的服务,常见于开发测试中访问本地运行的程序,如 Web 服务、调试工具等,通过端口区分不同进程,这里是ollama服务。

输完后点击“获取”,软件将自动获取我们电脑上已经安装的AI模型:

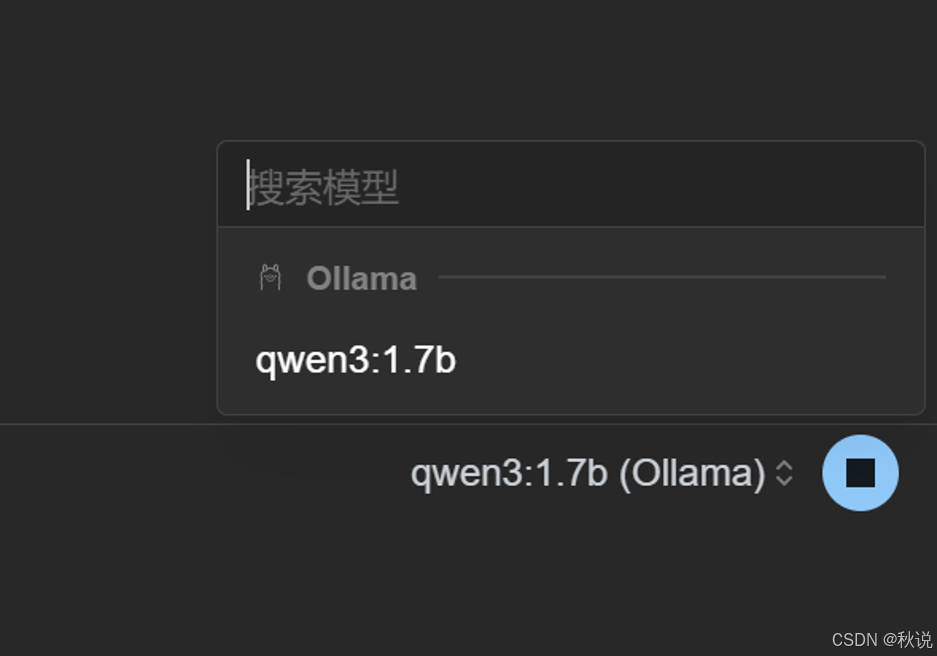

在设置界面选择默认模型为Qwen3:

在对话界面选择模型为qwen3:

使用可视化大模型

测试: