本地部署 DeepSeek

1. Ollama下载安装

Ollama 是一个开源的本地大语言模型运行框架,专为在本地机器上便捷部署和运行大型语言模型而设计。如:LLM、DeepSeek 等。

想要详细了解的可以在【快速掌握 Ollama 使用】了解

点击 Ollama下载网站 进行下载

安装后,可以先验证下是否安装成功 使用【CMD】命令提示符,输入【ollama】,出现下面图片内容,说明已经安装成功了。

2.下载安装大模型

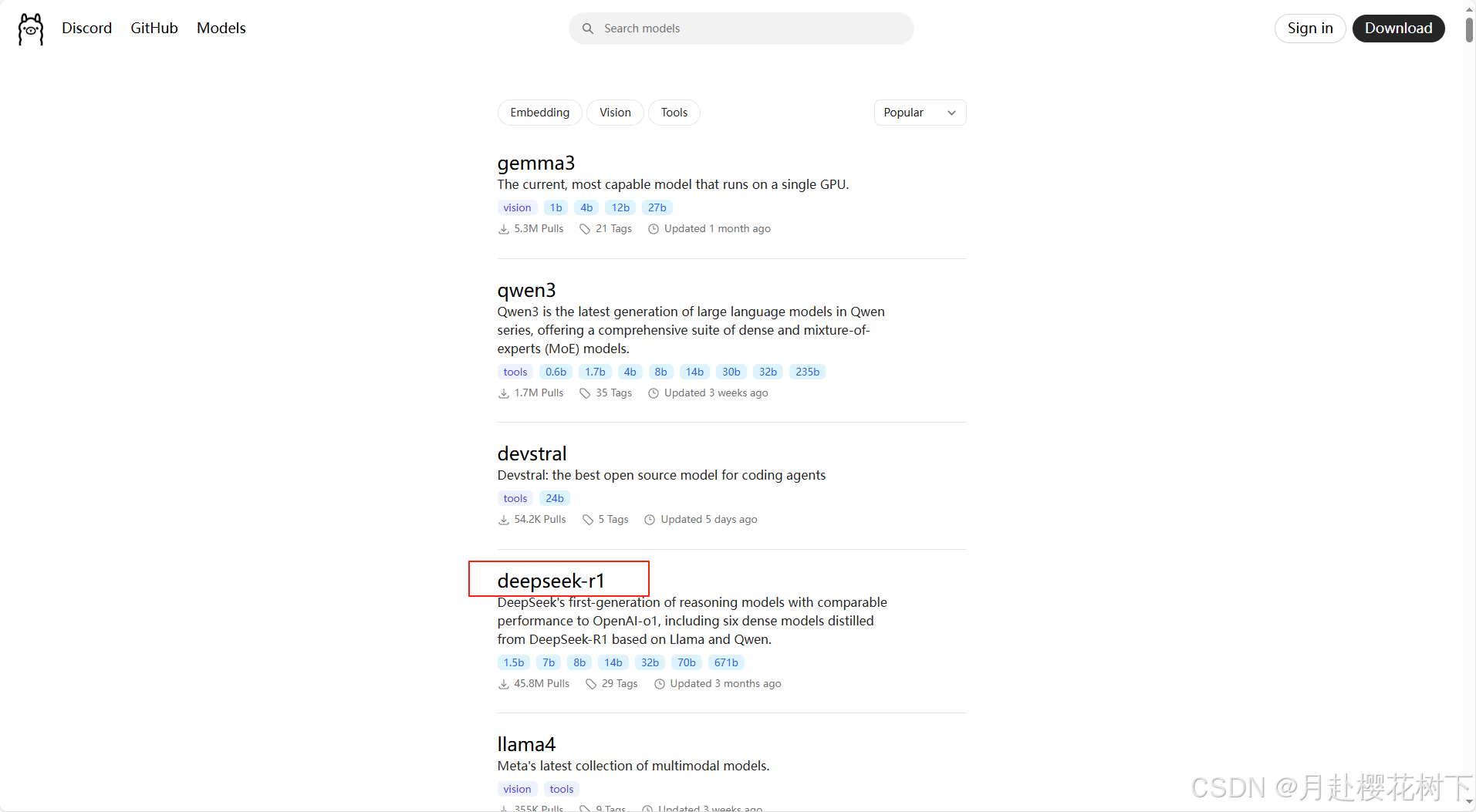

返回 Ollama下载网站 ,点击 Models 进入,找到 deepseek-r1

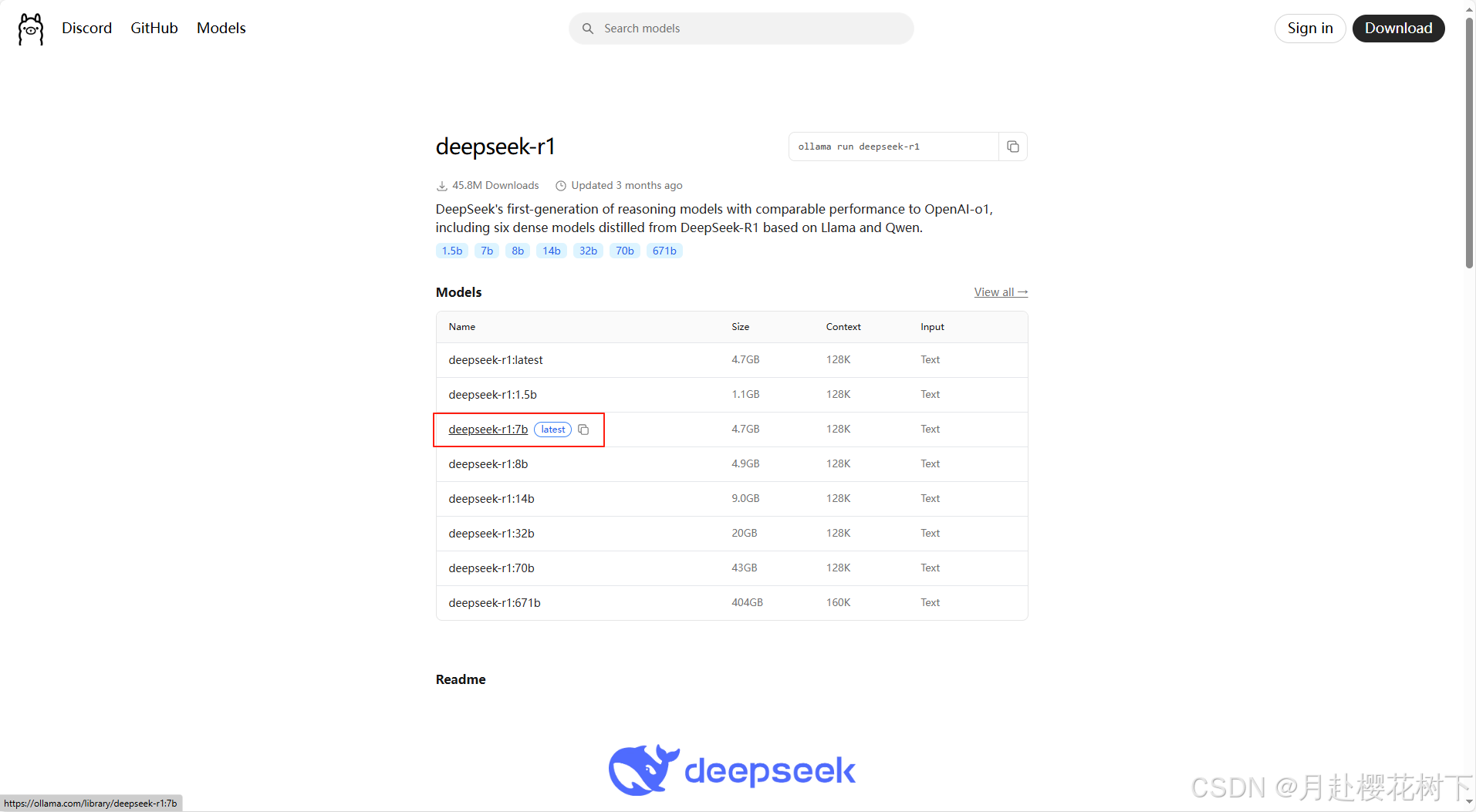

按照自己的机型去选择,不同的参数,使用的参数越大,使用的效果越好

版本 | 适配机型及特点 | 内存要求 |

| 1.5B | 适合在个人电脑等设备运行。CPU 4 核以上,可选 GTX 1050 Ti 这类入门级显卡。适合短文本生成、基础问答等轻量级任务,可用于本地测试。 | 内存 8GB 以上,建议 16GB |

| 7B / 8B | CPU 需 8 核以上,GPU选择, 7B 版本推荐 RTX 2060,8B 版本推荐 RTX 3060。适合文案、表格、统计等中等复杂度任务,也可用于本地开发和测试,处理文本摘要、翻译等任务 。 | 内存 16GB 以上 |

| 14B | CPU 需 16 核以上,GPU 建议搭配 RTX 3090。适用于长文本生成、数据分析等复杂任务,对硬件性能要求较高,一般用于专业领域或企业级场景 。 | 内存 32GB 以上 |

| 32B | CPU 需 32 核以上专业 CPU,必须配备高性能 GPU。适合企业级复杂任务,多为专业机构使用 。用于语言建模、大规模训练等超大规模任务。 | 内存 64GB 以上 |

| 70B | CPU 需 64 核以上,GPU 必须是如 H100 。适用于科研机构或大型企业进行高复杂度生成任务 。面向更高级别的超大规模任务。 | 内存 128GB 以上 |

| 617B | CPU 需 128 核以上的多路 Xeon 或 EPYC CPU,且必须配备多 GPU(如 8x A100) 。对硬件要求极高,一般只有大型科研项目或超大型企业才具备运行条件 。针对顶级语言模型的超大规模任务。 | 内存 256GB 以上 |

选好之后,点击所选版本进去,复制该版本命令,粘在命令提示符中安装。

出现下面的图片内容就说明安装成功了,下次启动可以使用【ollama run deepseek-r1:7b】

启动成功后,就可以输入我们想问的问题,模型首先会进行深度思考,思考结束后会反馈我们问题的结果。

如果不喜欢用这个启动,最好下载【借助可视化界面软件:】