LoRA怎么和Base模型完成输出 ;LoRA完整计算过程; lora前向传播和反向传播 计算过程举例

LoRA怎么和Base模型完成输出 ;LoRA完整计算过程

目录

- LoRA怎么和Base模型完成输出 ;LoRA完整计算过程

- 原理层面

- 计算过程层面

- 前向传播计算

- 反向传播计算

- 应用场景层面

- lora前向传播和反向传播 计算过程举例

- 前向传播

- 反向传播

- 为什么标量 0.1 可以转换为一个对角矩阵,即主对角线元素为 0.1:仅仅是空间维度缩放

原理层面

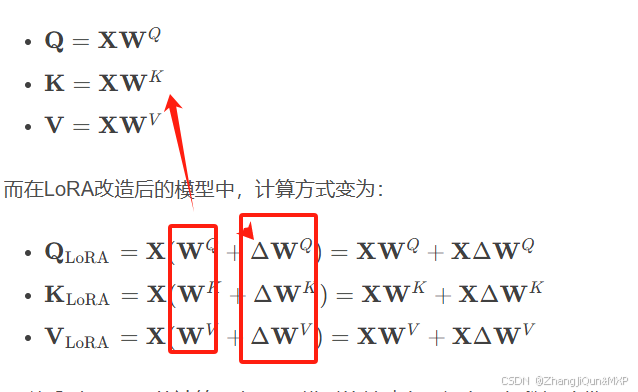

LoRA的核心思想是在不改变预训练Base模型原有参数的基础上,引入额外的低秩矩阵来进行微调。Base模型是经过大规模数据预训练得到的,已经学习到了丰富的语言知识和语义表示。LoRA通过在Base模型的某些关键层(如Transformer的注意力层)添加低秩分解矩阵,利用这些额外的可训练参数对Base模型进行微调,以适应特定的下游任务。所以,LoRA是基于Base模型的结构和参数进行扩展和优化的,没有Base模型,LoRA就失去了其存在的基础。

计算过程层面

前向传播计算

以Transformer架构中的注意力层为例,在计算查询(Query)、键(Key)和值(Value)时,传统的Base模型通过线性变换得到: