AI大模型-微调和RAG方案选项

在搭建知识库的方向上,有两个落地方案:微调、RAG。两个方案的比对:

方案选型

微调

让大模型(LLM)去学习现有知识(调整大模型的参数,让它学习新的知识),最终生成一个新的模型,用户提出问题后,基于经过学习后的新的模型来生成答案。

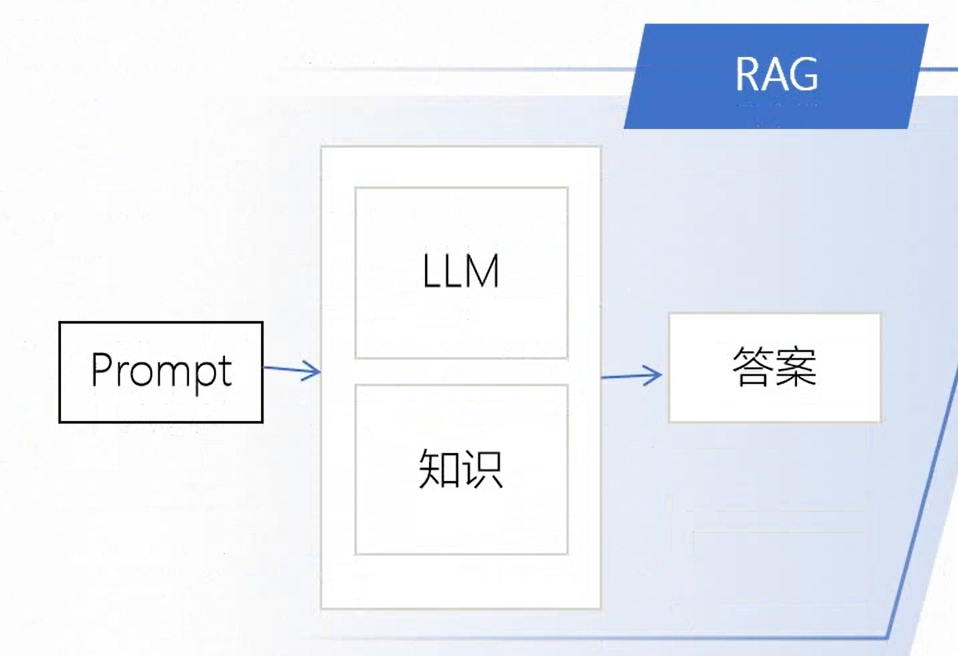

RAG

当用户提出一个问题,依靠现有知识,加上大模型(LLM)的语言生成能力,两者进行结合,最终给到用户答案。

总结:RAG回答问题是基于知识库中的知识进行回答,而微调是基于新的模型来进行回答。这是两者最本质的区别。

场景举例:

适合用微调

1.模型能力定制:希望模型能以固定或者特殊口吻来回答问题。

2.智能设备:模型应用到智能设备上面,大多数智能设备的空间都是比较小的,智能部署一些小模型,小模型的能力相对比较弱,所以更适合用微调。

3.对相应速度有要求:接收到用户的问题后,以最快的速度回复问题,这种情况也适合用微调,因为微调的方式是基于模型直接回复。

适合用RAG

1. 动态数据:数据每周或者每日要更新一次,适合用RAG,因为微调的成本比较高。

2.幻觉问题:对幻觉问题比较敏感,或者说本意就是为了解决幻觉问题,适合用RAG。微调后可能在其他方面有提升,但是幻觉问题可能会加重。

3.可解释性:如果场景对回答要求有可解释性,比对生成的问题需要明确知道其依据是什么,来自哪个文档或者内容,这种情况用RAG更加合适。

4.成本:如果想有更小的成本,那相对来说RAG的成本更小,微调设计到GPU算力和数据成本,最大的成本是数据成本,需要有足够量的数据来对模型进行训练,对数据的数量和质量都有较高的要求。

5.依赖生成能力:如果对模型的生成能力有要求,适合RAG。微调能加强某些领域的水平,但是可能会造成其他领域内容的遗忘。