大语言模型中的归一化实现解析

大语言模型(LLM)中,归一化怎么实现的

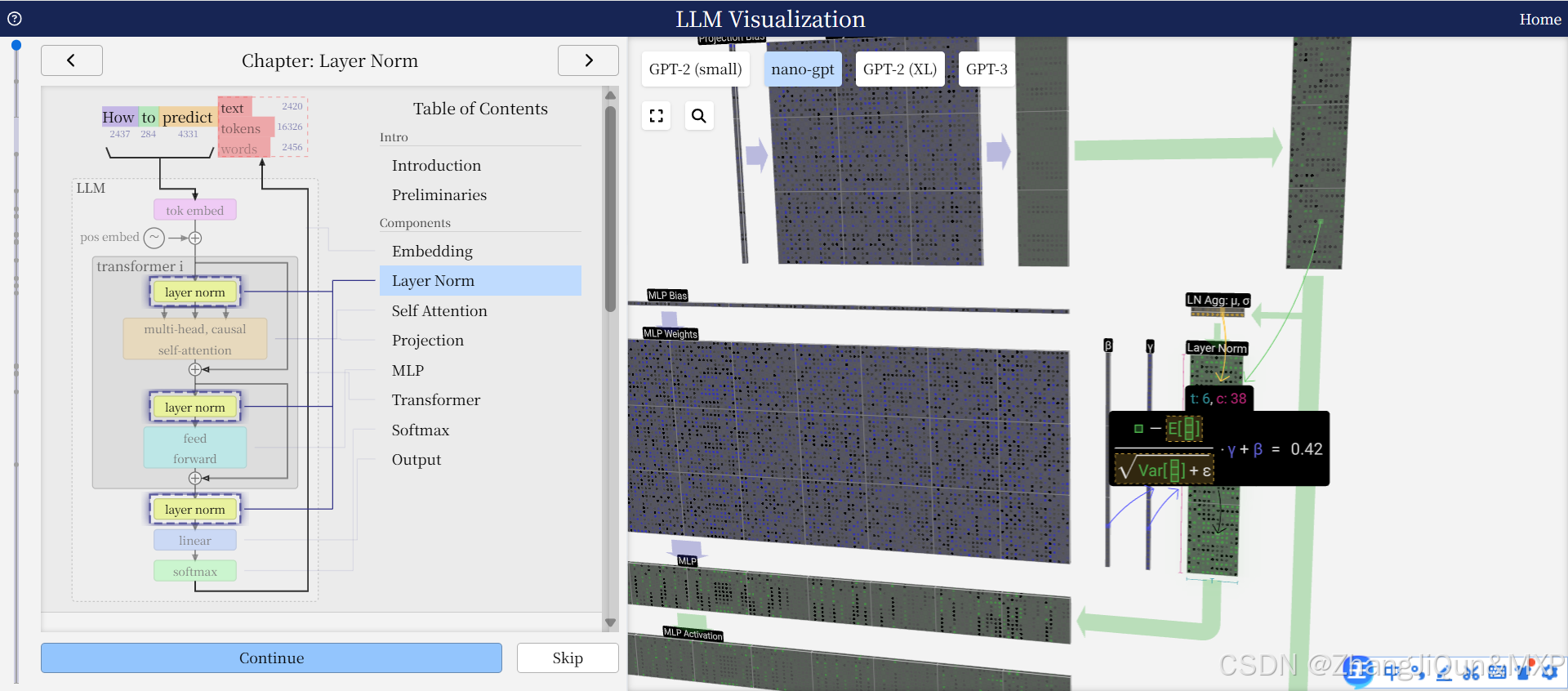

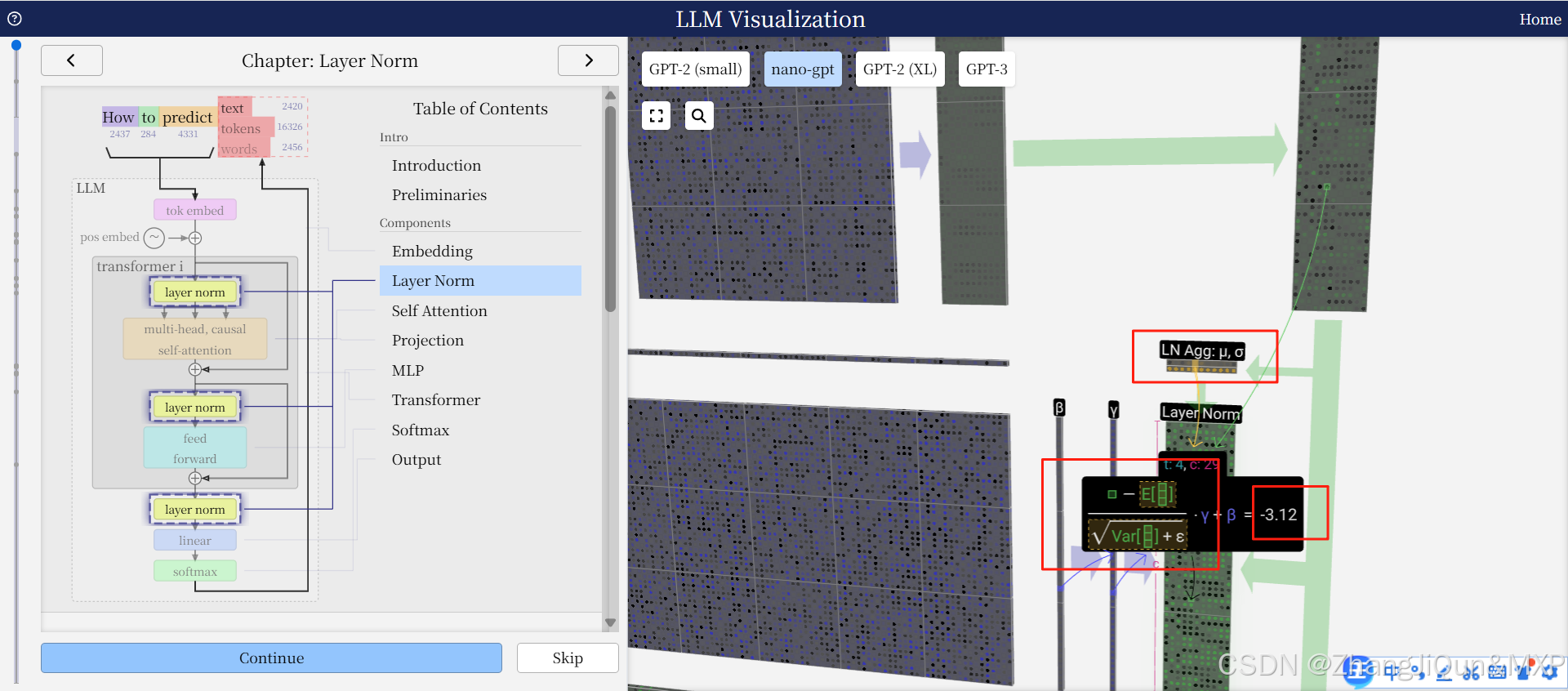

在大语言模型(LLM)中,归一化(Normalization) 是一种核心技术,主要用于稳定模型训练过程、缓解深层网络中的“梯度消失/爆炸”问题,并让每一层的输入分布保持相对稳定,从而提升模型的收敛速度和性能。与数据预处理阶段的归一化(如将数据缩放到[0,1])不同,LLM内部的归一化是在模型的每一层内部动态进行的,其中最常用的是 Layer Normalization(层归一化)(尤其在Transformer架构中,几乎是标配)。

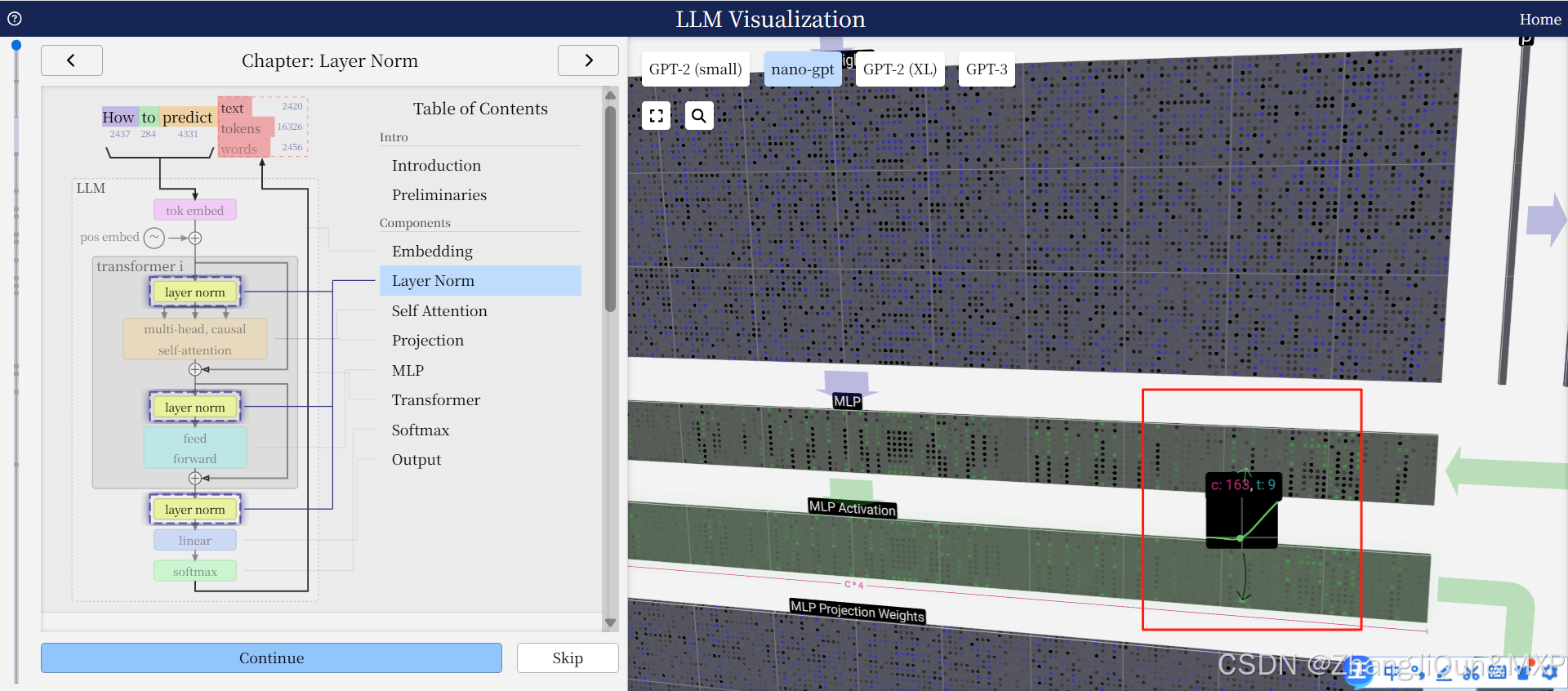

silue激活函数在MLP 的active

为什么LLM需要内部归一化?

LLM(如GPT、BERT)基于Transformer架构,通常包含数十甚至数百层网络。每一层的输入是上一层的输出,而深层网络的计算容