TensorRT-LLM.V1.1.0rc0:在无 GitHub 访问权限的服务器上编译 TensorRT-LLM 的完整实践

一、TensorRT-LLM有三种安装方式,从简单到难

1.NGC上的预构建发布容器进行部署,见《tensorrt-llm0.20.0离线部署DeepSeek-R1-Distill-Qwen-32B》。

2.通过pip进行部署。

3.从源头构建再部署。

在实际开发中,我们常常面临这样的场景:本地笔记本为 Windows 系统,虽然可以访问 GitHub,但受限于硬件性能,编译大型项目(如 TensorRT-LLM)耗时过长;而公司或实验室提供的 Linux 服务器性能强劲,适合编译任务,但却因网络策略限制无法连接外网,尤其是无法访问 GitHub。

为了充分利用服务器的高性能并绕过网络限制,本文将分享一种高效、可行的编译方案:在本地准备依赖资源,通过中转方式将代码和依赖上传至服务器,完成编译构建。

二、在能连接github的服务器中,下载源代码

2.1下载源代码

#git clone https://github.com/NVIDIA/TensorRT-LLM.git

上传到服务器/home/TensorRT-LLM

2.2下载cmake和mpi4py

https://github.com/Kitware/CMake/releases/download/v3.30.2/cmake-3.30.2-linux-x86_64.tar.gz

https://github.com/mpi4py/mpi4py/archive/refs/tags/3.1.5.tar.gz

上传到服务器/home/TensorRT-LLM/docker/context,如果文件夹不存在,则创建。

2.3修改Dockerfile.multi文件

增加如下两行代码:

COPY docker/context/cmake.tar.gz /tmp/cmake-3.30.2-linux-x86_64.tar.gz

# Install mpi4py

COPY docker/context/mpi4py-3.1.5.tar.gz /tmp/mpi4py-3.1.5.tar.gz

2.4修改install_cmake.sh文件

注释下面两行或删除。

路径:/home/TensorRT-LLM/docker/common/install_cmake.sh

#RELEASE_URL_CMAKE=${GITHUB_URL}/Kitware/CMake/releases/download/v${CMAKE_VERSION}/${CMAKE_FILE_NAME}.tar.gz

#wget --no-verbose --timeout=180 --tries=3 ${RELEASE_URL_CMAKE} -P /tmp

2.5修改install_mpi4py.sh文件

路径:/home/TensorRT-LLM/docker/common/install_mpi4py.sh

将curl -L ${RELEASE_URL} | tar -zx -C "$TMP_DIR"

改成

tar -zxf /tmp/mpi4py-3.1.5.tar.gz -C "$TMP_DIR"

2.6修改scripts/build_wheel.py文件

路径:/home/TensorRT-LLM/scripts/build_wheel.py

将下面的代码删除或注释

# with open(project_dir / ".gitmodules", "r") as submodules_f:

# submodules = [

# l.split("=")[1].strip() for l in submodules_f.readlines()

# if "path = " in l

# ]

# if any(not (project_dir / submodule / ".git").exists()

# for submodule in submodules):

# build_run('git submodule update --init --recursive')

三、编译开发环境

构建脚本有7个阶段,详见《TensorRT-LLM.V1.1.0rc1:Dockerfile.multi文件解读》。

本次构建开发环境devel

docker buildx build --target devel --load --platform linux/amd64 -f docker/Dockerfile.multi -t tensorrt-llm:1.1.0rc0 .

3.1参数解释

--target devel

表示只构建多阶段 Dockerfile 中名为 devel 的构建阶段(stage)。

使用 --target devel 意味着:只构建到 devel 阶段为止,不继续构建后面的 runtime 等阶段。

这通常用于开发调试,因为 devel 镜像包含编译工具、源码等,体积大但便于开发。

--load

将构建好的镜像加载到本地 Docker 镜像库中(即可以通过 docker images 看到)。

因为 buildx 默认使用 docker-container 或 remote 构建器时,结果不会自动进入本地镜像列表。

--platform linux/amd64

指定目标架构为 x86_64(即 amd64) 的 Linux 系统。

即使你在 ARM(如 Apple M1/M2)机器上运行,也会通过 QEMU 模拟构建出 amd64 的镜像。

常见可选值:

linux/amd64(Intel/AMD 64位)

linux/arm64(ARM 64位,如 M1/M2)

也可以指定多个:--platform linux/amd64,linux/arm64

-f docker/Dockerfile.multi

指定使用的 Dockerfile 文件路径为:项目根目录下的 docker/Dockerfile.multi。

表明这是一个多阶段构建(multi-stage) 的 Dockerfile,可能包含多个 FROM 阶段,用于分离开发、运行环境等。

-t tensorrt-llm:1.1.0rc0

给构建出的镜像打标签(tag):

仓库名:tensorrt-llm

标签名:1.1.0rc0(表示版本 1.1.0 的 release candidate 0)

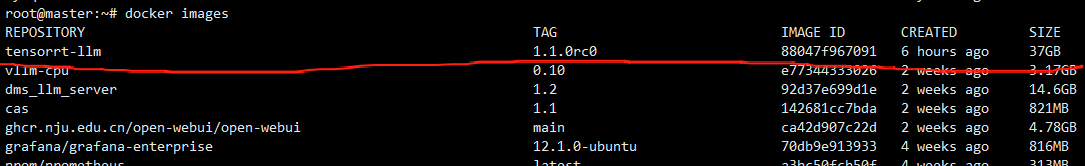

#docker images查看