almalinux9.6-4070显卡-ollama-qwen2.5-7b

目录

1.NVIDIA显卡驱动以及CUDA安装

2.docker安装以及镜像拉取

3.创建ollama及open-webui容器

4.配置open-webui连接ollama

本方法同样适用于和rhel8和rhel9

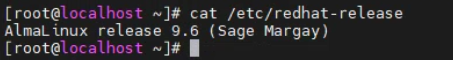

系统版本

1.NVIDIA显卡驱动以及CUDA安装

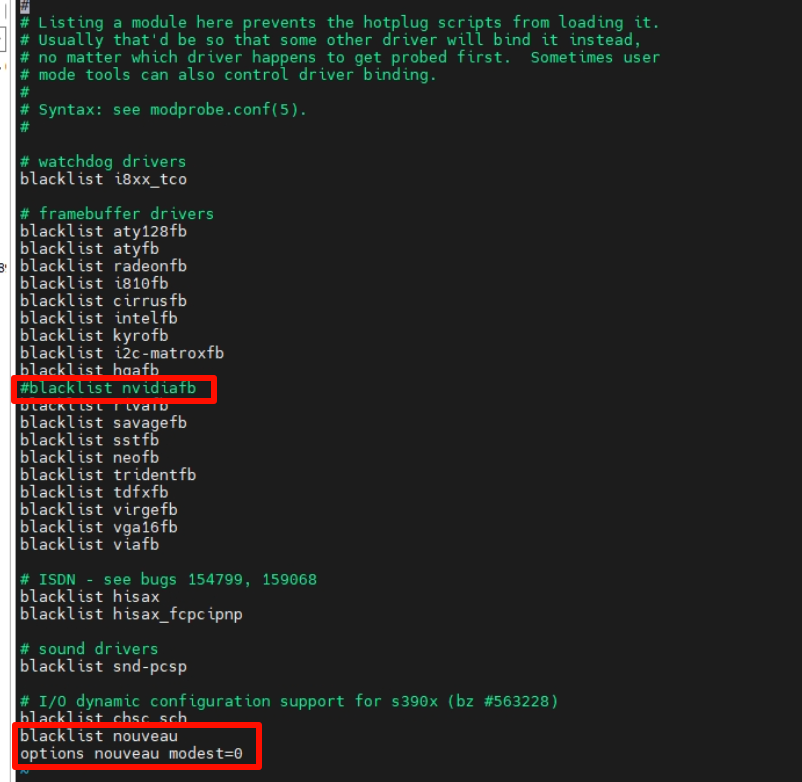

编辑/usr/lib/modprobe.d/dist-blacklist.conf文件,这一步是为了阻止系统加载 Nouveau(NVIDIA开源驱动)

blacklist nvidiafb加#号注释掉

添加如下内容

blacklist nouveau

options nouveau modest=0

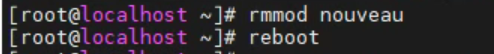

修改后之后使用命令移除Nouveau,并进行重启

#移除nouveau

rmmod nouveau

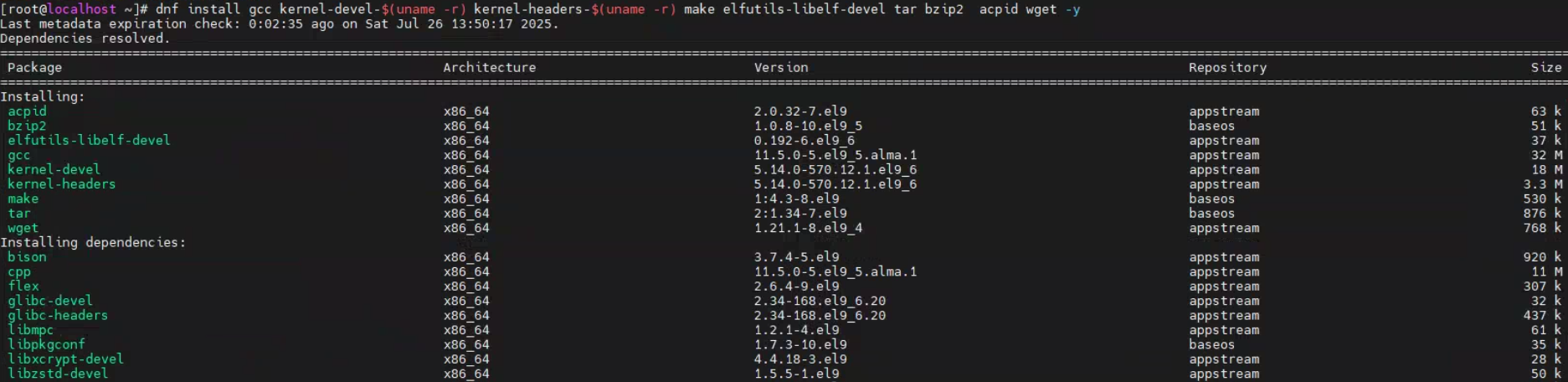

重启之后,使用命令安装一下驱动所需依赖(在此之前也可以用 dnf update -y 升级一下已有软件包)

#uname -r命令的作用是查看系统内核版本,在命令中代表安装对应内核版本的kernel-devel以及kernel-headers

dnf install gcc kernel-devel-$(uname -r) kernel-headers-$(uname -r) make elfutils-libelf-devel tar bzip2 acpid wget -y

依赖安装完成后,我们需要下载NVIDIA显卡驱动

下载地址为:

NVIDIA GeForce 驱动程序 - N 卡驱动 | NVIDIA![]() https://www.nvidia.cn/geforce/drivers/根据显卡型号以及系统型号选择驱动,点击开始搜索

https://www.nvidia.cn/geforce/drivers/根据显卡型号以及系统型号选择驱动,点击开始搜索

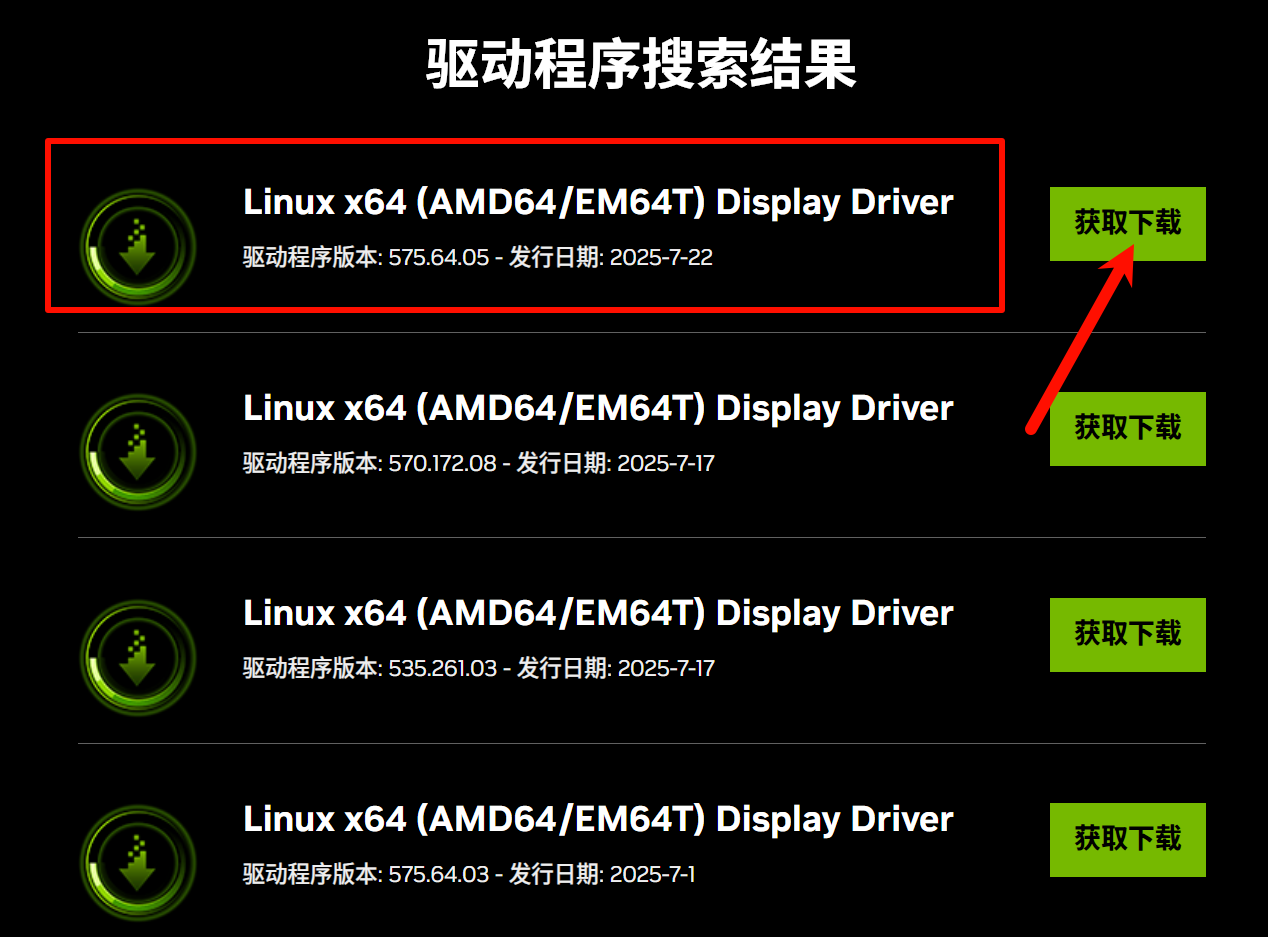

有多个版本可供选择,我这里直接下载最新的,点击获取下载

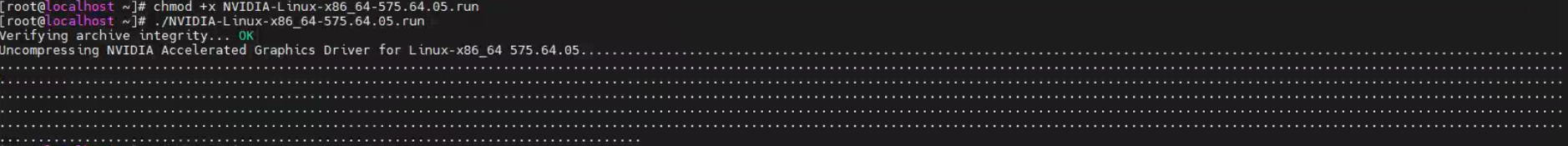

下载好之后通过STFP上传到服务器,给可执行权限后进行安装

#给驱动添加可执行权限,*代表驱动版本

chmod +x NVIDIA-Linux-x86_64-*.run

#执行驱动安装

./NVIDIA-Linux-x86_64-*.run

这里是问你装专用驱动还是开源驱动,建议是专用驱动NVIDIA Proprietary

这里是问是否需要下载32位兼容性库,一般来说用不上,选择NO即可

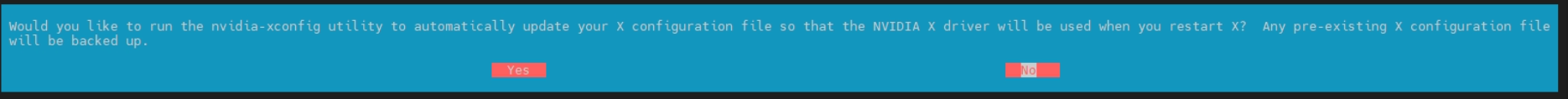

这条提示是在问你是否要运行 nvidia-xconfig 工具自动更新 X 配置文件,建议选 Yes,工具会自动调整配置,让电脑重启图形界面后,用 NVIDIA 驱动渲染画面;同时会备份原来的 X 配置文件,不用担心原配置丢失。要是选 No,就得自己手动改 X 配置文件,否则 NVIDIA 驱动可能没法正常接管图形输出,比如重启后分辨率异常、显卡没启用等。

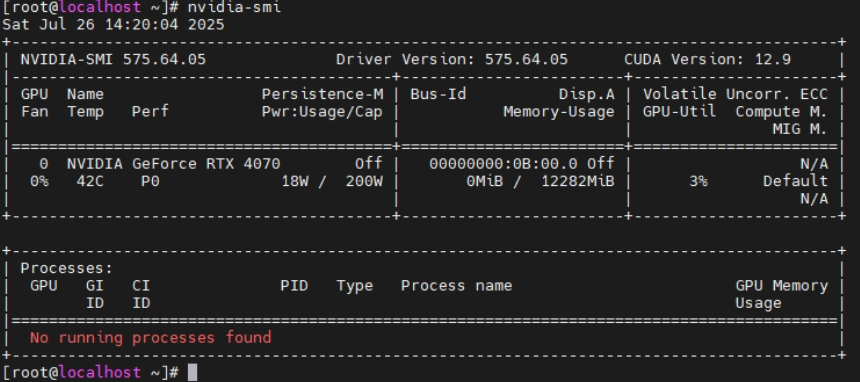

安装好了之后,用命令查看显卡信息

#查看显卡信息命令

nvidia-smi

驱动安装之后我们开始安装CUDA,驱动版本不同我们安装的CUDA版本也不同,如上图命令输出就可以看到575版本的显卡驱动(右上角的CUDA Version),建议CUDA12.9

我们到CUDA官方,网址为:

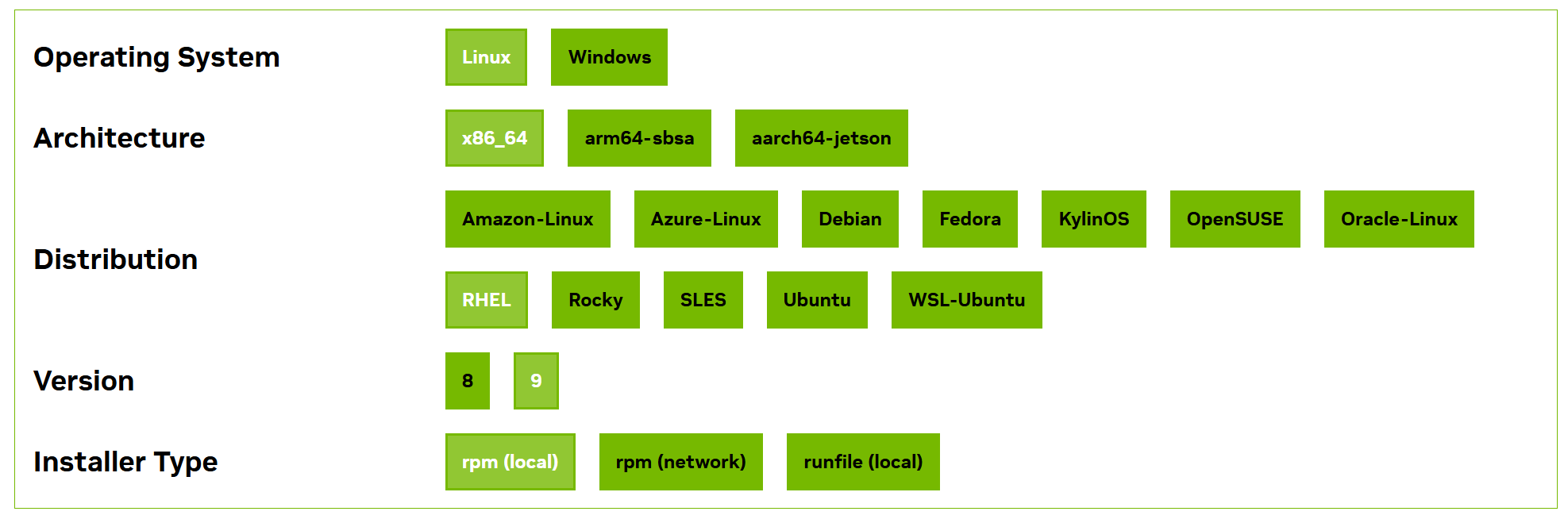

CUDA Toolkit 12.9 Update 1 Downloads | NVIDIA Developer![]() https://developer.nvidia.com/cuda-downloads选择系统版本(almalinux以及rockylinux都是rhel;版本8.*就选Version 8,版本9.*就选Version 9)以及安装方式,我这里还是选择rpm(local)下载到本地安装

https://developer.nvidia.com/cuda-downloads选择系统版本(almalinux以及rockylinux都是rhel;版本8.*就选Version 8,版本9.*就选Version 9)以及安装方式,我这里还是选择rpm(local)下载到本地安装

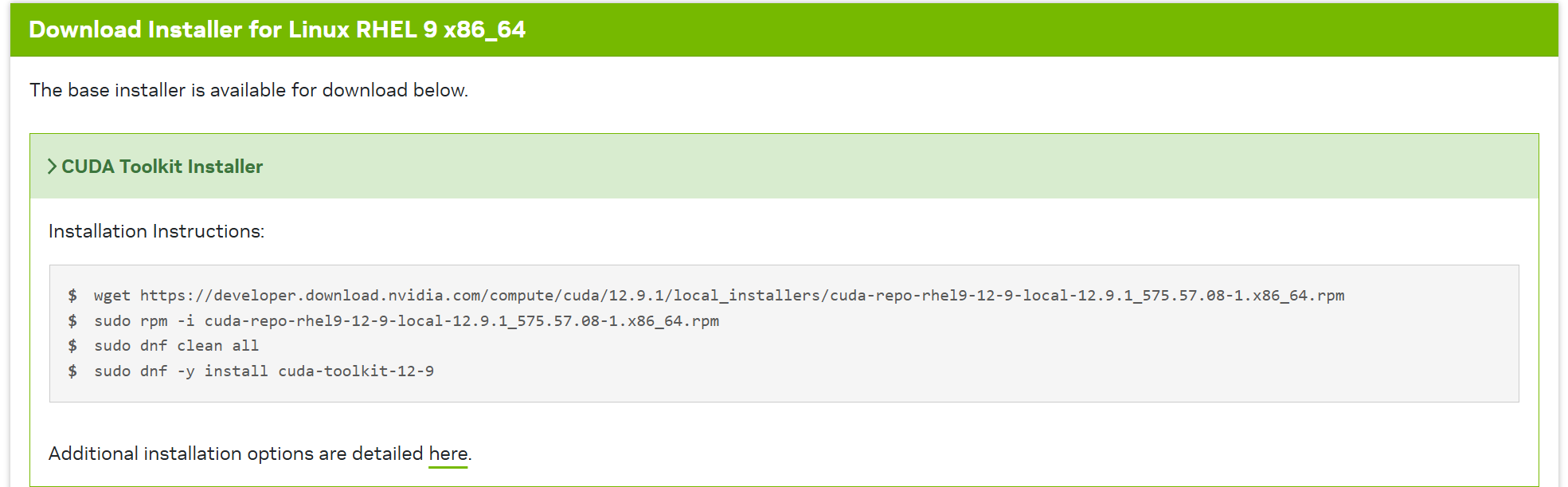

选好之后,会给我们对应的安装命令,按照官方给出的命令输入即可(这里使用了wget命令,如果没有安装使用 dnf install wget -y 进行安装即可)

安装截图如下

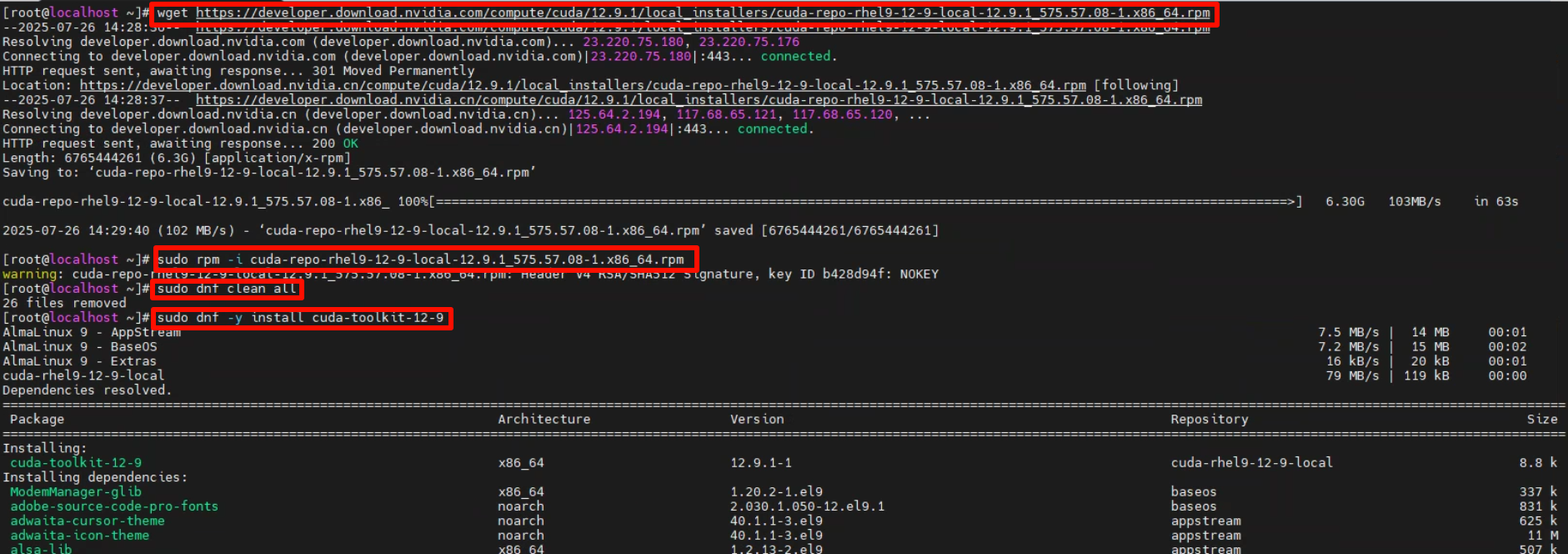

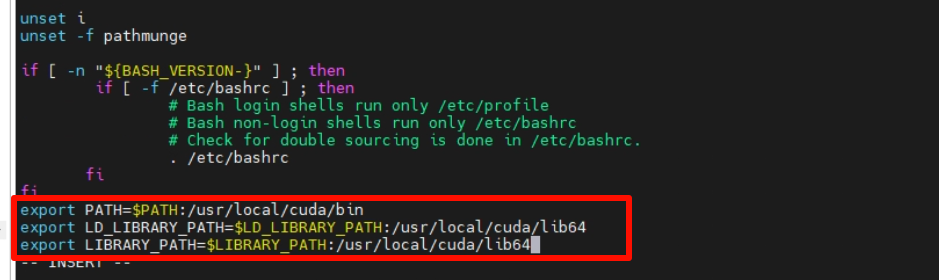

安装好之后,我们还需要修改一下环境变量,编辑文件/etc/profile,添加以下内容

export PATH=$PATH:/usr/local/cuda/bin

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/usr/local/cuda/lib64

export LIBRARY_PATH=$LIBRARY_PATH:/usr/local/cuda/lib64

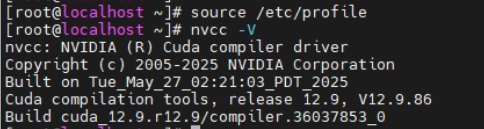

保存好之后,用命令重新加载一下环境变量配置文件

#重新加载环境变量配置文件

source /etc/profile使用命令即可查看到CUDA的版本信息

#查看CUDA版本信息

nvcc -V

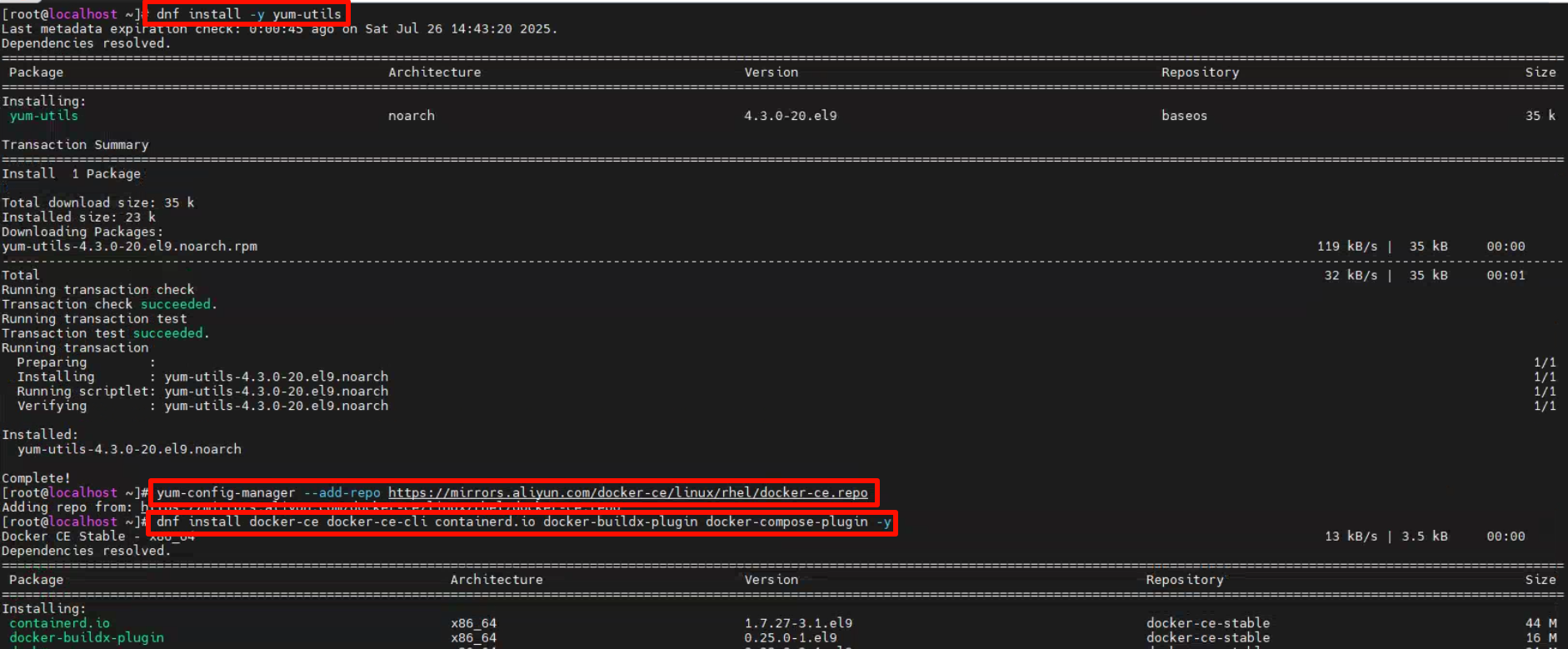

2.docker安装以及镜像拉取

首先我们需要添加一下docker的软件源,然后再开始安装,命令为

#安装yum-utils工具

dnf install -y yum-utils

#添加阿里云镜像站的docker软件源

yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/rhel/docker-ce.repo

#安装docker

dnf install docker-ce docker-ce-cli containerd.io docker-buildx-plugin docker-compose-plugin -y

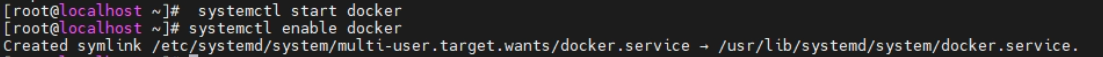

安装好之后,我们启动docker,并设置docker服务自启动,命令为

#启动docker

systemctl start docker

#设置docker服务自启动

systemctl enable docker

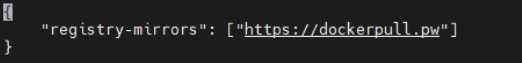

这个时候,docker已经好了,但是不配置加速器的情况下,我们无法拉取docker镜像,我们编辑文件 /etc/docker/daemon.json,将内容修改为:

{"registry-mirrors": ["https://dockerpull.pw"]

}

修改后我们需要重启docker

#重启docker

systemctl restart docker![]()

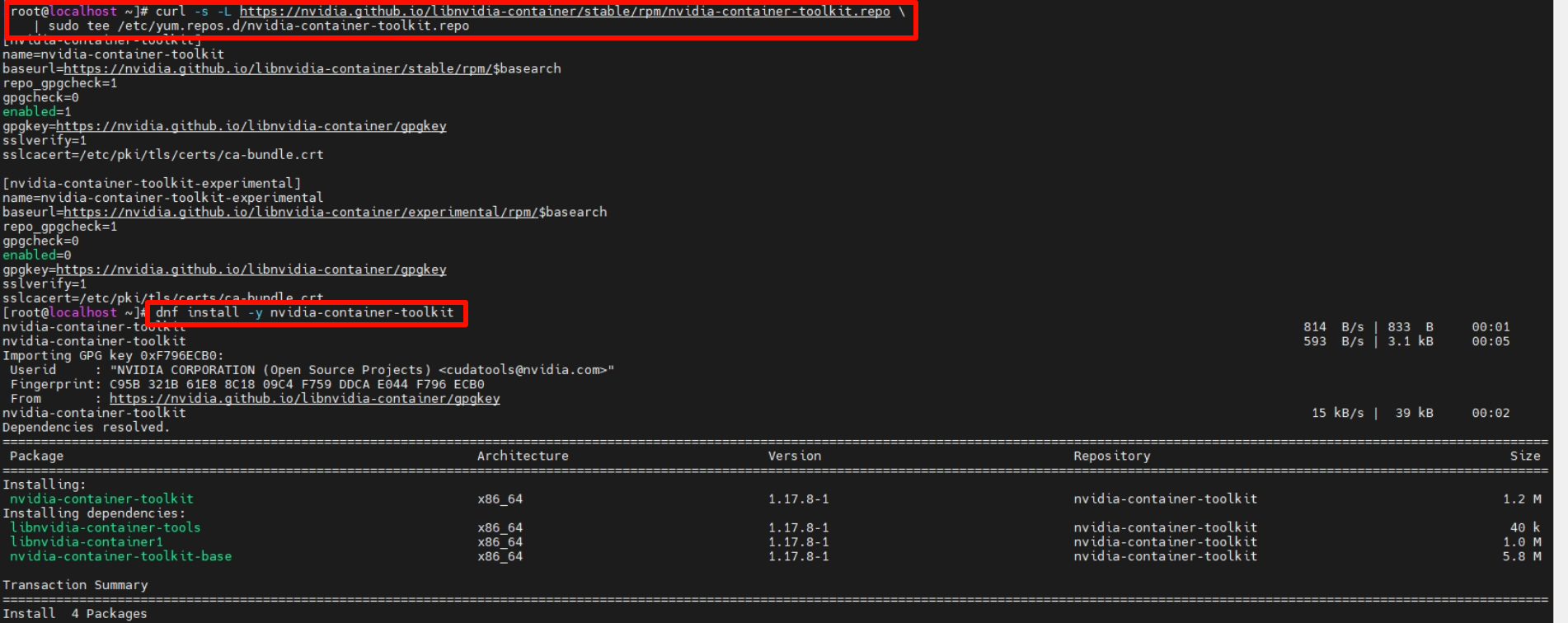

加速器配置之后,我们还有一个事情要做,正常情况下docker无法调用gpu的,我们需要安装NVIDIA容器支持包才可以让docker调用GPU,首先我们先添加NVIDIA容器包的软件源,再进行安装

#添加NVIDIA容器支持包的软件源

curl -s -L https://nvidia.github.io/libnvidia-container/stable/rpm/nvidia-container-toolkit.repo \| sudo tee /etc/yum.repos.d/nvidia-container-toolkit.repo

#安装NVIDIA容器支持包

dnf install -y nvidia-container-toolkit

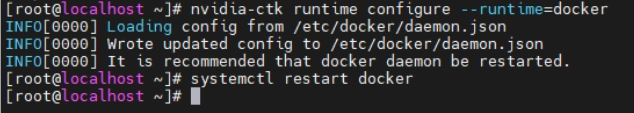

安装好了,配置一下命令让docker能够使用NVIDIA的GPU,然后重启docker

#让 Docker 容器能够访问和使用宿主机上的 NVIDIA GPU 资源

nvidia-ctk runtime configure --runtime=docker

#重启docker

systemctl restart docker

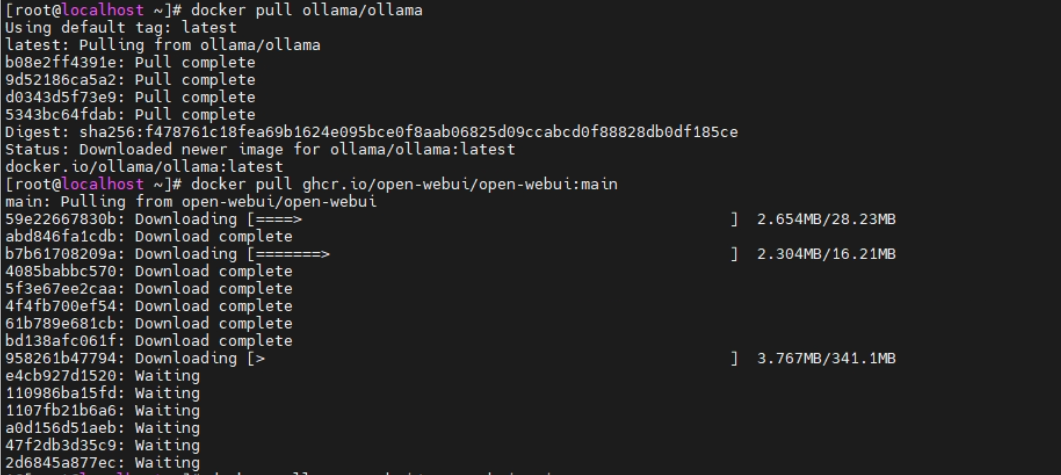

配置工作都做完了,我们开始拉取Ollama以及OpenWebUI镜像

#拉取ollama镜像

docker pull ollama/ollama

#拉取openwebui镜像

docker pull ghcr.io/open-webui/open-webui:main

#如果openwebui卡顿,换成国内源

docker pull swr.cn-north-4.myhuaweicloud.com/ddn-k8s/ghcr.io/open-webui/open-webui:v0.6.9

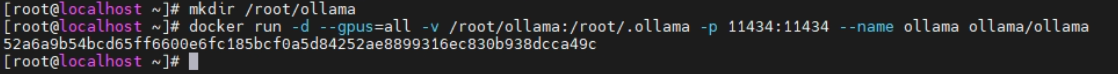

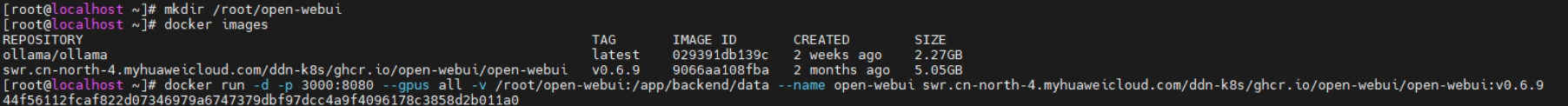

3.创建ollama及open-webui容器

创建ollama的文件夹,用于docker文件夹映射

#创建ollama文件夹

mkdir /root/ollama

#创建并启动ollama的容器

docker run -d --gpus=all -v /root/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

用ollama下载并启动qwen2.5-7b

#到ollama容器启动ollama run qwen2.5:7b命令(意思是下载并启动qwen2.5-7b模型)

docker exec -it ollama ollama run qwen2.5:7b

模型启动成功后,我们开始docker部署open-webui

#创建open-webui文件夹

mkdir /root/open-webui

#创建并启动open-webui的容器(如果镜像是ghcr.io/open-webui/open-webui:main那么命令就是docker run -d -p 3000:8080 --gpus all -v /root/open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main)

docker run -d -p 3000:8080 --gpus all -v /root/open-webui:/app/backend/data --name open-webui swr.cn-north-4.myhuaweicloud.com/ddn-k8s/ghcr.io/open-webui/open-webui:v0.6.9

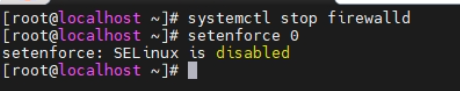

关闭防火墙和selinux

#关闭防火墙

systemctl stop firewalld

#关闭selinux

setenforce 0

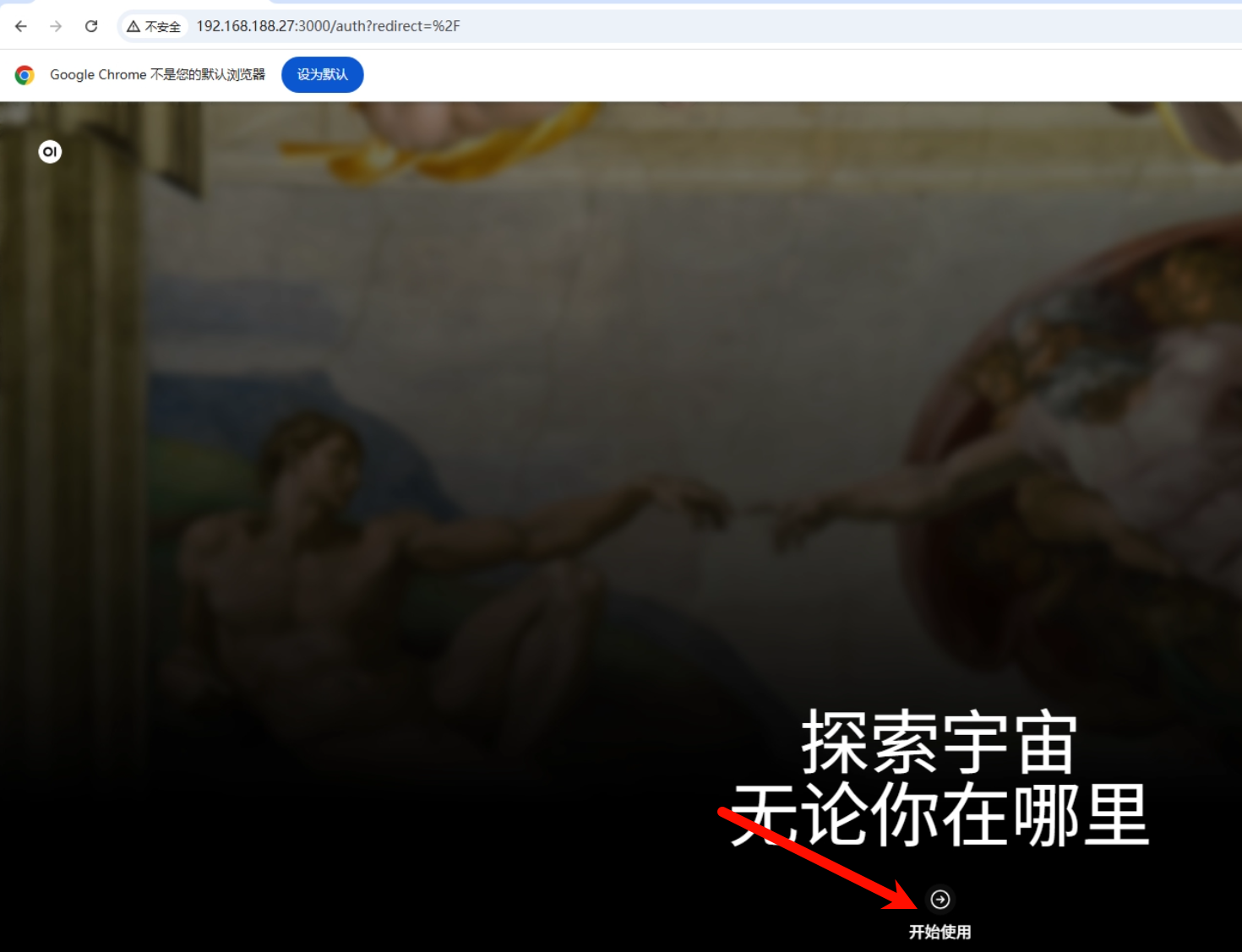

4.配置open-webui连接ollama

进入 http://服务器IP:3000 页面,点击开始使用

创建用户,信息请自行填写,然后点击创建管理员账号

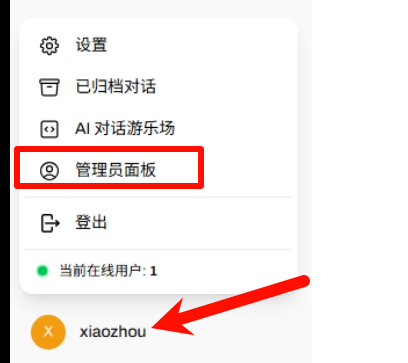

点击左下角的用户名,然后点击管理员面板

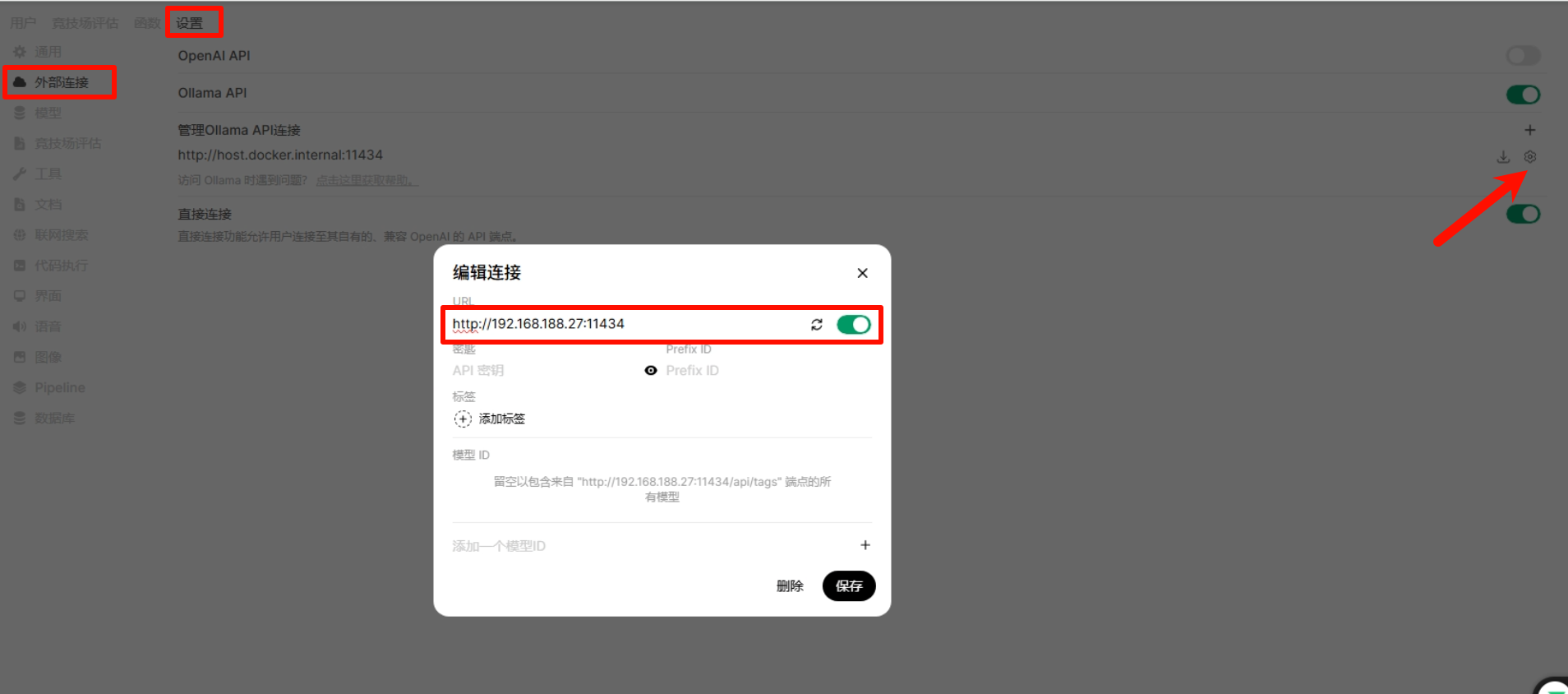

点击左上角的设置-外部连接-ollama API,然后找到齿轮设置,修改URL为 http://服务器IP:11434,然后点击保存

点击左上角的新对话,即可进入文本输入界面,可以看到我们ollama跑的qwen2.5-7B模型;正常输入获取回复,到这一步基于almalinux9.6的ollama部署qwen2.5-7B就完成了