LLM重排器落地难题:如何破解速度与精度的工程困局?

用大模型重排搜索结果效果惊艳,但延迟和成本吓退无数团队。真正的挑战不在技术可行性,而在工程落地。

在构建 RAG(检索增强生成)系统时,许多开发者都遇到过一个两难选择:使用传统的检索模型(如 BM25、Embedding),结果相关性总不尽如人意;改用强大的 LLM(大语言模型)作为重排器(Reranker),效果显著提升,但延迟和成本却高得无法接受。

这正是 Jeff 在访谈中暗示的痛点——“如今在生产应用中不这么做,也有很好的理由”。解决这个矛盾,正是“上下文工程师”的核心价值所在。这并非非黑即白的选择,而是一个需要系统化工程权衡的过程。

一、问题核心:为什么LLM重排器这么“慢”?

简单算一笔账就明白了:

传统检索:从百万级向量库中召回 300 个候选片段,耗时约 50-200 毫秒

LLM 重排:用大模型对这 300 个片段进行精细排序,即使使用 GPT-3.5,也可能需要 5-10 秒

用户无法接受一个搜索请求需要 10 秒才能返回结果。这就是落地的主要障碍。

二、破解策略:三位一体的工程解决方案

策略一:优化重排器自身(让LLM跑得更快)

1. 选择小而专的模型

绝对不要用 GPT-4 这类巨型模型做重排。重排任务不需要强大的世界知识或创造力,应该选择轻量级开源模型:

Llama-3-8B-Instruct

Mistral-7B

专门为重排任务微调的小模型(如低于 1B 参数的专用模型)

2. 极致精简Prompt设计

糟糕的Prompt设计会浪费大量token和推理时间:

# 反例:冗长的Prompt(低效)

prompt = f"""

你是一位世界级文档分析专家。请仔细阅读以下文本,判断它与用户问题的相关性。

请给出详细解释,然后输出一个1-10的相关性评分。问题: {query}

文本: {chunk}请开始分析:

"""# 正例:极致精简的Prompt(高效)

prompt = f"""

问题: {query}

文本: {chunk}

相关性(1-10):

"""

3. 推理优化技术

自托管模型时可采用这些加速方案:

使用 vLLM 或 TensorRT-LLM 等高性能推理框架

对模型进行量化(如 FP16 到 INT4/INT8)

启用连续批处理(Continuous Batching)优化吞吐量

策略二:优化重排流程(减少工作量)

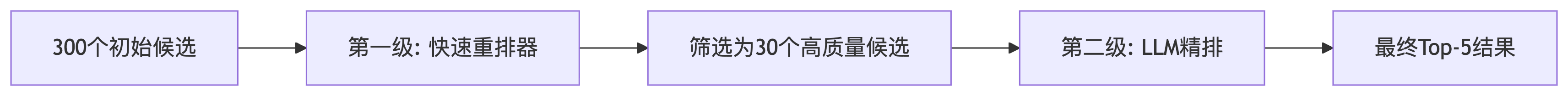

4. 二级重排漏斗(最实用方案)

这是业界最常用的策略,避免让LLM直接处理大量候选:

图表

第一级快速重排器可选择:

Cohere/TogetherAI的专业重排API

交叉编码器(Cross-Encoder)小型模型

优化的传统算法(如BM25+)

5. 并行处理请求

LLM重排请求可以并行发送,大幅减少总延迟:

import asyncioasync def parallel_rerank(query, chunks):tasks = []for chunk in chunks:task = call_llm_rerank(query, chunk) # 异步调用tasks.append(task)results = await asyncio.gather(*tasks)return sorted(results, key=lambda x: x.score, reverse=True)6. 超时与服务降级机制

为LLM重排设置严格超时,准备降级方案:

try:results = await asyncio.wait_for(parallel_rerank(query, chunks),timeout=1.5 # 设置1.5秒超时)

except asyncio.TimeoutError:results = fallback_rerank(query, chunks) # 降级到快速方案策略三:优化用户体验(让用户感知不到慢)

7. 流式响应与渐进增强

这是产品设计层面的高阶解决方案:

即时响应:先展示快速检索结果

后台处理:同时进行LLM精排

无缝更新:完成后动态增强结果

前端实现示例:

// 1. 立即显示初步结果

displayInitialResults(quickResults);// 2. 后台启动精排

startLLMReranking(query, chunks).then(enhancedResults => {// 3. 非侵入式更新界面highlightTopResults(enhancedResults);addSmartSummary(enhancedResults);

});这种方案让用户感觉系统“瞬间响应”,同时又获得了高质量的排序结果。

三、实战建议:不同场景的权衡策略

根据你的应用场景,可以选择不同的策略组合:

| 应用场景 | 延迟要求 | 推荐策略 | 可接受延迟 |

|---|---|---|---|

| 实时搜索/交易 | 极严格(<500ms) | 快速模型+超时降级 | 300-500ms |

| 企业知识库 | 中等(<3s) | 二级重排+并行处理 | 1-2s |

| 研究分析工具 | 宽松(>5s) | 完整LLM重排+流式输出 | 5-10s |

四、总结:没有银弹,只有权衡

LLM重排器的落地是一个典型的工程权衡问题,需要在效果、延迟和成本之间找到最佳平衡点。关键收获:

不要用大炮打蚊子:选择与任务匹配的模型规模

分层处理是王道:二级重排漏斗是最实用的架构模式

用户体验是关键:通过流式响应让用户感知不到延迟

永远要有Plan B:超时降级机制是生产环境的必需品

优秀的工程不是追求理论上最优解,而是为特定场景找到最合适的解决方案。通过本文介绍的策略组合,你完全可以构建出既智能又高效的LLM重排系统。

思考题:你的项目中,是否遇到过效果与性能的权衡困境?最终采取了什么解决方案?欢迎在评论区分享你的经验!**