《打造自己的DeepSeek》第2期:怎么安装自己的DeepSeek?

上一期介绍了为什么要打造自己的 DeepSeek,本期将介绍怎么安装自己的 DeepSeek。

这里要使用的工具是 Ollama。

它是一个免费开源的本地大语言模型运行平台,可以帮我们把 DeepSeek 模型下载到我们自己的电脑上运行,支持 Windows、MacOS 和 Linux 三大主流操作系统(本月 8 日,华为发布了鸿蒙电脑操作系统,相信在不久的将来,Ollama 也会支持)。

具体的部署步骤如下:

一、下载 Ollama

- 访问 Ollama 官网:www.ollama.com

可以看到,除了 DeepSeek R1,它还支持很多其他的开源模型。

至于为什么没有大名鼎鼎的 ChatGPT,当然是因为它不开源了(研发它的公司叫做 OpenAI,以 Open 为名,却从不开源,应该叫 “CloseAI” 才是)。

这里以部署 DeepSeek R1 为例,其他开源模型部署的步骤是大同小异的,大家可以自行尝试。

- 点击“Download”进行下载:

这里自动识别了电脑的操作系统,我的电脑是 Windows 系统,这里就以 Windows 为例演示了,其他系统步骤大同小异。

二、安装 Ollama

Ollama 的安装非常简单。

- 打开安装程序,点击“Install”即开始安装,没有多余选项。

- 按键盘上的 Win + R 键,在弹窗中输入

cmd

点击“确定”,打开命令窗口:

- 输入

ollama,点击回车,如果出现如下输出,代表 Ollama 安装成功。

三、下载 DeepSeek R1 模型

- 回到 Ollama 官网首页,点击 “DeepSeek R1”:

会进入到 DeepSeek R1 模型的下载主页:

点击这里可以看到 DeepSeek R1 不同量级模型对应的显存要求列表:

数字后面的 b 是 billion 的缩写,代表十亿个参数,参数量越大代表得到的回答的质量也就越高,但相对的对配置的要求也越高。

- 如果电脑只有集显,就选择 1.5b 的模型。

- 如果是统一架构的 CPU,一部分内存可以当显存用,根据可以当作显存使用的内存大小选择模型。

- 如果电脑有独立显卡,根据显存大小选择模型。

- 至于 671b,显存要求高达 404GB!它是大家现在使用的公版 DeepSeek 的量级,个人电脑几乎不可能达到,一般都是大公司部署使用。

这里我们以配置要求最低的 1.5b 模型进行演示。

- 下滑找到 1.5b 模型对应的安装命令,“复制”命令:

- 回到刚才打开的命令窗口,“粘贴”命令:

点击“回车”运行:

当看到输出“success”,即代表安装成功。

这里其实已经可以使用 DeepSeek 了,比如:

但这样的命令行方式显然很不方便,所以还需要使用第三方工具,实现类似于官网那样的使用体验。

四、下载 Cherry Studio

- 访问 Cherry Studio 官网:www.cherry-ai.com

- 点击“下载客户端”进行下载:

这里根据自己的系统架构进行选择:

- 如果是 x86 64 位架构,就选择 “x64”选项。

- 如果是 ARM 64 位架构,就选择“ARM64”选项。

这里很好判断,个人电脑目前除了苹果的 M 系列芯片电脑以及本月 19 号发布的华为鸿蒙电脑,都是 x86 64 位架构的。

我的电脑是 x86 64 位的:

五、安装 Cherry Studio

- 打开安装程序:

指定想要安装的目录,进行安装:

出现如下界面代表安装完成:

六、使用 Cherry Studio

- 打开安装好的 Cherry Studio:

- 点击左下角的“设置”按钮:

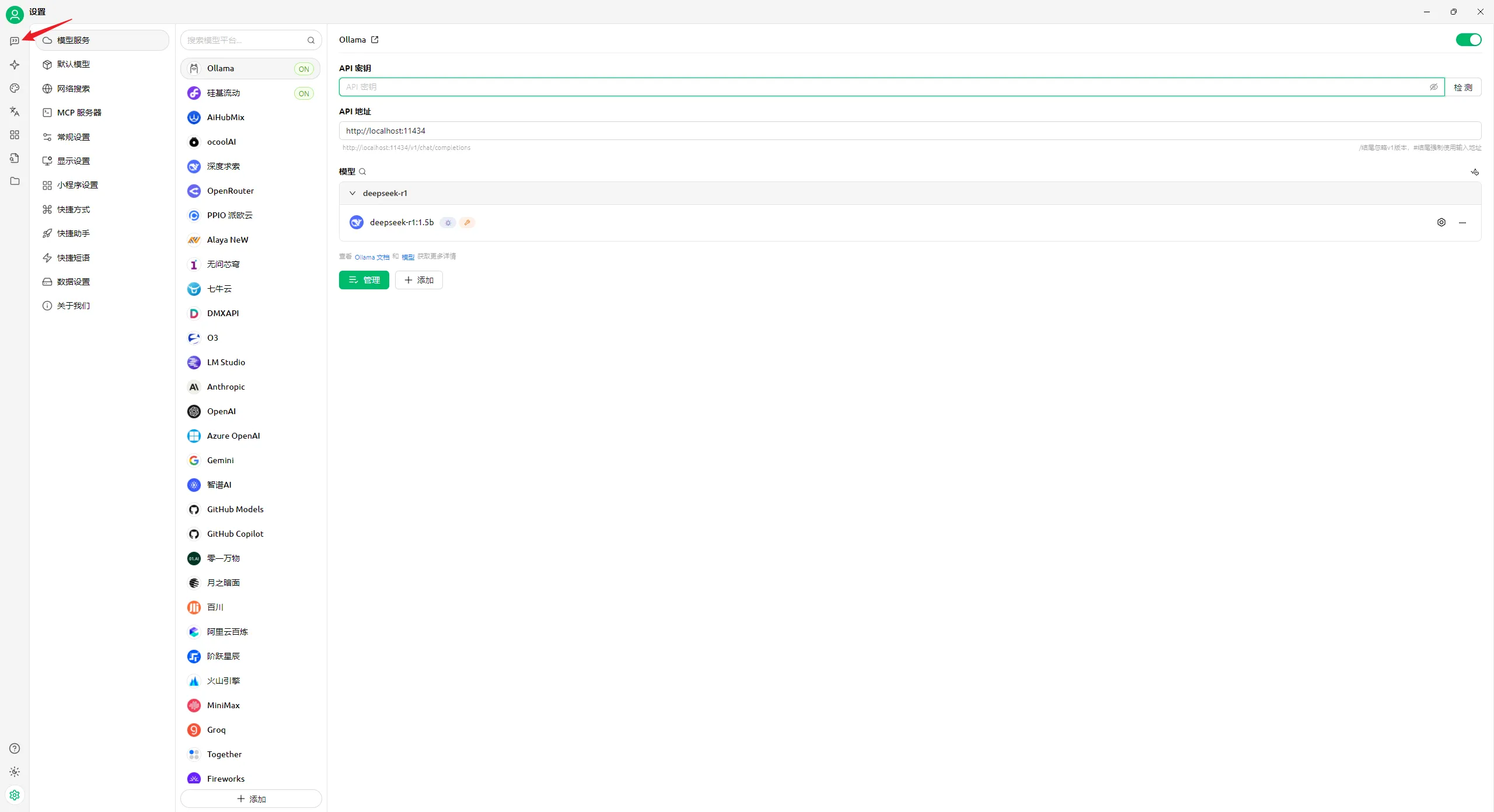

- 在模型服务中选择“Ollama:

- 打开顶部的开关:

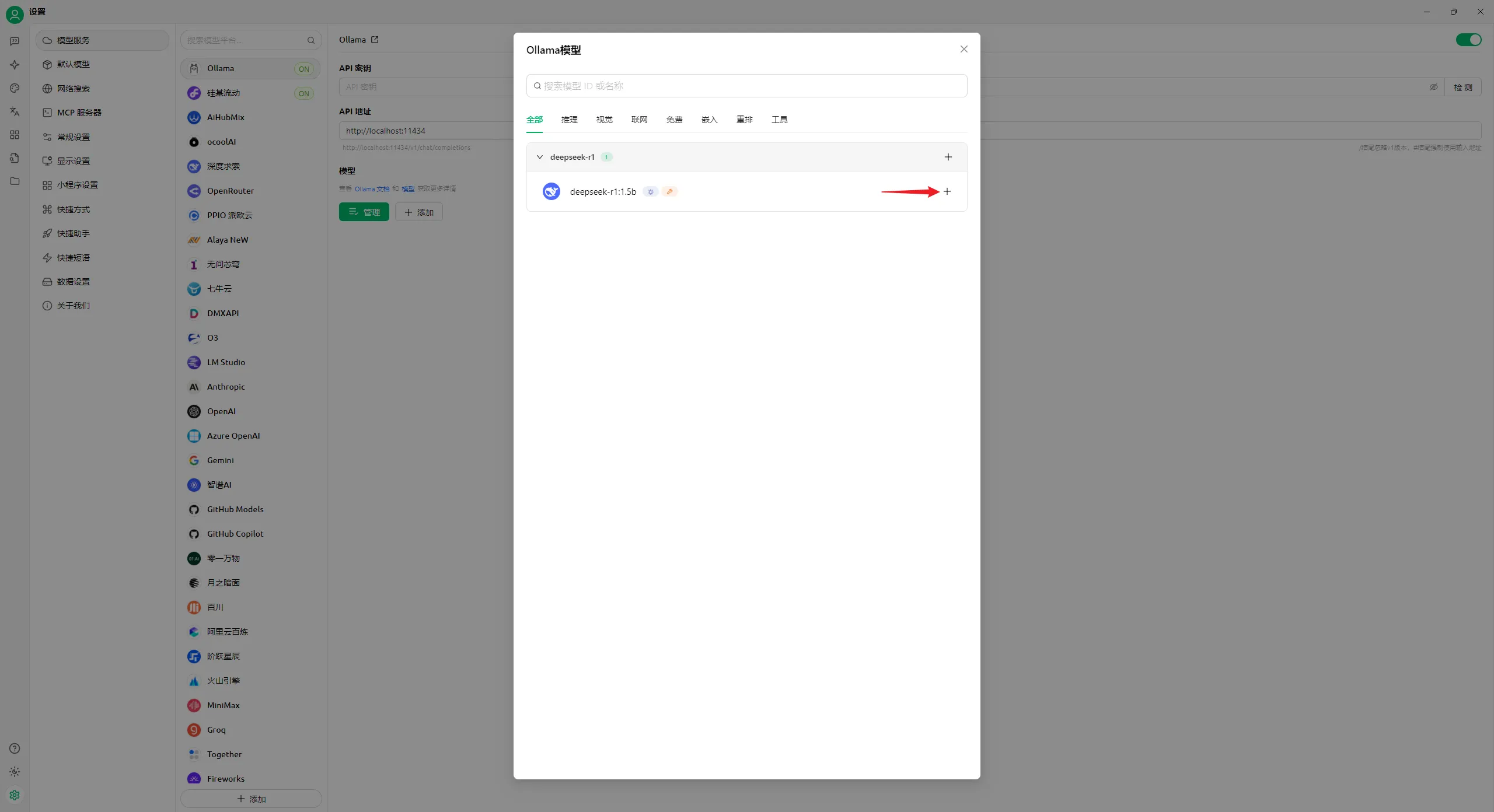

- 点击“管理”按钮:

- 添加刚才下载的 DeepSeek 模型:

关闭对话框:

- 关闭其他模型的开关:

- 回到主页的对话界面:

这样就可以跟平时一样与 DeepSeek 对话了:

如果安装了多个 DeepSeek 模型,还可以点击顶部切换:

这样就完成了自己的 DeepSeek 安装。

电脑重启后会在系统右下角有 Ollama 的图标,代表 Ollama 正在运行:

如何不想运行,右键点击退出即可:

如果想要再次使用按 Win 键搜索“Ollama”即可打开:

然后打开 Cherry Studio 即可直接使用: