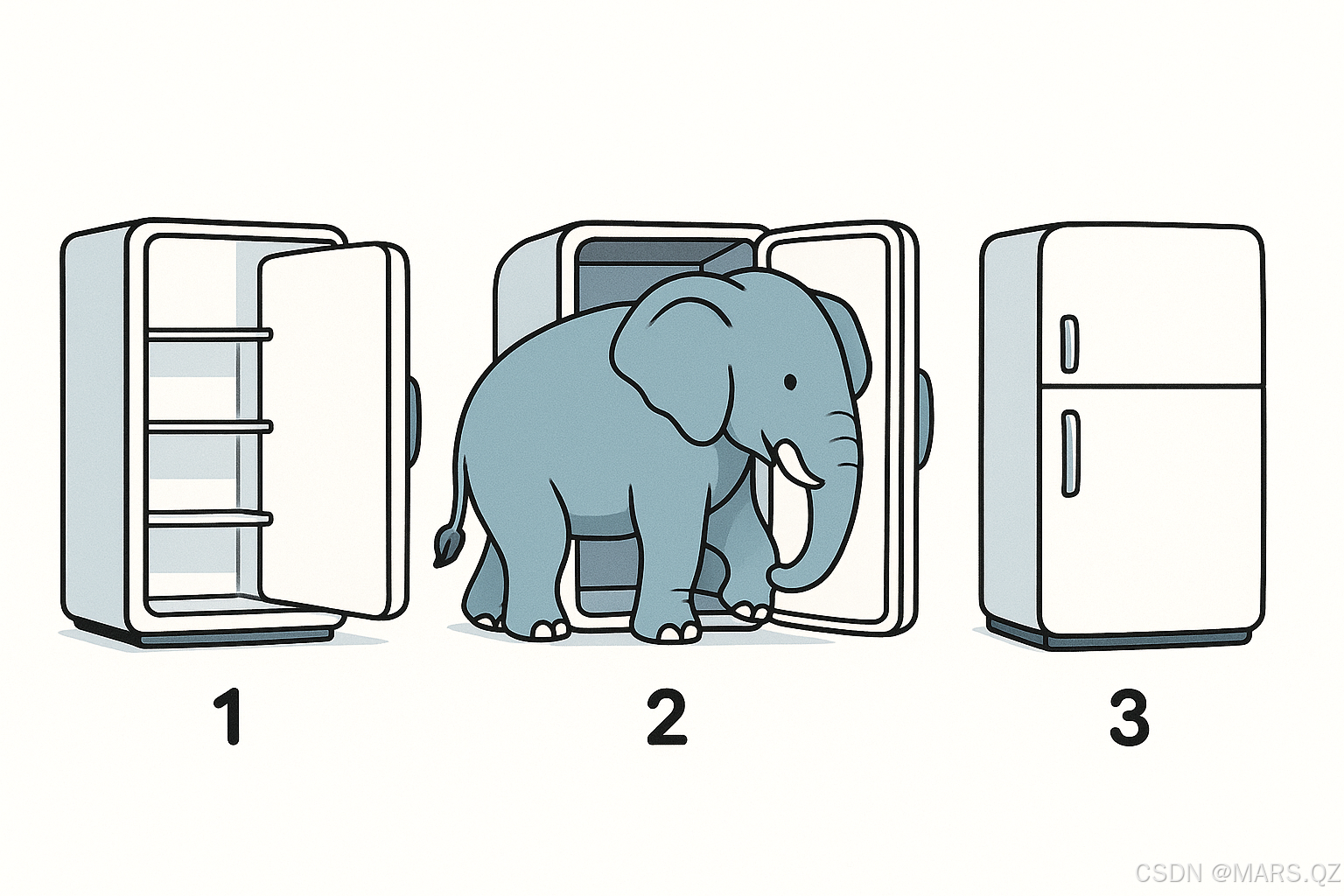

将大象装进冰箱里需要几步?- Edge AI模组的部署

下面结合一个典型的视频处理大模型在边缘设备(Edge)上部署到 GPU/NPU 上的全过程,从技术角度细分所需步骤和需要评估的各类资源指标。本文假设视频处理大模型(比如用于实时目标检测、语义分割、动作识别等)已经在服务器端完成了训练,接下来要将其移植到具备 GPU 或 NPU 加速能力的端侧硬件上运行。

一、总体流程与关键阶段

将一个视频处理大模型部署到端侧 GPU/NPU,一般可分为以下几个大阶段:

- 需求与硬件选型阶段

- 确定目标应用场景:实时性需求(帧率)、推理延迟上限、功耗预算、部署环境(无人机、安防摄像头、车载设备等)。

- 根据场景选定候选硬件:边缘 GPU(如 NVIDIA Jetson 系列)或特定 SoC 内置 NPU(如 Qualcomm Snapdragon、MediaTek NeuroPilot、Rockchip NPU、华为麒麟/昇腾芯片等)。

- 模型分析与预评估阶段

- 模型规模与计算复杂度:统计原始模型的参数量(如权重总大小),FLOPs(浮点运算次数),以及特定算子(卷积核、Transformer Attention 等)的占比。

- 输入尺寸与帧率需求:例如,1920×1080 分辨率视频流 30 FPS;或 1280×720×60 FPS。计算单帧处理时的算力和内存需求。

- 目标精度与可容忍精度损失:确定量化后可接受的精度下降(如 Top-1/Top-5 相对基线下降 <1–2%)。

- 模型优化与转换阶段

- 剪枝与蒸馏(可选):若原始模型过大,可先在服务器端做网络剪枝(filter/通道剪枝)或知识蒸馏,得到一个轻量化版本。

- 量化:根据目标硬件支持情况选择静态量化(PTQ)或量化感知训练(QAT)策略。最常见是 INT8 量化,也可考虑混合精度 FP16/FP32 或 BF16。

- 算子融合与替换:将可融合的算子序列(如 Conv → BatchNorm → ReLU)在导出阶段直接“焊接”在一起;对于在目标硬件上不被支持的自定义算子,要么拆分为基础算子,要么编写自定义插件。

- 导出与转换为硬件中间格式:

- GPU 路径:导出为 ONNX、TF SavedModel、TorchScript 等通用格式,然后用 TensorRT(NVIDIA GPU)做“ONNX → TensorRT Engine”转换;

- NPU 路径:导出为 ONNX / TF Lite / Paddle Lite / Caffe 等格式,通过厂商提供的编译器(如 RKNN-Toolkit、HiAI Compiler、Qualcomm SNPE、MediaTek NeuroPilot、Huawei ACL)转换为 NPU 专用二进制模型(如 .rknn、.tflite、.om、.nb 等形式)。

- 跨平台验证与性能调优阶段

- 性能基准测试(Benchmark):在目标硬件上测量推理延迟(Latency)、吞吐量(Throughput)、功耗(Power Consumption)、内存占用(Memory Footprint);视需求报告单帧延迟、端到端管道延迟(含解码、预处理、推理、后处理)。

- 精度验证:用一组代表性视频或图片帧,计算量化/融合后模型的精度与原始模型的差异。若下降超出容忍范围,需要微调量化参数或重新做 QAT。

- 调度与多线程/异步优化:针对 GPU 做 CUDA 流(Stream)并行、Batch 调度,或针对 NPU 做异步 DMA(Direct Memory Access)+ CPU 协同;保证推理与视频解码/渲染解耦,减少管线阻塞。

- 集成与部署阶段

- 推理框架集成:在应用程序中集成相应的运行时库(如 TensorRT Runtime、CUDA/cuDNN、ONNX Runtime、Tengine、RKNN Runtime、Android NNAPI、华为 HiAI DLL)。

- 异构调度与容错:实现当 NPU 资源不足时自动降级到 CPU 或 GPU 推理,以及当 GPU 硬件负载过高时切换到更低精度模式。

- 系统级部署:打包为可执行文件或 APK,包含模型文件、运行时依赖、摄像头/视频流采集驱动、硬件加速库和应用代码,最终在目标设备上进行 OTA/USB 方式推送部署。

二、各阶段所需评估的关键资源指标

下面罗列在上述流程中,工程师需要重点关注和评估的资源维度,以及常用的评估方法或工具。

1. 算力与吞吐(Compute & Throughput)

- TOPS(Tera Operations Per Second)或 TFLOPS

- 目标硬件指标:GPU(如 Jetson Nano = ~0.5 TFLOPS FP16;Xavier NX = ~21 TOPS INT8)或 NPU(如 RK3399Pro NPU = ~3 TOPS INT8;Kirin/Ascend NPU = 2–8 TOPS)官方数据手册。

- 模型需求估算:根据模型的 FLOPs 统计(如 10 GFLOPs/帧),计算在所需帧率下每秒需要的总 FLOPs(帧率 × 单帧 FLOPs),对比分配到硬件 TOPS 是否足够。

- 算子并行度与吞吐测试

- GPU:用 nvidia-smi、tegrastats(Jetson 系列),或在代码中插入 NVProf/NSight 进行核函数(kernel)级别的吞吐分析。

- NPU:使用厂商 SDK(如 RKNN Benchmark、HiAI Tester、SNPE Benchmark)测量单个算子或整个模型在 NPU 上的实际 TOPS 与延迟。

2. 延迟与实时性(Latency)

- 端到端推理延迟

- 包含:视频帧解码 → 图像预处理(Resize、Normalize、NCHW/NHWC 转换) → 数据传输(CPU → GPU/NPU) → 推理 → 后处理(NMS、可视化) → 展示/输出。

- 用时测量:在 C++/Python 程序中使用高精度计时器(如 std::chrono、gettimeofday、cv::TickMeter)分别统计每个阶段耗时,对瓶颈阶段进行优化。

- 算子级延迟剖析

- GPU:在 CUDA 代码中通过 cudaEvent_t 记录 kernel 启动延迟与执行时长;或借助 NVIDIA Nsight Compute/Systems 采集算子时间。

- NPU:NPU SDK 通常会在日志中输出各算子耗时,通过 rknn_query (RKNN)或类似 API 统计每层推理时长,用于发现哪些算子在 NPU 上最耗时。

3. 内存占用与带宽(Memory & Bandwidth)

- 模型大小(Disk + 内存)

- 加载内存需求:量化后模型文件大小(如原始 FP32 模型 200 MB,INT8 量化后约 50 MB)。

- 运算临时内存:推理时中间张量在 GPU 全局内存或 NPU 片上 SRAM/DRAM 的占用,可通过工具(nvidia-smi)或 SDK 查询算子执行时峰值内存。

- 带宽瓶颈:解码视频后作为连续帧流,若要每帧都进行 CPU→GPU/NPU 数据拷贝,需评估 PCIe/AXI/DDR 带宽是否满足。如 Jetson Nano 的 LPDDR4 带宽约 25.6 GB/s,可承载 1080p×30 FPS FP16 模型,但对于高分辨率 4K 场景可能不足。

- 缓存利用与存储优化

- GPU:要关注 L2 Cache / Shared Memory 使用率,可借助 Nsight Compute 关注内存访存占比。对卷积算子可通过 cudnnGetConvolution*WorkspaceSize 获取所需临时空间并预先分配,避免多次申请释放。

- NPU:关注片上 SRAM 分区,保证算子流水线中各输入、输出张量都能驻留在片上;若超出容量,只能回退到 DRAM 交换,导致能效大幅下降。

4. 功耗与热设计(Power & Thermal)

- 功耗测量

- GPU:Jetson 平台可用 tegrastats 报告实时功耗;NVIDIA GPU 可借助 nvidia-smi --query-gpu=power.draw 或外部功率计测量整机功耗。

- NPU:某些 SoC(如麒麟、骁龙)提供 PMU(Performance Monitoring Unit)指标,也可通过外部功率计监测 SoC 运行时功耗。

- 热设计指标

- 持续负载下温度:在连续推理(如 30 FPS 1080p 时)下测量芯片核心温度,如果超过安全阈值(如 Jetson Nano 建议不超 85 °C),需要额外散热(风扇、散热片)。

- 功耗模式调节:部分平台可选省电模式(如 Jetson 的 nvfanctl、tegra_power_model),或 NPU 自动调节量化精度(FP16→INT8),以控制功耗与温度。

5. 精度与可接受降级(Accuracy & Trade-off)

- 量化精度损失评估

- 比较原始 FP32 模型与量化后模型(INT8/FP16)的 Top-N 精度、错检率、漏检率等核心指标。若因量化导致精度损失超过可接受范围,就需要:

- 做量化感知训练(QAT);

- 对敏感层保持高精度(混合精度);

- 在端侧进行量化后微调。

- 比较原始 FP32 模型与量化后模型(INT8/FP16)的 Top-N 精度、错检率、漏检率等核心指标。若因量化导致精度损失超过可接受范围,就需要:

- 网络架构替换/剪枝效果

- 若模型在 NPU 上性能仍不足,可考虑在服务器端先做剪枝或蒸馏得到小模型,再在端侧部署,以权衡精度与速度。

三、典型部署步骤示例

下面以“ONNX 模型 → NVIDIA Jetson Nano 上 FP16 推理”和“ONNX 模型 → RK3399Pro NPU 上 INT8 推理”两条路线,分别说明具体的操作步骤与注意事项。

1. ONNX → NVIDIA Jetson Nano(FP16/TensorRT)

(1)环境准备与依赖安装

- Jetson Nano 开发板系统:JetPack 4.x(包含 CUDA 10.x、cuDNN、TensorRT)。

- 在主机/开发板上安装 PyTorch/TensorFlow,确认可以正常导出 ONNX。

- 安装 trtexec 工具(随 TensorRT 一起提供),用于快速构建和 Benchmark。

(2)模型导出

- 在服务器或开发板上加载训练好的 PyTorch/TF 模型(FP32),以 ONNX 格式导出:

import torch

model.eval().cuda()

dummy = torch.randn(1, 3, H, W).cuda()

torch.onnx.export(model, dummy, "model_fp32.onnx", opset_version=11,input_names=["input"], output_names=["output"],dynamic_axes={"input":{0:"batch"}, "output":{0:"batch"}}) (3)ONNX 模型校验

- 在主机上用 onnx.checker.check_model("model_fp32.onnx") 确保导出文件合法。

- 用 onnxruntime 在 CPU 上做一次推理,确认结果与原模型一致(误差可容忍范围内)。

(4)TensorRT Engine 生成

- 在 Jetson Nano 上使用 trtexec 生成 FP16 Engine:

trtexec --onnx=model_fp32.onnx \--saveEngine=model_fp16.trt \--fp16 \--workspace=2048 \--minShapes=input:1x3xHminxWmin \--optShapes=input:1x3xHoptxWopt \--maxShapes=input:4x3xHmaxxWmax \--explicitBatch- --fp16:启用 FP16 模式;

- --workspace=2048:分配 2 GB 临时内存供 TensorRT 优化算法使用;

- --min/--opt/--maxShapes:指定动态张量的大小范围;

- --explicitBatch:显式 Batch 维度(ONNX 动态 Batch 支持)。

(5)离线性能基准测试

- 继续用 trtexec 测试 Engine 的延迟与吞吐:

trtexec --loadEngine=model_fp16.trt --batch=1 --iterations=1000- 记录 Latency(毫秒)和 Throughput(FPS),以确认能否达到 例如 30 FPS@1080p。

(6)集成到应用程序

- 在 C++/Python 代码中加载 TensorRT Engine,执行推理:

// 伪代码示例

TRTLogger logger;

auto runtime = nvinfer1::createInferRuntime(logger);

std::ifstream f("model_fp16.trt", std::ios::binary);

// 反序列化

auto engine = runtime->deserializeCudaEngine(...);

auto context = engine->createExecutionContext();

// 分配输入/输出 GPU buffer

// 将预处理后图像拷贝到 GPU

context->enqueueV2(bufferPointers, stream, nullptr);

// 将输出拷回 CPU,做后处理- 结合视频解码(GStreamer/FFmpeg)与预处理(Resize/Crop/Normalize)流水线,将摄像头 / 文件读取部分与推理部分异步并行,实现端到端 30 FPS。

(7)功耗与热设计

- 启动推理程序后,用 tegrastats 实时监控 CPU、GPU、内存使用率及功耗。

- 若超出功耗预算,可尝试:

- 降低推理精度(从 FP16 → INT8);

- 将某些算子降采样(例如在输入端降分辨率);

- 关闭 HDMI 显示器,只在乙太网/串口调试。

2. ONNX → RK3399Pro NPU(INT8/RKNN)

(1)环境准备与依赖安装

- RK3399Pro 开发板系统:一般基于 Ubuntu 18.04,已集成 RKNN Runtime。

- 在主机上安装 RKNN-Toolkit(Python 环境)及其依赖(rknn-toolkit、tensorflow 或 onnx)。

(2)模型导出与预处理

- 同样先将 PyTorch/TF 模型导出为 ONNX。注意:

- ONNX opset 版本需与 RKNN-Toolkit 支持的版本匹配(如 opset ≤ 11)。

- 去掉或替换模型中 NPU 不支持的算子(如某些高级 Attention、GroupNorm 等),必要时使用“ONNX Graph Surgeon”拆分子图。

(3)模型转换与量化

- 在主机上使用 RKNN-Toolkit 将 ONNX 模型转换并量化为 INT8:

from rknn.api import RKNN# 1) 创建 RKNN 对象

rknn = RKNN()# 2) 加载 ONNX 模型

rknn.load_onnx(model='model_fp32.onnx')# 3) 配置输入布局与预处理(可选)

# rknn.config(mean_values=[[123.68, 116.78, 103.94]],

# std_values=[[58.40, 57.12, 57.37]],

# reorder_channel='0 1 2')# 4) Build: 量化并转换为 NPU 模型

# use_quantization=True 表示开启 INT8 量化

rknn.build(do_quantization=True, dataset='./calib_data/')# 5) 导出 RKNN 模型文件

rknn.export_rknn('model_int8.rknn')

rknn.release()- do_quantization=True:开启 PTQ 量化,需要提供少量校准数据集(通常 100–500 张代表性图片);

- mean_values/std_values:若原模型在预处理时做了归一化,需要在此同步设置;

- 量化时 RKNN-Toolkit 会自动完成 Quantize → Dequantize → INT8 MAC 映射,并尽可能做算子融合。

(4)离线性能与精度验证

- 在主机端或 RK3399Pro 开发板上使用 rknn.eval_perf() 或者官方 Benchmark 工具测算平均单帧推理时间(单位 ms)及帧率(FPS)。

- 用一组校验数据做精度评估:将同一批图片下给原 FP32 模型和量化后的 model_int8.rknn 测结果差异,计算 mAP(目标检测模型)、mIoU(分割模型)等指标下降量,若超限则回到量化配置或 QAT 阶段。

(5)集成到应用中

- 在 RK3399Pro 开发板上编写推理示例(C/C++ 或 Python):

from rknn.api import RKNN

import cv2

import numpy as np# 1) 加载 RKNN 模型

rknn = RKNN()

rknn.load_rknn('model_int8.rknn')

rknn.init_runtime()# 2) 打开摄像头或视频文件

cap = cv2.VideoCapture('/dev/video0')while True:ret, frame = cap.read()if not ret: break# 3) 预处理:Resize 到输入尺寸,转 RGB,归一化,转 NCHWimg = cv2.resize(frame, (W, H))img = cv2.cvtColor(img, cv2.COLOR_BGR2RGB)img = img.astype(np.float32)img = (img - [123.68, 116.78, 103.94]) / [58.40, 57.12, 57.37]img = img.transpose((2, 0, 1))img = np.expand_dims(img, 0)# 4) 推理outputs = rknn.inference(inputs=[img])# 5) 后处理:NMS、绘制框、展示# ...cv2.imshow('Result', frame)if cv2.waitKey(1) & 0xFF == ord('q'): breakcap.release()

cv2.destroyAllWindows()

rknn.release() - 在集成时,需要注意:

- 输入数据对齐:确保与量化阶段一致的预处理、数据布局(NCHW/NHWC);

- 内存复用:尽量将显存/DRAM buffer 预先分配,避免每帧重复申请;

- 线程与异步:在 Python 中可使用多线程,一线程专门做 cap.read() + decode,一线程做 rknn.inference(),最后一线程做显示/后处理,三者异步并行提高吞吐。

(6)功耗与热设计

- 在 RK3399Pro 上可通过 pmu_monitor 或外部功率计测量推理时 SoC 总功耗(一般整板范围 3–5 W)。

- 如果功耗过高,可尝试:

- 进一步剪枝模型:减少 Conv 层通道数;

- 降低输入分辨率:例如从 1080p 降到 720p;

- 降低运行频率:在 Linux 下使用 cpufreq、governor,或 NPU SDK 提供的 DVFS(动态电压频率调整)。

四、常见风险与注意事项

- 算子兼容性风险

- 有些视频处理大模型会用到高级算子(如 Video Swin Transformer、可分离时空卷积、3D-CNN、光流估计算子等),目标 GPU/NPU 底层如果不原生支持,就必须手动拆分或写自定义算子,这往往需要较强的算法和硬件编译器知识,否则可能导致推理时直接报错或性能极差。

- 精度与速度的折中

- 量化后精度会下降,若端侧任务对精度要求极高(例如医疗影像、安防人脸识别),需要做 QAT 甚至结合少量端侧数据再做微调。

- 若在性能不足的 NPU 上,为追求 30 FPS,不得不降分辨率或降低模型复杂度,则可能导致检测/分割精度下降。需要与业务方进行权衡评估。

- 内存带宽与缓存瓶颈

- 特别是 4K 视频输入时,即使 NPU 本身算力足够,但若下游预处理(Resize、Normalize)仍由 CPU/GPU 负责,存在内存拷贝与缓存竞争,会大幅增加延迟。此时需要把预处理也迁移到硬件加速(如使用 NPU DSP 执行 Resize)、或者使用高带宽 LPDDR4X/LPDDR5。

- 热失控与降频

- 边缘设备散热条件差,长时间满载后容易出现降频,导致帧率不稳定,要配合硬件团队做好散热设计(风扇、散热片、外壳通风等)。

- 调度与容错

- 当硬件负载过高或者推理出错(如 NPU 内存溢出),需要设计好回退机制。例如:

- GPU:若使用 TensorRT 失败,可回退到 ONNX Runtime CPU 执行;

- NPU:若 NPU 运行出错,则将关键算子下放 CPU 或借助 GPU。

- 当硬件负载过高或者推理出错(如 NPU 内存溢出),需要设计好回退机制。例如:

五、小结

将一个视频处理大模型部署到端侧 GPU 或 NPU 上,主要分为以下技术步骤与对应的资源评估:

- 需求与硬件选型:明确帧率、分辨率、功耗、温度、部署环境等,选定候选加速硬件。

- 模型分析与优化:统计模型 FLOPs、参数量;做剪枝/蒸馏以减小尺寸;确定量化策略(INT8/FP16/QAT)。

- 算子兼容与融合:检查模型中是否含不被支持的高级算子,做必要拆分/自定义算子;在编译阶段做算子融合、算子替换,以减少内存压力与核函数开销。

- 模型转换与编译:使用 TensorRT、RKNN-Toolkit、SNPE、OpenVINO 等工具链,将模型转换为硬件可执行格式,自动完成量化和图优化。

- 性能基准与精度验证:测量端到端延迟、吞吐、内存占用、功耗;对比精度与原始模型,若超标需回退微调。

- 集成部署与异构优化:将推理引擎与视频采集/预处理/后处理流水线结合,完成异步并发调度,并设计降级容错策略。

需要评估的核心资源指标:

- 计算能力(TOPS/TFLOPS)与算子吞吐;

- 延迟(Latency)、帧率(FPS)与实时性;

- 内存占用(推理时模型+中间激活峰值)、带宽(DDR/AXI/PCIe);

- 功耗(W)与热设计(温度上限);

- 精度损失(量化后 Top-N 或任务特定指标)与可接受范围;

- 硬件兼容性(是否支持所用框架算子、是否需要自定义插件)。

通过上述技术流程与资源评估,可以确保视频处理大模型在边缘设备的 GPU/NPU 上既满足实时性、又保持足够精度,并在功耗和内存受限场景下实现稳定可靠的部署。