【2025ICCV】

论文题目:MixA-Q: Revisiting Activation Sparsity for Vision Transformers from a Mixed-Precision Quantization Perspective

1. 研究背景与动机

- 问题背景:视觉Transformer(如Swin Transformer)在密集预测任务(如目标检测、分割)中表现优异,但自注意力计算开销大,尤其处理高分辨率图像时存在实时性瓶颈。

- 现有方法局限:

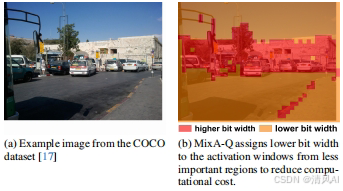

- 激活剪枝(如SparseViT):通过跳过不重要窗口的计算提升效率,但需重新训练、高剪枝率下精度骤降,且对分布外(OOD)输入敏感。

- 量化方法:主流方法采用层间混合精度(MPQ),但忽视了层内激活稀疏性(即图像中不同区域重要性差异)。

2. 核心方法:MixA-Q框架

核心思想

<