HDFS Block与Spark的partition对比

HDFS,全称 Hadoop Distributed File System,作为 Hadoop 生态系统的核心存储组件,它为大数据提供了可靠的分布式存储解决方案。而 Spark,则以其强大的分布式计算能力著称,能够快速对这些数据进行处理和分析,犹如一位高效的工匠,将仓库中的原材料加工成有价值的信息。在 HDFS 和 Spark 的运行机制中,block 和 partition 是两个极为重要的概念。block 是 HDFS 存储数据的基本单元,就像是仓库里一个个大小固定的货架格子,数据被分块存储其中;partition 则是 Spark 中对数据进行并行处理的划分单位,类似于工厂中不同生产线处理的任务批次。

二、基本概念阐述

(一)HDFS Block概念

HDFS 采用主从架构,其中 NameNode 是主节点,负责管理文件系统的命名空间和文件块的映射关系,存储所有文件和目录的元数据,比如文件名、权限、块位置等信息 ,并协调客户端对数据的访问请求。DataNode 则是从节点,负责存储实际的数据块,并执行数据块的读 / 写操作。

在这个架构中,block 是 HDFS 分布式存储的最小单元。简单来说,当我们有一个大文件要存储到 HDFS 中时,它会被切分成一个个固定大小的 block 进行存储。默认情况下,Hadoop 2.x 版本中 block 的大小是 128MB ,当然,这个大小并不是一成不变的,我们可以根据实际需求在 HDFS-site.xml 配置文件中通过修改 dfs.blocksize 参数来调整。

例如,有一个 1GB 大小的视频文件要存储到 HDFS 中,按照默认 128MB 的 block 大小,它会被切分成 8 个 block(1024MB÷128MB = 8) ,这些 block 会被分布式地存储在不同的 DataNode 节点上,从而实现了数据的分布式存储,提高了存储的可靠性和扩展性。

HDFS的Block具有以下特性 :

1. 固定大小

HDFS 的 block 具有固定大小的特性,这一特性带来了诸多优势。从存储管理的角度来看,固定大小的 block 使得存储管理变得相对简单。因为每个 block 大小一致,便于统计存储容量和规划存储布局。在 NameNode 中,对于元数据的管理也更加高效,它只需要记录每个 block 的位置等关键信息,而不需要处理因文件大小不同而带来的复杂情况。在数据读取时,固定大小的 block 有利于并行读取。当客户端请求读取文件时,可以同时从多个 DataNode 上并行读取不同的 block,大大提高了数据读取的速度。

然而,这一特性也存在一定的缺点。如果文件大小不是 block 大小的整数倍,就会出现最后一个 block 空间浪费的情况。比如一个文件大小为 130MB,按照 128MB 的 block 大小,会占用两个 block,其中第二个 block 只存储了 2MB 的数据,其余 126MB 的空间就被浪费了。对于大量小文件的存储,固定大小的 block 会导致每个小文件都至少占用一个 block,造成大量的空间浪费,而且会增加 NameNode 管理元数据的压力,因为每个 block 都需要在 NameNode 中记录元数据信息。

2. 冗余备份

为了保证数据的可靠性,HDFS 采用了冗余备份机制。默认情况下,每个 block 会有三个副本,这些副本会被存储在不同的 DataNode 上,甚至会分布在不同的机架上。这种多副本策略极大地提高了数据的容错能力。当某个 DataNode 出现故障,其上存储的 block 副本丢失时,HDFS 可以自动从其他拥有该 block 副本的 DataNode 上获取数据,确保数据的完整性和可用性。

但是,冗余备份也带来了一些影响。一方面,它增加了存储成本,因为需要更多的存储空间来存储副本。另一方面,在数据写入时,需要将数据同时复制到多个副本,这会消耗一定的网络带宽和时间,影响写入的效率。而且,在维护副本一致性时,也需要额外的开销来确保各个副本的数据始终保持一致。

三、spark 的 partition概念

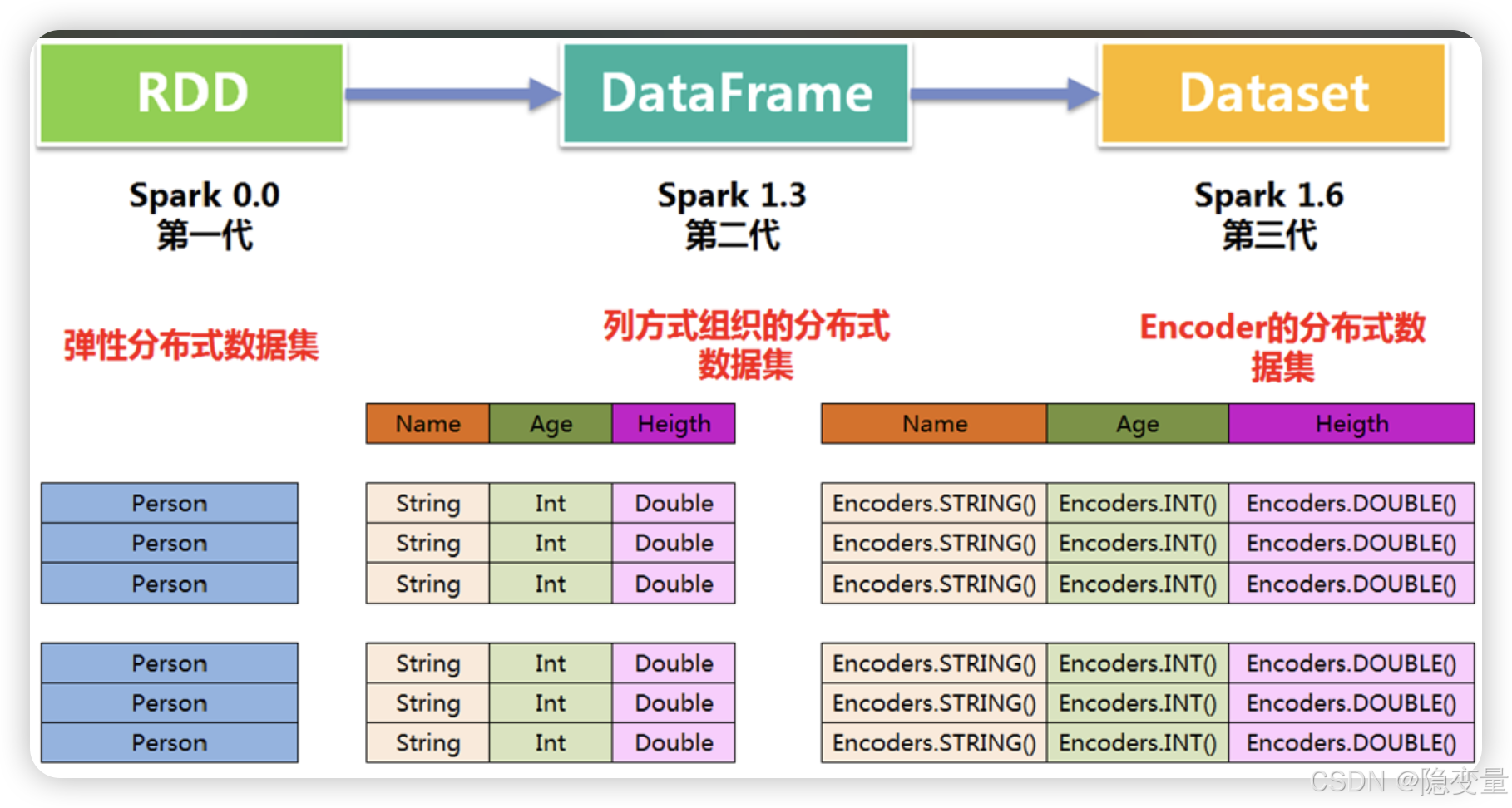

在 Spark 的世界里,RDD(Resilient Distributed Dataset)是其核心数据结构,代表一个不可变的分布式对象集合 。而 partition(分区)则是 RDD 的基本组成单位,它就像是工厂里不同的生产线,每个分区都可以独立地进行并行计算,从而大大提高了计算效率。

例如,当我们使用 Spark 对一个包含海量用户行为数据的 RDD 进行分析时,这个 RDD 会被划分成多个 partition,每个 partition 分布在集群的不同节点上。当执行诸如统计每个用户的访问次数这样的操作时,不同的 partition 可以同时对各自的数据进行处理,最后再将结果汇总,实现了高效的并行计算 。

Spark的partition具有以下特性 :

1. 动态调整

Spark 的 partition 具有动态灵活的特性,分区的数量和大小并非固定不变。在实际应用中,我们可以根据数据量的大小、集群的资源状况等因素来动态调整分区数量。当处理的数据量较小时,减少分区数量可以降低任务调度的开销;而在处理大规模数据时,增加分区数量可以充分利用集群的并行计算能力。在 Spark 中,我们可以使用repartition和coalesce等算子来实现分区数量的调整 。比如,当我们发现某个 RDD 的分区数量过多,导致任务调度开销过大时,可以使用coalesce算子来减少分区数量,提高计算效率。例如:

val data = sc.parallelize(1 to 1000, 10) // 创建一个包含10个分区的RDD

val newData = data.coalesce(5) // 将分区数量减少到5个

这种动态调整分区的能力,使得 Spark 能够更好地适应不同规模和特性的数据处理需求,提高资源利用率和计算性能。

2. 弹性计算

Spark 的 partition 还具备强大的弹性计算机制。这意味着当某个分区的数据丢失或计算失败时,Spark 可以根据 RDD 之间的血统依赖关系(Lineage)重新计算该分区的数据 ,而无需重新处理整个数据集。

血统依赖关系记录了 RDD 的生成过程和转换操作。比如,RDD2 是通过对 RDD1 执行map操作得到的,RDD3 是通过对 RDD2 执行filter操作得到的,那么 RDD3 就依赖于 RDD2,RDD2 又依赖于 RDD1。当 RDD3 的某个分区数据丢失时,Spark 可以根据这个依赖关系,从 RDD1 开始重新执行map和filter操作,来恢复丢失的分区数据 。

这种弹性计算机制不仅提高了 Spark 计算的容错性,还减少了数据冗余存储,使得 Spark 在处理大规模数据时更加高效和可靠 。

四、HDFS 的 block 和 spark 的 partition对比

(一)存储层面

1)从存储位置来看,HDFS 的 block 主要存储在 DataNode 节点的本地磁盘上,形成了分布式的存储架构,这些 DataNode 分布在集群的各个物理节点上,共同构成了 HDFS 的存储体系。而 Spark 的 partition 本身并不直接存储数据,它更多地是一种逻辑上的划分,数据通常存储在内存或者磁盘上,具体取决于 Spark 的配置和执行环境。当数据量较小时,Spark 会尽量将数据存储在内存中,以加快计算速度;而当数据量超出内存容量时,会将部分数据存储到磁盘上。

2)在大小设定方面,HDFS 的 block 具有固定的大小,在 Hadoop 2.x 版本中默认大小为 128MB ,虽然可以通过配置参数进行调整,但在实际应用中,一旦设定,其大小在整个存储过程中基本保持不变。这种固定大小的设计,使得存储管理和元数据记录相对简单,有利于快速定位和读取数据。相比之下,Spark 的 partition 大小并不固定,它会根据数据的特性、计算任务的需求以及集群资源状况动态变化。在处理不同规模的数据时,Spark 可以灵活地调整 partition 的大小,以充分利用集群资源,提高计算效率。

3)冗余设计上,HDFS 为了确保数据的可靠性,采用了多副本冗余存储策略。每个 block 默认会有三个副本,这些副本会被存储在不同的 DataNode 上,甚至分布在不同的机架上 。这种冗余设计大大提高了数据的容错能力,即使某个 DataNode 出现故障,也能从其他副本中获取数据,保证数据的完整性和可用性。然而,冗余存储也带来了存储成本增加和写入效率降低的问题。Spark 的 partition 则没有冗余设计,它主要依靠 RDD 的血统依赖关系(Lineage)来实现容错。当某个 partition 的数据丢失或计算失败时,Spark 可以根据 Lineage 重新计算该 partition 的数据,而不需要额外存储冗余数据,这在一定程度上节省了存储资源,但在数据恢复时可能需要消耗更多的计算资源和时间。

(二)数据处理层面

1)在功能定位上,HDFS 的 block 主要侧重于数据的存储,它是 HDFS 实现分布式存储的基础单元,负责将大文件切分成小块进行存储,并通过冗余备份保证数据的可靠性。而 Spark 的 partition 则是为了实现数据的并行计算而设计的,它是 RDD 的基本组成部分,每个 partition 可以独立地进行并行计算,从而提高整个数据处理的效率。

2)从数据处理方式来看,HDFS 的 block 在数据读取时,通常是顺序读取,客户端从 NameNode 获取 block 的位置信息后,直接从对应的 DataNode 上读取数据。这种读取方式适用于大规模数据的顺序访问场景。Spark 的 partition 在数据处理时,则是通过一系列的算子(如 map、filter、reduce 等)对每个分区内的数据进行并行处理。这些算子可以对数据进行各种转换和计算操作,并且可以根据需求进行灵活组合,以实现复杂的数据处理逻辑。例如,在进行数据分析时,可以使用map算子对数据进行格式转换,使用filter算子筛选出符合条件的数据,再使用reduce算子进行数据聚合计算。

3)在数据容错机制方面,HDFS 依靠多副本冗余来容错。当某个 block 副本损坏或丢失时,HDFS 会自动检测并从其他完好的副本中复制一份新的副本,以保证数据的完整性。这个过程对上层应用是透明的,应用程序无需关心副本的恢复过程。Spark 的 partition 则依赖于 RDD 的血统依赖关系进行容错。如果某个 partition 的数据丢失,Spark 可以根据 RDD 之间的依赖关系,重新计算丢失的分区数据。这种容错机制虽然不需要额外的冗余存储,但在重新计算时需要消耗一定的计算资源和时间,并且依赖关系的维护也需要一定的开销。