Dify入门指南(2):5 分钟部署 Dify:云服务 vs 本地 Docker

无需算法团队,无需 GPU 服务器,只需一台普通电脑或云账号,5 分钟即可搭建企业级 AI 开发平台。本文手把手对比 云服务直装 和 本地 Docker 部署 两种方案,附避坑指南与性能实测!

一、云服务部署:3 分钟极速开箱

适合人群:快速验证原型 · 中小企业轻量化使用

核心优势:零运维、免费用量额度、自动升级

操作步骤:

1. 注册登录 👉 访问 Dify 官网 → 点击「免费开始」→ 用邮箱/GitHub 账号注册

国内用户推荐选择 亚太节点(新加坡/东京),延迟更低

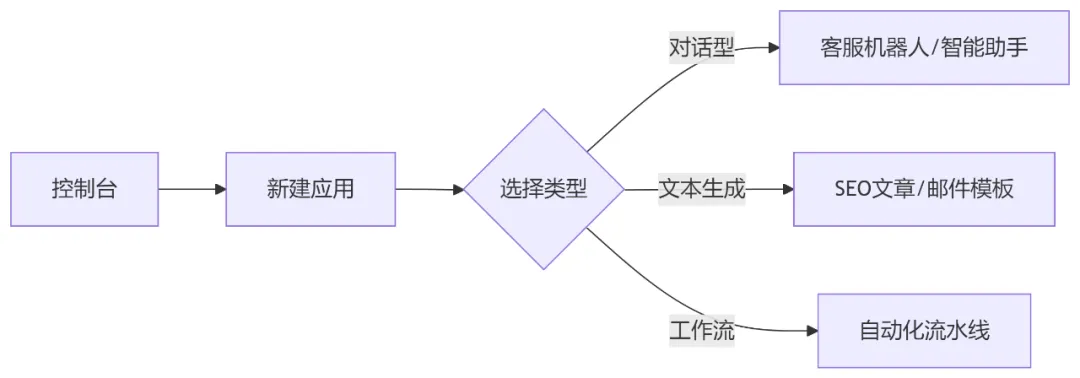

2. 创建应用

3. 配置模型

免费额度:新用户赠送 $1 的 GPT-3.5 调用额度

- 进入「模型供应商」→ 选择 OpenAI/Claude/通义千问

- 填入 API Key(云服务自动代理请求,无需暴露 Key 给客户端)

4. 立即体验

# 通过 API 测试

curl -X POST "https://api.dify.ai/v1/chat-messages" \ -H "Authorization: Bearer YOUR_API_KEY" \ -d '{"inputs": {}, "query": "你好"}'

进入应用 → 点击「发布」→ 通过 Web/API 接入

💡 云服务优缺点:

二、本地 Docker 部署:5 分钟构建私有环境

-

适合人群:金融/医疗等强合规场景 · 需要连接内网系统

-

核心优势:数据 100% 私有化 · 自定义 GPU 加速

-

操作步骤:

1. 环境准备

最低配置:Linux/MacOS/Windows WSL2 · 4核 CPU · 8GB 内存 · 20GB 磁盘

安装 Docker 及 Docker Compose

2. 一键启动

# 下载官方 compose 文件

curl -O https://raw.githubusercontent.com/langgenius/dify/main/docker/docker-compose.yaml # 启动服务(首次启动自动拉镜像)

docker-compose up -d # 查看日志(出现 Listening at http://0.0.0.0:80 即成功)

docker-compose logs -f

3. 访问控制台

- 浏览器打开 http://localhost(默认账号:admin@dify.ai,密码:difyai.com)

- 立即修改密码! → 进入「系统设置」重置

4. 配置本地模型(关键步骤)

# 编辑 docker-compose.yaml,添加 Ollama 本地模型服务

services:

ollama:image:ollama/ollamaports:-"11434:11434"volumes:-ollama:/root/.ollama

# 启动 Llama3 中文优化版

docker exec -it dify-ollama ollama run qwen:4b-chat # Dify 控制台添加模型

模型类型:OpenAI 兼容

端点:http://ollama:11434/v1

模型名称:qwen:4b-chat

🔧 私有化部署调优技巧

三、方案对比:按需选择最优解

实测数据:本地部署运行 Qwen-4B 模型,单条查询响应 <2s(RTX 3060 GPU)

四、避坑指南:高频问题解决方案

镜像拉取失败

# 替换国内镜像源

sed -i 's/ghcr.io/mirror.ghcr.io/g' docker-compose.yaml

端口冲突(本地 80 端口被占)

# 修改 compose 文件端口映射

services: dify-web: ports: - "8080:80" # 改为 8080 端口

知识库上传失败

- 检查文件:仅支持 PDF/TXT/Markdown/Word

- 内存不足:增加 Docker 内存限制 docker-compose.yml → mem_limit: 4096m

五、总结:两条路径,同一目标

云服务是快速验证的“轻骑兵”,适合敏捷迭代;

本地 Docker 是数据自主的“堡垒机”,满足合规刚需。

无论选择哪种方式,Dify 都大幅降低了 AI 应用的门槛。