【AI论文】端到端视觉标记器调优

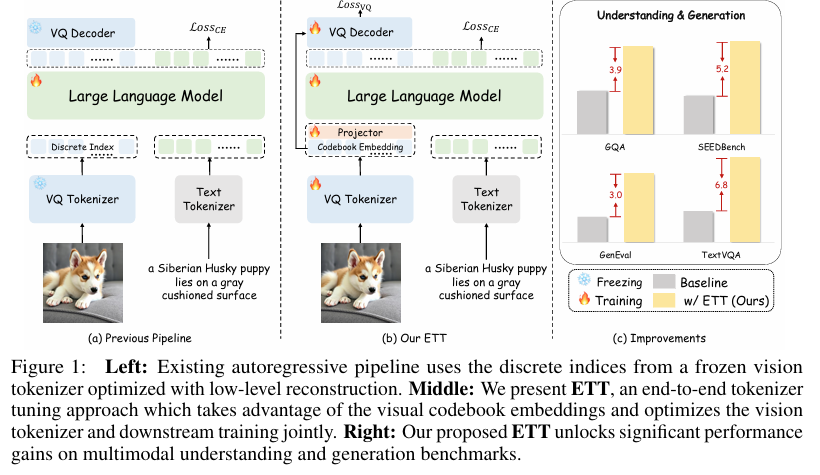

摘要:现有的视觉特征标记化将视觉特征标记器的优化与下游训练隔离开来,隐含地假设视觉特征标记可以在各种任务(如图像生成和视觉问题回答)中很好地泛化。针对低级重建优化的视觉特征标记器对需要不同表示和语义的下游任务是不可知的。 这种解耦范式引入了一个关键的不一致:视觉标记化的损失可能是目标任务的表示瓶颈。 例如,在给定图像中对文本进行标记时出现的错误会导致识别或生成结果不佳。 为了解决这个问题,我们提出了ETT,这是一种端到端的视觉标记器调优方法,可以在视觉标记和目标自回归任务之间进行联合优化。 与之前仅使用来自冻结视觉标记器的离散索引的自回归模型不同,ETT利用了标记器码本的视觉嵌入,并通过重建和字幕目标对视觉标记器进行端到端的优化。 ETT可以无缝集成到现有的培训管道中,只需要最小的架构修改。 我们的ETT易于实施和集成,无需调整所使用的大型语言模型的原始代码本或架构。 广泛的实验证明,我们提出的端到端视觉标记器调优可以显著提高性能,即与冻结标记器基线相比,在多模态理解和视觉生成任务中可以提高2-6%的性能,同时保留了原始的重建能力。 我们希望这种非常简单而强大的方法能够在图像生成和理解之外增强多模态基础模型。Huggingface链接:Paper page,论文链接:2505.10562

一、研究背景和目的

研究背景:

随着大型语言模型(LLMs)和多模态预训练技术的飞速发展,自回归(AR)建模在自然语言处理(NLP)之外的影响力日益扩大,逐渐渗透到视觉和多模态任务中。在自回归模型的下一 token 预测(NTP)范式下,多模态学习通常将图像和文本等多模态数据编码为紧凑的离散 token,以便进行统一的序列建模。例如,最近的工作Emu3将文本、图像和视频标记为离散 token,并在统一的 token 空间中执行下一 token 预测。随后,许多后续工作进一步推动了这一方向的发展,在视觉生成和感知方面取得了改进的性能。这种统一的下一 token 预测范式为大规模的训练和推理提供了一个灵活的多模态学习框架。

然而,在多模态自回归模型中,tokenization(标记化)起着关键作用。特别是对于图像和视频等模态,训练一个高效且通用的标记器面临着重大挑战,因为标记化很难同时做到紧凑且无损。标记化的损失可能成为目标任务的瓶颈。例如,在给定图像中对文本进行标记时出现的错误会导致识别或生成结果不佳。现有的标记化方法忽视了这种不一致性,单独训练视觉标记器并直接将其集成到下游训练中,假设获得的视觉 token 可以在不同任务中很好地泛化。然而,针对自动编码优化的视觉标记器对需要不同表示和语义的下游任务是不可知的。大多数标记器专注于低级像素级重建,其学习到的表示质量由于向量量化(VQ)造成的信息损失而受到限制,导致在视觉理解任务中的性能相较于使用连续高级表示(如CLIP)的模型较差。此外,现有的自回归管道通常仅使用来自视觉标记器的离散索引,这些索引与大型语言模型中随机初始化的视觉嵌入相关联,以实现下游任务。这对学习视觉表示和视觉语言对齐提出了挑战,而这两者对于多模态学习至关重要。

研究目的:

本文旨在解决现有视觉标记化方法与下游自回归任务之间的不一致性问题,提出一种端到端的视觉标记器调优(ETT)方法。通过联合优化视觉标记化和目标自回归任务,ETT能够显著提升多模态理解和视觉生成任务的性能,同时保留标记器的原始图像重建能力。具体而言,本文的研究目的包括:

- 提出一种新的视觉标记器训练范式,使视觉标记器能够感知并优化下游自回归任务。

- 引入一种简单而有效的方法ETT,用于端到端视觉标记器调优。ETT利用标记器的码本嵌入,而不是仅使用离散索引,并应用 token 级别的字幕损失来优化标记器的表示。

- 通过广泛的实验验证ETT在多模态理解和生成任务中的有效性,并展示其在不同基准数据集上的性能提升。

二、研究方法

1. 视觉标记器初步:

本文采用基于VQ(向量量化)的视觉标记器,包括编码器、量化器和解码器。编码器将输入图像投影到特征图上,量化器将特征图中的每个特征映射到码本中的最近代码,得到量化嵌入,最后解码器将量化嵌入重构回原始图像。为了扩展码本尺寸和代码维度,本文采用IBQ作为基础框架,并调整码本大小以适应实验需求。

2. 端到端视觉标记器调优(ETT):

- 离散索引到码本嵌入:现有方法如Emu3在下游任务中仅使用视觉标记器的离散索引,这丢弃了标记器嵌入的丰富表示能力。ETT通过直接连接视觉标记器的码本嵌入到大型语言模型(LLM),有效利用了标记器中编码的更丰富的特征表示,同时实现了端到端的训练。

- LLM桥接端到端调优:给定输入图像,首先从标记器的码本中获得其量化嵌入。为了确保与预训练LLM的兼容性,采用一个轻量级投影器将量化视觉嵌入映射到与LLM隐藏维度大小相同的空间。由于整个计算图(包括预训练的LLM和视觉标记器)都是可微的,因此可以使用基于梯度的优化进行端到端训练。

- 重建能力的保持:在端到端训练中,除了使用字幕损失外,还直接重用了视觉重建的损失函数,以确保标记器的重建能力。整体训练目标结合了字幕损失和VQ损失,通过联合训练标记器的编码器和解码器与LLM,确保了模型在保持重建能力的同时,学习到的视觉 token 在多模态理解和生成任务中仍然保持语义上的有效性和意义。

3. 多模态生成和理解训练配方:

整个训练过程分为三个顺序阶段:对齐学习、语义学习和后训练。在对齐学习阶段,冻结预训练的LLM和视觉标记器,仅训练视觉投影器层,以建立视觉语言对齐。在语义学习阶段,解冻LLM、投影器和视觉标记器的权重,使用字幕损失和重建损失进行联合优化。在后训练阶段,进一步对专家模型(ETT-Chat和ETT-Gen)进行微调,以增强多模态理解和文本到图像生成的能力。

三、研究结果

1. 多模态理解评估:

ETT在多个广泛使用的视觉语言感知基准数据集上进行了验证,包括任务特定评估(GQA和TextVQA)、幻觉检测(POPE)、开放域多模态理解(MME、MMBench、SEED-Bench和MM-Vet)以及科学推理(ScienceQA-IMG)。实验结果表明,ETT在所有基准数据集上均优于离散对应方法,如Chameleon、LWM和Liquid,甚至在模型和数据规模较小的情况下也能取得优异表现。此外,ETT在与连续编码器基础的多模态语言模型(如QwenVL-Chat、EVE和Janus)的比较中也表现出色,证明了ETT在多模态任务中的有效性和数据利用策略的优越性。

2. 视觉生成评估:

在文本到图像生成任务中,ETT与之前的扩散基础和自回归基础的最先进方法进行了全面比较,包括多模态专家和通才模型。实验结果表明,ETT在利用更少的LLM参数和更小规模的训练数据集的情况下,实现了具有竞争力的性能。具体而言,在GenEval数据集上,ETT达到了0.63的整体得分,优于先进的扩散模型如SDXL,并超过了自回归基础的方法,如LlamaGen和Chameleon。在T2I-CompBench数据集上,ETT在颜色、形状和纹理模式方面也取得了令人鼓舞的性能,证明了ETT在视觉生成任务中的有效性。

3. 消融研究:

为了验证ETT对下游多模态生成和理解任务的有效性,本文进行了全面的消融研究。实验结果表明,引入ETT在理解和生成任务上均带来了显著的性能提升。特别是,与传统的标记器利用方式相比,端到端调优进一步增强了视觉标记器的特征表示能力,从而在依赖视觉特征的任务上取得了更好的性能。此外,本文还研究了视觉重建与多模态理解之间的权衡,发现通过调整重建损失的权重,可以在保持一定重建能力的同时,优化多模态理解任务的表现。

四、研究局限

尽管ETT在多模态理解和生成任务中取得了显著的性能提升,但仍存在一些局限性:

- 数据规模和模型容量:端到端微调的数据规模和模型容量可以进一步扩大,以增强视觉表示和下游任务性能。当前的实验主要基于有限的数据集和模型规模进行,未来可以在更大规模的数据集和更强大的模型上进行验证。

- 从头开始的端到端训练:当前的方法主要侧重于优化现有视觉标记器的视觉特征,利用LLM的语义能力,而不是从头开始构建一个专为理解和生成设计的视觉标记器。未来的研究可以探索从头开始端到端训练视觉标记器的可能性,旨在为多模态任务创建更全面和可适应的表示。

- 模态扩展:除了图像和文本模态外,未来的研究还可以探索将ETT扩展到视频和音频等其他模态的可能性,以推动多模态基础模型的进一步发展。

五、未来研究方向

基于ETT的研究成果和局限性分析,未来的研究方向可以包括以下几个方面:

- 扩大数据规模和模型容量:在更大规模的数据集和更强大的模型上进行实验,以验证ETT在更广泛条件下的有效性和性能提升。

- 从头开始的端到端训练:探索从头开始端到端训练视觉标记器的可能性,旨在为多模态任务创建更全面和可适应的表示。这可能需要设计新的网络架构和训练策略,以充分利用大规模数据集中的信息。

- 模态扩展:将ETT扩展到视频和音频等其他模态,以推动多模态基础模型的进一步发展。这可能需要解决跨模态对齐、特征融合和表示学习等挑战。

- 应用探索:探索ETT在更多实际应用场景中的潜力,如机器人控制、自动驾驶、虚拟现实等。通过将这些技术应用于实际问题中,可以进一步验证其有效性和实用性。

- 理论分析:对ETT的工作机制进行更深入的理论分析,以揭示其性能提升的根本原因。这有助于更好地理解端到端调优在多模态学习中的作用,并为未来的研究提供指导。