(论文速读)FloVD:光流遇见视频扩散模型,开启相机控制视频生成

论文题目:FloVD: Optical Flow Meets Video Diffusion Model for Enhanced Camera-Controlled Video Synthesis(FloVD:增强摄像机控制视频合成的光流满足视频扩散模型)

会议:CVPR2025

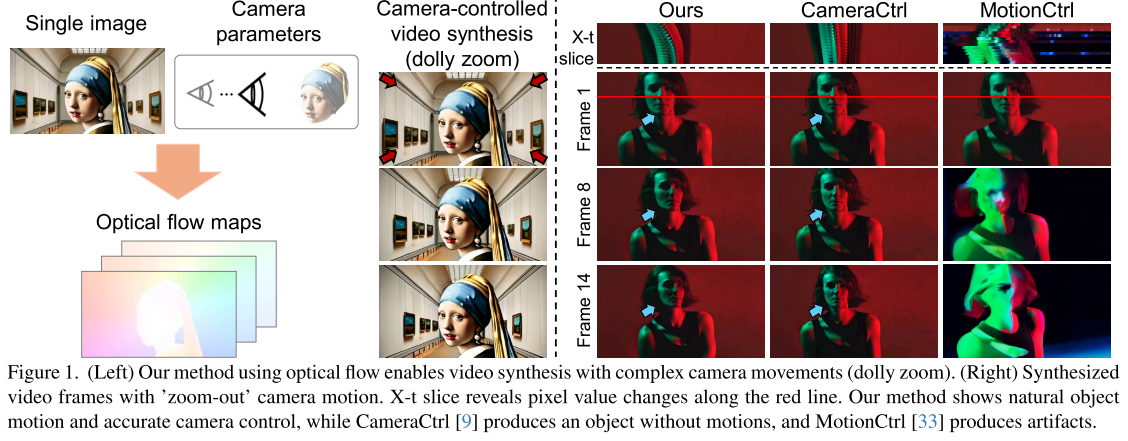

摘要:提出了一种新的视频扩散模型,用于摄像机可控视频生成。FloVD利用光流来表示相机和移动物体的运动。这种方法提供了两个关键的好处。由于光流可以直接从视频中估计,我们的方法允许使用任意训练视频,而不需要真实摄像机参数。此外,由于背景光流编码了不同视点之间的3D相关性,我们的方法可以通过利用背景运动来实现详细的相机控制。为了在支持详细的摄像机控制的同时合成自然物体运动,我们的框架采用了由光流生成和流条件视频合成组成的两级视频合成流水线。大量的实验证明了我们的方法在精确的相机控制和自然物体运动合成方面优于以往的方法。

引言

随着AIGC技术的飞速发展,视频生成已经成为计算机视觉领域最激动人心的研究方向之一。从Sora到RunwayML,各种视频生成模型层出不穷。然而,如何让AI生成的视频具备精确的相机控制能力,一直是这个领域面临的重大挑战。

最近,来自POSTECH和微软亚洲研究院的研究团队提出了FloVD(Optical Flow meets Video Diffusion),这是一个革命性的框架,它巧妙地将光流技术与视频扩散模型结合,实现了前所未有的相机控制视频生成效果。这篇论文已被CVPR 2025接收,让我们深入了解这项突破性的工作。

预备知识:什么是光流?

光流的基本概念

在深入了解FloVD之前,我们需要先理解什么是光流(Optical Flow)。

光流是指图像中像素点的运动模式,它描述了连续帧之间像素位置的变化。简单来说,光流就是"像素的运动轨迹"。

想象一下,当你看电影时,屏幕上的每个像素点在不同帧之间是如何移动的:

- 如果摄像机向右移动,整个画面会向左流动

- 如果镜头放大,画面会从中心向外扩散

- 如果画面中有移动的汽车,那部分像素会有独特的运动模式

光流的数学表示

光流可以用二维向量场来表示:对于图像中的每个像素点(x,y),光流向量(u,v)表示该像素在下一帧中的位移:

新位置 = (x + u, y + v)

光流的类型

稠密光流 vs 稀疏光流:

- 稠密光流:计算图像中每个像素的运动向量

- 稀疏光流:只计算特征点的运动向量

前向光流 vs 后向光流:

- 前向光流:从当前帧指向下一帧

- 后向光流:从下一帧指向当前帧

光流的应用

光流在计算机视觉中有广泛应用:

- 运动检测:识别画面中的移动物体

- 视频压缩:利用帧间相关性减少存储空间

- 自动驾驶:感知周围环境的运动状态

- 视频稳定:补偿相机抖动

- 动作识别:分析人体或物体的运动模式

现有视频生成方法的挑战

控制能力的缺失

传统的视频扩散模型虽然能生成高质量视频,但在用户控制方面存在严重不足:

基础控制方法的局限性:

- 文本描述控制:只能进行高层次的描述,如"镜头向左移动"

- 用户笔画控制:通过绘制轨迹控制背景运动,但精度有限

- 这些方法只支持简单的缩放(zoom)和平移(pan)操作

参数化控制的困境:

- 直接使用相机参数的方法需要包含真实相机参数的训练数据

- 获取这样的数据集非常困难和昂贵

- 现有方法被迫使用受限数据集(如RealEstate10K),主要包含静态场景

泛化能力的问题

由于训练数据的限制,现有方法面临严重的泛化问题:

- 物体运动不自然:在静态场景上训练的模型无法生成真实的物体运动

- 相机控制不准确:模型难以准确遵循输入的相机轨迹

- 视觉伪影:生成的视频中常出现不连贯的前景和背景区域

FloVD的核心创新

核心思想:光流作为统一表征

FloVD的关键洞察是:光流可以作为相机运动和物体运动的统一表征。

这个想法的天才之处在于:

- 光流可以直接从视频估计:不需要真实的相机参数

- 背景光流编码3D信息:包含不同视角间的3D相关性

- 统一框架:同时处理相机运动和物体运动

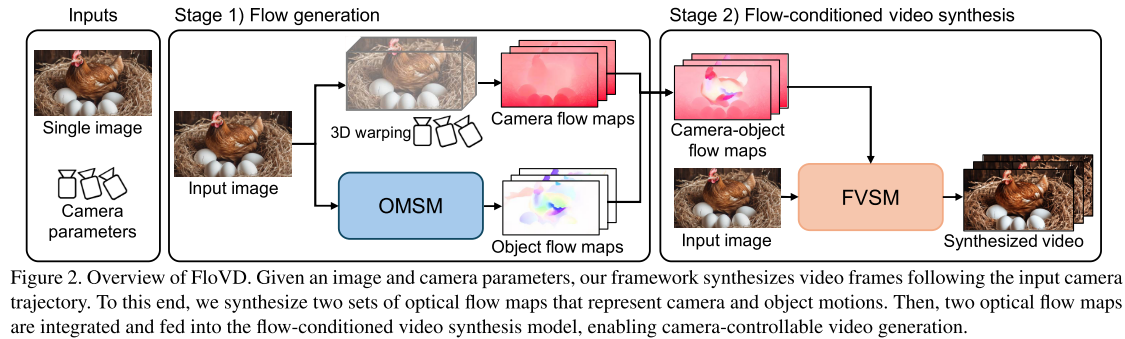

两阶段管道设计

FloVD采用了创新的两阶段处理流程:

阶段1:光流生成

输入:单张图像 + 相机参数

输出:光流图

这个阶段又分为两个子任务:

相机流生成:

- 使用单图像深度估计网络估计深度图

- 将2D像素坐标投影到3D空间

- 根据相机参数进行3D变换

- 重新投影到2D平面生成相机流

物体流生成:

- 使用专门的物体运动合成模型(OMSM)

- 基于潜在视频扩散模型架构

- 独立于背景运动生成物体运动流

流融合:

- 使用语义分割获得物体掩码

- 将相机流和物体流智能组合

- 生成最终的相机-物体流图

阶段2:基于流的视频合成

输入:原始图像 + 相机-物体流图

输出:合成视频

- 使用流条件视频合成模型(FVSM)

- 扩展潜在视频扩散模型,增加流编码器

- 生成遵循相机轨迹且具有自然物体运动的视频

技术细节深度解析

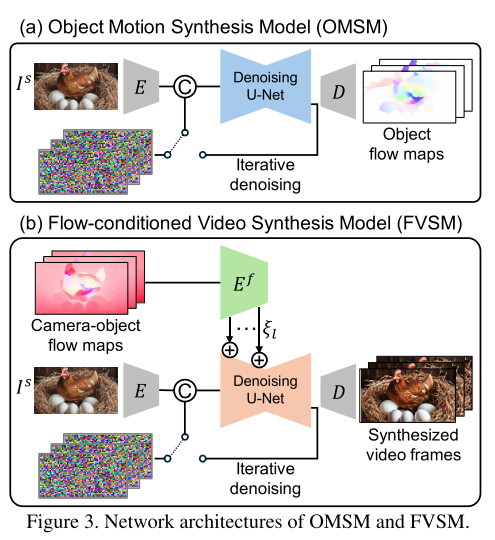

物体运动合成模型(OMSM)

OMSM是FloVD的核心组件之一,它的设计非常巧妙:

架构设计:

- 基于潜在视频扩散模型的去噪U-Net

- 复用预训练VAE的编码器和解码器

- 无需修改架构即可处理光流数据

训练策略:

- 第一阶段:在完整数据集上初始化训练

- 第二阶段:在无相机运动的精选数据集上微调

这种两阶段训练解决了domain gap问题,让模型能够从小规模精选数据集中有效学习物体运动合成。

光流处理技巧:

- 将光流的(x,y)分量映射到VAE的RGB通道

- 第三个通道使用(x+y)/2的平均值

- 验证了这种方法可以无损重建光流图

流条件视频合成模型(FVSM)

FVSM负责将光流信息转换为最终的视频:

流编码器设计:

- 受T2I-Adapter启发的多级流嵌入

- 在U-Net的每一层注入流信息

- 保持与预训练模型的兼容性

训练优化:

- 使用二次时间步采样策略(QTS)提高相机控制能力

- 自适应光流归一化确保训练稳定性

- 只训练流编码器,固定其他组件

流融合的物理考量

论文中坦诚地指出了一个重要局限:物理上完全准确的相机-物体流融合需要z轴(垂直于图像平面)的物体运动信息,而这在2D光流中是缺失的。

然而,实验表明FVSM仍能生成自然的物体运动,这得益于:

- 模型在真实视频上的训练确保了现实主义

- 即使输入略有噪声,模型也能产生合理结果

- 深度学习的强大泛化能力弥补了物理建模的不足

实验结果与评估

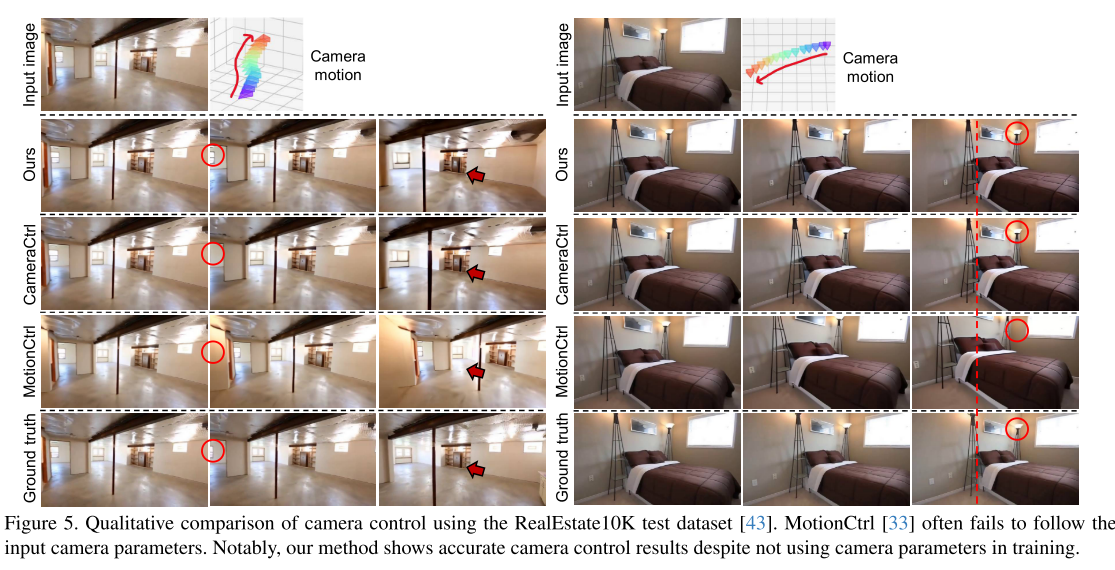

相机控制能力评估

研究团队采用了严格的量化评估协议:

评估指标:

- 平均旋转误差(mRotErr)

- 平均平移误差(mTransErr)

- 平均相机外参矩阵误差(mCamMC)

评估流程:

- 使用输入图像和相机参数合成视频

- 用GLOMAP从合成视频估计相机参数

- 将估计参数与真实输入参数对比

结果对比:

- vs MotionCtrl:FloVD在所有指标上都显著优于MotionCtrl

- vs CameraCtrl:即使不使用相机参数训练,FloVD仍达到相当或更好的性能

视频质量评估

评估数据集:

- Pexels-random:1500个随机视频样本

- Pexels-small/medium/large:按物体运动幅度分类的数据集

评估指标:

- FVD(Frechet Video Distance):衡量视频分布差异

- FID(Frechet Image Distance):衡量图像质量

- IS(Inception Score):衡量生成多样性和质量

关键发现:

- 整体质量:FloVD在Pexels-random上表现最佳

- 物体运动:在所有运动幅度类别中都优于竞争方法

- 大运动优势:在Pexels-large(大运动)类别中优势最为明显

消融研究

研究团队进行了详细的消融实验:

- 基线模型(无OMSM,RealEstate10K训练):无明显物体运动

- +OMSM:能生成物体运动,但偶有伪影

- +大规模数据:最终模型,自然物体运动无伪影

量化结果显示每个组件都带来了持续的性能提升。

令人印象深刻的应用

电影级相机控制

FloVD支持复杂的电影摄影技术:

Dolly Zoom效果:

- 同时进行相机前后移动和相反方向的变焦

- 保持主体大小不变,背景产生戏剧性的透视变化

- 这是《眩晕》等经典电影中的标志性技巧

时间一致的视频编辑

通过重用FVSM组件,FloVD可以实现:

- 编辑视频的第一帧

- 使用原始视频的光流信息

- 生成时间一致的编辑结果

- 无需额外训练或优化

技术局限与未来方向

当前局限

- 物体运动合成误差:OMSM的错误可能导致不自然的物体运动

- 语义分割依赖:分割模型的误差会影响流融合质量

- 物理建模简化:缺乏z轴物体运动信息

改进方向

- 用户交互:通过点提示改善分割质量

- 物理建模:更准确的相机-物体运动融合

- 端到端优化:联合训练各个组件

对行业的影响

技术贡献

- 训练数据自由:摆脱了对特殊标注数据集的依赖

- 统一框架:光流作为通用运动表征的新范式

- 实用性提升:支持复杂相机操作和视频编辑

应用前景

- 影视制作:低成本实现专业相机运动效果

- 虚拟现实:生成可控的沉浸式视频体验

- 内容创作:为创作者提供精确的视频生成工具

- 教育培训:虚拟摄影教学和实践

结论

FloVD代表了相机控制视频生成领域的重大突破。通过将光流作为相机和物体运动的统一表征,它解决了现有方法面临的核心挑战:

- 数据依赖:无需特殊标注的训练数据

- 控制精度:实现准确的相机轨迹跟随

- 运动自然性:生成真实的物体运动效果

更重要的是,FloVD开启了一个新的研究方向:如何更好地利用光流等传统计算机视觉技术来增强现代深度学习模型。这种"新旧结合"的思路为未来的研究提供了宝贵的启示。

随着视频生成技术的不断发展,我们有理由相信,FloVD所代表的技术路线将推动整个行业向更加可控、更加实用的方向发展,最终让每个人都能成为出色的"虚拟导演"。