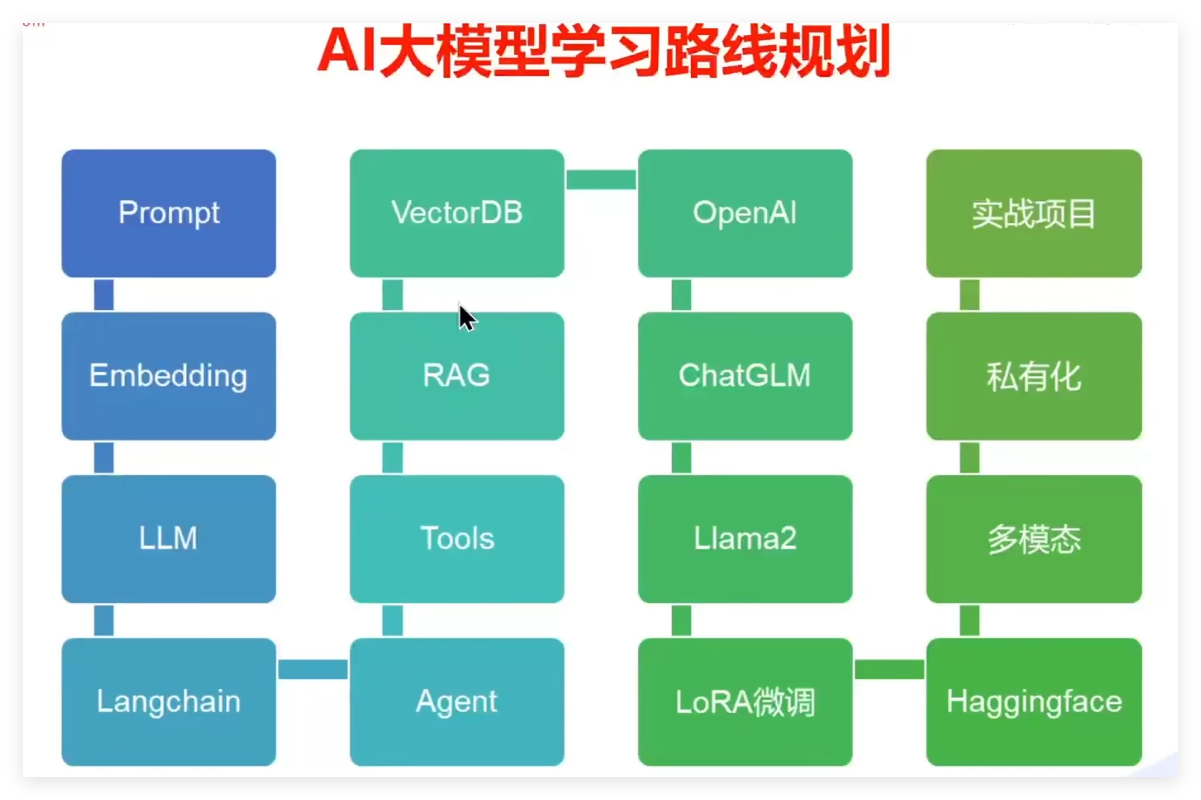

【LLM开发学习】

目录

- LLM开发及其介绍

- Langchain 支持的模型

- 案例

- 案例一:Langchain简单实现LLM调用

- 参考资料

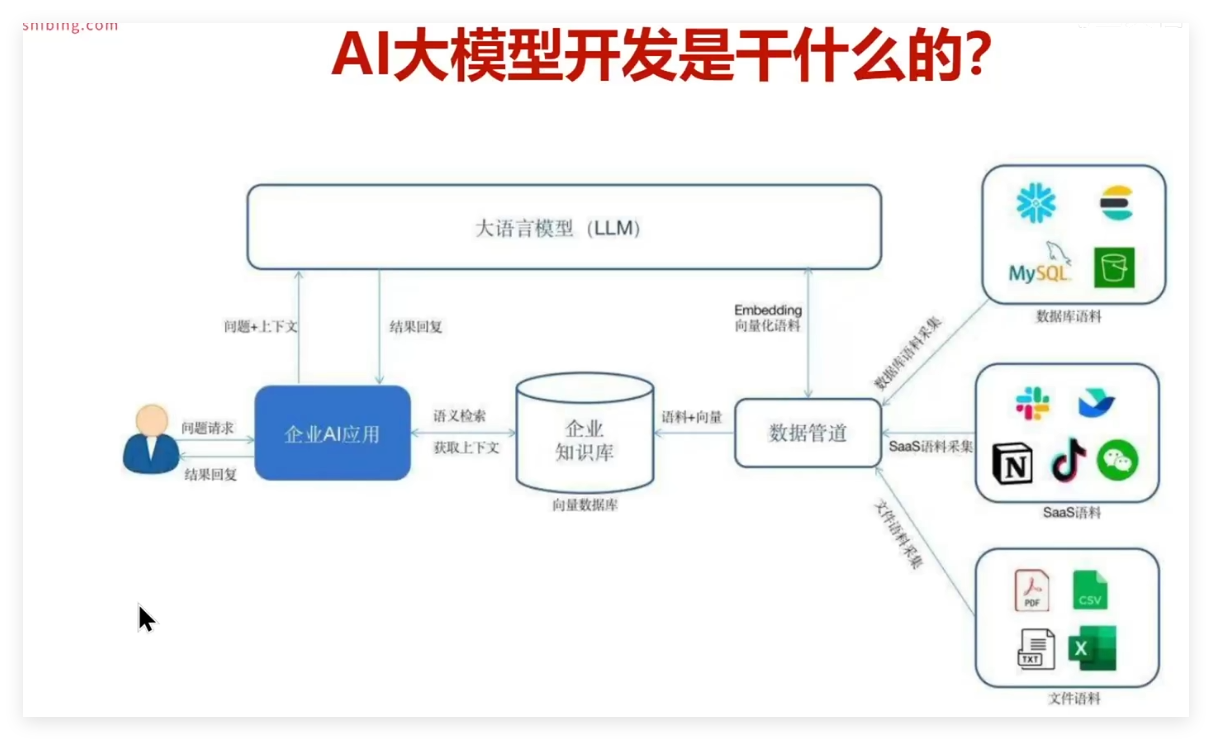

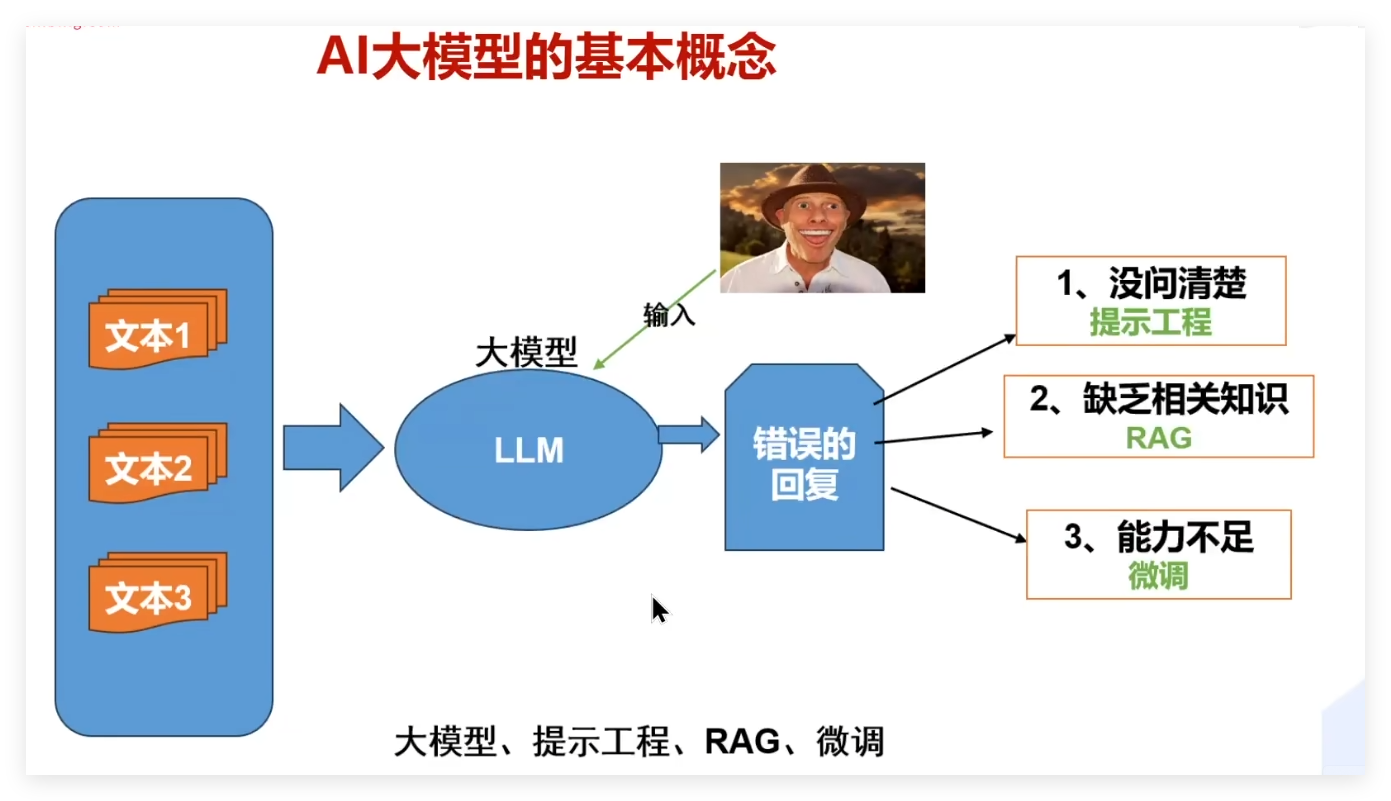

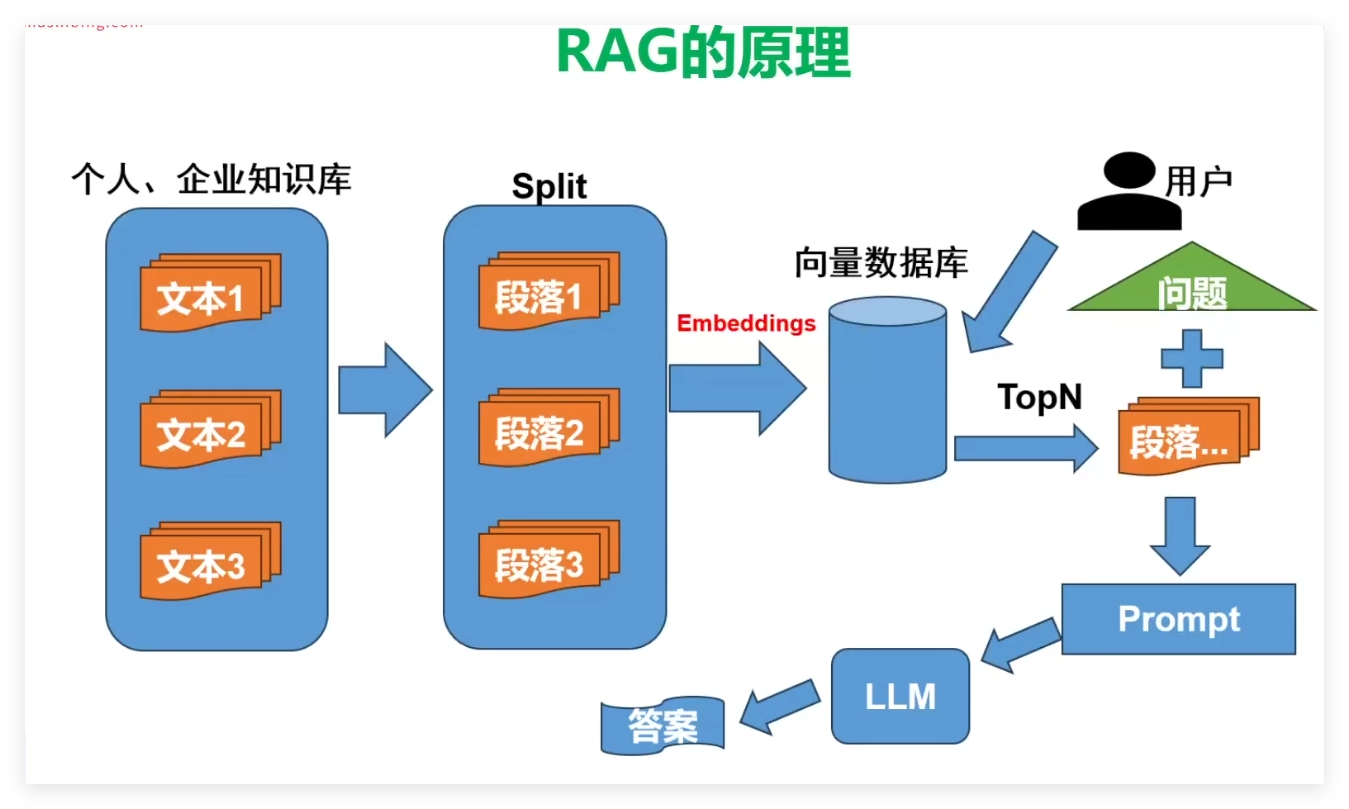

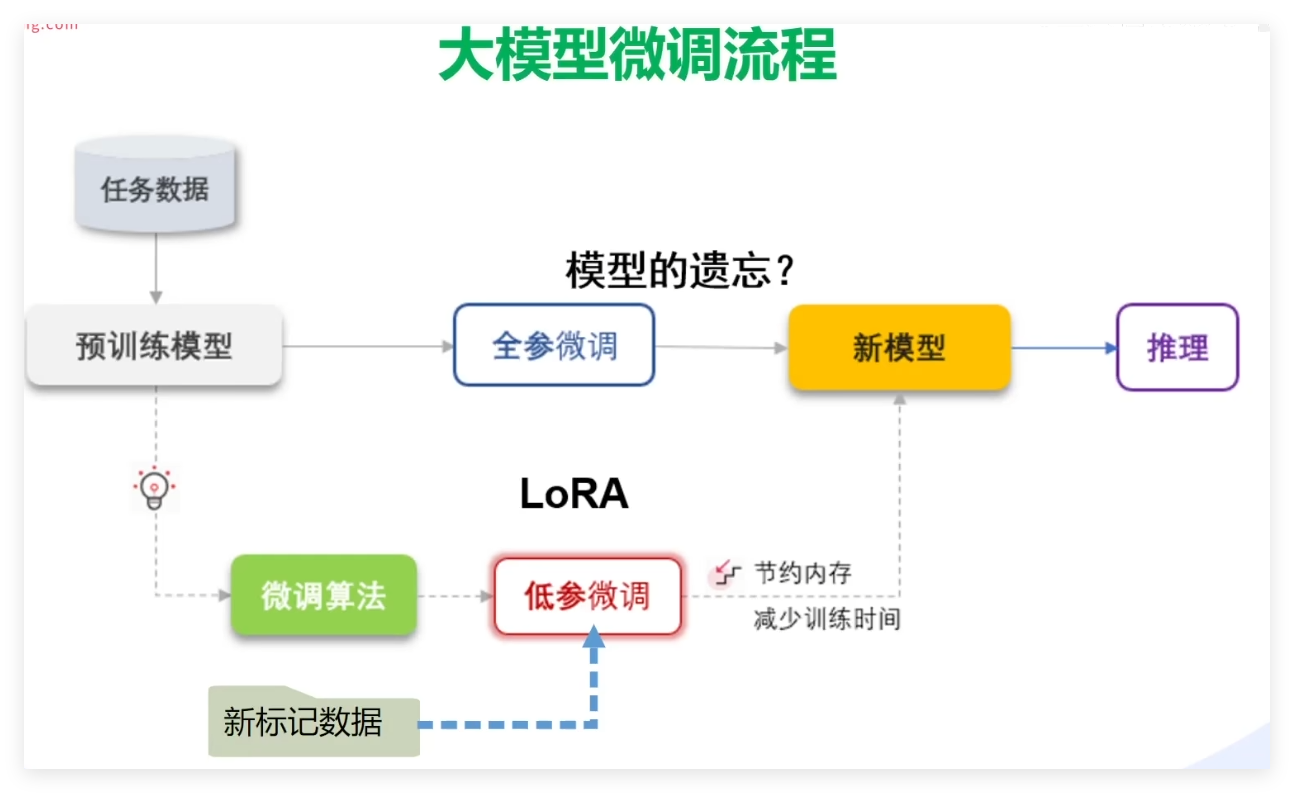

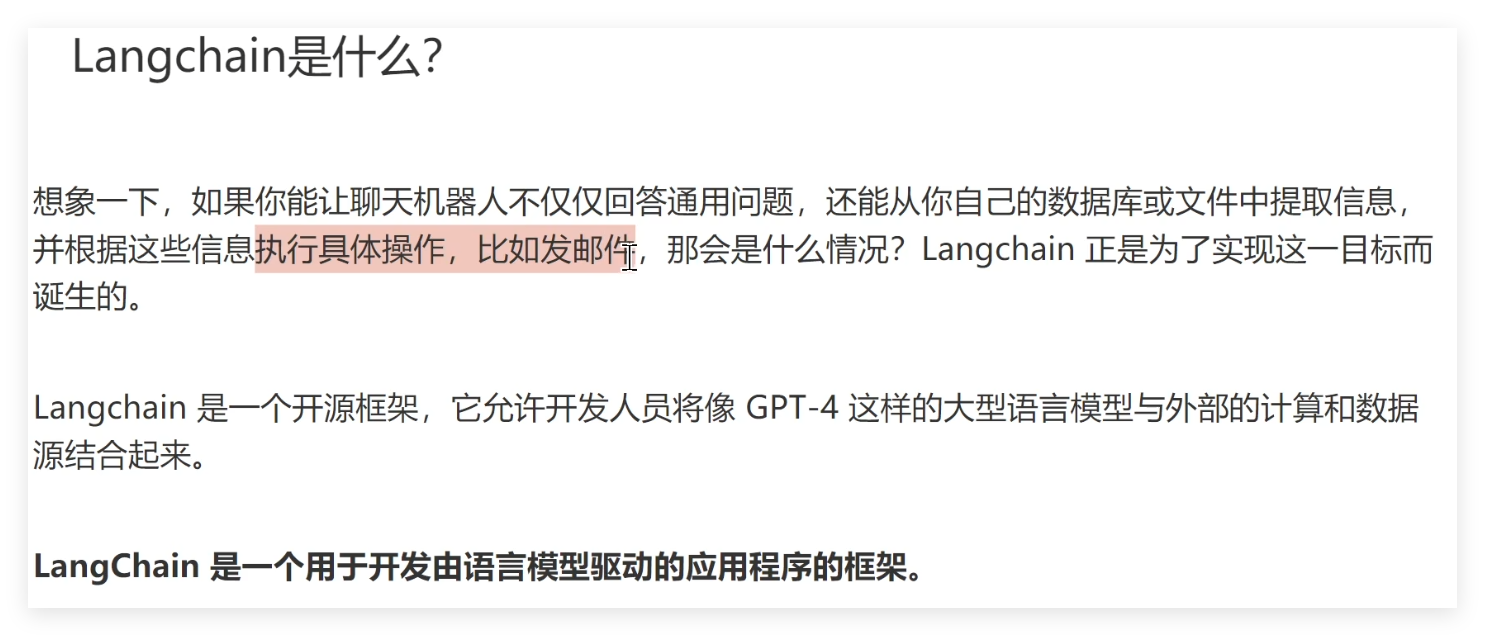

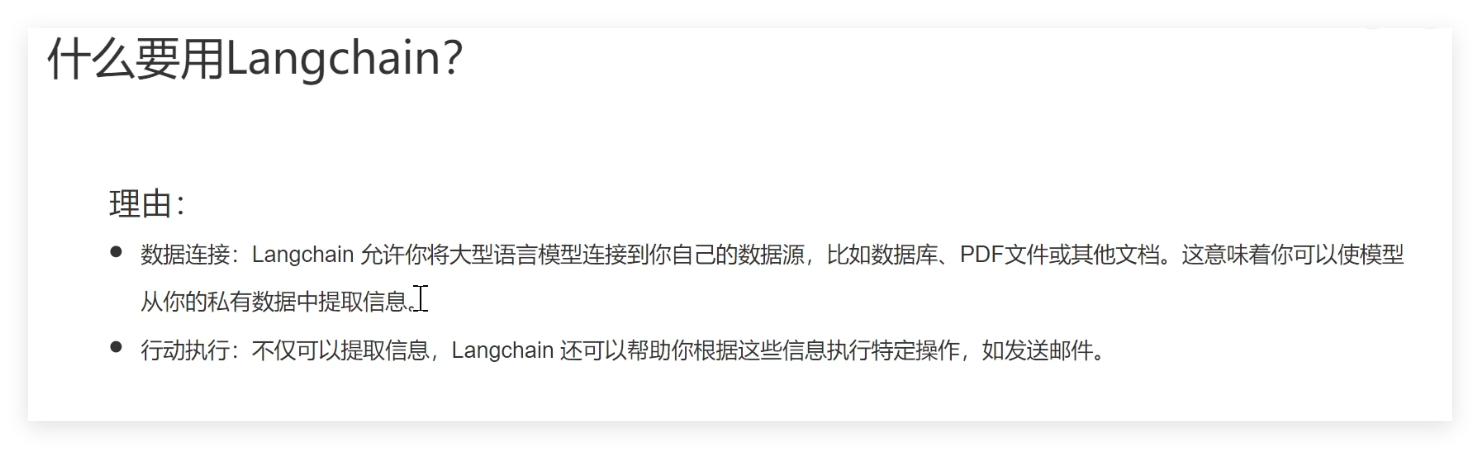

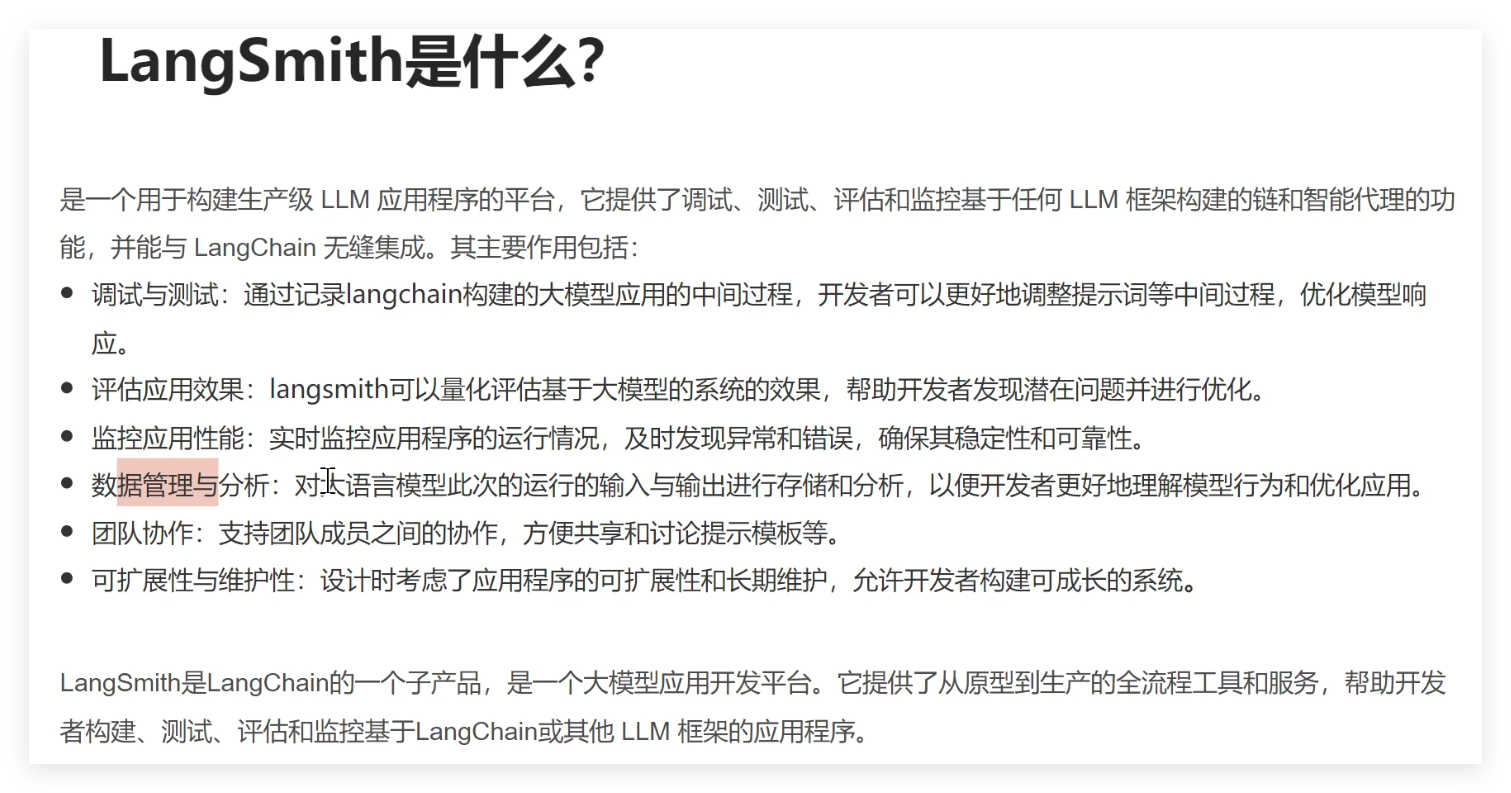

LLM开发及其介绍

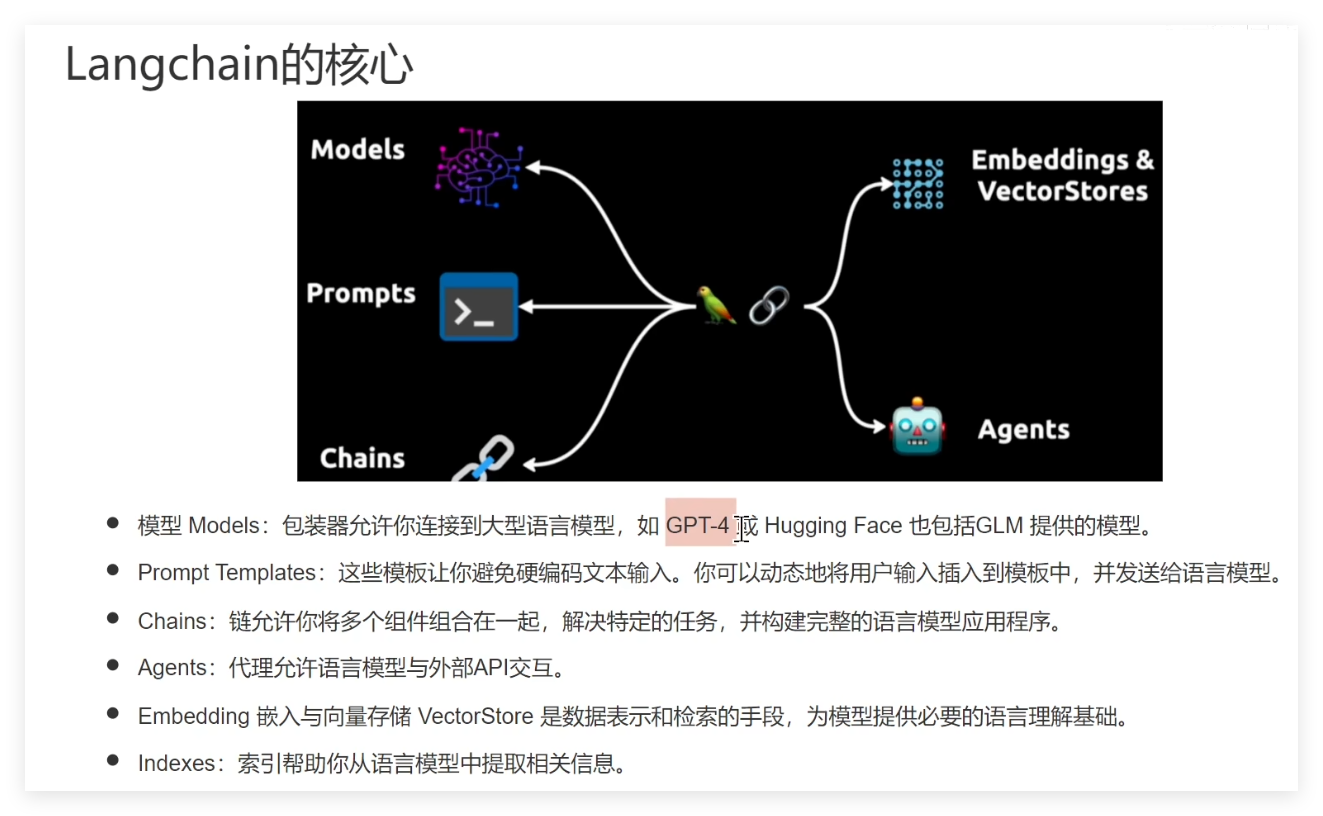

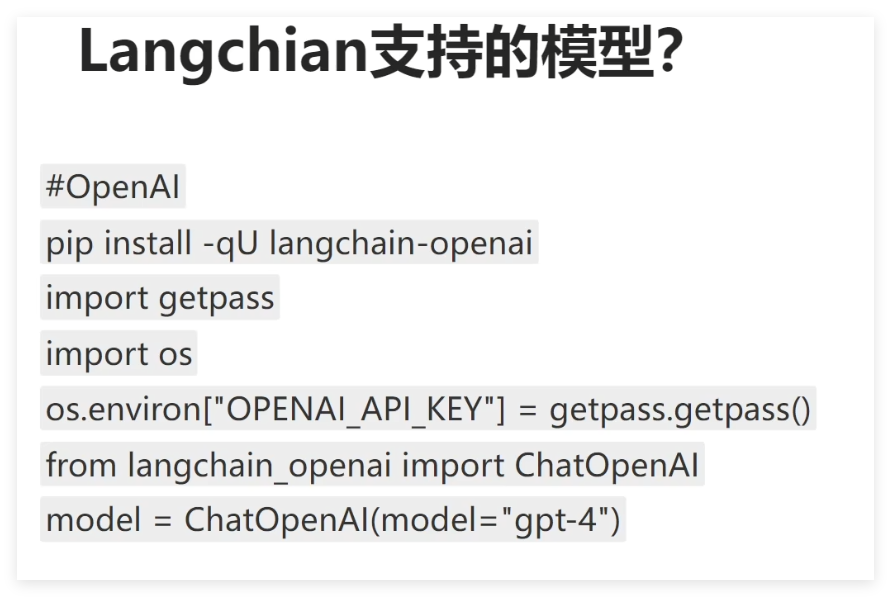

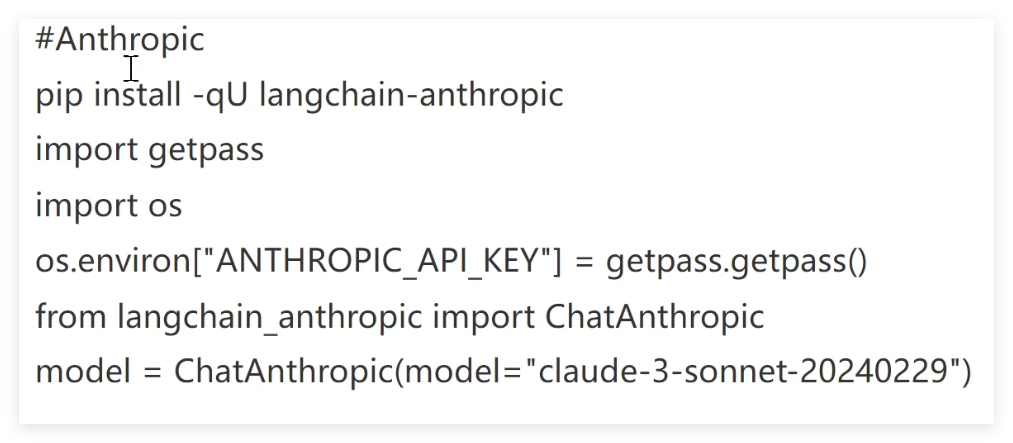

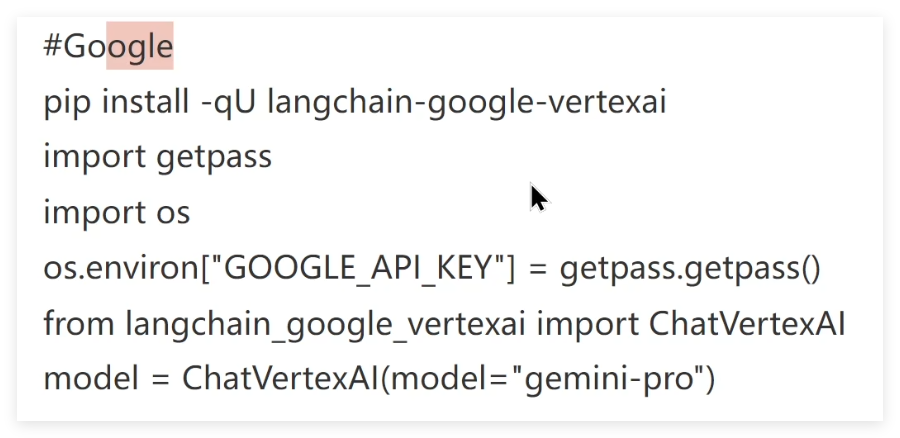

Langchain 支持的模型

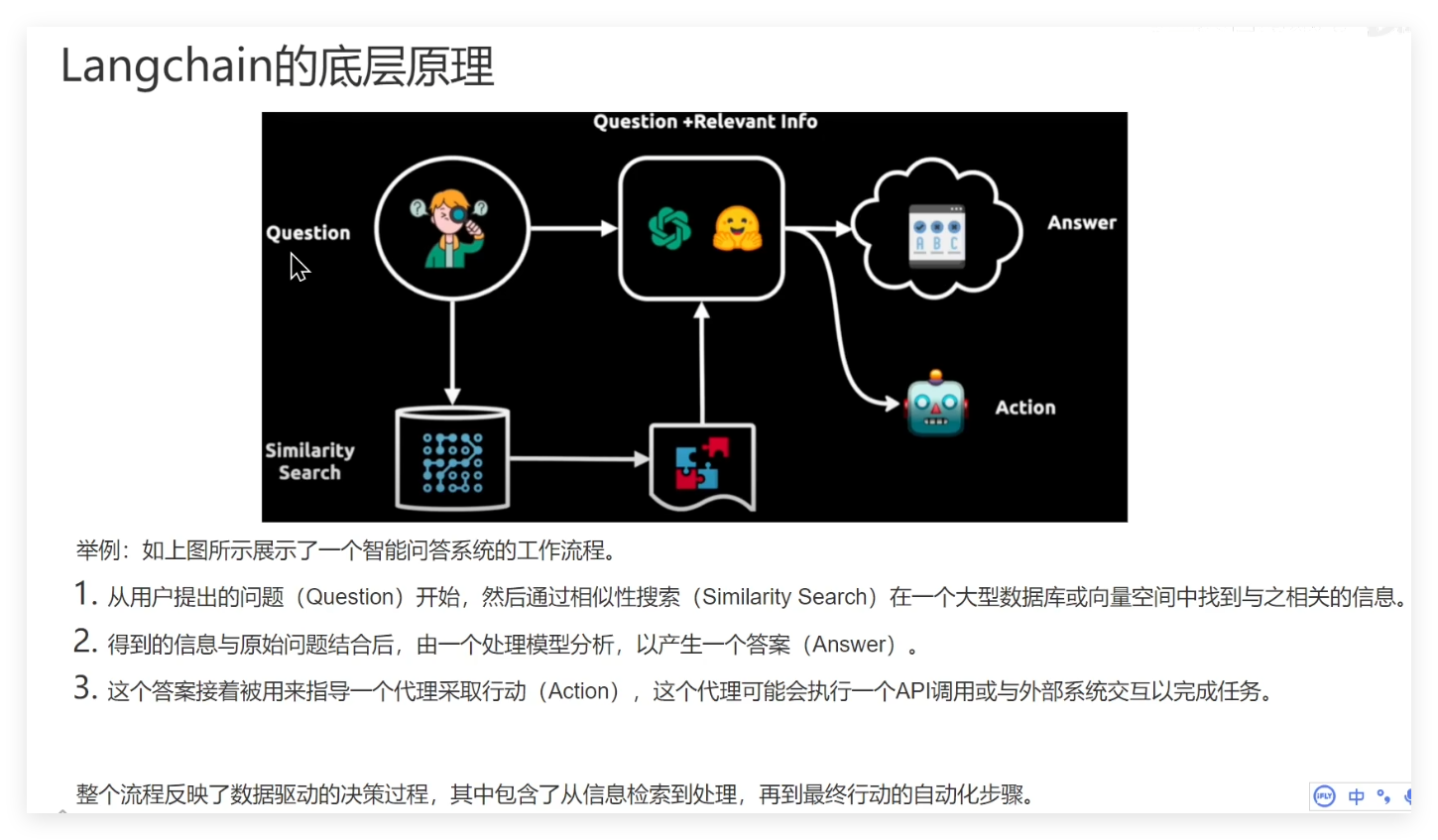

案例

案例一:Langchain简单实现LLM调用

from fastapi import FastAPI

from langchain_core.messages import SystemMessage, HumanMessage

from langchain_core.output_parsers import StrOutputParser

from langchain_core.prompts import ChatPromptTemplate

from langchain_openai import ChatOpenAI

import os

#

# os.environ["OPENAI_BASE_URL"] = "https://xxx.com/v1"

# os.environ["OPENAI_API_KEY"] = "******"

from langchain.chat_models import init_chat_model

from langserve import add_routesos.environ["LANGCHAIN_TRACING_V2"] = "true"

os.environ["LANGCHAIN_API_KEY"] = "******"

#1.模型创建

# model=ChatOpenAI(model='gpt-4-turbo')

model = init_chat_model(model="deepseek-ai/DeepSeek-R1-0528-Qwen3-8B",#"Qwen/Qwen3-8B", # 模型名称model_provider="openai", # 模型提供商,硅基流动提供了openai请求格式的访问base_url="https://api.siliconflow.cn/v1/", #硅基流动模型的请求urlapi_key="*****", # 填写你注册的硅基流动 API Key

)# #2.准备prompt

# msg=[

# SystemMessage(content='请将以下内容翻译为意大利语言'),

# HumanMessage(content='你好,请问你要去哪里?')

# ]# result=model.invoke(msg)

# print(result)#未解析答案#定义prompt模板

prompt_template=ChatPromptTemplate.from_messages([('system','请将以下内容翻译为{language}'),('user','{text}')

])#3.创建返回数据解析器

#简单解析响应数据

parser=StrOutputParser()

# print(parser.invoke(result))#仅输出结果#4.创建链

chain=prompt_template| model | parser

# print(chain.invoke(msg))

# print(chain.invoke({'language':'English','text':'我现在有事,您请回吧。'}))##服务端部署

#创建fastapi应用

app=FastAPI(title='我的Langchain服务',version='V1.0',description='翻译器')add_routes(app,chain,path="/demo_chain",#路由接口

)if __name__=="__main__":import uvicorn#port:端口号# uvicorn.run(app,host="localhost",port=123456)#127.0.0.1uvicorn.run(app, host="127.0.0.1", port=888) #在 TCP/IP 协议中,端口号是一个 16 位的整数,范围从 0 到 65535

from langserve import RemoteRunnableif __name__=="__main__":##实现服务端访问client=RemoteRunnable('http://127.0.0.1:888/demo_chain/')print(client.invoke({'language':'English','text':'我现在有事。'}))

参考资料

AI大模型