LangChain4j对话内存管理:ChatMemory原理与实战应用

LangChain4j对话内存管理:ChatMemory原理与实战应用

前言

在大语言模型应用开发中,对话上下文管理是构建智能对话系统的核心挑战。LangChain4j提供的ChatMemory组件通过智能化的消息管理策略,帮助开发者轻松应对长对话场景。本文将深入解析ChatMemory的核心机制,并通过典型场景实例演示其使用方法。

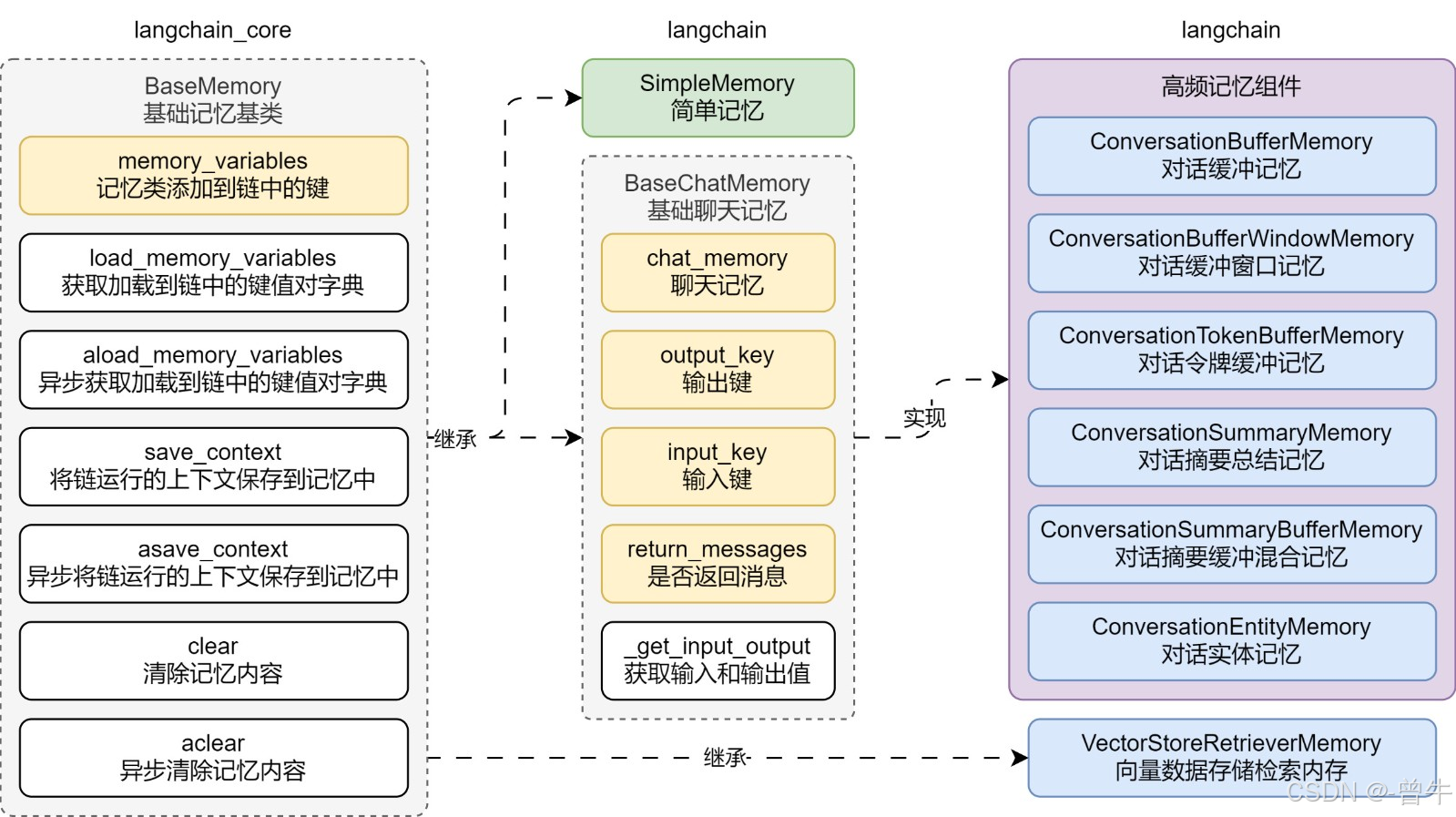

一、ChatMemory核心架构解析

1.1 内存与历史的本质区别

| 维度 | 内存(Memory) | 历史(History) |

|---|---|---|

| 数据完整性 | 选择性保留 | 完整记录所有交互 |

| 核心目标 | 优化LLM认知表现 | 忠实记录对话过程 |

| 典型操作 | 消息淘汰/摘要/增强 | 原始数据存储 |

| 应用场景 | 模型输入预处理 | 用户界面展示/审计追踪 |

1.2 淘汰策略实现原理

消息窗口策略对比:

// 基于消息数量的窗口

MessageWindowChatMemory.builder().maxMessages(20).build();// 基于Token量的窗口

TokenWindowChatMemory.builder().maxTokens(4096).tokenizer(new OpenAiTokenizer()).build();

| 策略类型 | 计算维度 | 适用场景 | 优势 |

|---|---|---|---|

| MessageWindow | 消息条数 | 快速原型开发 | 实现简单,响应快速 |

| TokenWindow | Token数量 | 生产环境 | 精准控制上下文长度 |

二、高级功能实现

2.1 持久化存储实战

public class RedisChatMemoryStore implements ChatMemoryStore {private final JedisPool jedisPool;private static final String KEY_PREFIX = "chat:memory:";@Overridepublic List<ChatMessage> getMessages(Object memoryId) {try (Jedis jedis = jedisPool.getResource()) {String json = jedis.get(KEY_PREFIX + memoryId);return ChatMessageDeserializer.messagesFromJson(json);}}@Overridepublic void updateMessages(Object memoryId, List<ChatMessage> messages) {try (Jedis jedis = jedisPool.getResource()) {String json = ChatMessageSerializer.messagesToJson(messages);jedis.setex(KEY_PREFIX + memoryId, 3600, json);}}

}

2.2 特殊消息处理机制

SystemMessage处理规则:

- 唯一性保证:系统消息全局唯一

- 版本控制:内容变更时自动更新

- 持久保留:不受淘汰策略影响

工具消息关联处理:

三、典型应用场景实例

3.1 多用户会话隔离

class ChatService {private final Map<String, ChatMemory> userMemories = new ConcurrentHashMap<>();public String chat(String userId, String message) {ChatMemory memory = userMemories.computeIfAbsent(userId, id -> TokenWindowChatMemory.builder().id(id).maxTokens(2000).build());memory.add(new UserMessage(message));AiMessage response = aiService.generate(memory.messages());memory.add(response);return response.text();}

}

3.2 增强式对话管理

ChatMemory memory = TokenWindowChatMemory.builder().maxTokens(3000).tokenizer(new HuggingFaceTokenizer()).chatMemoryStore(new PostgreSQLStore()).build();// 注入系统指令

memory.add(new SystemMessage("你是一位精通唐诗的AI助手,回答时需引用诗句"));// 自动处理工具调用

memory.add(new AiMessage("请查询北京天气", ToolExecutionRequest.builder().name("weather_query").build()));

四、性能优化实践

4.1 内存监控指标

| 指标名称 | 监控阈值 | 优化策略 |

|---|---|---|

| 上下文Token量 | < 模型最大限制80% | 调整窗口大小/启用消息摘要 |

| 持久化操作延迟 | < 100ms | 启用异步写入/缓存批处理 |

| 消息处理吞吐量 | > 1000 TPS | 采用对象池化/内存分片 |

4.2 常见问题排查指南

症状: 对话出现上下文断裂

- 检查项:淘汰策略配置、Token计算准确性、系统消息保留状态

症状: 工具调用结果丢失

- 检查项:主消息保留情况、关联消息处理逻辑、存储序列化完整性

总结

LangChain4j的ChatMemory组件为对话系统提供了三大核心价值:

- 智能上下文管理:通过动态淘汰策略平衡性能与信息完整性

- 企业级扩展能力:开放的存储接口支持各类数据库集成

- 语义感知处理:对系统指令和工具调用的特殊处理保证业务逻辑正确性

建议在实际应用中结合监控系统,持续优化淘汰策略参数。对于需要严格审计的场景,建议同时维护独立的历史存储系统。未来可探索将摘要生成等AI能力融入内存管理,实现更智能的上下文优化。