Dify部署全攻略:从零开始搭建AI应用开发平台

Dify是一个开源的AI应用开发平台,它提供了一套完整的工具链,让开发者能够快速构建、部署和管理AI应用。本文将详细介绍Dify的部署方式、配置要点以及常见问题解决方案。

dify文档:dify文档传送门

dify中文文档:dify中文文档传送门

一、Dify简介

Dify是一个开源的LLM应用开发平台,具有以下特点:

- 🚀 可视化Prompt编排

- 🧠 支持多种大语言模型

- 🔧 完整的后端服务

- 🎨 现代化的前端界面

- 📊 数据分析和监控

二、部署环境准备

2.1 系统要求

- 操作系统:Linux、macOS或Windows(推荐Linux)

- 内存:至少4GB RAM(推荐8GB以上)

- 存储:至少10GB可用空间

- Docker:版本19.03或更高

- Docker Compose:版本1.27.0或更高

2.2 安装Docker和Docker Compose

docker和docker compose的安装可参考教程:docker安装教程、docker compose安装教程

三、Dify部署方式详解

3.1 Docker Compose一键部署(推荐)

步骤1:下载DIfy源码

# git下载最新版本

git clone https://github.com/langgenius/dify.git# git下载指定版本

git clone https://github.com/langgenius/dify.git --branch 0.15.3步骤2:启动Dify

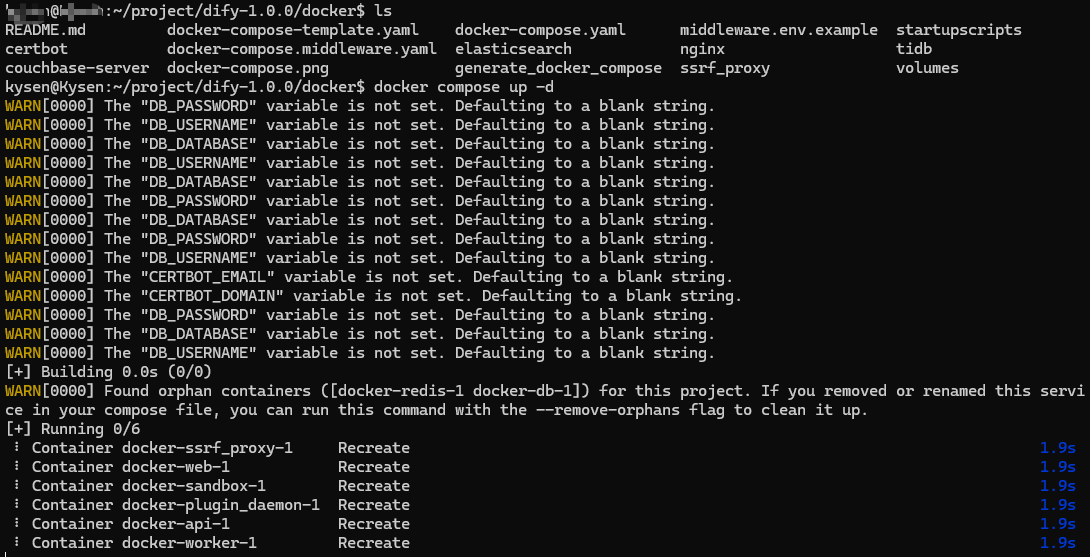

cd dify/dockercp .env.example .envdocker compose up -d注意,一定要切换到docker路径才可用docker compose启动。

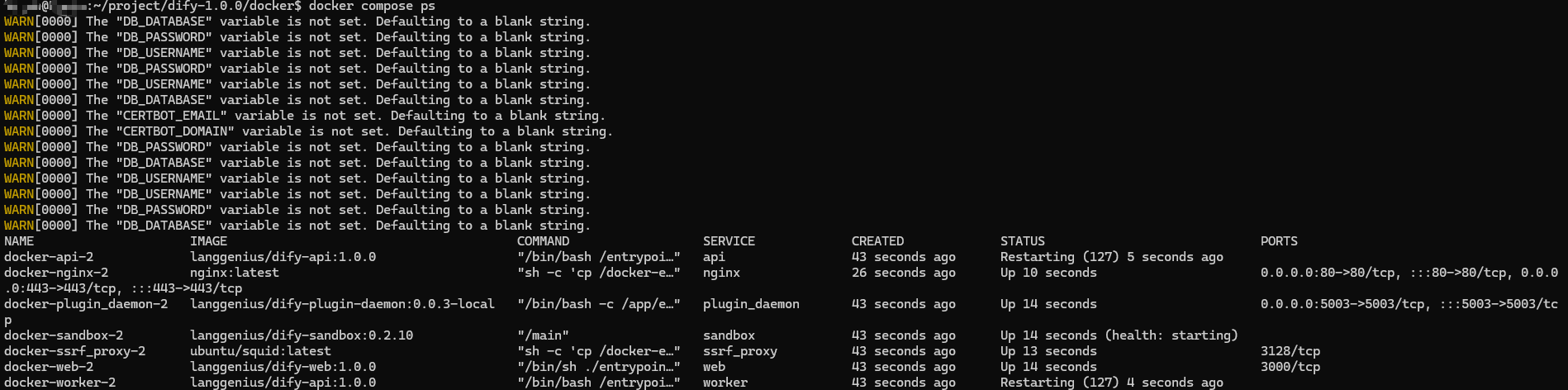

可使用docker compose ps查看启动的容器组来验证是否成功。

3.2 重新启动 Dify

若有更改Dify的配置,采用以下方式重启生效。

方法一:一键重启

# 重启容器组

docker compose restart方法二:关闭后启动

# 关闭容器组

docker compose down# 启动容器组

docker compose up -d更改dify配置可在.env文件或者docker-compose.yaml文件做更改。

四、Dify使用

4.1 注册登录账号

dify启动成功后,在浏览器中输入IP即可打开dify网页,因为未改配置默认ng暴露80端口号进行代理。

首次打开网页需要登陆,第一个登陆的账号就是注册的最高管理员账号,登陆好了就等于已经注册了,登陆进去后可更改再密码。

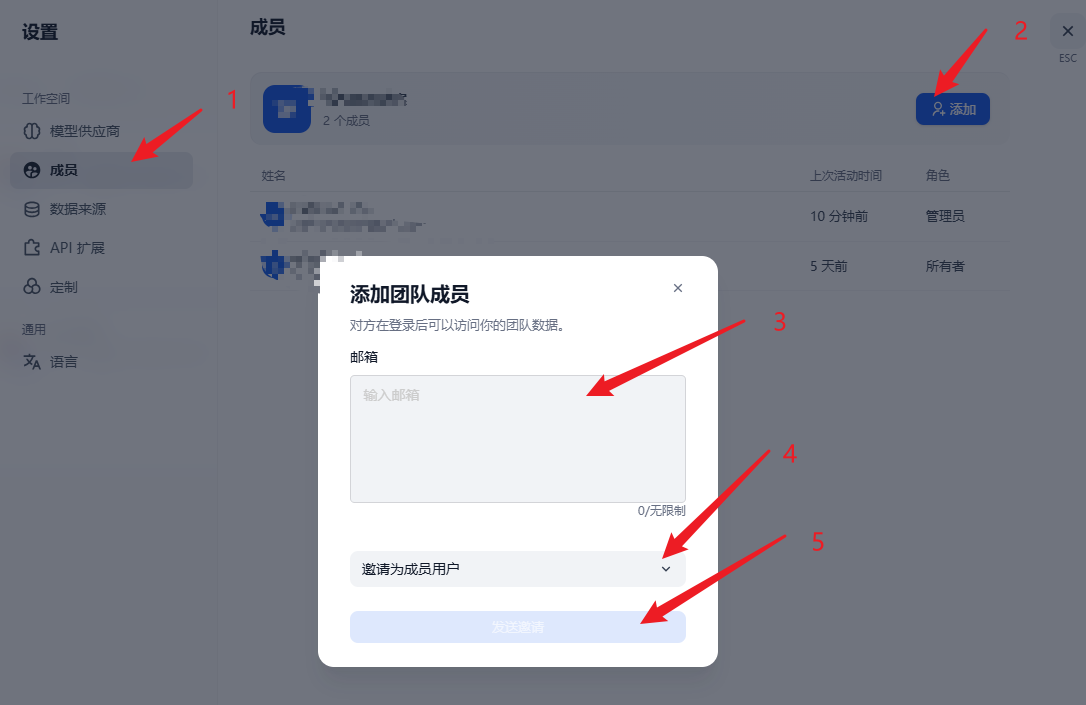

另外可邀请团队成员,点击设置-成员-添加,填写成员的邮箱,选择邀请的用户类型(不同类型对应不同的权限),点击发送邀请,将出现的连接给对应的成员,即可登陆,用法跟最高管理员账号第一次登陆一样。

4.2 dify简单使用

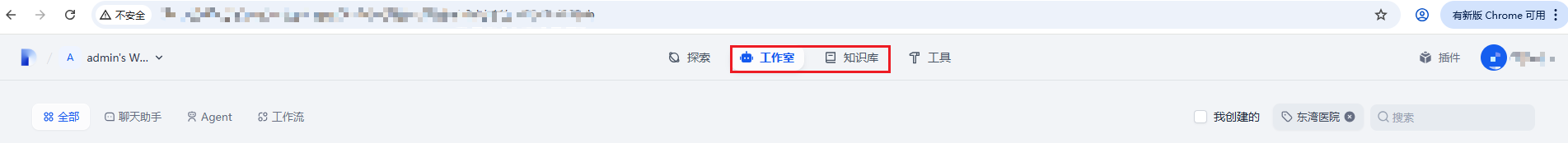

常用的是工作室和知识库,工作室中包含聊天助手和工作流的功能,配置好通用的对话大模型就能用,工作流做好了可以保存为DSL文件,在其他地址dify上直接上传该DSL文件就可以将做好的工作流移过去;知识库主要提供RAG的功能,需要配置embedding模型和rerank模型才能用。

4.3 dify模型配置

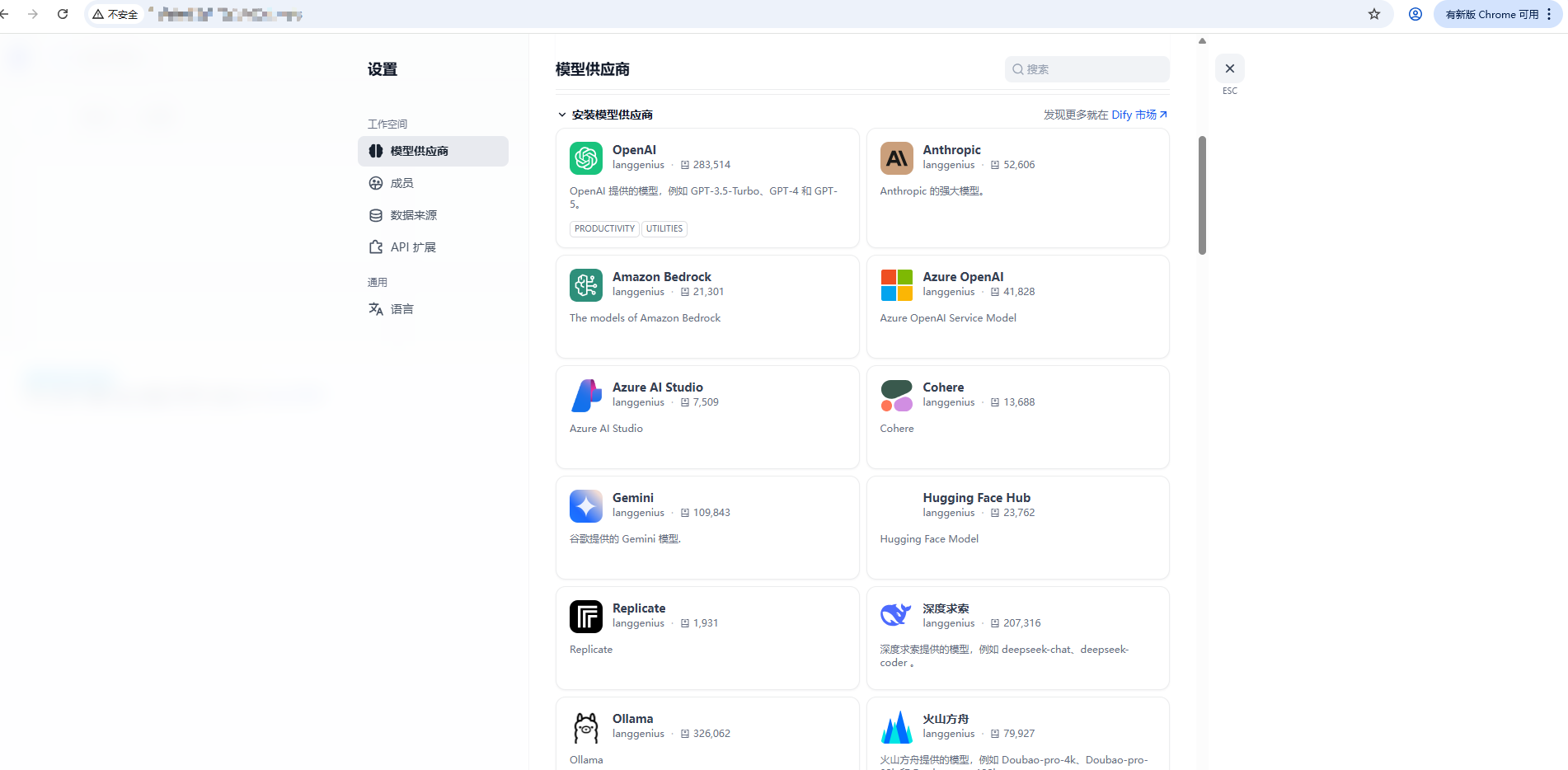

点击右上角的用户-设置,点击工作空间下的模型供应商进行配置模型。

(1)通用大模型可用OpenAI-API-compatible这个供应商配置,只要符合OpenAI协议的都能用,例如vLLM部署的模型。也可以用Ollama这个供应商配置,配置Ollama部署的模型。

(2)embedding模型和rerank模型,可选择Xinference这个模型供应商配置的Xinference部署的模型。

配置时,参数要选对才能配置成功,否则保存时会报错,例如配置Ollama部署的模型,模型类型选择LLM,模型名称要和部署时的名称相同,URL要填好Ollama的IP和端口号。

4.4 制作工作流

制作自己的工作流时,需要配置相应的模型。其中工作流提供LLM、条件分支、代码执行、HTT怕请求等节点,另外还提供了工具可用。LLM节点需要选择模型,书写自己的提示词。