百度深度学习面试:batch_size的选择问题

题目

在深度学习中,为什么batch_size设置为1不好?为什么batch_size设为整个数据集的大小也不好?(假设服务器显存足够)

解答

这是一个非常核心的深度学习超参数问题。即使显存足够,选择极端的 batch_size 也通常会带来显著的性能下降。这背后是优化动力学(Optimization Dynamics)和泛化能力(Generalization) 的深层权衡。

下面我们分别详细探讨。

一、为什么 batch_size = 1(在线学习)不好?

将 batch_size 设置为 1 意味着每看到一个样本就更新一次权重,这被称为随机梯度下降(SGD) 或在线学习。其问题主要在于:

1. 训练过程极度不稳定,收敛困难

高方差梯度:单个样本的梯度是整个训练集梯度的一个噪声非常大的估计。这次更新可能指向一个正确的方向,下一次更新可能指向一个完全相反的方向。

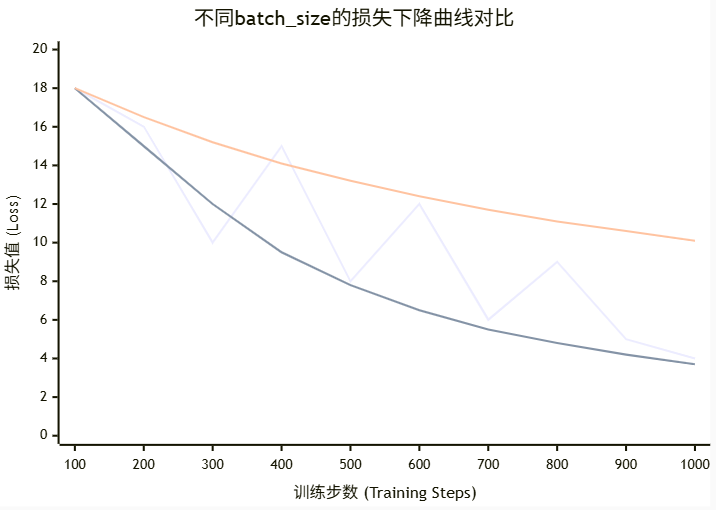

损失剧烈震荡:模型的损失函数会剧烈跳动,难以平滑地下降到一个好的局部最优点(或平坦的最小值区域)。如下图所示,

bs=1的路径非常曲折嘈杂。难以设置学习率:学习率设置得非常小,收敛会慢得无法忍受;学习率设置得稍大,一次“坏”的更新就可能让模型参数跳出当前正在优化的良好区域,甚至导致梯度爆炸,训练完全失败。

2. 无法利用硬件并行计算,训练效率极低

现代深度学习严重依赖 GPU/TPU 的并行计算能力。这些硬件在设计上对大规模矩阵运算(如大的矩阵乘法)进行了极致优化。

batch_size = 1意味着每次只计算一个样本的梯度,GPU 的绝大多数计算单元都处于空闲状态。这完全浪费了硬件的强大算力,导致训练时间变得异常漫长。

3. 失去梯度下降的“平均”效应

Batch 梯度下降的核心思想是通过一批样本的梯度求平均来获得一个对数据分布更真实、更稳定的估计。

bs=1失去了这种平均效应,模型更容易记住噪声和异常值,而不是学习数据中通用的模式。

简单比喻:这就像在暴风雨中划船,你每划一桨(一次更新)就根据刚刚遇到的一个浪头来决定下一桨的方向,而不是观察过去几秒钟的整体水流情况。结果就是你一直在剧烈地左右摇摆,很难高效地前进。

二、为什么 batch_size = 整个训练集(批梯度下降)也不好?

将 batch_size 设置为整个数据集的大小,意味着每个 epoch 只进行一次更新。虽然梯度方向是最准确的,但问题同样突出:

1. 泛化能力差:容易陷入尖锐最小值(Sharp Minimum)

这是最核心的问题。理论研究和大规模实验表明,小的 batch size 倾向于找到 平坦的最小值(Flat Minimum),而大的 batch size 倾向于找到 尖锐的最小值(Sharp Minimum)。

平坦最小值:损失函数在某个区域都比较低,像一个宽阔的山谷。模型参数在这个区域发生微小变化时,损失值变化不大,因此模型对没见过的测试数据(分布略有不同)鲁棒性强,泛化能力好。

尖锐最小值:损失函数在一个点很低,但周围陡然升高,像一个狭窄的深井。虽然训练损失可以很低,但模型参数稍一变动,性能就急剧下降,因此泛化能力通常很差,容易过拟合。

2. 计算成本和内存问题

虽然假设显存足够,但计算依然昂贵:即使显存能放下整个数据集,计算整个数据集的梯度也是一次巨大的计算开销。尤其是对于大规模数据集(如 ImageNet),一次前向和反向传播的计算成本非常高。

内存瓶颈:对于非常大的模型和数据集,即使显存足够,一次加载所有数据也会触及硬件的内存带宽上限,可能并不会比中等 batch size 快多少。

3. 优化过程容易陷入局部最优点和鞍点

小 batch size 带来的梯度噪声在某种程度上是一种正则化,它可以帮助模型参数“跳出”不好的局部最优点或鞍点。

当使用全批梯度下降时,梯度估计非常精确,缺乏这种“扰动”能力。一旦梯度接近于零(如在鞍点或平坦区域),优化过程就会完全停止,因为没有噪声把它推出去寻找更好的区域。

4. 收敛所需的迭代次数更少,但总计算量更大

由于每次更新方向都是最优的,理论上达到相同精度所需的 epoch 数量更少。

但是,每个 epoch 的计算成本远远高于小 batch size 的方案。综合考虑总计算时间和最终泛化性能,全批梯度下降几乎总是最差的选择。

简单比喻:这就像你要从北京去上海,全批梯度下降是让你先精确测量出整个地球的曲率和路况,规划出一条理论上绝对最短的直线路径(可能要打隧道、架跨海大桥),然后一步到位。这个过程规划成本极高,且路径脆弱(桥断了就完了)。而小批量梯度下降则是每走一段就看一眼地图调整一下,虽然路径不是绝对最短,但更灵活、更鲁棒,总用时可能更少。

总结与最佳实践

| 特性 | batch_size = 1 | batch_size = 全数据集 | 中等 batch_size (e.g., 32, 64, 256) |

|---|---|---|---|

| 梯度质量 | 噪声大,方差高 | 非常精确,方差低 | 噪声适中,是真实梯度的良好估计 |

| 训练稳定性 | 非常不稳定 | 非常稳定 | 相对稳定 |

| 收敛速度 | 慢(步数多) | 快(步数少)但每步慢 | 总计算时间最优 |

| 泛化能力 | 通常较好(噪声正则化) | 通常较差(陷尖锐最小点) | 最好(噪声与稳定性的平衡) |

| 硬件利用率 | 极低(无法并行) | 高(但可能内存受限) | 极高(完美并行) |

| 内存需求 | 很低 | 极高 | 可调节 |

最佳实践:

从一个适中的值开始(例如 32),这是一个在大多数任务上都表现良好的默认值。

考虑 GPU 内存:在保证不爆显存的前提下,尽可能使用更大的 batch size 以充分利用并行计算。通常使用

2^N的大小(如 32, 64, 128),因为某些硬件和库对此有优化。调整学习率:当增加 batch size 时,通常需要同步增大学习率(如线性缩放规则:

new_lr = old_lr * (new_bs / old_bs)),因为更大的 batch 意味着更可靠的梯度,我们可以更大胆地前进。对于非常大的 batch size,还需要配合学习率热身(Learning Rate Warmup) 等技巧来保持训练的稳定性。

因此,深度学习中 batch size 的选择是一个典型的权衡艺术,需要在优化效率和泛化性能之间找到最佳平衡点,而两个极端通常都不是好的选择。