【完整源码+数据集+部署教程】高尔夫球追踪与识别系统源码和数据集:改进yolo11-LAWDS

背景意义

研究背景与意义

高尔夫运动作为一项广受欢迎的休闲和竞技活动,吸引了大量的参与者和观众。随着科技的进步,尤其是计算机视觉和深度学习技术的发展,如何利用这些技术来提升高尔夫运动的训练和观赏体验,成为了一个重要的研究方向。高尔夫球的追踪与识别不仅能够帮助运动员分析自己的击球技术,还能为教练提供更为精准的数据支持,从而制定个性化的训练方案。此外,借助先进的视觉识别系统,赛事转播也能够更加生动地展示比赛过程,提升观众的观看体验。

在此背景下,基于改进YOLOv11的高尔夫球追踪与识别系统应运而生。YOLO(You Only Look Once)系列模型以其高效的实时检测能力和优越的准确性,在物体检测领域中得到了广泛应用。通过对YOLOv11的改进,结合特定的高尔夫球数据集,我们能够实现对高尔夫球及其相关物体(如球杆、不同颜色的高尔夫球等)的高效识别与追踪。该数据集包含2600张图像,涵盖了四个主要类别:球杆、白色高尔夫球、黄色高尔夫球和小型高尔夫球。这些数据的丰富性和多样性为模型的训练提供了坚实的基础。

通过对高尔夫球的精准追踪与识别,不仅可以提升运动员的训练效果,还能为高尔夫赛事的智能化转播提供技术支持,推动高尔夫运动的数字化转型。此外,该系统的成功应用也为其他运动项目的物体检测与追踪提供了借鉴,具有广泛的应用前景和研究价值。因此,基于改进YOLOv11的高尔夫球追踪与识别系统的研究,不仅具有重要的学术意义,也将为高尔夫运动的未来发展注入新的活力。

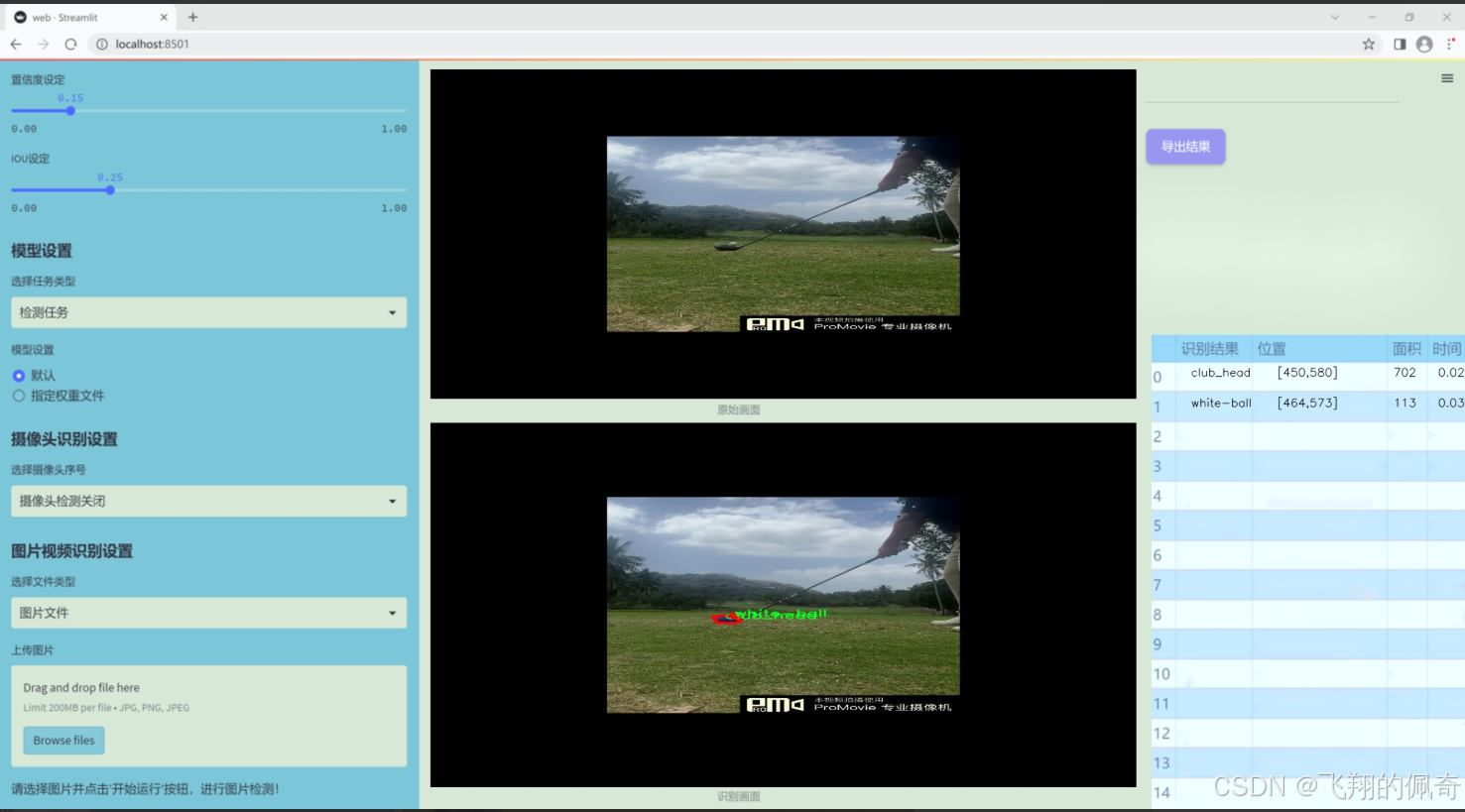

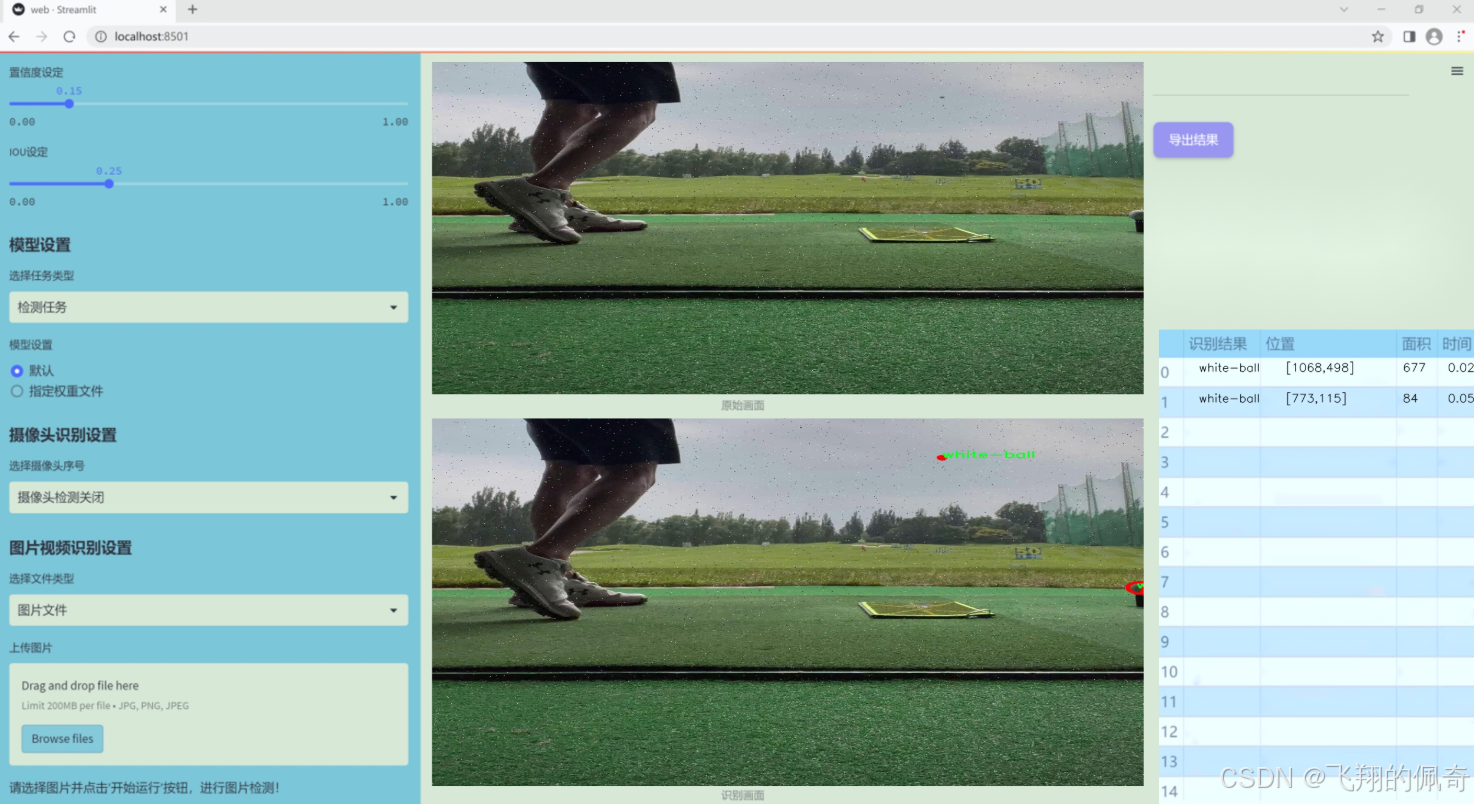

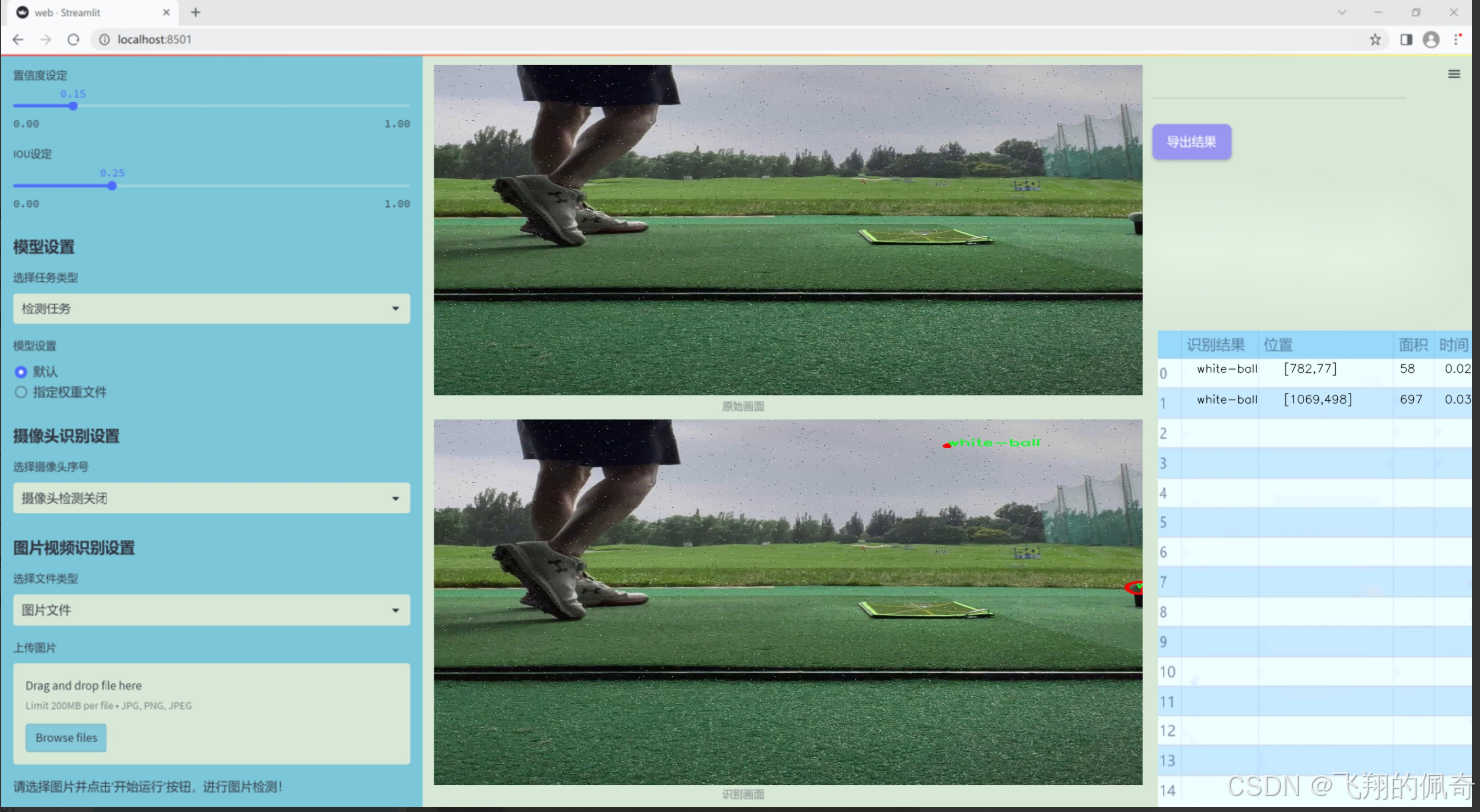

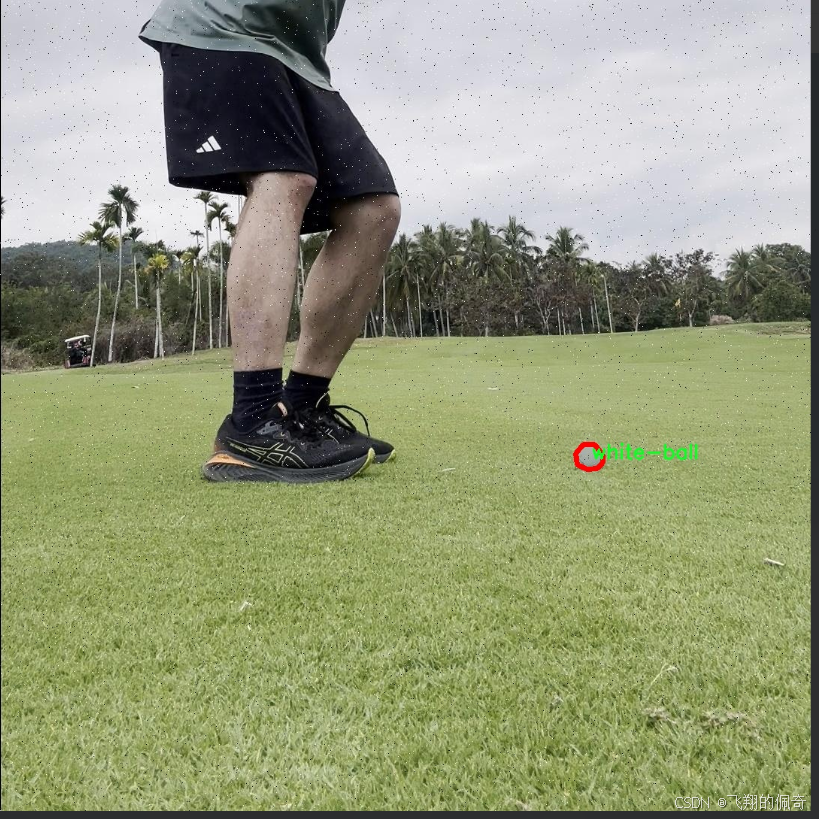

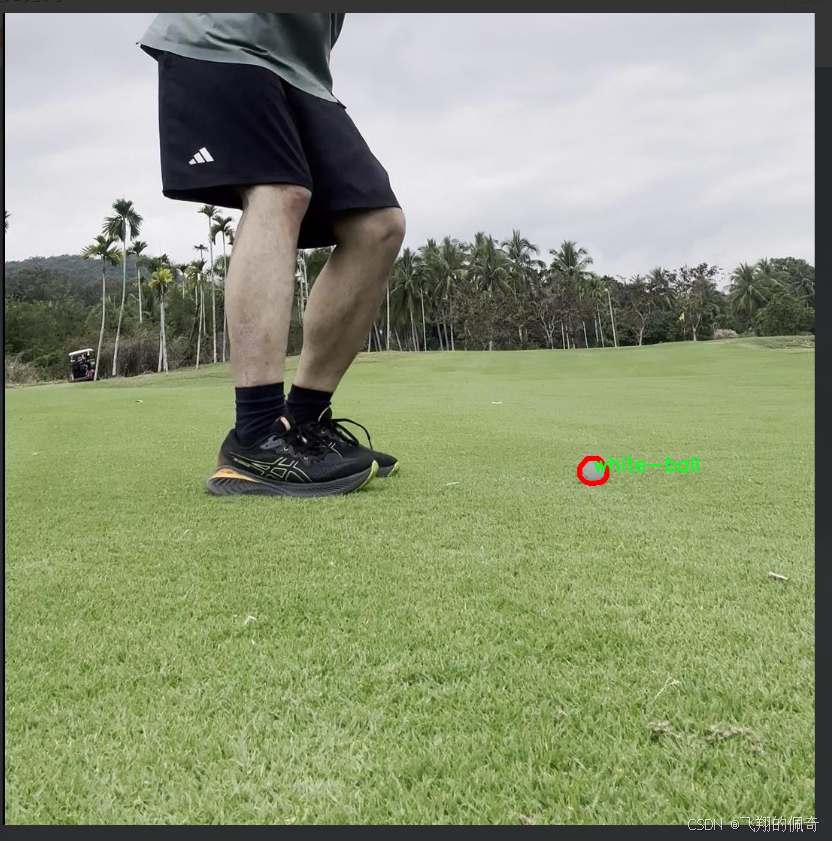

图片效果

数据集信息

本项目数据集信息介绍

本项目所使用的数据集旨在支持高尔夫球追踪与识别系统的训练,特别是针对改进YOLOv11模型的应用。数据集的主题为“golf-tracking-with-color 2”,专注于高尔夫运动中关键物体的检测与识别。该数据集包含四个主要类别,分别是“club_head”(球杆头)、“small-ball”(小球)、“white-ball”(白色球)和“yellow-ball”(黄色球)。这些类别的选择反映了高尔夫运动中常见的物体,能够有效地帮助模型学习和识别不同类型的高尔夫球及其相关装备。

在数据集的构建过程中,充分考虑了高尔夫运动的实际场景,确保数据的多样性和代表性。数据集中包含了不同光照条件、角度和背景下的图像,以提高模型在真实环境中的鲁棒性。每个类别的样本数量经过精心设计,以确保模型在训练过程中能够获得均衡的学习机会,从而提高其对各类物体的识别准确性。

此外,数据集还包含了丰富的标注信息,确保每个图像中的目标物体都被准确标记。这种高质量的标注不仅有助于模型的训练,也为后续的性能评估提供了可靠的依据。通过使用这一数据集,研究团队希望能够显著提升YOLOv11在高尔夫球追踪与识别任务中的表现,使其在实际应用中能够更精准地识别和追踪高尔夫球及其相关装备,从而为高尔夫运动的分析和研究提供更为强大的技术支持。

核心代码

activation.py

import torch

import torch.nn as nn

class AGLU(nn.Module):

“”“AGLU激活函数模块,来自于https://github.com/kostas1515/AGLU。”“”

def __init__(self, device=None, dtype=None) -> None:"""初始化AGLU激活函数模块。"""super().__init__()# 使用Softplus作为基础激活函数,beta设为-1.0self.act = nn.Softplus(beta=-1.0)# 初始化lambda参数,使用均匀分布self.lambd = nn.Parameter(nn.init.uniform_(torch.empty(1, device=device, dtype=dtype))) # 初始化kappa参数,使用均匀分布self.kappa = nn.Parameter(nn.init.uniform_(torch.empty(1, device=device, dtype=dtype))) def forward(self, x: torch.Tensor) -> torch.Tensor:"""计算AGLU激活函数的前向传播。"""# 将lambda参数限制在最小值0.0001以上lam = torch.clamp(self.lambd, min=0.0001)# 计算AGLU激活函数的输出return torch.exp((1 / lam) * self.act((self.kappa * x) - torch.log(lam)))

代码注释说明:

导入必要的库:导入PyTorch库及其神经网络模块。

AGLU类:定义一个名为AGLU的类,继承自nn.Module,表示一个自定义的激活函数模块。

初始化方法:

调用父类的初始化方法。

创建一个Softplus激活函数实例,并设置beta为-1.0。

初始化两个可学习参数lambd和kappa,它们的初始值是从均匀分布中随机生成的。

前向传播方法:

将lambd参数限制在0.0001以上,以避免在计算中出现过小的值。

计算并返回AGLU激活函数的输出,公式中使用了Softplus激活函数的输出和lambd、kappa参数。

这个程序文件名为 activation.py,主要定义了一个名为 AGLU 的激活函数模块,属于 Ultralytics YOLO 项目的一部分,遵循 AGPL-3.0 许可证。文件中首先导入了 PyTorch 库及其神经网络模块。

AGLU 类继承自 nn.Module,表示这是一个自定义的神经网络模块。在类的初始化方法 init 中,首先调用了父类的初始化方法。接着,定义了一个激活函数 self.act,使用了 nn.Softplus,其参数 beta 被设置为 -1.0,这意味着该激活函数的形状会有所不同。

此外,类中还定义了两个可学习的参数 lambd 和 kappa,这两个参数通过 nn.Parameter 来创建,并使用均匀分布初始化。lambd 和 kappa 的初始化是基于输入的设备和数据类型,这使得该模块能够在不同的硬件上灵活运行。

在 forward 方法中,定义了前向传播的计算过程。输入的张量 x 经过处理后,首先对 lambd 进行限制,确保其最小值为 0.0001,以避免数值不稳定。然后,计算的结果是通过 torch.exp 函数对经过 self.act 处理后的值进行指数运算,具体计算公式为 (1 / lam) * self.act((self.kappa * x) - torch.log(lam))。

总的来说,这个模块实现了一种新的激活函数,结合了可学习的参数,旨在提高神经网络的表达能力和性能。

10.4 wtconv2d.py

以下是代码中最核心的部分,并附上详细的中文注释:

import torch

import torch.nn as nn

import torch.nn.functional as F

from torch.autograd import Function

import pywt

创建小波滤波器

def create_wavelet_filter(wave, in_size, out_size, type=torch.float):

# 使用pywt库创建小波对象

w = pywt.Wavelet(wave)

# 反转小波的分解高通和低通滤波器

dec_hi = torch.tensor(w.dec_hi[::-1], dtype=type)

dec_lo = torch.tensor(w.dec_lo[::-1], dtype=type)

# 创建分解滤波器

dec_filters = torch.stack([dec_lo.unsqueeze(0) * dec_lo.unsqueeze(1),

dec_lo.unsqueeze(0) * dec_hi.unsqueeze(1),

dec_hi.unsqueeze(0) * dec_lo.unsqueeze(1),

dec_hi.unsqueeze(0) * dec_hi.unsqueeze(1)], dim=0)

# 重复滤波器以匹配输入通道数

dec_filters = dec_filters[:, None].repeat(in_size, 1, 1, 1)

# 反转小波的重构高通和低通滤波器

rec_hi = torch.tensor(w.rec_hi[::-1], dtype=type).flip(dims=[0])

rec_lo = torch.tensor(w.rec_lo[::-1], dtype=type).flip(dims=[0])

# 创建重构滤波器

rec_filters = torch.stack([rec_lo.unsqueeze(0) * rec_lo.unsqueeze(1),rec_lo.unsqueeze(0) * rec_hi.unsqueeze(1),rec_hi.unsqueeze(0) * rec_lo.unsqueeze(1),rec_hi.unsqueeze(0) * rec_hi.unsqueeze(1)], dim=0)

# 重复滤波器以匹配输出通道数

rec_filters = rec_filters[:, None].repeat(out_size, 1, 1, 1)return dec_filters, rec_filters

小波变换

def wavelet_transform(x, filters):

b, c, h, w = x.shape # 获取输入的形状

pad = (filters.shape[2] // 2 - 1, filters.shape[3] // 2 - 1) # 计算填充

# 使用小波滤波器进行卷积

x = F.conv2d(x, filters.to(x.dtype).to(x.device), stride=2, groups=c, padding=pad)

x = x.reshape(b, c, 4, h // 2, w // 2) # 重新调整形状

return x

反小波变换

def inverse_wavelet_transform(x, filters):

b, c, _, h_half, w_half = x.shape # 获取输入的形状

pad = (filters.shape[2] // 2 - 1, filters.shape[3] // 2 - 1) # 计算填充

x = x.reshape(b, c * 4, h_half, w_half) # 重新调整形状

# 使用小波滤波器进行转置卷积

x = F.conv_transpose2d(x, filters.to(x.dtype).to(x.device), stride=2, groups=c, padding=pad)

return x

定义小波变换类

class WaveletTransform(Function):

@staticmethod

def forward(ctx, input, filters):

ctx.filters = filters # 保存滤波器

with torch.no_grad():

x = wavelet_transform(input, filters) # 执行小波变换

return x

@staticmethod

def backward(ctx, grad_output):grad = inverse_wavelet_transform(grad_output, ctx.filters) # 计算反向传播return grad, None

定义卷积层类

class WTConv2d(nn.Module):

def init(self, in_channels, out_channels, kernel_size=5, stride=1, bias=True, wt_levels=1, wt_type=‘db1’):

super(WTConv2d, self).init()

assert in_channels == out_channels # 输入通道数和输出通道数必须相等self.in_channels = in_channelsself.wt_levels = wt_levelsself.stride = stride# 创建小波滤波器self.wt_filter, self.iwt_filter = create_wavelet_filter(wt_type, in_channels, in_channels, torch.float)self.wt_filter = nn.Parameter(self.wt_filter, requires_grad=False) # 不需要梯度self.iwt_filter = nn.Parameter(self.iwt_filter, requires_grad=False) # 不需要梯度# 基础卷积层self.base_conv = nn.Conv2d(in_channels, in_channels, kernel_size, padding='same', stride=1, groups=in_channels, bias=bias)def forward(self, x):# 执行小波变换和卷积操作x = self.base_conv(x) # 先进行基础卷积# 这里可以添加小波变换的逻辑return x

代码说明:

创建小波滤波器:create_wavelet_filter 函数用于生成小波变换所需的分解和重构滤波器。

小波变换和反小波变换:wavelet_transform 和 inverse_wavelet_transform 函数分别实现小波变换和反小波变换的过程。

小波变换类:WaveletTransform 类定义了小波变换的前向和反向传播方法。

卷积层类:WTConv2d 类是一个自定义的卷积层,结合了小波变换的功能。它在初始化时创建小波滤波器,并在前向传播中执行卷积操作。

以上是代码的核心部分及其详细注释,涵盖了小波变换的实现和卷积层的设计。

这个程序文件 wtconv2d.py 实现了一个基于小波变换的二维卷积层,主要用于深度学习中的图像处理任务。程序使用了 PyTorch 框架,并结合了小波变换的概念,以增强卷积操作的特性。

首先,程序导入了必要的库,包括 PyTorch 的核心模块和小波变换库 pywt。接着,定义了一个创建小波滤波器的函数 create_wavelet_filter,该函数根据指定的小波类型生成离散小波变换(DWT)和逆离散小波变换(IDWT)的滤波器。这些滤波器用于对输入数据进行小波变换和逆变换。

wavelet_transform 和 inverse_wavelet_transform 函数分别实现了小波变换和逆变换的具体操作。它们通过使用卷积操作来实现,利用小波滤波器对输入数据进行处理,并在必要时进行填充以保持数据的形状。

接下来,定义了两个类 WaveletTransform 和 InverseWaveletTransform,它们继承自 torch.autograd.Function,用于实现小波变换和逆变换的前向和反向传播。这使得小波变换可以在训练过程中自动计算梯度。

wavelet_transform_init 和 inverse_wavelet_transform_init 函数用于初始化小波变换和逆变换的应用函数,方便在后续的卷积层中调用。

WTConv2d 类是这个程序的核心部分,继承自 nn.Module。在初始化方法中,首先检查输入和输出通道数是否相等。然后,创建小波滤波器并将其设置为不可训练的参数。接着,定义了基本的卷积层和小波卷积层,后者用于处理小波变换后的数据。

在 forward 方法中,输入数据经过小波变换处理后,进行多层卷积操作,随后再通过逆小波变换恢复数据。最终,经过一个基础卷积层和缩放模块的处理,返回输出结果。

最后,_ScaleModule 类定义了一个简单的缩放模块,用于对输入进行缩放操作,其权重可以初始化为指定的值。

整体而言,这个程序实现了一个结合小波变换的卷积层,旨在通过小波分析增强卷积神经网络在图像处理任务中的表现。通过使用小波变换,可以更好地捕捉图像中的多尺度特征,提升模型的性能。

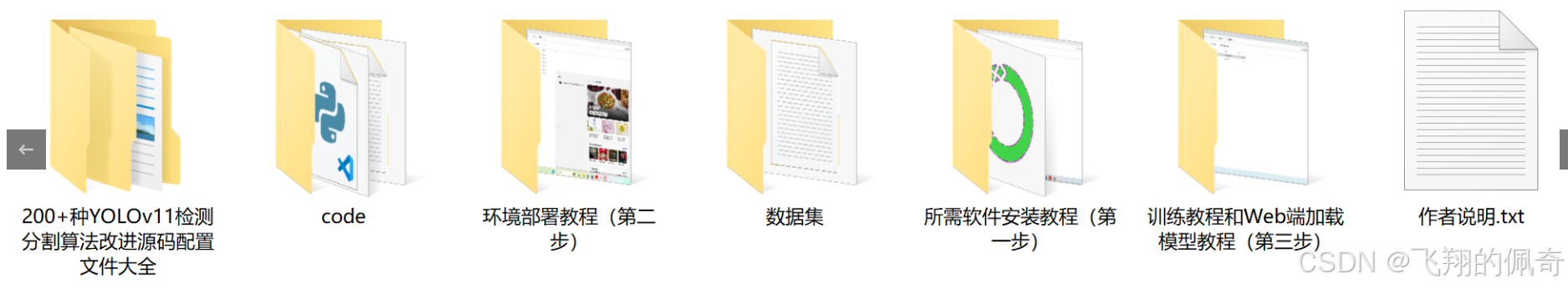

源码文件

源码获取

欢迎大家点赞、收藏、关注、评论啦 、查看👇🏻获取联系方式