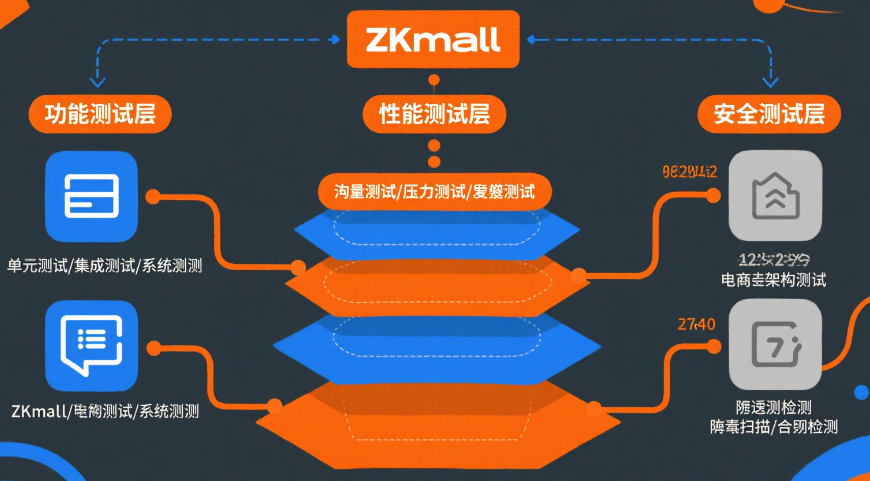

电商架构测试体系:ZKmall开源商城筑牢高并发场景下的系统防线

在电商系统的生命周期里,架构测试就像一把精密的尺子,时刻丈量着系统的稳定性与性能边界。ZKmall 开源商城打造的 "全链路压力测试 + 多维度监控 + 智能预警" 体系,不是简单的工具堆砌,而是一套能自我进化的质量保障机制。它不仅能在双 11、618 等流量洪峰中为系统保驾护航,更能在日常运营中持续挖掘优化空间,让每一次用户点击都获得流畅体验。

压力测试:在流量风暴中寻找系统的 "承压临界点"

压力测试不是为了 "搞垮系统",而是要在可控环境下找到系统的性能拐点。ZKmall 通过三层递进的测试策略,像剥洋葱一样逐层暴露潜在风险。

从接口到系统的分层测试逻辑

接口层测试:把每个核心 API 当成独立个体 "严刑拷打"。就拿商品列表接口来说,我们用测试工具模拟从 100 到 10000 的并发用户梯度冲击,观察响应时间的变化曲线。最终发现 5000 并发是个关键节点,超过这个数值后响应时间会出现跳跃式增长 —— 这就是我们设定的安全阈值。

业务层测试:还原用户真实操作路径。比如模拟 "浏览商品→对比参数→加入购物车→填写地址→提交订单" 的完整流程,就像让一群虚拟用户在系统里 "逛街下单"。测试中发现,当下单用户超过 3000 人时,整个流程的响应速度会从 150ms 骤增至 500ms,这说明订单系统的某个环节成了瓶颈。

系统层测试:在克隆生产环境的 "镜像空间" 里搞 "极限挑战"。我们曾用 10 倍日常流量模拟双 11 场景,看着监控大屏上数据库连接数、缓存命中率、消息队列堆积量的实时跳动,就像在观测一场 "数字风暴"。这种测试能发现各组件协同工作时的隐藏问题 —— 比如某次测试中,Redis 看似正常,却因内存碎片率过高导致整个支付链路延迟。

测试工具的 "组合拳" 打法

不同的测试场景需要不同的工具 "利器":

用 JMeter 做单接口的 "精准打击",适合验证缓存策略调整后的效果。比如修改商品详情页的缓存过期时间后,我们能快速测出响应时间的变化。

用 Gatling 构建复杂业务场景的 "连续攻击",它生成的实时报表能直观展示下单流程中哪个步骤开始 "掉链子"。

用 Locust 搞 "人海战术",模拟 10 万用户同时涌入首页的场景,这种分布式压测能真实反映 CDN 和负载均衡的抗压能力。

最 "狠" 的是 Chaos Monkey,它会随机 "杀死" 某个 Redis 节点或故意制造网络延迟,看看系统的容错机制是否真的管用。有次测试中,它意外暴露了支付系统在主从切换时的 3 秒空档期,这个隐患后来在大促前被彻底解决。

性能指标背后的用户体验逻辑

我们设定的每一个指标阈值,都对应着用户的真实感受:

商品列表页 P95 响应时间≤100ms,是因为超过这个数值,用户就会感觉到 "卡顿"。

下单流程≤300ms,是考虑到用户支付时的焦急心理 —— 谁愿意在付款时等半天呢?

错误率控制在 0.1% 以内,意味着 1000 个用户里最多只有 1 个会遇到问题,这种概率不会引发群体性投诉。

这些数字不是拍脑袋定的,而是分析了上万条用户行为数据后得出的 —— 当商品详情页加载超过 150ms,用户的跳出率会上升 20%;支付流程每延迟 100ms,转化率就会下降 1%。

中间件监控:给系统装上 "神经感知网络"

如果说压力测试是 "体检",那日常监控就是 "健康监测"。ZKmall 的监控体系就像给系统装上了无数个 "传感器",能实时捕捉微小的异常信号。

监控体系的 "四维架构"

这套体系从数据产生到问题解决形成完整闭环:

数据采集层就像 "神经末梢",深入到 MySQL 的连接池、Redis 的内存块、RabbitMQ 的队列里,把零散的指标汇聚起来。

数据存储层用不同 "容器" 装不同类型的数据:时序数据库存性能指标,像 CPU 使用率的 24 小时曲线;Elasticsearch 存日志,方便追溯某个错误的来龙去脉;链路追踪数据则像 "数字足迹",记录请求在各服务间的旅行轨迹。

数据展示层把枯燥的数字变成直观的 "仪表盘":Grafana 的折线图能看出 Redis 内存使用的增长趋势,Kibana 的热力图能定位哪个时段错误日志激增。

告警通知层像个 "智能哨兵",但它不会乱报警 —— 设置了多级阈值,比如 CPU 使用率超过 70% 发预警,85% 才发紧急告警。曾有个深夜,系统通过钉钉推送了一条 "订单队列堆积 5000 条" 的消息,运维人员及时处理,避免了第二天的配送延迟。

核心中间件的 "专属监护方案"

每个中间件都有自己的 "体检表":

MySQL 监控不仅看 QPS/TPS,更关注慢查询和死锁。有次发现每天 10 点会出现一批慢查询,追溯后发现是运营人员导出报表的 SQL 没加索引。

Redis 监控的 "三大杀手" 是内存使用率、命中率和主从同步延迟。我们曾因忽略内存碎片率,导致明明内存还有余量,却频繁触发淘汰机制。

RabbitMQ 最关键的是消息堆积量和消费速率的 "剪刀差"。有次大促前,发现订单队列的消费速率突然下降 30%,排查后才知道是某个消费者实例的 JVM 参数配置有误。

Elasticsearch 的 "命门" 是集群状态和 JVM 堆内存。某次商品搜索变慢,原来是分片分布不均,把热点数据都挤到了某几个节点上。

这些监控不是摆设,而是能直接指导优化 —— 比如看到 Redis 命中率低于 90%,就知道该调整缓存策略了;发现数据库连接池经常满负荷,就得分析是不是有长事务没优化。

实战:双 11 前的 "排雷" 行动

去年某电商平台用 ZKmall 架构备战双 11 的经历,堪称架构测试的经典案例。

压力测试揪出的 "隐形杀手"

测试中发现,商品详情页在 5000 并发下慢得像 "蜗牛":

链路追踪显示,80% 的时间都耗在数据库查询上。原来新上的 "猜你喜欢" 模块没有做缓存,每刷新一次就查一次库。

优化方案很直接:把商品基础信息放 Redis,热门商品再做本地缓存,同时给 SQL 加了联合索引。改完后响应时间从 500ms 压到 80ms,相当于给数据查询 "开了高速路"。

更惊险的是下单接口的问题:

3000 并发下错误率飙到 5%,监控面板上数据库连接池的曲线像根 "直线"—— 早就满了。

解决办法是 "开源节流":连接池从 100 扩到 200,把日志、统计这些非核心操作丢给消息队列异步处理。最后错误率降到 0.1%,响应时间稳定在 200ms,相当于给下单流程 "拓宽了车道"。

中间件监控发现的 "定时炸弹"

Redis 集群的内存使用率冲到 90%,差点 "爆仓":

查监控日志才发现,有批过期的商品缓存没清理,像 "占着茅坑不拉屎" 的僵尸数据。

我们缩短了缓存过期时间,启用内存淘汰机制,还写了定时任务清理过期键。内存使用率最后稳定在 70%,相当于给 Redis"清出了储物空间"。

RabbitMQ 的订单队列堆了 1 万多条消息,像个 "堰塞湖":

原来是消费者数量不够,生产速率是消费的 2 倍。

加了 10 个消费者实例,优化了处理逻辑,还让重要订单 "插队"。最后消息堆积清零,处理延迟从 5 分钟缩到 1 分钟,相当于给消息队列 "开了泄洪道"。

大促当天的 "数字指挥室"

双 11 当天,整个技术团队守在监控大屏前:

凌晨 0 点,流量峰值如期而至,商品查询 QPS 突破 5 万,是日常的 10 倍。但因为提前做了 CDN 预热和缓存扩容,响应时间始终稳定在 80ms。

上午 10 点,支付接口突然出现波动,监控显示某台数据库从库延迟 1000ms。运维按预案切换了读节点,3 分钟后恢复正常。

下午 3 点,Redis 集群有个节点 CPU 飙升,自动触发了故障转移,整个过程用户毫无感知。

最终,这个平台当天处理了 120 万订单,零故障扛过了流量峰值。事后复盘时发现,架构测试中发现的 17 个问题,每解决一个都直接提升了系统的稳定性。

让架构测试成为 "日常习惯"

ZKmall 的架构测试体系告诉我们:好的电商系统不是 "测" 出来的,而是 "养" 出来的。

压力测试不能只在大促前做,而要融入迭代流程 —— 每次发版前,都用自动化脚本跑一遍核心场景,就像给系统做 "常规体检"。中间件监控也不能只靠运维盯着,而要让开发人员也能看到自己写的代码对系统的影响。

更重要的是建立 "测试 - 优化 - 反馈" 的闭环:某次压力测试发现的缓存问题,可能会催生出更好的缓存策略;监控中频繁出现的慢查询,会推动 ORM 框架的优化。这种持续改进,才是架构测试的真正价值。

说到底,技术指标的背后是用户体验,系统稳定性的背后是商业价值。当架构测试能像呼吸一样自然融入开发节奏,电商系统才能真正做到 "用户无感,业务有保障"。