(Arxiv-2025)Phantom:通过跨模态对齐实现主体一致性视频生成

Phantom:通过跨模态对齐实现主体一致性视频生成

paper是字节发布在Arxiv2025的工作

paper title:Phantom: Subject-Consistent Video Generation via Cross-Modal Alignment

Code:地址

Abstract

随着视频生成基础模型的不断发展,其应用正逐步扩展至多个方向,而主体一致性视频生成仍处于探索阶段。我们将其称为“Subject-to-Video”,即从参考图像中提取主体元素,并根据文本指令生成主体一致的视频。我们认为,Subject-to-Video 的本质在于平衡文本与图像这两种模态的提示信息,从而实现对文本与视觉内容的深入且同步的对齐。为此,我们提出了 Phantom,一个统一的视频生成框架,支持单主体和多主体参考。在现有的文本生成视频和图像生成视频架构基础上,我们重新设计了联合文本-图像注入模型,并通过文本-图像-视频三元组数据驱动其学习跨模态对齐能力。该方法实现了高保真度的主体一致性视频生成,同时有效解决了图像内容泄漏和多主体混淆等问题。评估结果表明,我们的方法在性能上优于其他最先进的闭源商业解决方案。尤其在人体生成任务中,我们强调主体一致性,涵盖现有的身份保持类视频生成方法,并提供更显著的优势。

1. Introduction

扩散模型的兴起 [18, 38] 正以前所未有的速度迅速重塑生成建模领域。其中,扩散模型在视频生成方面带来的进展尤为显著。在视觉领域中,与图像生成相比,视频生成更需关注多帧之间的连续性与一致性,这带来了额外的挑战。受大语言模型扩展规律 [36, 51, 58] 的启发,视频生成的研究重心正逐步转向探索基础大型模型,类似于Sora [27, 35, 40, 59, 63] 这样的系统,它们已展现出令人期待的视觉效果,并正在为人工智能生成内容(AIGC)开启全新时代。

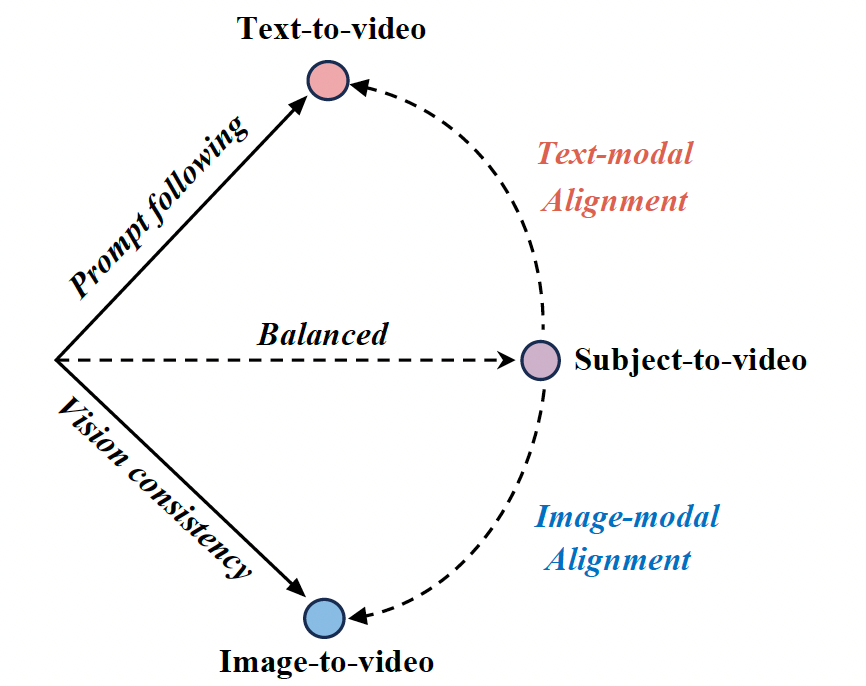

目前,基础性视频生成模型主要聚焦于两大任务:文本生成视频(text-to-video, T2V)[35] 和图像生成视频(image-to-video, I2V)[2]。文本生成视频(T2V)利用语言模型理解输入的文本指令,并生成描述预期人物、动作和背景的视觉内容。尽管该方法支持创造性和富有想象力的内容组合,但由于其本身的随机性,常常难以生成一致性和可预测的结果。另一方面,图像生成视频(I2V)通常以一张图像作为起始帧,并结合可选的文本描述,将静态图像转化为动态视频。尽管控制性更强,但由于起始帧具有严格的“复制-粘贴”特性 [4, 40],内容的丰富性通常受限。我们将主体一致性视频生成过程称为“Subject-to-Video”(S2V)[4, 23, 34],它涉及从图像中捕捉主体,并在文本提示的引导下灵活生成视频,结合图像和文本输入的多样性与可控性。如图1所示,其核心在于平衡文本与图像这两种模态的提示信息,要求模型能够同时对齐文本指令与图像内容。

图1. 跨模态视频生成任务之间的关系。

然而,在视频生成任务中对主体一致性的研究仍然落后于图像生成场景。随着文本生成图像(T2I)基础模型的发展成熟 [11, 28],主体生成图像(S2I)也从参数优化方法 [20, 44],演进到基于Adapter的训练方法 [21, 60],再到统一图像编辑方法 [5, 15, 57],并取得了令人瞩目的成果(见第2.2节)。最直接实现S2V的方法是将S2I与I2V相结合,但这存在两个主要局限。首先,相较于S2V,S2I在学习主体一致性方面更为困难,因为S2V的训练数据天然包含多视角与动态变化,使模型能更好地理解主体。其次,从S2I过渡到I2V可能导致信息丢失。例如,在生成由背面转向正面的运动时,起始帧可能缺乏主体的身份信息,从而导致I2V无法保持身份一致性(详见补充材料)。因此,主体一致性的视频生成需要一个专门的视频模型进行统一处理。

具体而言,主体一致性视频生成任务的目标是深入且同步地对齐文本和图像中描述的内容。为实现这一目标,我们为S2V任务提出了一条数据处理管线,以生成文本-图像-视频三元组形式的训练数据。该任务需要解决两个关键问题。首先,防止图像内容泄露到生成的视频中。一些方法 [4, 16, 23, 29, 61] 从视频中采样关键帧作为图像条件来重建视频,但这种做法可能使模型直接复制粘贴图像内容,降低了对文本指令的响应能力。尽管部分方法尝试通过图像变换来增强数据 [4],但这些方法仍无法有效处理图像的刚性属性与整体光照问题。为此,我们专注于构建跨视频的多主体配对数据,以确保主体在保持内容匹配的同时,呈现出非刚性形变与颜色变化。第二,解决多主体生成过程中的混淆问题。具体来说,当相似主体触发相同的文本描述时,可能导致内容歧义。为解决此问题,我们强调对视频中各个主体外观的明确描述。多个主体的外观应具有可区分性,并能精确匹配所采样参考图像的内容。此外,我们还构建了一个重述模块(rephraser),用于将用户输入的文本提示改写为包含图像内容的详细描述。

我们的模型设计基于两个主要考虑因素:(1) 如何简单且高效地扩展一个视频基础模型以支持S2V能力; (2) 如何实现统一的单主体与多主体一致性生成框架。因此,我们在预训练的T2V与I2V模型 [30] 基础上重新设计了图像-文本联合注入模型,以确保有效的跨模态学习。具体而言,我们的方法构建于MMDiT架构 [11] 之上。参考 [54],我们将全自注意力机制替换为窗口注意力,以降低计算开销。我们使用VAE [10] 和CLIP [62] 对参考图像进行编码,编码结果分别注入至MMDiT的视觉分支与文本分支中。VAE编码提供低层次的细节信息,而CLIP编码则提供高层语义信息。此外,我们在注意力计算过程中引入了一种动态信息注入策略,允许在不影响窗口大小与位置编码的前提下插入一个或多个参考图像 [48],从而实现单主体与多主体一致性视频生成的统一模型架构。

此外,对于S2V任务,我们构建了面向人像ID、单主体和多主体的评估数据集,并制定了相应的评估指标。由于部分开源可复现项目 [4, 16, 23, 29, 61] 的性能尚未达到闭源商业解决方案 [26, 34, 39, 40, 53] 的水平,我们主要与商业方法进行对比。

总体而言,我们提出的Phantom具有以下贡献:

概念方面:

(1) 我们首次明确地定义了“Subject-to-Video”(S2V)任务,并阐明其与Text-to-Video(T2V)和Image-to-Video(I2V)之间的关系,如图1所示;

(2) Phantom为S2V任务提供了一条可行路径,聚焦于文本与视觉内容的高质量对齐。

技术方面:

(1) 提出了一条新的数据处理管线,构建跨模态对齐的三元组数据,有效解决了信息泄露(复制-粘贴)与内容混淆(多主体)问题;

(2) Phantom提出了一个统一的框架,用于处理单主体和多主体参考条件下的视频生成,其核心是动态注入多种条件信息的机制。

意义方面:

(1) Phantom展现出卓越的视频生成质量,填补了学术研究与商业闭源系统之间的性能差距;

(2) 所提出的统一一致性生成范式涵盖了如身份生成等子任务,并表现出显著优势,表明Phantom类解决方案在电影工业、广告制作等场景中具有广阔的应用前景。

图2. 使用我们方法生成的主体一致性视频示例,展示了参考图像与对应生成的视频帧(省略了文本提示)。最后三行展示了多主体参考的情况。

2. Related Work

2.1. Video foundation model

扩散算法推动了视频基础模型研究的兴起,在内容创作与智能交互领域产生了深远影响。早期的潜变量扩散模型(LDM)[42] 通常采用U-Net架构 [43],例如开源的Stable Diffusion 1.5 [42]。随后,这些模型加入了时间模块,演变为视频生成模型,如Make-A-Video [47]、SVD [2] 和 Animatediff [13]。在扩展规律的指导下,DiT架构 [38] 推动了更多视觉基础模型的发展。其中,Stable Diffusion 3 引入了MMDiT [11],一种双流式的DiT架构,该架构被应用于多个开源视频生成项目中,如CogvideoX [59]、HunyuanVideo [27] 和 SeedVR [54]。

2.2. Subject-consistency image generation

近年来,图像任务中的主体一致性生成取得了显著进展。基于优化的方法 [12, 19, 20, 44, 45] 通过训练将图像内容与特殊标识符绑定,用于文本生成图像任务。其中一个在训练与推理范式上具有代表性的工作是IP-Adapter [60],该方法在冻结基础模型权重的同时,仅训练额外的适配器模块以实现主体一致性生成。这一方法也被广泛应用于需要面部ID一致性的任务中 [6, 14, 55]。然而,这些方法通常依赖于CLIP [7] 或 DINO [37] 提取图像语义,导致在低层次细节重建与灵活文本响应之间存在权衡。近期的研究进展则将图像生成与编辑任务统一到单一模型中 [5, 15, 33, 57],支持在同一个模型中实现多种编辑任务,包括主体一致性生成。相比于基于适配器的方法,这类方法更深入地学习图像-文本对齐,能够充分发挥基础模型的能力,并解决多适配器带来的性能退化问题。

2.3. Subject-consistency video generation

从近期研究进展来看,视频生成能力与算法创新的发展仍明显滞后于图像任务。类似于图像一致性技术,Kling [26] 提出了一种基于优化的视频生成方法,用于实现面部ID一致性,该方法需上传同一人物的多个视频进行优化,计算成本较高。适配器方法也被尝试应用于视频ID一致性任务,例如IDAnimator [16] 和 ConsisID [61],但这些方法通常仅在小型数据集(约1万条)上进行验证,限制了其在面部信息与文本描述对齐方面的能力。近年来,如ConceptMaster [23]、MovieWeaver [29] 和 VideoAlchemist [4] 等工作展示了在一般场景下生成一致性多主体视频的能力。然而,目前尚无开源方法专门针对S2V任务,而商业软件在S2V方面的能力 [26, 34, 39, 40, 53] 仍处于最先进水平。因此,与闭源商业方案进行性能对比,对于评估所提出方法的优越性至关重要。

3. Phantom

本节介绍Phantom的具体实现。第一小节说明如何构建跨模态对齐训练数据,重点在于创建交叉配对的文本-图像-视频三元组,以解决“复制-粘贴”问题。第二小节介绍Phantom架构的设计与考量,重点在于单主体与多主体特征如何被动态注入到框架中。第三小节则介绍了一些关键的训练设置与推理技巧,以确保S2V能力的高效实现。

3.1. Data Pipeline

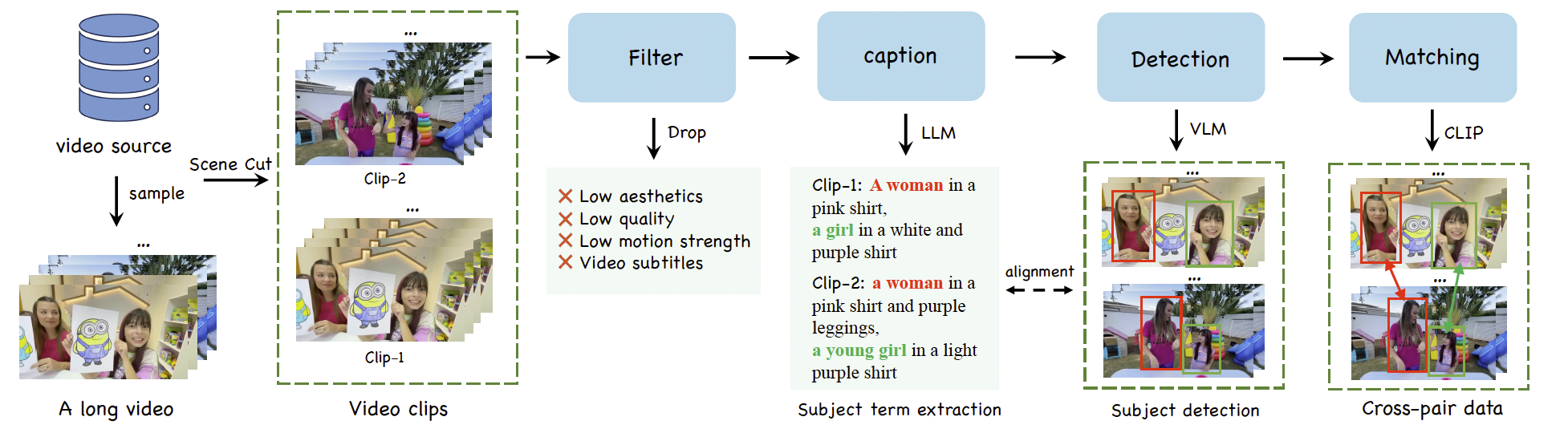

为了实现Subject-to-Video(S2V)生成,我们构建了一个文本-图像-视频的三元组数据结构用于跨模态学习(见图3),确保视频同时与图像和文本进行配对。首先,我们从Panda70M [3] 和内部来源中采样长视频。这些视频通过AutoShot [64] 和 PySceneDetect [50] 被切分为单场景片段,低质量、低美学评分或运动幅度低的片段将被筛除。接着,我们使用Gemini [49] 为筛选后的片段生成文本描述,重点描述主体的外观、行为和场景信息。然后,利用LLM [36] 分析生成的描述文本,提取出包含外观信息的主体词汇,作为提示词输入至VLM [1],以获取参考帧中对应主体的检测框。至此,文本描述中的主体信息与参考图像中检测出的主体元素实现了精确对齐。

尽管图像与文本在语义上对齐,但这些参考图像取自视频中的特定帧,因此这些图像-视频对被称为“in-pair”数据。一些现有方法 [4, 23] 使用in-pair数据训练S2V模型,以确保图像与视频之间的主体一致性。然而,图像与视频之间过高的视觉相似度可能导致模型忽略文本提示,从而生成的视频简单地复制粘贴输入图像。为了解决该问题,我们进一步构建跨视频片段的配对数据。我们使用改进的CLIP架构中的图像嵌入器 [46] 对不同视频中检测到的主体进行打分和配对,并剔除得分过高(意味着容易复制粘贴)或过低(意味着主体不一致)的样本。

在构建完跨配对数据管线后,我们还需根据应用场景对数据进行进一步细分。主要元素包括人物、动物、物体、背景等。此外,元素间的交互也可进一步细分场景,如多人互动、人宠互动、人机互动等。通过按应用场景细分数据源,我们可以定量补充缺失的数据类型。例如,虚拟试衣应用需要特定的模特图像与服装布局数据。最终,我们获得了约一百万规模的跨配对数据,其中包含人物主体的数据占据最大比例。此外,我们还添加了一部分图像配对数据以提升多样性,数据来源包括Subject200k [5] 和 OmniGen [57]。

图3. 跨模态视频生成的数据处理流程。该流程包括筛选、添加文本描述、检测和匹配等阶段,从视频片段中提取主体并与文本提示进行对齐,以确保主体一致的视频生成。

3.2. Framework

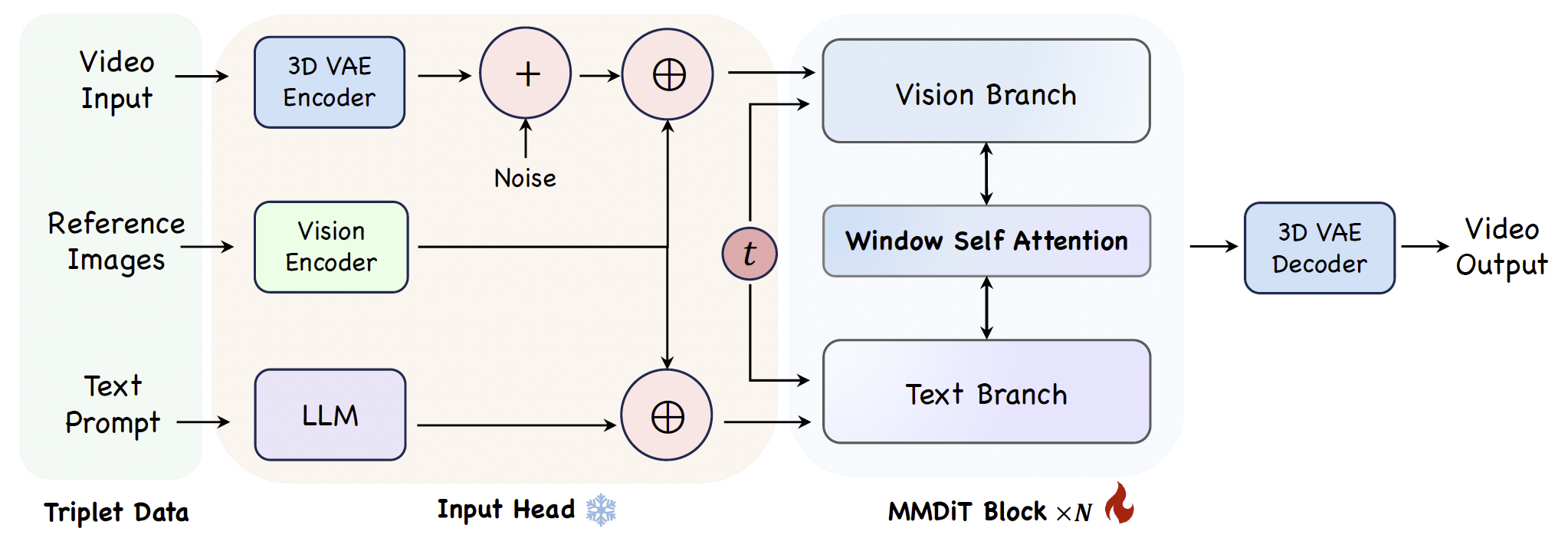

图4. Phantom架构概览。三元组数据在输入头部被编码为潜在空间表示,经过组合后,通过改进的MMDiT模块进行处理,以学习不同模态之间的对齐关系。

Phantom 架构如图4所示,由一个未训练的输入头部和一个训练好的MMDiT模块组成。输入头包含一个3D VAE [59] 编码器和一个继承自视频基础模型的LLM [58],分别用于编码输入视频和文本。视觉编码器关键地包含变分自编码器(VAE)[10] 和 CLIP [41, 62]。图像特征 Fref.v\mathbf{F}_{\text{ref.v}}Fref.v 与视频潜变量 Fvid\mathbf{F}_{\text{vid}}Fvid 拼接,复用3D VAE以保持视觉分支输入的一致性。同时,图像的CLIP特征 Fref.c\mathbf{F}_{\text{ref.c}}Fref.c 与文本特征 Ftext\mathbf{F}_{\text{text}}Ftext 拼接,提供高级语义信息,用于补偿来自VAE的低层次特征。特征融合过程涉及维度对齐,具体如下:

FTl1+l2,c=Ftextl1,c⊕Fref.cl2,c(1)\mathbf{F}_T^{l_1 + l_2, c} = \mathbf{F}_{\text{text}}^{l_1, c} \oplus \mathbf{F}_{\text{ref.c}}^{l_2, c} \tag{1} FTl1+l2,c=Ftextl1,c⊕Fref.cl2,c(1)

FVt+n,h,w,c=Fvidt,h,w,c⊕Fref.vn,h,w,c(2)\mathbf{F}_V^{t+n, h, w, c} = \mathbf{F}_{\text{vid}}^{t, h, w, c} \oplus \mathbf{F}_{\text{ref.v}}^{n, h, w, c} \tag{2} FVt+n,h,w,c=Fvidt,h,w,c⊕Fref.vn,h,w,c(2)

其中,⊕\oplus⊕ 表示拼接操作。拼接后的特征 FT\mathbf{F}_TFT 和 FV\mathbf{F}_VFV 被输入到MMDiT的文本与视觉分支中,模型仅在注意力计算阶段对注入的特征进行分离处理。

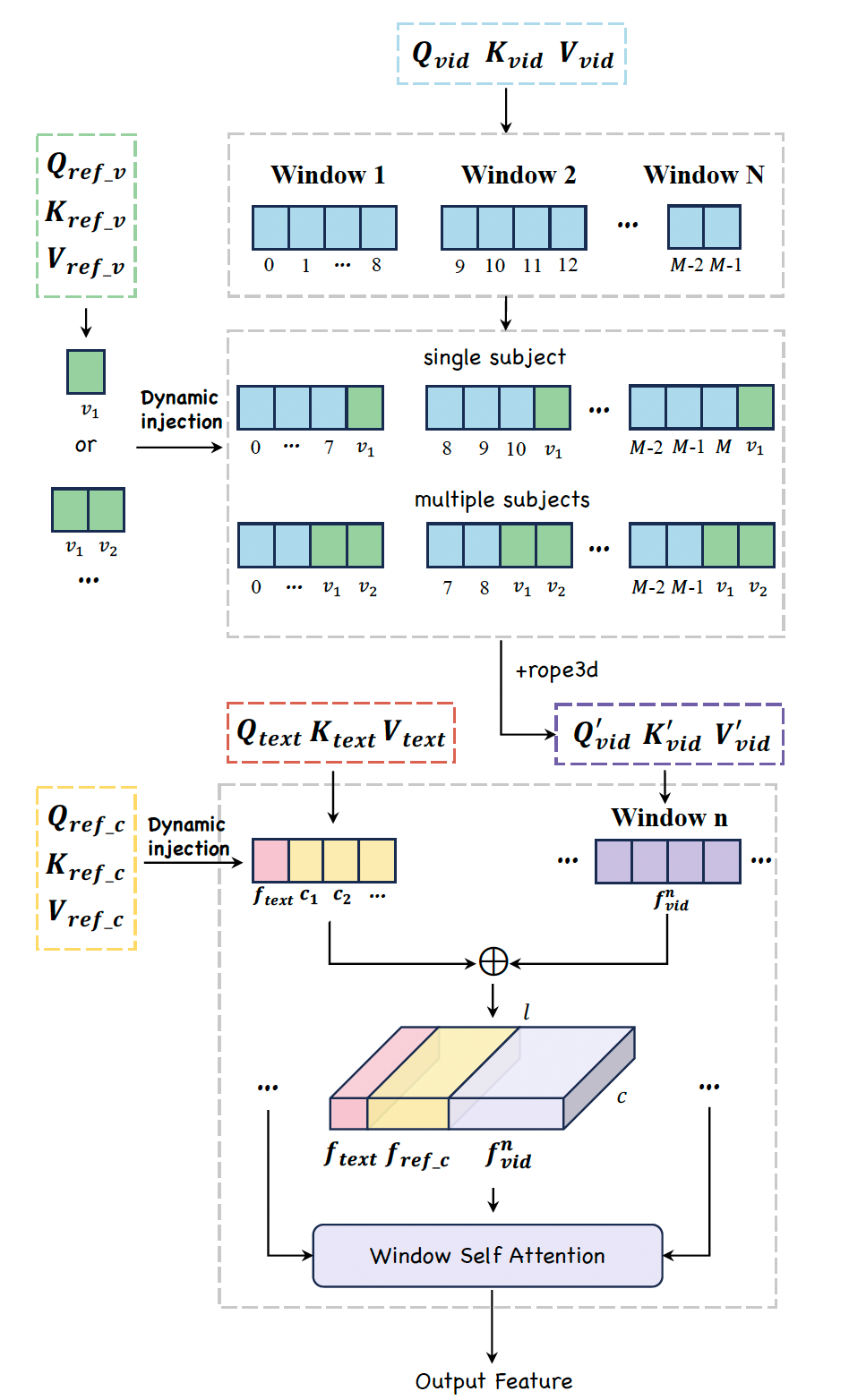

具体而言,MMDiT模块基于 [30, 54] 构建,并针对参考图像输入进行了改进,主要修改了Attention模块 [52],如图5所示。首先,从 Fvid\mathbf{F}_{\text{vid}}Fvid 计算得到的 Qvid\mathbf{Q}_{\text{vid}}Qvid、Kvid\mathbf{K}_{\text{vid}}Kvid、Vvid\mathbf{V}_{\text{vid}}Vvid 特征被划分为大小为9的窗口。然后,从 Fref.v\mathbf{F}_{\text{ref.v}}Fref.v 计算得到的 Qref.v\mathbf{Q}_{\text{ref.v}}Qref.v、Kref.v\mathbf{K}_{\text{ref.v}}Kref.v、Vref.v\mathbf{V}_{\text{ref.v}}Vref.v 特征被动态拼接到每个窗口的末尾,而原有窗口内的特征则依次移至下一个窗口的开头。该方法在保持窗口结构的同时,确保了每个窗口内视频特征与主体特征之间的交互,并支持单主体或多主体输入的自适应处理。与此同时,从 Ftext\mathbf{F}_{\text{text}}Ftext 计算得到的 Qtext\mathbf{Q}_{\text{text}}Qtext、Ktext\mathbf{K}_{\text{text}}Ktext、Vtext\mathbf{V}_{\text{text}}Vtext 特征与从 Fref.c\mathbf{F}_{\text{ref.c}}Fref.c 计算得到的 Qref.c\mathbf{Q}_{\text{ref.c}}Qref.c、Kref.c\mathbf{K}_{\text{ref.c}}Kref.c、Vref.c\mathbf{V}_{\text{ref.c}}Vref.c 特征也被动态拼接。在收集完所有参考信息后,在每个窗口内计算自注意力。然后,将动态注入的参考图像特征(包括ref.v与ref.c)与文本特征从输出特征中提取出来,并在每个窗口内进行平均处理。该过程确保当前模块中的输入与输出特征维度保持一致,从而有助于后续模块的计算。

图5. 每个MMDiT模块中针对单个或多个参考主体的动态注入策略与注意力计算方法。

3.3. Training and inference

训练设置。我们采用整流流(Rectified Flow,RF)[31, 32] 来构建训练目标并调整噪声分布采样 [11]。RF 旨在学习一个合适的流场,使模型能够从噪声中高效且高质量地生成有意义的数据样本。在训练的正向过程中,向干净数据 x0x_0x0 添加噪声以生成 xt=(1−t)⋅x0+t⋅ϵx_t = (1 - t) \cdot x_0 + t \cdot \epsilonxt=(1−t)⋅x0+t⋅ϵ,其中 ϵ\epsilonϵ 是服从 N(0,I)\mathcal{N}(0, \mathbf{I})N(0,I) 分布的高斯噪声,ttt 是在总步数 T=1000T=1000T=1000 内缩放到 [0,1][0, 1][0,1] 区间的随机采样步数。模型预测速度 vtv_tvt 来回归速度 ut=dxt/dtu_t = dx_t/dtut=dxt/dt,vtv_tvt 表示为:

vt=Gθ(xt,t,FT,FV)(3)v_t = \mathcal{G}_\theta(x_t, t, \mathbf{F}_T, \mathbf{F}_V) \tag{3} vt=Gθ(xt,t,FT,FV)(3)

因此,RF 的训练损失定义为:

Lmse=∥vt−ut∥2(4)\mathcal{L}_{\text{mse}} = \|v_t - u_t\|^2 \tag{4} Lmse=∥vt−ut∥2(4)

值得注意的是,vtv_tvt 包含在尾部的附加 nnn 维特征(参见公式 (2)),这些特征不会参与损失计算。模型训练分两个阶段进行:第一阶段在 256p/480p 分辨率下进行了 50k 次迭代;第二阶段引入混合的 720p 数据,继续训练 20k 次以增强高分辨率生成能力。此外,由于 VAE 的训练目标之一是像素级重建,当与 VAE 特征一起训练时,CLIP 特征可能会被掩盖。因此,我们在训练过程中为 VAE 设置了较高的 dropout 比率(0.7)以实现平衡。总的训练计算资源约为 30,000 GPU 小时(使用 A100)。

推理设置。Phantom 在推理时可接受 1 到 4 张参考图像,并根据给定文本提示生成相应视频。需要注意的是,使用更多参考图像可能导致不稳定的结果。为与训练数据对齐,推理使用的文本提示必须首先由重述器(rephraser)调整,以准确描述每个参考主体的外观和行为,避免相似主体之间的混淆(参见补充材料)。在采样过程中使用 Euler 方法,步数为 50,并通过 classifier-free guidance [17] 实现图像与文本条件的解耦。每一步的去噪输出如下所示:

xt−1=xt−1◯+ω1(xt−1I−xt−1◯)+ω2(xt−1TI−xt−1I)(5)x_{t-1} = x_{t-1}^{\bigcirc} + \omega_1 (x_{t-1}^I - x_{t-1}^{\bigcirc}) + \omega_2 (x_{t-1}^{TI} - x_{t-1}^I) \tag{5} xt−1=xt−1◯+ω1(xt−1I−xt−1◯)+ω2(xt−1TI−xt−1I)(5)

其中,xt−1◯x_{t-1}^{\bigcirc}xt−1◯ 是无条件去噪输出,xt−1Ix_{t-1}^Ixt−1I 是基于图像条件的去噪输出,xt−1TIx_{t-1}^{TI}xt−1TI 是基于图文联合条件的去噪输出。权重 ω1\omega_1ω1 和 ω2\omega_2ω2 分别设为 3 和 7.5。