【扩散模型专栏】01 扩散模型入门:概念与背景

摘要

扩散模型作为生成式人工智能领域的一项革命性技术,已经从学术研究的前沿走向了工业应用的核心。这一技术范式通过模拟自然界中的扩散过程,实现了从噪声到数据的逆向重构,为图像生成、视频合成、音频处理等多个领域带来了前所未有的突破。本文将从扩散模型的基本概念出发,深入剖析其理论基础、历史发展脉络以及广泛的应用场景,为读者提供一个全面而深入的技术视角。

关键词:扩散模型,生成式模型,去噪扩散概率模型,评分函数,深度学习

1. 什么是扩散模型?

1.1 扩散模型的基本概念

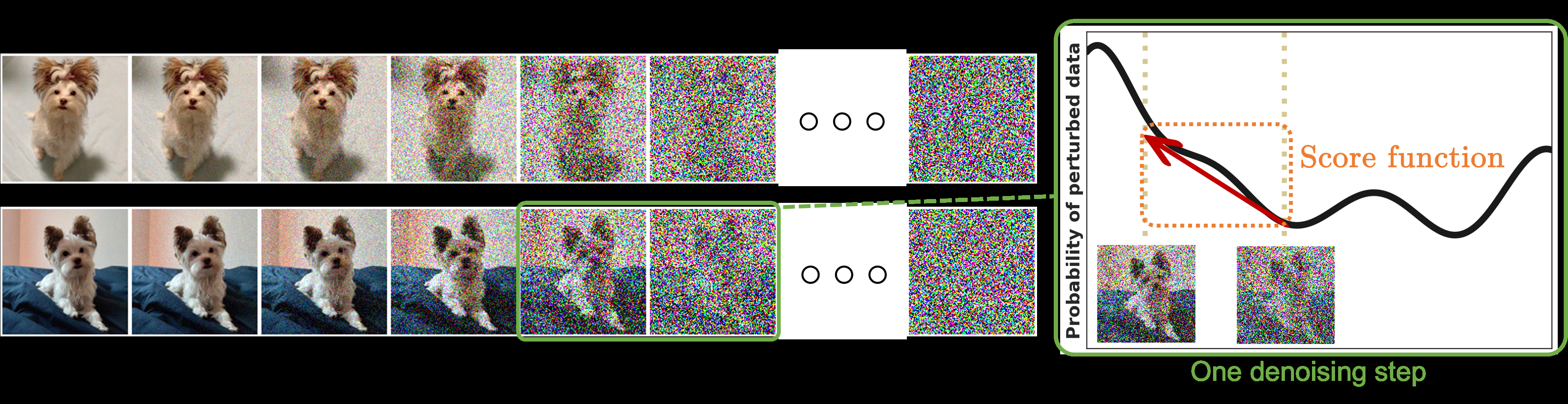

扩散模型,从字面意思理解,就像是模拟物理世界中分子扩散的过程一样,是一种通过逐步添加噪声然后学习逆转这一过程来生成数据的深度学习模型。想象一下,如果我们在一杯清水中滴入一滴墨水,墨水会逐渐扩散直到整杯水变得混浊不清,这个过程是不可逆的。但是,如果我们能够学会这个扩散过程的"倒放",就能从混浊的水中重新得到清澈的水和那滴墨水的原始形状。扩散模型正是基于这种思想,通过学习"逆扩散"过程来从随机噪声中生成有意义的数据。

扩散模型的核心思想可以用数学语言更精确地描述。给定一个数据分布 ,扩散模型首先定义一个前向扩散过程,通过马尔可夫链逐步向数据添加高斯噪声:

其中 是预定义的方差调度序列,$T$ 是扩散步数。经过足够多的步骤后,原始数据会被完全破坏,变成近似于标准高斯分布的噪声。

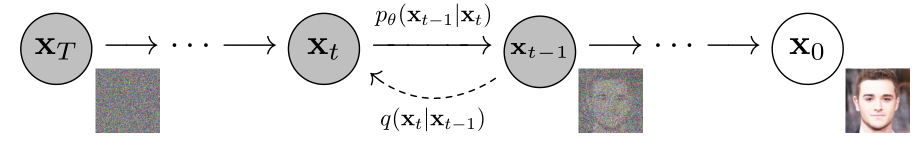

接下来,扩散模型的关键在于学习逆向过程,即从噪声中恢复原始数据。这个逆向过程被建模为:

其中 是神经网络的参数,需要通过训练学习得到。这就像是训练一个"时光倒流机器",让它学会如何从每一个带噪声的状态回到前一个稍微清晰一点的状态,直到最终恢复出原始的清晰数据。

1.2 生成式模型的发展与对比

为了更好地理解扩散模型的独特之处,我们需要将其放在生成式模型发展的历史背景中来审视。生成式模型的核心目标是学习数据的分布,从而能够生成与训练数据相似的新样本。在扩散模型出现之前,主要有三大类生成式模型在各自的领域中占据主导地位。

1.2.1 生成对抗网络(GANs)的兴起与局限

生成对抗网络可以比作一场"造假者与鉴定师"的游戏。在这个游戏中,生成器(造假者)试图创造出逼真的假数据来欺骗判别器(鉴定师),而判别器则努力区分真实数据和生成数据。这种对抗性训练机制使得GANs能够生成极其逼真的图像,在2014年首次提出后就引起了巨大的轰动[1]。

GANs的优势在于其生成速度快,只需要一次前向传播就能生成高质量的样本。然而,GANs也存在一些固有的问题。首先是训练不稳定性,生成器和判别器需要达到一个微妙的平衡,稍有不慎就会导致模式坍塌(mode collapse)或训练发散。其次是模式坍塌问题,即生成器可能只学会生成数据分布中的一小部分,导致生成样本的多样性不足。最后,GANs缺乏明确的目标函数来衡量生成质量,使得训练过程难以监控和调试。

1.2.2 变分自编码器(VAEs)的概率视角

变分自编码器采用了一种更加优雅的概率论方法来处理生成建模问题。如果说GANs是通过"对抗"来学习,那么VAEs就是通过"重构"来学习。VAEs假设数据是由某个潜在变量生成的,通过学习编码器将数据映射到潜在空间,再通过解码器从潜在空间重构数据[2]。

VAEs的数学框架基于变分推断,其目标是最大化数据的边际似然的下界(ELBO):

这个公式的第一项鼓励重构质量,第二项则约束潜在表示接近先验分布。VAEs的优势在于训练稳定,有明确的理论基础,并且能够进行有意义的潜在空间插值。然而,VAEs的主要缺点是生成的样本往往比较模糊,缺乏GANs那样的锐利细节。

1.2.3 流模型(Flow Models)的精确性

流模型采用了一种完全不同的策略,通过一系列可逆变换将简单分布(如高斯分布)转换为复杂的数据分布。这种方法的最大优势是能够精确计算数据的似然,这在其他生成模型中往往是不可能或者需要近似的[3]。

流模型的核心是雅可比行列式的变换公式:

其中 是从潜在变量

到数据

的可逆变换。然而,可逆性的要求限制了模型的架构设计,通常需要复杂的耦合层或者自回归结构,这使得流模型在处理高维数据时效率不高。

表1.1 生成式模型对比分析

| 模型类型 | 训练稳定性 | 生成质量 | 采样速度 | 似然计算 | 多样性 | 主要优势 | 主要缺点 |

|---|---|---|---|---|---|---|---|

| GANs | 差 | 极高 | 快 | 不可用 | 中等 | 高质量生成 | 训练不稳定 |

| VAEs | 好 | 中等 | 快 | 近似 | 好 | 理论基础强 | 生成模糊 |

| Flow Models | 好 | 中等 | 中等 | 精确 | 好 | 精确似然 | 架构受限 |

| Diffusion Models | 好 | 极高 | 慢 | 近似 | 极好 | 稳定高质量 | 采样慢 |

1.2.4 扩散模型的独特优势

扩散模型的出现为生成建模带来了新的视角和解决方案。与上述模型相比,扩散模型具有以下独特优势:

首先,训练稳定性。扩散模型不需要像GANs那样平衡两个网络的对抗训练,而是通过一个统一的去噪目标函数进行训练,大大提高了训练的稳定性。这就像是从"战争"模式转换到了"建设"模式,专注于逐步改善而不是对抗。

其次,生成质量和多样性的平衡。扩散模型在保证高生成质量的同时,能够产生高度多样化的样本。这是因为扩散过程本身就是一个随机过程,每次采样都会产生不同的轨迹,从而生成不同的结果。

再次,理论基础扎实。扩散模型有着深厚的理论基础,包括与非平衡热力学、评分匹配、朗之万动力学等的联系,这为模型的改进和扩展提供了丰富的理论指导[4]。

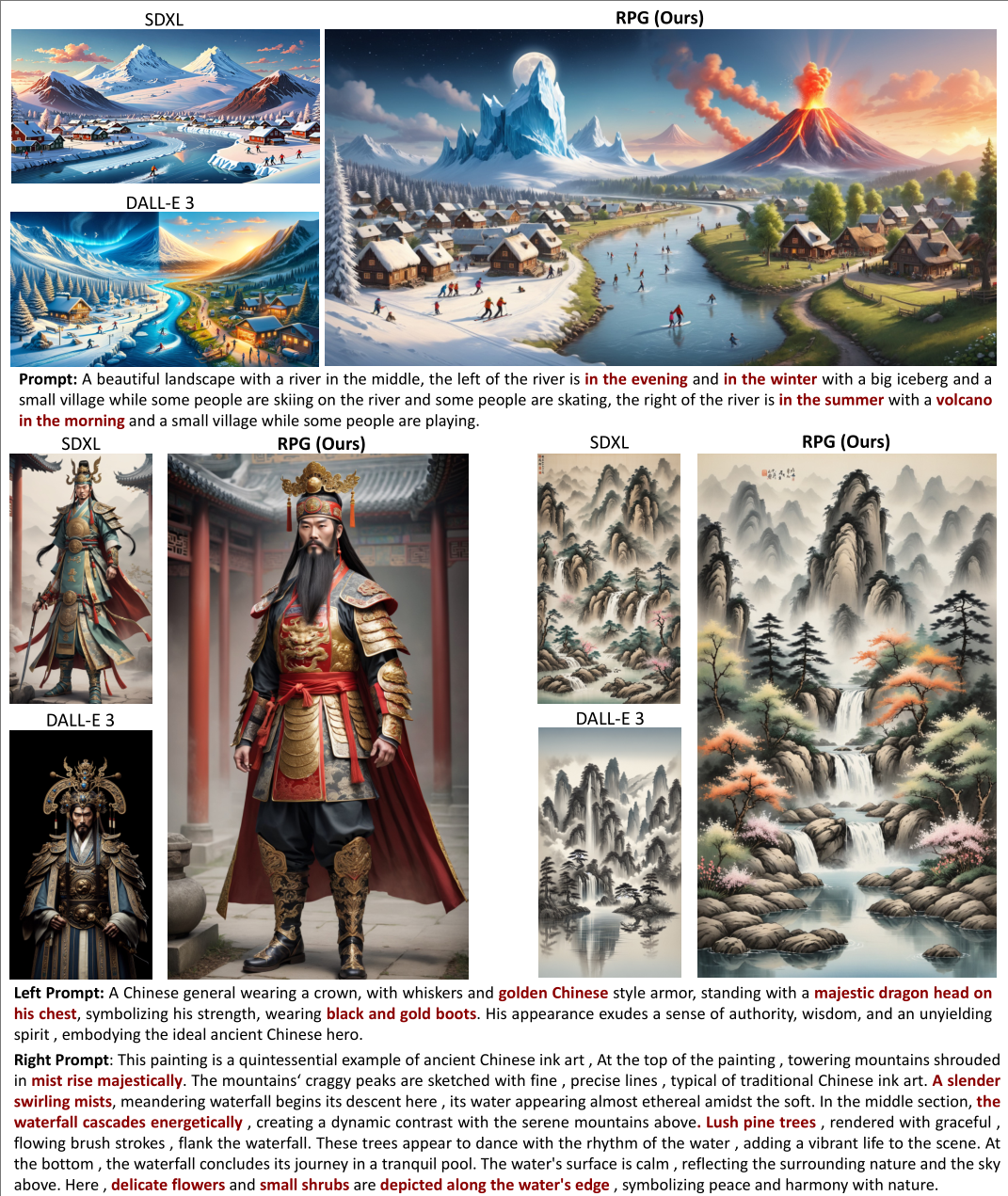

最后,灵活的条件控制。扩散模型可以很容易地进行条件生成,无论是类别条件、文本条件还是其他形式的控制信号,都可以自然地融入到扩散过程中。

1.3 扩散模型的核心思想:渐进去噪与逆向过程

扩散模型的核心思想可以用一个生动的比喻来理解:想象你正在修复一幅被污损的古画。传统的修复方法可能需要艺术家一次性完成整幅画的修复,这需要极高的技艺和对原画的深度理解。而扩散模型采用的是一种"渐进修复"的策略,将整个修复过程分解为数千个微小的步骤,每一步只需要去除一点点污损,逐步恢复画作的原貌。

1.3.1 前向扩散过程的数学描述

前向扩散过程是扩散模型的第一个关键组件,它定义了如何系统地破坏数据。这个过程遵循一个预定义的噪声调度,可以用数学公式精确描述:

其中每一步的转移分布为:

这个过程的巧妙之处在于,通过重参数化技巧,我们可以直接计算从初始数据 到任意时刻

的分布:

其中 ,

。这意味着我们可以在任意时刻直接对数据进行加噪,而不需要逐步进行,这大大提高了训练效率。

1.3.2 逆向过程的学习策略

逆向过程是扩散模型的核心,它需要学习如何从噪声中逐步恢复数据。如果我们知道真实的逆向分布 ,那么生成过程就变得简单了。然而,这个分布通常是不可知的,需要用神经网络来近似。

关键的洞察来自于这样一个事实:当噪声方差 足够小时,逆向过程也可以近似为高斯分布。更进一步,Ho等人在2020年的开创性工作中发现,可以将逆向过程重新参数化为噪声预测问题[5]:

这种重参数化将原本复杂的分布估计问题转化为了相对简单的噪声预测问题。神经网络 的任务就是预测在每个时间步添加的噪声,训练目标变为:

这种重参数化的妙处在于,它将一个看似困难的生成问题转化为了一个监督学习问题:给定带噪声的输入和噪声本身,学习预测噪声。

1.3.3 采样过程的实现

训练完成后,扩散模型的采样过程就是逆向扩散过程的实现。从纯噪声 开始,模型逐步去噪: