多模态大模型

3.1 跨越模态的桥梁:多模态大模型概述

我们的世界是多模态的。人类通过视觉、听觉、嗅觉、味觉和触觉等多种感官来感知和理解世界,并将这些信息进行融合处理。传统的AI模型通常专注于单一模态,例如只处理图像(计算机视觉)或只处理文本(自然语言处理)。然而,为了让AI更接近人类的智能水平,能够更全面、更深入地理解和互动,多模态学习(Multimodal Learning) 应运而生。

多模态大模型(Multimodal Large Language Models, MLLMs) 正是这一领域的最新突破。它们旨在融合不同模态的信息(例如图像与文本、视频与音频等),使模型能够同时处理和理解多种类型的数据。这使得AI能够:

- 更全面的理解: 看到一张图片时,不仅识别出其中的物体,还能理解图片背后的场景、情感,并用语言进行描述。

- 更自然的交互: 通过文本提问图片内容,或用图片引导文本生成。

- 更强大的泛化能力: 从一种模态学到的知识可以迁移到另一种模态,提高模型的鲁棒性和适应性。

- 赋能更多应用: 图像描述、视觉问答、跨模态检索、文生图、图生文、多模态聊天机器人等。

多模态大模型通常以大型语言模型(LLM)为基础,通过引入视觉编码器、多模态对齐层等组件,使其具备处理和理解视觉信息的能力。接下来,我们将探讨几个具有里程碑意义的多模态大模型。

3.2 图像与文本的对齐:CLIP的开创性工作

在多模态大模型领域,OpenAI的CLIP (Contrastive Language-Image Pre-training) 无疑是一个里程碑式的模型。它巧妙地通过对比学习,实现了图像和文本之间高效的跨模态对齐。

核心思想: CLIP通过在海量的“图片-文本对”上进行对比预训练,学习到一种通用的视觉表示,使得图片和其对应的文本描述在共同的嵌入空间中彼此靠近,而与不匹配的文本描述彼此远离。

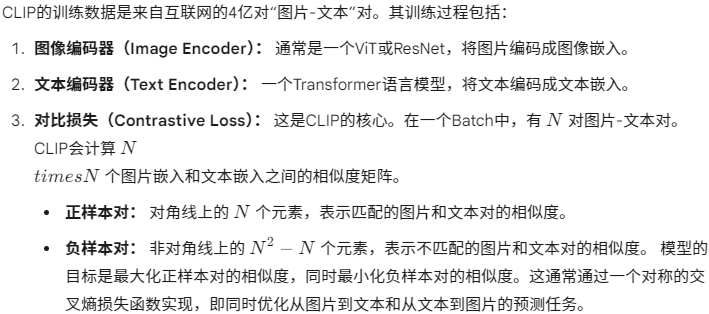

原理详解:

CLIP的创新与优势:

- 零样本(Zero-shot)能力: 预训练后的CLIP模型,无需在下游任务上进行任何微调,就可以执行图像分类、目标检测等任务。例如,要对一张图片进行分类,只需提供类别名称的文本描述(如“一张猫的照片”、“一张狗的照片”),然后计算图片嵌入与这些文本描述嵌入的相似度,选择相似度最高的类别。

- 高效迁移: 学习到的通用视觉表示可以轻松迁移到各种下游任务,即使是少样本(few-shot)学习也能表现出色。

- 统一的跨模态嵌入空间: 使得图像和文本能够在语义上进行比较和检索。

Python示例:使用预训练的CLIP模型进行零样本图像分类

我们将使用Hugging Face transformers库中预训练的CLIP模型来演示其零样本分类能力。

首先,请确保安装Hugging Face transformers和Pillow库:

Bash

pip install transformers torch Pillow

Python

import torch

from PIL import Image

from transformers import CLIPProcessor, CLIPModel

import requests# 1. 加载预训练的CLIP模型和处理器

# `openai/clip-vit-base-patch32` 是一个常用的基础版本

model_name = "openai/clip-vit-base-patch32"

model = CLIPModel.from_pretrained(model_name)

processor = CLIPProcessor.from_pretrained(model_name)# 2. 准备图像

# 可以从URL下载图片,或者使用本地图片路径

# 示例图片:一只猫

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw).convert("RGB")# 3. 准备文本描述(要分类的类别)

# 可以是任何你想要分类的描述

candidate_labels = ["a photo of a cat", "a photo of a dog", "a photo of a bird", "a photo of a car"]# 4. 模型推理

print("\n--- CLIP零样本图像分类示例 ---")

print(f"图像来源: {url}")

print(f"候选类别: {candidate