DAY 38 Dataset和Dataloader类

- Dataset类的__getitem__和__len__方法(本质是python的特殊方法)

- Dataloader类

- minist手写数据集的了解

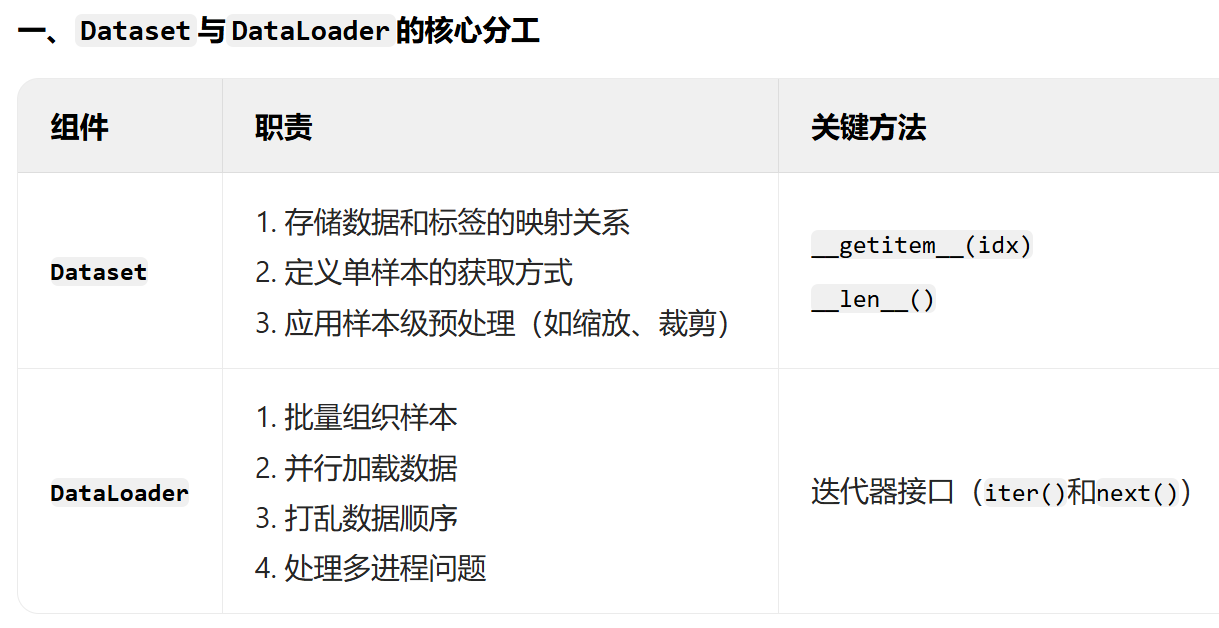

在遇到大规模数据集时,显存常常无法一次性存储所有数据,所以需要使用分批训练的方法。为此,PyTorch提供了DataLoader类,该类可以自动将数据集切分为多个批次batch,并支持多线程加载数据。此外,还存在Dataset类,该类可以定义数据集的读取方式和预处理方式。

1. DataLoader类:决定数据如何加载

2. Dataset类:告诉程序去哪里找数据,如何读取单个样本,以及如何预处理。

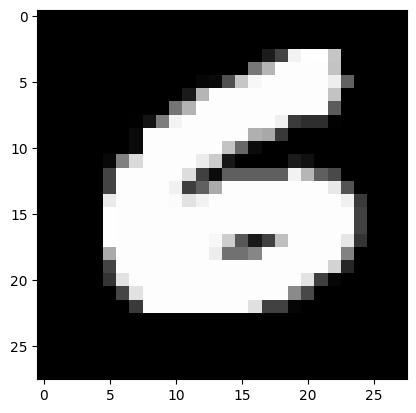

我们介绍MNIST手写数字数据集:该数据集包含60000张训练图片和10000张测试图片,每张图片大小为28*28像素,共包含10个类别。因为每个数据的维度比较小,所以既可以视为结构化数据,用机器学习、MLP训练,也可以视为图像数据,用卷积神经网络训练。

(一)Dataset类的__getitem__和__len__方法

import torch

import torch.nn as nn

import torch.optim as optim

from torch.utils.data import DataLoader , Dataset # DataLoader 是 PyTorch 中用于加载数据的工具

from torchvision import datasets, transforms # torchvision 是一个用于计算机视觉的库,datasets 和 transforms 是其中的模块

import matplotlib.pyplot as plt# 设置随机种子,确保结果可复现

torch.manual_seed(42)torchvision

├── datasets # 视觉数据集(如 MNIST、CIFAR)

├── transforms # 视觉数据预处理(如裁剪、翻转、归一化)

├── models # 预训练模型(如 ResNet、YOLO)

├── utils # 视觉工具函数(如目标检测后处理)

└── io # 图像/视频 IO 操作# 1. 数据预处理,该写法非常类似于管道pipeline

# transforms 模块提供了一系列常用的图像预处理操作# 先归一化,再标准化

transform = transforms.Compose([transforms.ToTensor(), # 转换为张量并归一化到[0,1]transforms.Normalize((0.1307,), (0.3081,)) # MNIST数据集的均值和标准差,这个值很出名,所以直接使用

])

# 2. 加载MNIST数据集,如果没有会自动下载

train_dataset = datasets.MNIST(root='./data',train=True,download=True,transform=transform

)test_dataset = datasets.MNIST(root='./data',train=False,transform=transform

)#在pytorch的思路是,数据在加载阶段就处理结束:

①Dataset类

import matplotlib.pyplot as plt# 随机选择一张图片,可以重复运行,每次都会随机选择

sample_idx = torch.randint(0, len(train_dataset), size=(1,)).item() # 随机选择一张图片的索引

# len(train_dataset) 表示训练集的图片数量;size=(1,)表示返回一个索引;torch.randint() 函数用于生成一个指定范围内的随机数,item() 方法将张量转换为 Python 数字

image, label = train_dataset[sample_idx] # 获取图片和标签#这里很难理解,为什么train_dataset[sample_idx]可以获取到图片和标签?

-是因为 datasets.MNIST这个类继承了torch.utils.data.Dataset类,这个类中有一个方法__getitem__,这个方法会返回一个tuple,tuple中第一个元素是图片,第二个元素是标签。

#PyTorch 的torch.utils.data.Dataset是一个抽象基类,所有自定义数据集都需要继承它并实现两个核心方法:

- __len__():返回数据集的样本总数。

- __getitem__(idx):根据索引idx返回对应样本的数据和标签。

PyTorch 要求所有数据集必须实现__getitem__和__len__,这样才能被DataLoader等工具兼容。这是一种接口约定,类似函数参数的规范。这意味着,如果你要创建一个自定义数据集,你需要实现这两个方法,否则PyTorch将无法识别你的数据集。

②Dataset类的__getitem__方法

__getitem__方法用于让对象支持索引操作,当使用[]语法访问对象元素时,Python 会自动调用该方法。通过定义__getitem__方法,让MyList类的实例能够像 Python 内置的列表一样使用索引获取元素。

# 示例代码

class MyList:def __init__(self):self.data = [10, 20, 30, 40, 50]def __getitem__(self, idx):return self.data[idx]# 创建类的实例

my_list_obj = MyList()

# 此时可以使用索引访问元素,这会自动调用__getitem__方法

print(my_list_obj[2]) # 输出:30③Dataset类的__len__方法

__len__方法用于返回对象中元素的数量,当使用内置函数len()作用于对象时,Python 会自动调用该方法。通过定义的__len__方法,使得MyList类的实例可以像普通列表一样被len()函数调用获取长度。

#示例代码

class MyList:def __init__(self):self.data = [10, 20, 30, 40, 50]def __len__(self):return len(self.data)# 创建类的实例

my_list_obj = MyList()

# 使用len()函数获取元素数量,这会自动调用__len__方法

print(len(my_list_obj)) # 输出:5④总结

- Dataset = 厨师(准备单个菜品)

- DataLoader = 服务员(将菜品按订单组合并上桌)

预处理(如切菜、调味)属于厨师的工作,而非服务员。所以在dataset就需要添加预处理步骤。

# 可视化原始图像(需要反归一化)

def imshow(img):img = img * 0.3081 + 0.1307 # 反标准化npimg = img.numpy()plt.imshow(npimg[0], cmap='gray') # 显示灰度图像plt.show()print(f"Label: {label}")

imshow(image)#反归一化的原因:

在可视化数据时,我们通常希望看到原始数据的真实样貌,而归一化后的数据可能已经失去了原始数据的尺度和范围。因此,需要进行反归一化(Denormalization)操作,将归一化后的数据还原到原始的数据范围,这样才能正确地展示图像。

(二) Dataloader类

# 3. 创建数据加载器

train_loader = DataLoader(train_dataset,batch_size=64, # 每个批次64张图片,一般是2的幂次方,这与GPU的计算效率有关shuffle=True # 随机打乱数据

)test_loader = DataLoader(test_dataset,batch_size=1000 # 每个批次1000张图片# shuffle=False # 测试时不需要打乱数据

)(三)总结

| 维度 | Dataset | DataLoader |

|---|---|---|

| 核心职责 | 定义“数据是什么”和“如何获取单个样本” | 定义“如何批量加载数据”和“加载策略” |

| 核心方法 | __getitem__(获取单个样本)、__len__(样本总数) | 无自定义方法,通过参数控制加载逻辑 |

| 预处理位置 | 在__getitem__中通过transform执行预处理 | 无预处理逻辑,依赖Dataset返回的预处理后数据 |

| 并行处理 | 无(仅单样本处理) | 支持多进程加载(num_workers>0) |

| 典型参数 | root(数据路径)、transform(预处理) | batch_size、shuffle、num_workers |

(四) 作业

作业:了解下cifar数据集,尝试获取其中一张图片

CIFAR数据集全称为Canadian Institute For Advanced Research dataset,主要包含CIFAR-10和CIFAR-100这两个广泛应用于计算机视觉领域的图像数据集,

CIFAR-10数据集

- 数据规模 :包含60000张32x32像素的彩色图像,分为10个不同的类别,每个类别有6000张图像。其中50000张图像作为训练集,10000张图像作为测试集。

- 类别信息 :这10个类别分别是飞机(airplane)、汽车(automobile)、鸟类(bird)、猫(cat)、鹿(deer)、狗(dog)、青蛙(frog)、马(horse)、船(ship)和卡车(truck)。

- 应用场景 :常用于图像分类任务的基准测试,帮助研究人员和开发者评估不同机器学习和深度学习模型在图像分类上的性能。

CIFAR-100数据集

- 数据规模 :同样包含60000张32x32像素的彩色图像,不过它被分为100个不同的类别,每个类别有600张图像。其中50000张图像作为训练集,10000张图像作为测试集。

- 类别信息 :这100个类别又被分为20个超类,每个超类包含5个子类。例如,超类“鱼”可能包含“水族馆的鱼”“比目鱼”“射线”“鲨鱼”和“鳟鱼”等子类。

- 应用场景 :由于类别更加细分,CIFAR-100比CIFAR-10更具挑战性,适合用于评估模型在更复杂图像分类任务中的表现。

import matplotlib.pyplot as plt

import numpy as np

import torch

from torchvision import datasets, transforms# 定义数据预处理(仅转换为Tensor)

transform = transforms.Compose([transforms.ToTensor()

])# 加载CIFAR-10训练集(自动下载)

train_dataset = datasets.CIFAR10(root='./data', # 数据集保存路径train=True, # 加载训练集download=True, # 自动下载transform=transform

)# 定义类别标签(CIFAR-10的10个类别)

classes = ['airplane', 'automobile', 'bird', 'cat', 'deer','dog', 'frog', 'horse', 'ship', 'truck']# 随机选择一个样本

index = torch.randint(0, len(train_dataset), size=(1,)).item()

image, label = train_dataset[index]# 将Tensor转换为numpy数组并调整维度(C,H,W -> H,W,C)

#PyTorch默认返回的图片是(C, H, W)格式,需转换为(H, W, C)才能用matplotlib正确显示

image = image.permute(1, 2, 0).numpy()# 显示图片

plt.figure(figsize=(4, 4))

plt.imshow(image)

plt.title(f'Label: {classes[label]} (Class {label})')

plt.axis('off')

plt.show()输出结果: