Spring Cloud微服务架构设计与实战:从组件落地到分布式事务解决

一、架构选型:为何选择 Spring Cloud 构建企业级微服务?

在分布式系统开发中,技术栈选型直接决定架构的可扩展性与维护成本。以某电商平台(日均订单 10 万 +)的微服务改造为例,对比 Dubbo 与 Spring Cloud 后,最终选择 Spring Cloud 的核心原因有三点:

生态完整性:Spring Cloud 涵盖服务注册发现(Eureka/Nacos)、配置中心(Config/Nacos Config)、熔断降级(Circuit Breaker)、网关(Gateway)等全链路组件,无需像 Dubbo 那样手动整合第三方工具(如 Zookeeper+Sentinel),减少组件兼容性问题;

Java 技术栈契合度:基于 Spring Boot 开发,与 Java 开发者常用的 Spring 生态无缝衔接,降低团队学习成本(原 Spring MVC 开发人员可快速上手);

云原生适配性:支持 Kubernetes 容器化部署,配合 Spring Cloud Alibaba 可实现与阿里云、华为云等公有云服务的快速集成,满足企业 “上云” 需求。

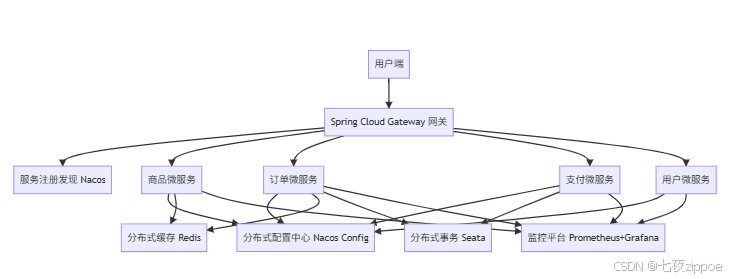

下图为该电商平台的 Spring Cloud 微服务架构图:

图 1:电商平台 Spring Cloud 微服务架构图

二、核心组件落地:从 “理论” 到 “项目实战” 的关键步骤

以 “订单创建” 核心流程(用户下单→库存扣减→支付回调→订单状态更新)为例,拆解 Spring Cloud 核心组件的实际应用,每个环节均结合项目代码示例。

1. 服务注册与发现:Nacos 的实战配置

Nacos 作为 Spring Cloud Alibaba 的核心组件,同时承担服务注册与配置中心功能,解决 “服务地址动态感知” 与 “配置集中管理” 问题。

项目配置步骤:

- 引入依赖(pom.xml):

\<dependency>\<groupId>com.alibaba.cloud\</groupId>\<artifactId>spring-cloud-starter-alibaba-nacos-discovery\</artifactId>\<version>2.2.6.RELEASE\</version>\</dependency>\<dependency>\<groupId>com.alibaba.cloud\</groupId>\<artifactId>spring-cloud-starter-alibaba-nacos-config\</artifactId>\<version>2.2.6.RELEASE\</version>\</dependency>

- 配置 Nacos 地址(bootstrap.yml,优先级高于 application.yml):

spring:application:name: order-service # 服务名,需与Nacos控制台一致cloud:nacos:discovery:server-addr: 192.168.1.100:8848 # Nacos服务地址config:server-addr: 192.168.1.100:8848file-extension: yaml # 配置文件格式group: DEFAULT\_GROUP # 配置分组

- 启动类添加注解:

@SpringBootApplication@EnableDiscoveryClient // 开启服务注册发现public class OrderServiceApplication {public static void main(String\[] args) {SpringApplication.run(OrderServiceApplication.class, args);}}

效果:启动订单微服务后,可在 Nacos 控制台 “服务列表” 中看到 order-service,且支持服务健康检查(默认每 5 秒发送心跳,超过 30 秒未响应则标记为不健康)。

2. 服务调用:OpenFeign 的远程接口调用

在 “订单创建” 流程中,订单微服务需调用商品微服务的 “扣减库存” 接口,通过 OpenFeign 实现声明式远程调用,简化 HTTP 请求代码。

实战代码:

- 订单微服务引入 OpenFeign 依赖:

\<dependency>\<groupId>org.springframework.cloud\</groupId>\<artifactId>spring-cloud-starter-openfeign\</artifactId>\<version>2.2.9.RELEASE\</version>\</dependency>

- 创建 Feign 客户端接口:

@FeignClient(value = "product-service") // 目标服务名public interface ProductFeignClient {// 远程调用商品服务的扣减库存接口@PostMapping("/product/deductStock")ResultDTO\<Boolean> deductStock(@RequestBody StockDeductDTO dto);}

- 订单服务业务层调用:

@Servicepublic class OrderServiceImpl implements OrderService {@Autowiredprivate ProductFeignClient productFeignClient;@Overridepublic ResultDTO\<OrderVO> createOrder(OrderCreateDTO dto) {// 1. 调用商品服务扣减库存StockDeductDTO stockDTO = new StockDeductDTO();stockDTO.setProductId(dto.getProductId());stockDTO.setQuantity(dto.getQuantity());ResultDTO\<Boolean> deductResult = productFeignClient.deductStock(stockDTO);if (!deductResult.isSuccess() || !deductResult.getData()) {return ResultDTO.fail("库存不足");}// 2. 创建订单(省略数据库操作)// 3. 返回订单信息return ResultDTO.success(buildOrderVO(order));}}

注意事项:需在启动类添加@EnableFeignClients注解,且支持超时配置(通过feign.client.config.default.connect-timeout=5000设置连接超时 5 秒)。

3. 分布式事务:Seata 的 TCC 模式实战

订单创建流程中,“扣减库存” 与 “创建订单” 需保证原子性(要么都成功,要么都失败),否则会出现 “库存扣减但订单未创建” 的脏数据。采用 Seata 的 TCC 模式(Try-Confirm-Cancel)解决该问题,适合非关系型数据库或无事务支持的服务场景。

TCC 流程设计:

Try 阶段:订单服务预留订单号,商品服务冻结对应库存(而非直接扣减);

Confirm 阶段:订单创建成功,商品服务确认扣减冻结的库存;

Cancel 阶段:订单创建失败,商品服务解冻冻结的库存。

项目代码实现:

- 商品服务添加 TCC 接口:

// Try接口:冻结库存@TwoPhaseBusinessAction(name = "deductStockTcc", commitMethod = "confirm", rollbackMethod = "cancel")public void deductStockTry(@BusinessActionContextParameter(paramName = "dto") StockDeductDTO dto,BusinessActionContext context) {// 1. 查询商品库存Product product = productMapper.selectById(dto.getProductId());if (product.getStock() < dto.getQuantity()) {throw new BusinessException("库存不足");}// 2. 冻结库存(更新stock\_frozen字段)ProductUpdateDTO updateDTO = new ProductUpdateDTO();updateDTO.setId(dto.getProductId());updateDTO.setStockFrozen(dto.getQuantity());productMapper.updateFrozenStock(updateDTO);// 3. 保存事务上下文(用于Confirm/Cancel阶段)context.getActionContext().put("productId", dto.getProductId());context.getActionContext().put("quantity", dto.getQuantity());}// Confirm接口:确认扣减库存public void confirm(BusinessActionContext context) {Long productId = Long.parseLong(context.getActionContext().get("productId").toString());Integer quantity = Integer.parseInt(context.getActionContext().get("quantity").toString());// 扣减实际库存,解冻冻结库存productMapper.deductStock(productId, quantity);}// Cancel接口:取消(解冻库存)public void cancel(BusinessActionContext context) {Long productId = Long.parseLong(context.getActionContext().get("productId").toString());Integer quantity = Integer.parseInt(context.getActionContext().get("quantity").toString());// 解冻冻结库存productMapper.unfreezeStock(productId, quantity);}

- 订单服务调用 TCC 接口:

@Servicepublic class OrderServiceImpl implements OrderService {@Autowiredprivate ProductFeignClient productFeignClient;@Autowiredprivate OrderMapper orderMapper;@Override@GlobalTransactional(rollbackFor = Exception.class) // Seata全局事务注解public ResultDTO\<OrderVO> createOrder(OrderCreateDTO dto) {// 1. 调用商品服务TCC的Try接口(冻结库存)StockDeductDTO stockDTO = new StockDeductDTO();stockDTO.setProductId(dto.getProductId());stockDTO.setQuantity(dto.getQuantity());productFeignClient.deductStockTry(stockDTO);// 2. 创建订单(若失败,Seata会触发Cancel接口)Order order = new Order();order.setOrderNo(generateOrderNo());order.setUserId(dto.getUserId());order.setProductId(dto.getProductId());order.setQuantity(dto.getQuantity());order.setStatus(1); // 1-待支付int insertCount = orderMapper.insert(order);if (insertCount != 1) {throw new BusinessException("订单创建失败");}// 3. 返回订单信息(Seata自动触发Confirm接口)return ResultDTO.success(buildOrderVO(order));}}

效果:若订单创建失败(如数据库异常),Seata 会通过全局事务协调器触发商品服务的 Cancel 接口,解冻冻结的库存;若所有步骤成功,则触发 Confirm 接口完成实际库存扣减,确保数据一致性。

三、分布式系统监控与调优:从 “看得见” 到 “跑得稳”

分布式系统的复杂度在于 “问题定位难”,需搭建全链路监控平台,同时通过性能调优提升系统吞吐量。

1. 全链路监控:Prometheus+Grafana+Sleuth+Zipkin

链路追踪(Sleuth+Zipkin):记录每个请求的调用链路(如 “用户→网关→订单服务→商品服务”),解决 “哪个环节耗时最长” 的问题。

- 项目配置:引入

spring-cloud-starter-sleuth和spring-cloud-starter-zipkin依赖,配置 Zipkin 地址(spring.zipkin.base-url=``http://192.168.1.101:9411),启动后可在 Zipkin 控制台查看请求链路耗时(如图 2)。

- 项目配置:引入

指标监控(Prometheus+Grafana):采集服务 CPU 使用率、内存占用、接口 QPS、响应时间等指标,通过 Grafana 可视化展示。

management:endpoints:web:exposure:include: prometheus,health,infometrics:export:prometheus:enabled: true

关键指标配置:在 application.yml 中添加 Prometheus 暴露端点:

监控面板:Grafana 导入 “Spring Boot 2.0+” 模板(ID:12856),可查看接口响应时间分布(如 P95 响应时间≤500ms 为达标)、异常请求占比等核心指标。

2. 性能调优实战:从 “代码” 到 “架构” 的优化

以订单微服务为例,通过三方面调优将接口 QPS 从 500 提升至 2000:

- 缓存优化:热点商品库存放入 Redis,减少数据库查询(代码示例):

// 优化前:每次查询都访问数据库Product product = productMapper.selectById(dto.getProductId());// 优化后:先查Redis,再查数据库String key = "product:stock:" + dto.getProductId();Integer stock = redisTemplate.opsForValue().get(key);if (stock == null) {synchronized (dto.getProductId().toString().intern()) {stock = redisTemplate.opsForValue().get(key);if (stock == null) {Product product = productMapper.selectById(dto.getProductId());redisTemplate.opsForValue().set(key, product.getStock(), 5, TimeUnit.MINUTES);stock = product.getStock();}}}if (stock < dto.getQuantity()) {return ResultDTO.fail("库存不足");}

- 线程池优化:OpenFeign 默认使用单线程,通过自定义线程池提升并发能力:

@Configurationpublic class FeignConfig {@Beanpublic Executor feignExecutor() {ThreadPoolTaskExecutor executor = new ThreadPoolTaskExecutor();executor.setCorePoolSize(10); // 核心线程数executor.setMaxPoolSize(20); // 最大线程数executor.setQueueCapacity(100); // 队列容量executor.setThreadNamePrefix("feign-");executor.initialize();return executor;}}

- 数据库优化:订单表分库分表(按用户 ID 哈希分表),解决单表数据量过大(超过 1000 万条)导致的查询缓慢问题,使用 Sharding-JDBC 实现分表逻辑。

四、总结与扩展:Java 分布式系统的演进方向

本次基于 Spring Cloud 的微服务实战,解决了 “服务解耦”“分布式事务”“监控调优” 三大核心问题,但随着业务增长,还需向以下方向演进:

云原生改造:将微服务打包为 Docker 容器,通过 Kubernetes 实现自动扩缩容(如订单服务 QPS 超过阈值时自动增加实例);

服务网格(Istio):替代传统的 Spring Cloud 组件,实现 “流量管理”“灰度发布”“安全认证” 等功能,减少业务代码中的框架依赖;

Serverless 架构:将非核心服务(如订单通知、日志分析)迁移至 Serverless 平台(如阿里云 FC),按实际调用量计费,降低运维成本。

Java 分布式系统的开发核心是 “平衡复杂度与可扩展性”—— 既要通过微服务拆分提升团队并行开发效率,也要通过完善的监控、事务、缓存机制确保系统稳定,这需要开发者在实战中不断积累架构设计与问题排查经验。