istio笔记03--快速上手多集群mesh

istio笔记03--快速上手多集群mesh

- 介绍

- 安装部署

- 1. 部署集群

- 2. 部署 metallb

- 3. 安装istio

- 4. 配置mesh

- 验证

- 注意事项

- 说明

介绍

作为当前最流行的服务网格产品,istio已经在很多企业内部投入使用。在企业中为了提高服务的高可用、故障转移等能力,通常需要打通几个集群的mesh。

本文基于kind部署两个k8s集群,使用metallb实现入口LB,并且打通两个集群的mesh.

安装部署

1. 部署集群

1.1 安装集群

# kind create cluster -n k8s-130-a --image kindest/node:v1.30.0

# kind create cluster -n k8s-130-b --image kindest/node:v1.30.0

1.2 导出配置

# kind get kubeconfig --name=k8s-130-a > k8s-130-a.config

# kind get kubeconfig --name=k8s-130-b > k8s-130-b.config

上述安装会导致两个集群svc和pod子网相同,出现ip重复的情况,建议通过配置文件安装kind

# kind create cluster --config k8s-130-a.yaml

# kind create cluster --config k8s-130-b.yamlvim k8s-130-a.yaml

kind: Cluster

apiVersion: kind.x-k8s.io/v1alpha4

name: k8s-130-a

networking:podSubnet: "172.18.1.0/24"serviceSubnet: "172.18.11.0/24"

nodes:

- role: control-planeimage: kindest/node:v1.30.0

#- role: workervim k8s-130-b.yaml

kind: Cluster

apiVersion: kind.x-k8s.io/v1alpha4

name: k8s-130-b

networking:podSubnet: "172.18.2.0/24"serviceSubnet: "172.18.12.0/24"

nodes:

- role: control-planeimage: kindest/node:v1.30.0

#- role: worker

2. 部署 metallb

参考 metallb.io/installation

docker network inspect kind 发现默认网段为 172.18.0.0/16 , 此处设置LB IP网段在该范围之内即可

安装

1) 安装

# kubectl apply -f https://raw.githubusercontent.com/metallb/metallb/v0.15.2/config/manifests/metallb-native.yaml

2)vim 130-a-lb-ip-pool.yaml

apiVersion: metallb.io/v1beta1

kind: IPAddressPool

metadata:name: lb-ip-poolnamespace: metallb-system

spec:addresses:- 172.18.101.10-172.18.101.19

---

##配置L2Advertisement,用于地址宣告

apiVersion: metallb.io/v1beta1

kind: L2Advertisement

metadata:name: 130-a-advnamespace: metallb-system

spec:ipAddressPools: - lb-ip-pool3)vim 130-b-lb-ip-pool.yaml

apiVersion: metallb.io/v1beta1

kind: IPAddressPool

metadata:name: lb-ip-poolnamespace: metallb-system

spec:addresses:- 172.18.101.20-172.18.101.29

---

##配置L2Advertisement,用于地址宣告

apiVersion: metallb.io/v1beta1

kind: L2Advertisement

metadata:name: 130-b-advnamespace: metallb-system

spec:ipAddressPools: - lb-ip-pool

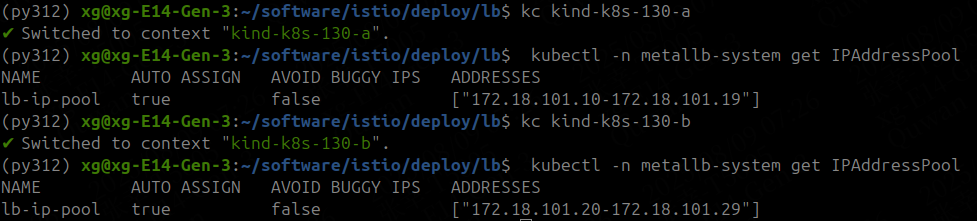

安装成功后可以通过 kubectl -n metallb-system get IPAddressPool 看到集群a和集群b都正常获取到对应的ip-pool信息

测试:

1) 创建ng

# kubectl create deploy nginx --image=nginx:1.23

2)创建LB类型的SVC

apiVersion: v1

kind: Service

metadata:name: nginxannotations:metallb.io/loadBalancerIPs: 172.18.101.11

spec:ports:- port: 80targetPort: 80selector:app: nginxtype: LoadBalancer

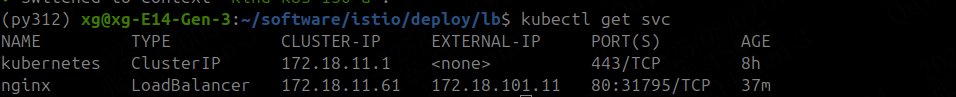

如下图,svc按照预期获取到lb ip

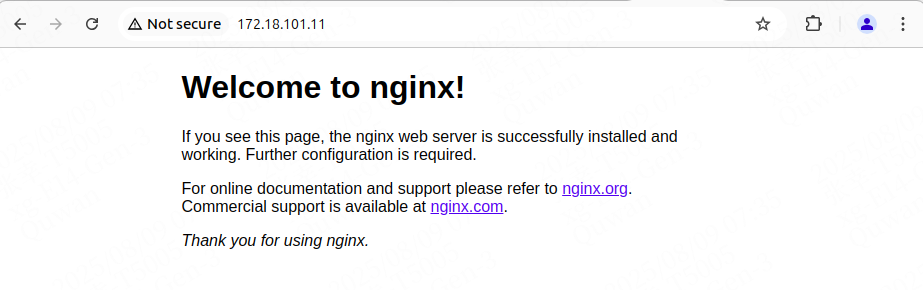

在浏览器也能正常通过lb访问nginx实例

3. 安装istio

3.1. 生成 istio 集群 1.23 部署文件

istioctl manifest generate --set revision=1-23 -f istiod-1.23.yaml -f production/istiod-overlay.yaml -f production/kind-k8s-130-a/istiod-overlay.yaml > production/kind-k8s-130-a/install-1-23.yaml

3.2. 检查部署资源

cd production/kind-k8s-130-a

kubectl apply -f install-1-23.yaml --dry-run=client

3.3. 部署

kubectl create namespace istio-system

kubectl apply -f install-1-23.yaml

3.4. 设置 tag

打一个default的tag,如果要做到金丝雀发布,需要给最新的加上canary标签

istioctl tag set -r 1-23 canary --overwrite

istioctl tag set -r 1-23 default --overwrite

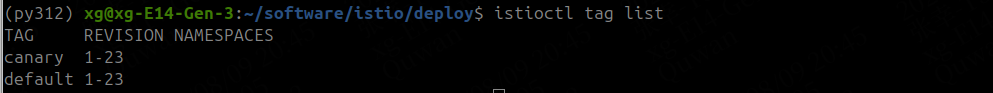

添加tag后可以通过istioctl tag list查看当前istio的tag情况

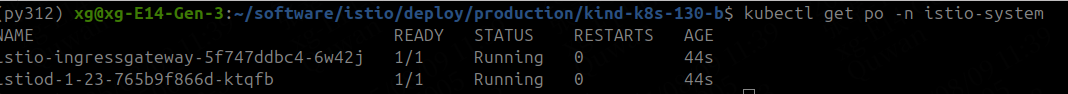

可以通过 kubectl get po -n istio-system 查看istio是否基本就绪

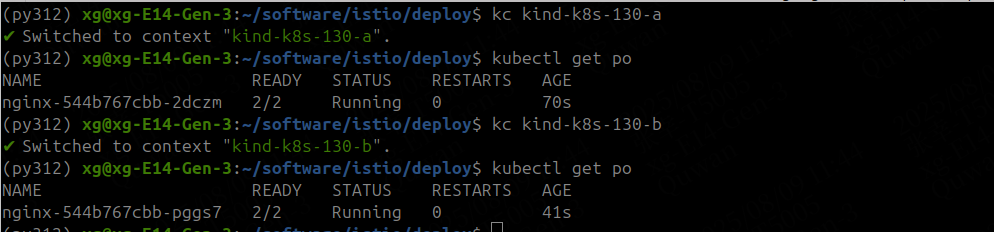

通过 kubectl label namespace default istio-injection=enabled 给default命名空间开启sidecar注入,重启nginx pod后发现正常注入sidecar了。

注意:本次istio安装目录结构如下

~/software/istio/deploy$ tree

.

├── istiod-1.23.yaml

└── production├── istiod-overlay.yaml├── kind-k8s-130-a│ ├── install-1-23.yaml│ └── istiod-overlay.yaml└── kind-k8s-130-b├── install-1-23.yaml└── istiod-overlay.yaml其中istiod-1.23.yaml为当前版本基础配置,此处简单从istio-1.23.2/manifests/profiles/default.yaml 中拷贝即可,实际使用的时候需要根据企业特性设置各个组件和mesh的特有配置;

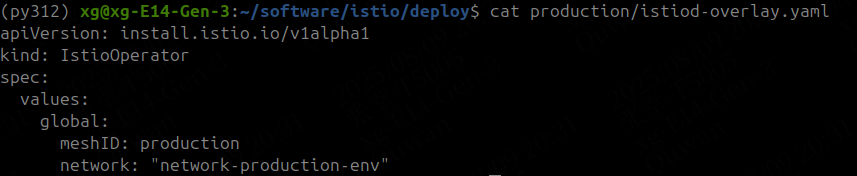

production/istiod-overlay.yaml 作为生产环境的基础配置;

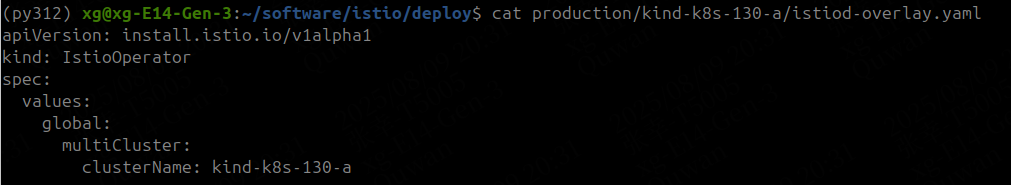

production/kind-k8s-130-a/istiod-overlay.yaml 作为指定集群的特有配置;

此处通过production/istiod-overlay.yaml 简单定义了生产环境的meshID和 网络名称,实际中可以通过${env}//istiod-overlay.yaml 来定义各个环境的基础配置,例如组件的资源参数

此处简单定义了kind-k8s-130-a的集群名称,实际中可以通过env/{env}/env/{cluster-name}/istiod-overlay.yaml 来精细化配置各个集群的属性。

4. 配置mesh

4.1 生成ca证书

make -f tools/certs/Makefile.selfsigned.mk root-ca

make -f tools/certs/Makefile.selfsigned.mk kind-k8s-130-b-cacerts

make -f tools/certs/Makefile.selfsigned.mk kind-k8s-130-a-cacerts

4.2 创建ca证书

# kc kind-k8s-130-a

kubectl create secret generic cacerts -n istio-system \--from-file=kind-k8s-130-a/ca-cert.pem \--from-file=kind-k8s-130-a/ca-key.pem \--from-file=kind-k8s-130-a/root-cert.pem \--from-file=kind-k8s-130-a/cert-chain.pem# kc kind-k8s-130-b

kubectl create secret generic cacerts -n istio-system \--from-file=kind-k8s-130-b/ca-cert.pem \--from-file=kind-k8s-130-b/ca-key.pem \--from-file=kind-k8s-130-b/root-cert.pem \--from-file=kind-k8s-130-b/cert-chain.pem

4.3 生成remote-secret

此处130-a集群容器ip为172.18.0.4,130-b集群容器ip为172.18.0.2

kubectx kind-k8s-130-a

istioctl create-remote-secret --name=kind-k8s-132-a --server https://172.18.0.4:6443 >kind-k8s-130-a.yaml

kubectx kind-k8s-130-b

istioctl create-remote-secret --name=kind-k8s-132-b --server https://172.18.0.2:6443 >kind-k8s-130-b.yamlkubectx kind-k8s-130-a

kubectl apply -f kind-k8s-130-b.yaml

kubectx kind-k8s-130-b

kubectl apply -f kind-k8s-130-a.yaml

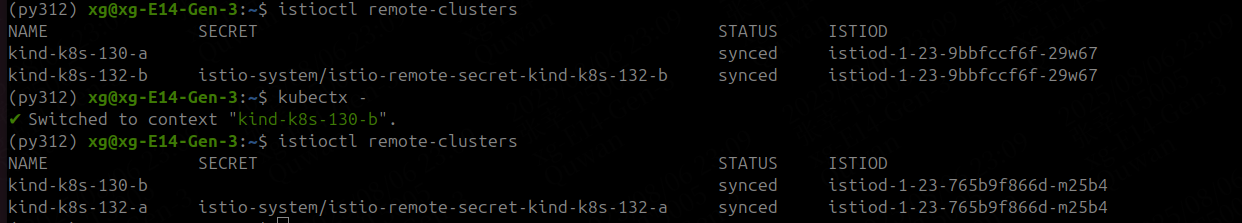

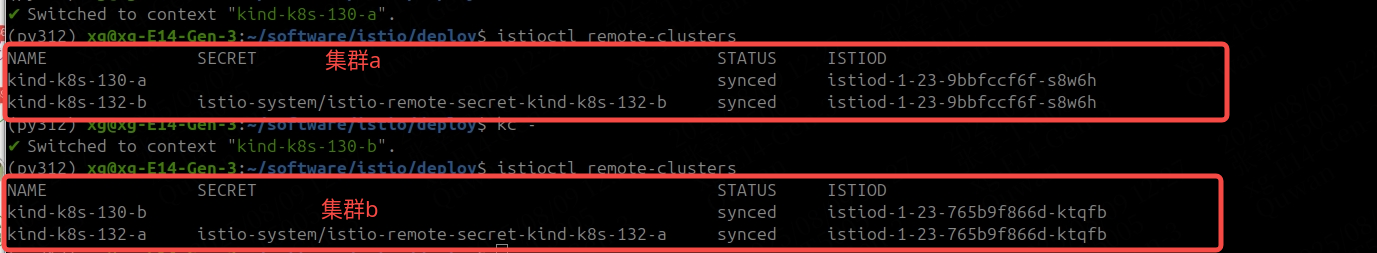

创建完成后,可以通过来查看两个集群中的mesh,如下图集群a和集群b互相打通了mesh

验证

通过 istioctl remote-clusters 可以发现两个集群之间正常

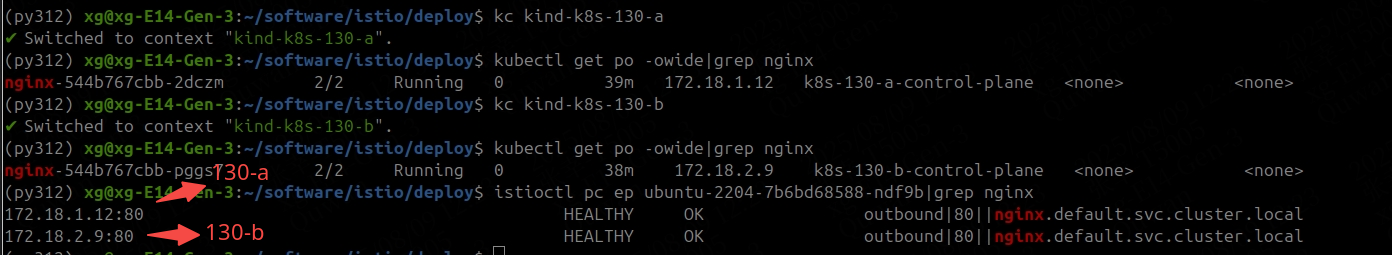

如下图,在集群b的ubuntu pod中同时发现了集群a和集群b中的nginx实例,即2个集群的mesh正常打通

注意事项

- 默认使用kind创建两个集群pod子网划分是相同的,因此验证多集群mesh的时候最好指定为不同的子网。

- kind拉起的pod报错 failed complete: too many open files

kind known-issues/#pod-errors-due-to-too-many-open-files解决方法: 进入容器内将如下两个参数保存到/etc/sysctl.conf即可 # echo "fs.inotify.max_user_watches = 524288" >> /etc/sysctl.conf # echo "fs.inotify.max_user_instances = 512" >> /etc/sysctl.conf # sysctl -p

说明

系统软件:

ubuntu 24.04.Desktop

kind v0.29.0

docker 28.3.3

istio 1.23.2

K8s v1.30.0

metallb v0.15.2

参考文档:

kind docs/user/quick-start/

基于istio实现多集群流量治理

istio Install Multi-Primary

metallb.io