NNLM和word2vec的区别

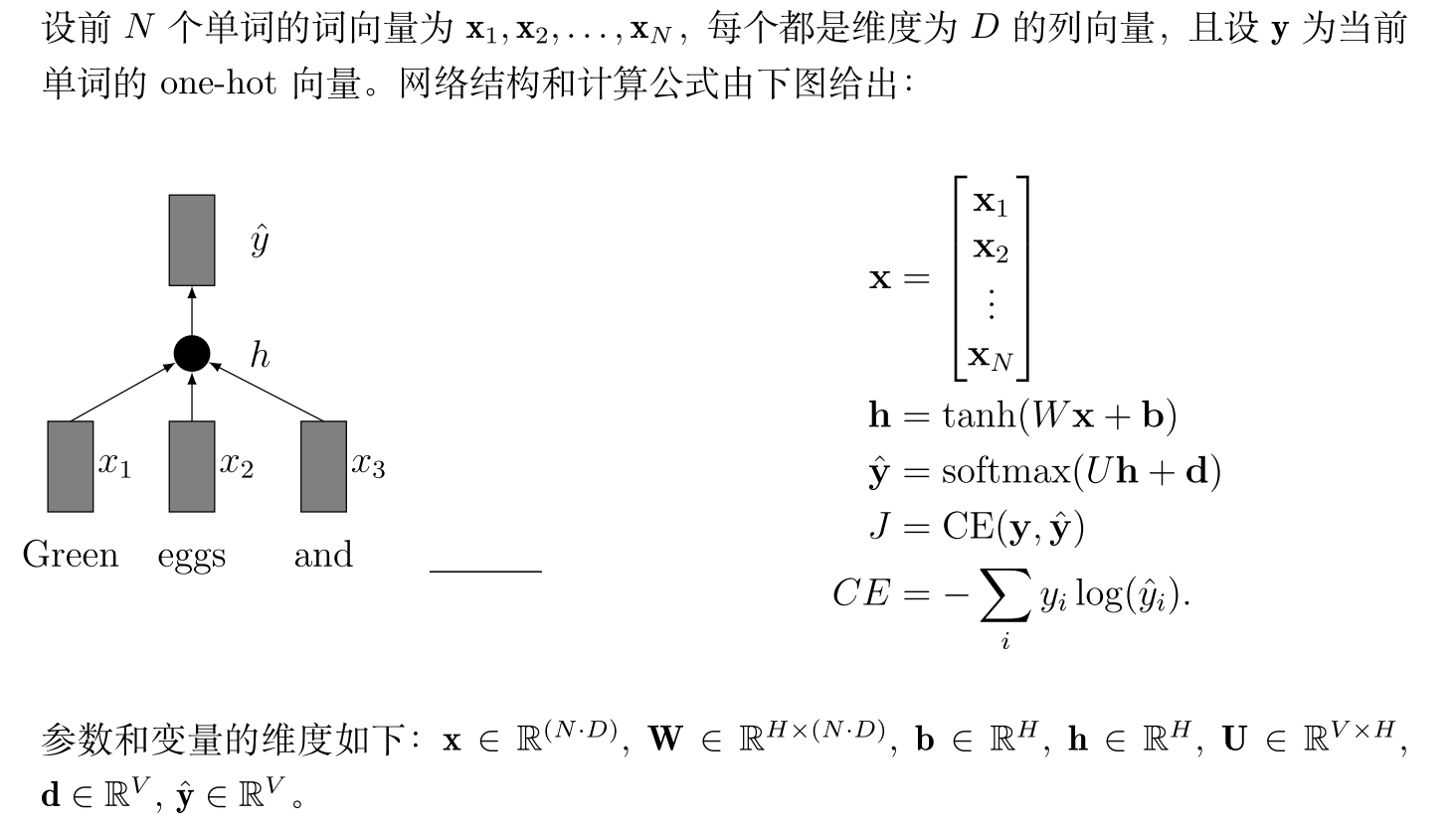

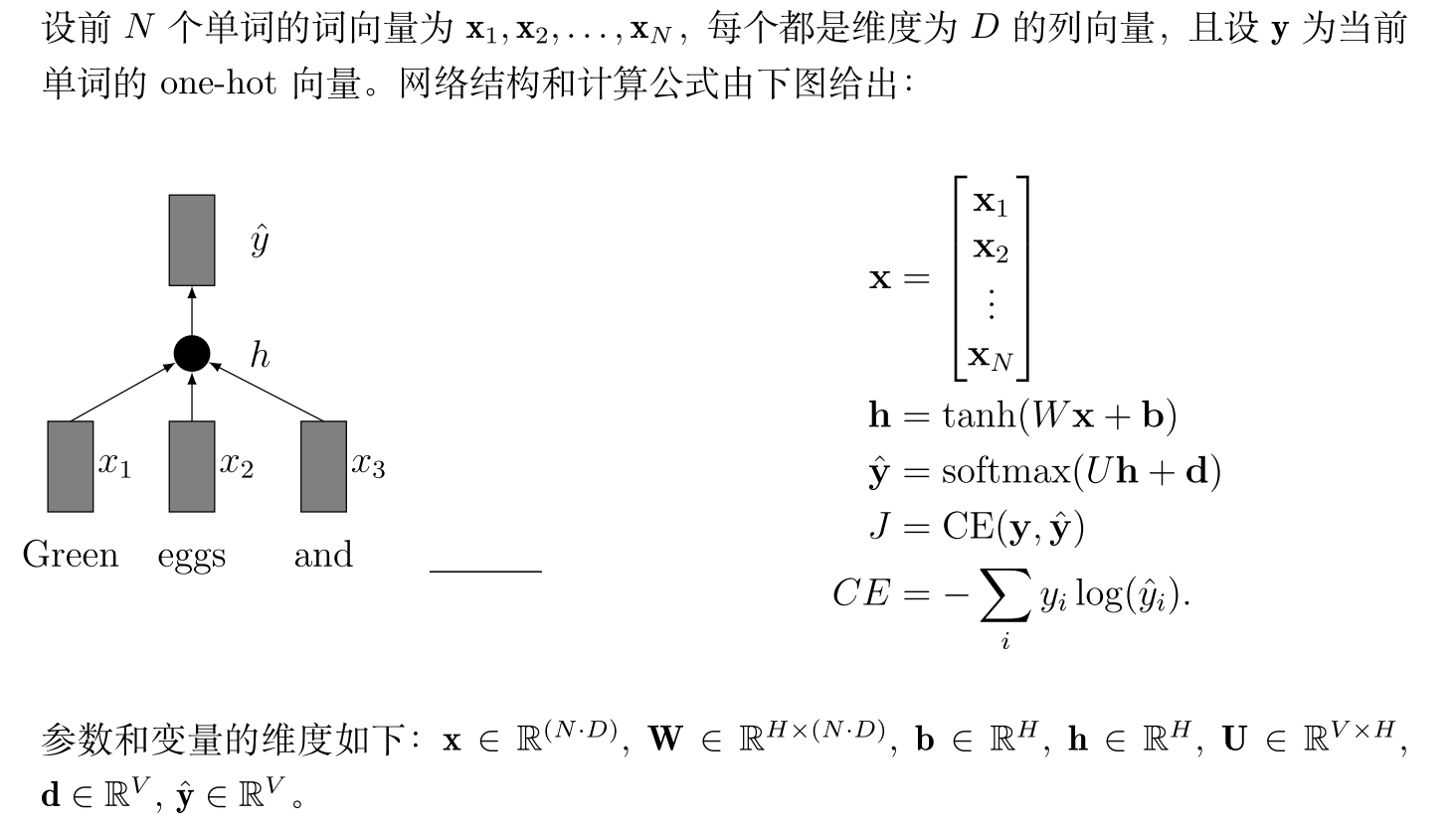

先看NNLM

将前N个词的embedding拼接起来得到向量,将该向量首先通过一个隐藏层,再映射到大小为V的线性层,进行预测即可。

而word2vecz则去掉了隐藏层。此外,CBOW不再采用拼接的方式,而将N个词的embedding直接进行相加。

先看NNLM

将前N个词的embedding拼接起来得到向量,将该向量首先通过一个隐藏层,再映射到大小为V的线性层,进行预测即可。

而word2vecz则去掉了隐藏层。此外,CBOW不再采用拼接的方式,而将N个词的embedding直接进行相加。