用语言模型训练出图像生成和理解能力:Liquid 框架 论文速读

《Liquid: Language Models are Scalable and Unified Multi-modal Generators》论文讲解

一、引言

论文提出 Liquid,一种自回归生成范式,通过将图像和文本都转化为离散代码并在共享特征空间中学习,实现视觉理解和生成的无缝集成。与以往多模态大语言模型(MLLM)不同,Liquid 仅使用一个大型语言模型(LLM),无需外部预训练的视觉嵌入(如 CLIP)。研究发现,随着模型尺寸增大,视觉与语言任务统一训练导致的性能下降会减弱。Liquid 还能相互增强视觉生成与理解任务,消除早期模型中的干扰问题。此外,Liquid 基于现有 LLMs 构建,大幅节省训练成本,且在多模态能力与纯语言性能上表现优异。

二、研究方法

(一)图像标记化与模型架构

-

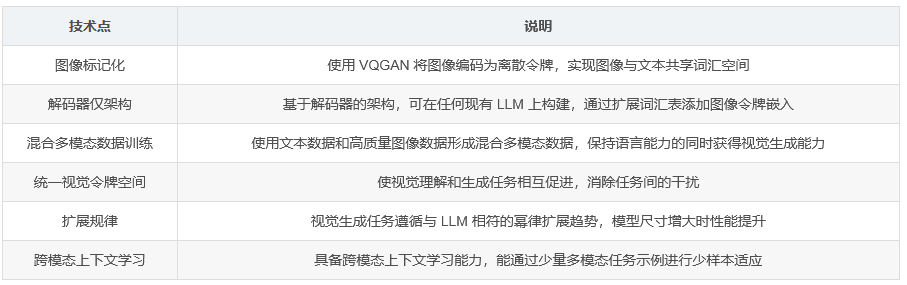

图像标记化:采用 VQGAN 将图像编码为离散令牌,类似于 BPE 对文本的处理方式。这样图像和文本共享词汇空间,使 LLM 能以相同方式理解和生成图像与文本。

-

模型架构:Liquid 基于解码器仅架构,可在任何现有 LLM 上构建。以 GEMMA-7B 为例,通过扩展词汇表添加 8192 个新可学习图像令牌嵌入,并扩展原始语言模型头部维度,实现文本和图像令牌在同一嵌入空间中的预测。

(二)数据准备与训练过程

-

数据准备:为保持预训练 LLM 的语言能力,从公共数据集中采样文本数据,并使用高质量图像数据,形成混合多模态数据用于继续预训练。

-

训练过程:采用 60M 数据继续预训练模型,定义多模态训练数据输入格式,并在训练中添加空间令牌。为解决大模型训练初期损失波动问题,降低最大梯度范数并使用 max-z 损失增强训练稳定性。

三、实验与关键发现

(一)视觉生成的扩展规律

- 实验表明,随着模型尺寸和训练迭代次数增加,验证损失平滑下降,令牌准确度和 VQA 得分持续上升,呈现出与 LLM 相符的幂律扩展趋势。

(二)视觉与语言生成的相互影响

-

小模型权衡现象:较小模型在混合训练时,语言性能受影响,但随着模型尺寸增大,这种权衡逐渐消失,表明大模型有能力同时处理视觉和语言任务。

-

视觉任务对语言任务的影响:混合训练使各尺寸模型在视觉生成任务上的验证损失升高,但随着模型尺寸增大,其对 VQA 得分的负面影响减弱。

(三)视觉理解与生成任务的相互促进

- 实验显示,增加视觉理解数据或生成数据,都能同时提升另一任务的性能,证明统一视觉令牌空间下,这两个任务可相互促进。

四、实验结果

(一)视觉生成任务

- 在 GenAI-Bench、MJHQ-30K 和 WISE 等基准测试中,Liquid 在视觉生成任务上表现优异,超越多个自回归统一 MLLM 和一些知名扩散模型,展现出良好的文本 - 图像对齐、图像真实性和保真度以及世界知识和推理能力。

(二)与主流 LLM 比较

- 在常识推理和阅读理解等基准测试中,Liquid 在大多数任务上超越了知名语言模型 Llama2 和混合预训练多模态语言模型 Chameleon,证明其语言能力未因视觉任务而退化。

(三)视觉理解任务

- 在多个视觉语言基准测试中,Liquid 超越了多个统一视觉理解和生成的 MLLM,并在一些任务上与专门从事视觉理解的模型表现相当。

(四)跨模态上下文学习

- Liquid 展现出良好的跨模态上下文学习能力,能够通过少量多模态任务示例进行少样本适应,发现结构化的跨模态关系。

五、结论

论文提出 Liquid 框架,使语言模型无需修改原始结构即可获得图像生成和理解能力。通过一系列扩展实验,揭示了统一令牌空间下多模态模型的关键特性,包括视觉生成任务遵循扩展规律、多模态任务间相互促进等,为大规模预训练提供了新方向。