【机器学习入门】5.1 线性回归基本形式——从“选西瓜”看懂线性模型的核心逻辑

如果你想预测 “房价”(根据面积、房龄),判断 “西瓜好坏”(根据色泽、根蒂),或者预估 “考试成绩”(根据学习时间、刷题量),那么线性回归一定是你最先要掌握的模型 —— 它是机器学习中最简单、最直观的预测模型,核心思想用一句话就能概括:“用特征的线性组合,预测一个连续结果”。

这篇文章会从 “生活化例子” 切入,帮你吃透线性回归的基本形式、核心参数(权重与偏置)、实际意义,再结合 “选西瓜” 的实战案例拆解公式,全程贴合入门学生认知,不堆砌复杂推导,所有公式和符号都有通俗解释,让你彻底搞懂 “线性回归到底在做什么”。

一、开篇:为什么线性回归是 “入门首选”?

在学具体形式前,先搞懂线性回归的定位 —— 它之所以成为机器学习入门第一课,核心原因有 3 个:

- 逻辑简单:本质是 “特征 × 重要性 + 基础值” 的线性计算,比如 “西瓜好坏 = 色泽 ×0.2 + 根蒂 ×0.5 + 敲声 ×0.3 + 1”,和小学算术类似;

- 可解释性强:每个特征的 “重要程度” 都能通过参数直观体现(比如根蒂权重 0.5>色泽 0.2,说明根蒂对判断西瓜更关键);

- 应用范围广:能解决 “连续值预测” 问题(如房价、温度、销量),是后续复杂模型(如逻辑回归、神经网络)的基础。

简单说:学会线性回归,就掌握了机器学习 “从特征到预测” 的基本逻辑。

二、回归的起源:从 “生物统计” 到 “机器学习”

提到 “回归”,很多人会觉得抽象,但它的起源特别生活化 ——19 世纪末,英国统计学家高尔顿研究 “身高遗传” 时发现: “父母身高很高的孩子,身高会向平均水平靠近;父母身高很矮的孩子,身高也会向平均水平靠近”,这种 “向均值回归” 的现象,就是 “回归” 一词的由来。

后来,这个概念被推广到更广泛的预测场景:只要目标是 “根据已知特征预测一个连续结果”(比如根据父母身高预测孩子身高、根据面积预测房价),都可以归为 “回归问题”,而线性回归就是 “用线性关系建模的回归方法”。

三、核心:线性模型的基本形式(公式拆解 + 符号通俗化)

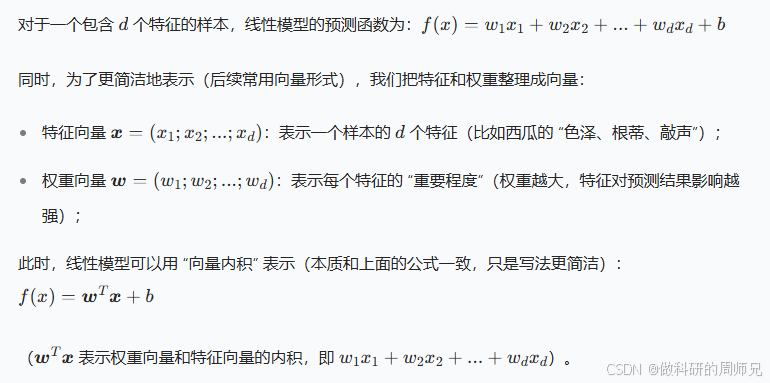

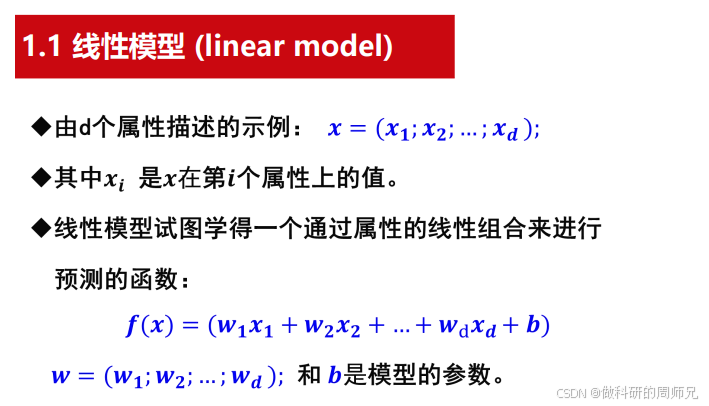

线性回归的核心是 “线性模型”,它的数学形式很简洁,但每个符号都有明确的实际意义。我们先看通用公式,再逐个拆解,确保入门学生能看懂。

3.1 线性模型的通用公式

3.2 每个符号的 “生活化解释”(关键!)

很多入门学生怕公式,其实是没搞懂符号对应的实际意义。我们用 “选西瓜” 的场景,把每个符号翻译成 “人话”:

| 符号 | 数学定义 | 选西瓜场景的实际意义 | 数据类型 / 示例 |

|---|---|---|---|

| x | 样本的特征向量 | 一个西瓜的所有判断特征组成的 “列表” | 向量,如(色泽 = 1,根蒂 = 2,敲声 = 1) |

| xi | 特征向量的第 i 个分量 | 西瓜的第 i 个具体特征(如 “色泽”“根蒂”) | 数值,如色泽 = 1(青绿 = 1,乌黑 = 2) |

| w | 权重向量 | 每个特征的 “重要程度打分” | 向量,如(0.2,0.5,0.3) |

| wi | 权重向量的第 i 个分量 | 第 i 个特征的重要程度(打分越高越重要) | 数值,如根蒂权重 = 0.5 |

| b | 偏置项(截距) | 预测的 “基础值”(即使所有特征为 0,也有的默认值) | 数值,如 1 |

| f(x) | 线性模型的预测结果 | 对 “西瓜好坏” 的评分(分数越高,越可能是好瓜) | 连续值,如 1.8、2.5 |

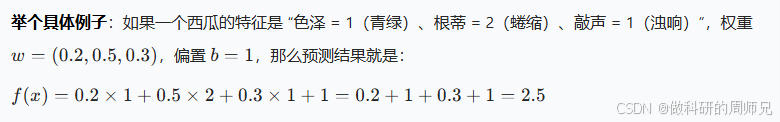

分数 2.5 较高,说明这个西瓜很可能是好瓜。

分数 2.5 较高,说明这个西瓜很可能是好瓜。

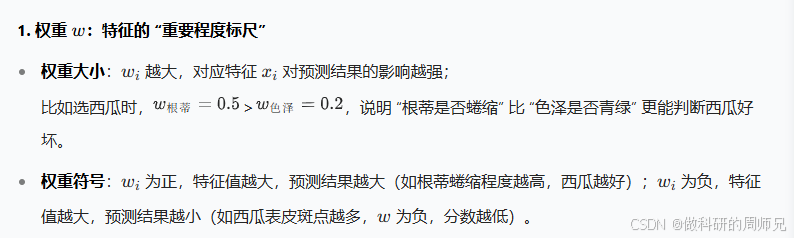

3.3 核心参数解读:权重 w 和偏置 b

线性模型的 “灵魂” 是参数 w 和 b,它们决定了模型的预测能力,我们重点解读:

2. 偏置 b:预测的 “基础底线”

偏置 b 是 “所有特征都为 0 时的预测值”,作用是 “调整模型的基础水平”,避免因特征值都较小时预测结果过低。 比如选西瓜时,即使色泽、根蒂、敲声的特征值都为 0(极端情况),偏置 b=1 也能保证预测分数有 1 分,而不是 0 分,更符合实际判断逻辑。

四、实战:用线性回归 “选西瓜”—— 公式落地到场景

文档中给出了 “选西瓜” 的线性回归实例,这是理解线性模型最好的案例。我们详细拆解这个例子,看线性回归如何从 “特征” 到 “判断好瓜”。

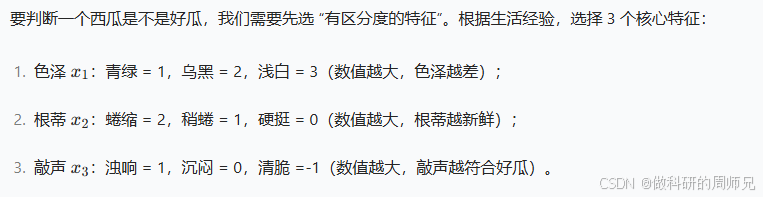

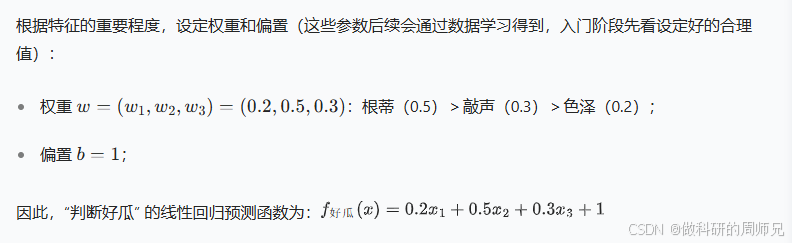

4.1 第一步:确定 “选西瓜的特征”

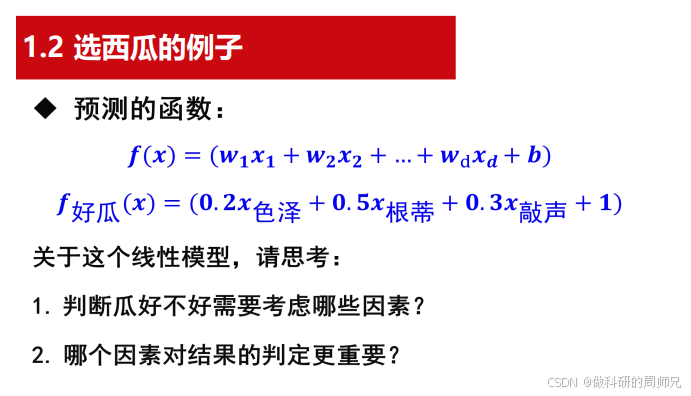

4.2 第二步:建立线性回归预测函数

4.3 第三步:用函数预测西瓜好坏

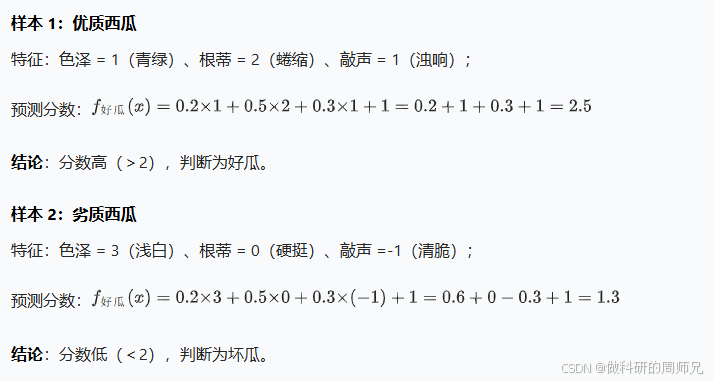

我们拿两个实际西瓜样本,代入函数计算,看结果如何:

4.4 关键思考:从例子看线性回归的核心逻辑

这个例子能帮我们回答两个核心问题,也是入门学生必须理解的:

- “考虑哪些因素?” → 线性回归的 “特征选择”:要选和目标强相关的特征(如色泽、根蒂,而非西瓜表皮的斑点数量),无关特征会降低预测 accuracy;

- “哪个因素更重要?” → 权重 w 的意义:权重越大,特征对结果影响越强(根蒂权重 0.5 最大,所以判断时优先看根蒂)。

五、线性回归的核心原理:如何找到 “最优的 w 和 b ”?

前面的例子中,权重 w 和偏置 b 是 “设定好的”,但实际应用中,我们需要从数据中 “学习” 这两个参数 —— 这就是 “参数学习”,核心是通过 “损失函数” 找到 “让预测结果最准” 的 w 和 b。

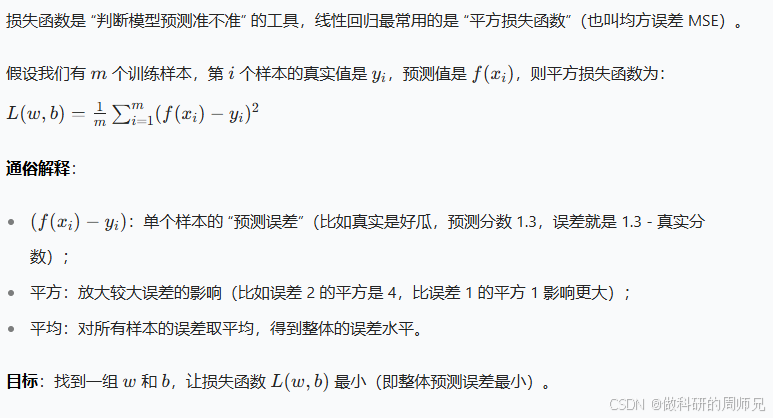

5.1 损失函数:衡量 “预测值与真实值的差距”

5.2 参数学习:如何最小化损失函数?

入门阶段不需要推导复杂的数学公式,只需知道核心方法:

- 正规方程(闭式解):对于简单的线性回归,有直接计算 w 和 b 的公式(通过求导令损失函数导数为 0 得到),适合样本少、特征少的场景;

- 梯度下降(迭代法):像 “下山” 一样,通过不断调整 w 和 b 的值(每次向损失函数减小的方向走一小步),逐步逼近最小损失,适合样本多、特征多的场景。

这两种方法的最终目标都是 “找到最优的 w 和 b”,后续章节会详细讲解,这里先建立 “参数需要学习” 的认知即可。

六、线性回归的实际应用场景(不止选西瓜)

线性回归的应用远不止 “选西瓜”,只要是 “连续值预测” 问题,都能用到它。我们列举 3 个入门学生能直观感知的场景:

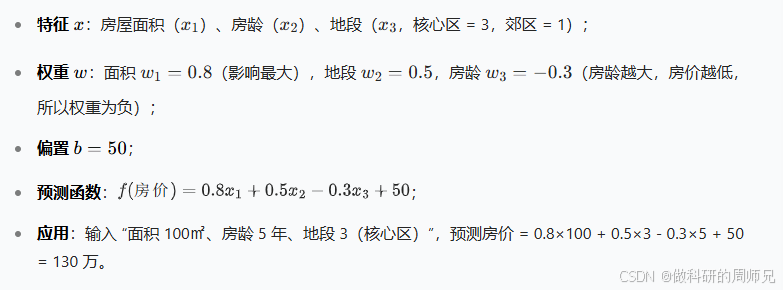

6.1 房价预测

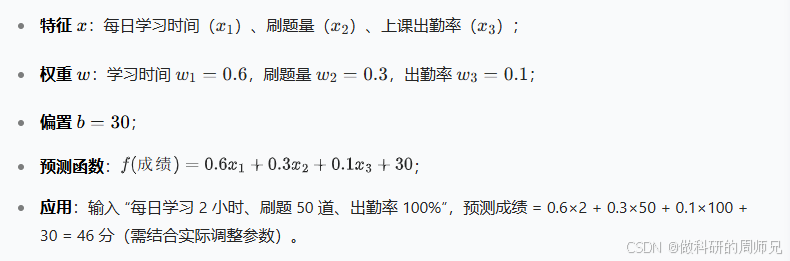

6.2 成绩预测

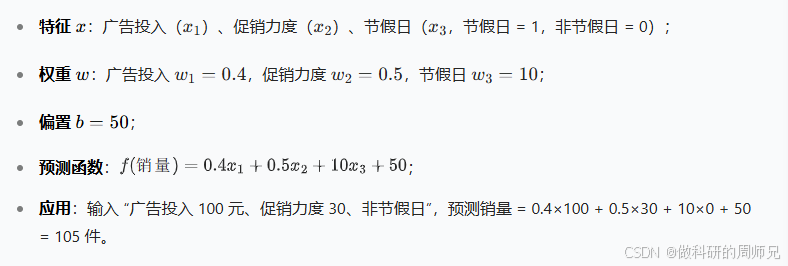

6.3 销量预测

七、模型小结:线性回归的 “核心三要素”

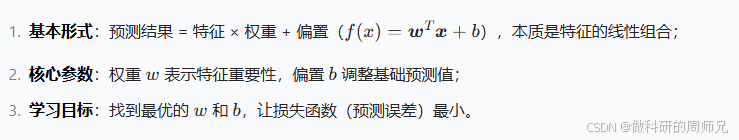

学到这里,你已经掌握了线性回归的基本形式,我们用 3 个核心点总结,帮你记住重点:

线性回归是机器学习的 “基石”,后续学习逻辑回归(分类任务)、神经网络(复杂非线性任务)时,都会用到它的核心思想。下一章我们会深入讲解 “如何通过梯度下降学习线性回归的参数”,带你从 “理解形式” 走向 “动手实现”。

如果这篇文章里有哪个公式或例子没搞懂,欢迎在评论区留言,我们一起拆解!